Esplorare ed elaborare i dati con Microsoft Fabric

I dati sono la chiave di base dell'analisi scientifica dei dati, in particolare quando si mira a eseguire il training di un modello di Machine Learning per ottenere l'intelligenza artificiale. In genere, i modelli presentano prestazioni migliorate man mano che aumentano le dimensioni del set di dati di training. Oltre alla quantità di dati, la qualità dei dati è altrettanto cruciale.

Per garantire sia la qualità che la quantità dei dati, è utile usare i motori di inserimento e elaborazione di dati affidabili di Microsoft Fabric. È possibile scegliere un approccio a basso utilizzo di codice o code-first per stabilire l'inserimento, l'esplorazione e le pipeline di trasformazione essenziali per l'inserimento dei dati.

Inserire i dati in Microsoft Fabric

Per usare i dati in Microsoft Fabric, è prima necessario inserire dati. È possibile inserire dati da più origini, sia locali che cloud. Ad esempio, è possibile inserire dati da un file CSV archiviato nel computer locale o in un Azure Data Lake Storage (Gen2).

Suggerimento

Altre informazioni su come inserire e orchestrare i dati da varie origini con Microsoft Fabric.

Dopo la connessione a un'origine dati, è possibile salvare i dati in una lakehouse Microsoft Fabric. È possibile usare la lakehouse come posizione centrale per archiviare tutti i file strutturati, semistrutturati e non strutturati. È quindi possibile connettersi facilmente alla lakehouse ogni volta che si desidera accedere ai dati per l'esplorazione o la trasformazione.

Esplorare e trasformare i dati

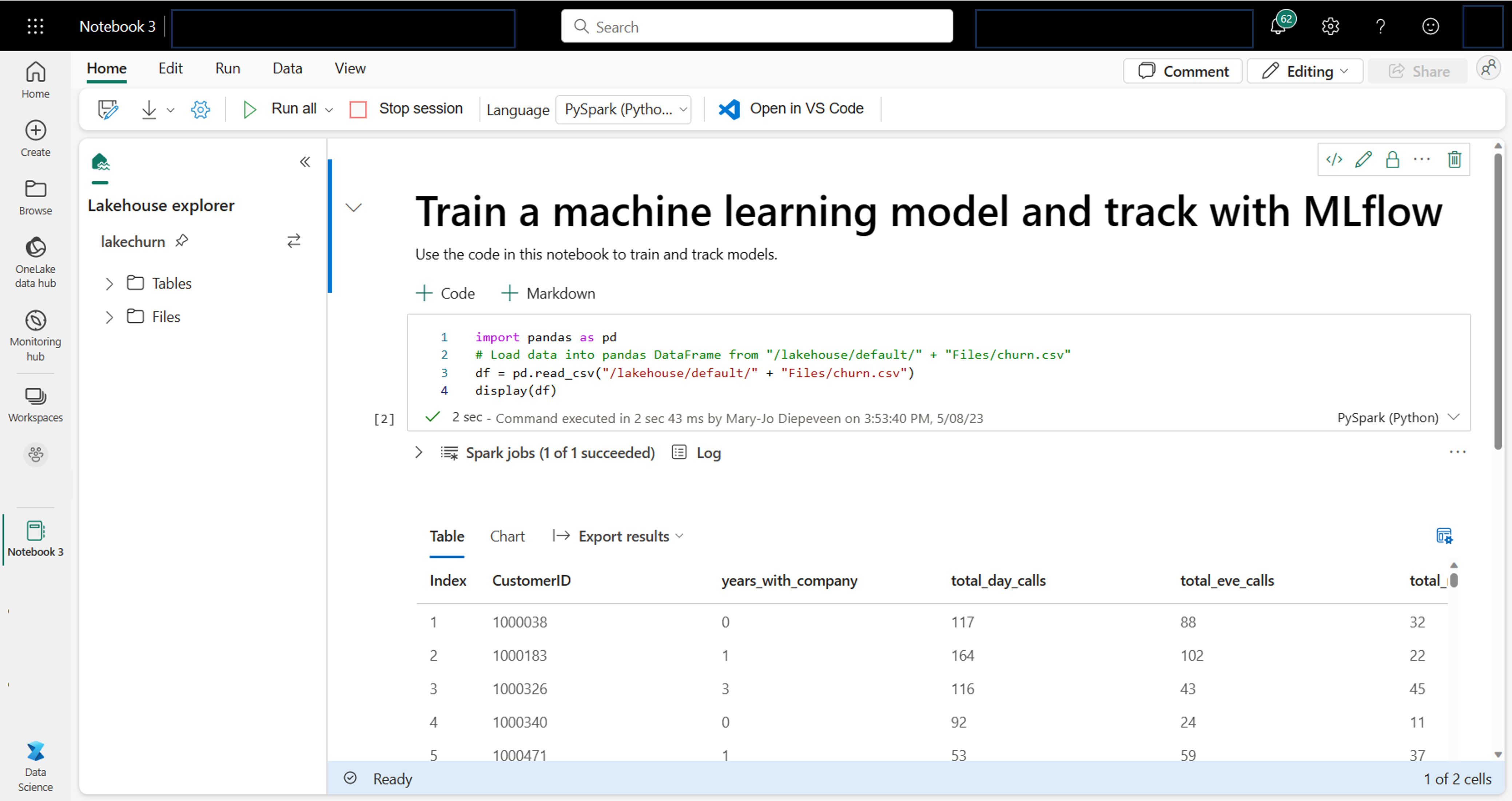

Come scienziato dei dati, è possibile che si abbia familiarità con la scrittura e l'esecuzione di codice nei notebook. Microsoft Fabric offre un'esperienza di notebook familiare, basata sul calcolo Spark.

Apache Spark è un framework di elaborazione parallela open source per l'elaborazione e l'analisi dei dati su larga scala.

I notebook vengono collegati automaticamente al calcolo Spark. Quando si esegue una cella in un notebook per la prima volta, viene avviata una nuova sessione Spark. La sessione persiste quando si eseguono celle successive. La sessione Spark si arresterà automaticamente dopo un certo periodo di inattività per risparmiare sui costi. È anche possibile interrompere manualmente la sessione.

Quando si lavora in un notebook, è possibile scegliere la lingua da usare. Per i carichi di lavoro di data science, è probabile che si utilizzerà PySpark (Python) o SparkR (R).

All'interno del notebook è possibile esplorare i dati usando la libreria preferita o con una delle opzioni di visualizzazione predefinite. Se necessario, è possibile trasformare i dati e salvare i dati elaborati scrivendolo nuovamente nella lakehouse.

Preparare i dati con Data Wrangler

Per esplorare e trasformare i dati più rapidamente, Microsoft Fabric offre la facilità d'uso di Data Wrangler.

Dopo aver avviato Data Wrangler, si otterrà una panoramica descrittiva dei dati in uso. È possibile visualizzare le statistiche di riepilogo dei dati per trovare eventuali problemi come i valori mancanti.

Per pulire i dati, è possibile scegliere una delle operazioni di pulizia predefinite. Quando si seleziona un'operazione, viene generata automaticamente un'anteprima del risultato e il codice associato. Dopo aver selezionato tutte le operazioni necessarie, è possibile esportare le trasformazioni nel codice ed eseguirle sui dati.