Usare Spark nei notebook

È possibile eseguire molti tipi diversi di applicazioni in Spark, tra cui codice in script Python o Scala, codice Java compilato come Archivio Java (JAR) e altre ancora. Spark viene comunemente usato in due tipi di carichi di lavoro:

- Processi di elaborazione in batch o in streaming per inserire, pulire e trasformare i dati, spesso in esecuzione come parte di una pipeline automatizzata.

- Sessioni di analisi interattive per esplorare, analizzare e visualizzare i dati.

Nozioni di base sulla modifica e sul codice dei notebook

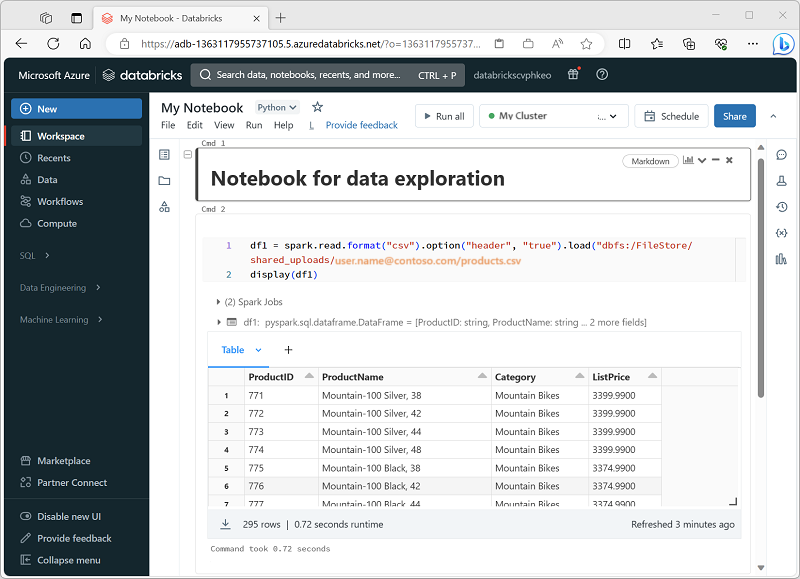

I notebook di Databricks sono l'area di lavoro principale per data science, progettazione e analisi. Sono compilati intorno alle celle, che possono contenere codice o testo formattato (Markdown). Questo approccio basato su celle semplifica l'esperimento, il test e la spiegazione del lavoro in un'unica posizione. È possibile eseguire una singola cella, un gruppo di celle o l'intero notebook, con output come tabelle, grafici o testo normale visualizzato direttamente sotto la cella eseguita. Le celle possono essere riorganizzate, ridotte o cancellate per mantenere il notebook organizzato e leggibile.

Un punto di forza principale dei notebook di Databricks è il supporto multi-linguaggio. Anche se il valore predefinito è spesso Python, è possibile passare a SQL, Scala o R all'interno dello stesso notebook usando comandi magic come %sql o %scala. Questa flessibilità significa che è possibile scrivere logica ETL in SQL, codice di Machine Learning in Python e quindi visualizzare i risultati con R, tutti in un unico flusso di lavoro. Databricks fornisce anche il completamento automatico e l'evidenziazione della sintassi, rendendo più semplice individuare gli errori e velocizzare la codifica.

Prima di eseguire qualsiasi codice, è necessario collegare un notebook a un cluster. Senza un cluster collegato, le celle di codice non possono essere eseguite. È possibile selezionare un cluster esistente dalla barra degli strumenti del notebook o crearne uno nuovo ed è possibile scollegare e ricollegare facilmente i notebook in base alle esigenze. Questa connessione consente al notebook di sfruttare la potenza di elaborazione distribuita in Azure Databricks.

Utilizzo di Databricks Assistant

Databricks Assistant è un compagno di codifica basato su intelligenza artificiale integrato direttamente nei notebook. L'obiettivo è quello di aiutare a scrivere, comprendere e migliorare il codice in modo più efficiente sfruttando il contesto dal notebook e dall'area di lavoro. Può generare nuovo codice dai prompt del linguaggio naturale, spiegare logica complessa, suggerire correzioni per errori, ottimizzare le prestazioni e anche effettuare il refactoring o formattare il codice per la leggibilità. Ciò rende utile non solo per principianti l'apprendimento di Spark o SQL, ma anche per gli utenti esperti che vogliono velocizzare lo sviluppo e ridurre il lavoro ripetitivo.

L'assistente è compatibile con il contesto, ovvero può usare informazioni sul notebook, il cluster e l'ambiente dati per fornire suggerimenti personalizzati. Ad esempio, se l'area di lavoro ha il catalogo Unity abilitato, può eseguire il pull di metadati come nomi di tabella, nomi di colonna e schemi durante la scrittura di query SQL. In questo modo è possibile chiedere qualcosa come "Selezionare l'importo medio delle vendite per area dalla tabella sales" e ottenere il codice SQL funzionante adatto al modello di dati effettivo. Analogamente, in Python è possibile chiedere di creare trasformazioni dei dati o processi Spark senza dover richiamare ogni firma di funzione dalla memoria.

Si interagisce con l'assistente in due modi principali:

Prompt in linguaggio naturale: è possibile digitare istruzioni in inglese normale nell'interfaccia simile alla chat ed essa inserirà codice nel notebook.

Comandi Slash: comandi rapidi, ad

/explainesempio ,/fixo/optimizeche consentono di agire sul codice selezionato. Ad esempio,/explainsuddivide una funzione complessa in passaggi più semplici,/fixpuò tentare di risolvere gli errori di sintassi o di runtime e/optimizesuggerisce miglioramenti delle prestazioni, ad esempio la suddivisione o l'uso di funzioni Spark efficienti.

Una funzionalità potente è la modalità di modifica, in cui l'assistente può proporre modifiche strutturali più grandi in più celle. Ad esempio, potrebbe eseguire il refactoring della logica ripetuta in una singola funzione riutilizzabile o ristrutturare un flusso di lavoro per una migliore leggibilità. Si ha sempre il controllo: i suggerimenti non sono distruttivi, ovvero è possibile esaminarli e accettarli o rifiutarli prima di applicare le modifiche al notebook.

Condivisione e modularizzazione del codice

Per evitare la duplicazione e migliorare la gestibilità, Databricks supporta l'inserimento di codice riutilizzabile in file (ad esempio, .py moduli) nell'area di lavoro, che i notebook possono importare. Esistono meccanismi per orchestrare i notebook, ovvero l'esecuzione di notebook da altri notebook o processi con più attività, in modo da poter creare flussi di lavoro che usano funzioni o moduli condivisi. L'uso %run di è un modo più semplice per includere un altro notebook, anche se con alcune limitazioni.

Debugging, cronologia delle versioni e annullamento degli errori

Databricks offre un debugger interattivo predefinito per i notebook Python: è possibile impostare punti di interruzione, procedere con l'esecuzione, esaminare le variabili e navigare attraverso l'esecuzione del codice passo dopo passo. Ciò consente di isolare i bug in modo più efficace rispetto all'uso di tecniche di debug basate su stampa/log.

I notebook mantengono automaticamente la cronologia delle versioni: è possibile visualizzare snapshot precedenti, assegnare descrizioni delle versioni, ripristinare versioni precedenti o eliminare/cancellare la cronologia. Se si utilizza l'integrazione con Git, è possibile sincronizzare e gestire le versioni dei notebook e dei file nel repository.

Suggerimento

Per altre informazioni sull'uso dei notebook in Azure Databricks, vedere l'articolo Notebooks nella documentazione di Azure Databricks.