モデル カタログとコレクション

Azure Machine Learning スタジオのモデルカタログは、生成 AI アプリケーションを構築できるさまざまなモデルを検出して使用するためのハブです。 モデルカタログでは、Azure OpenAI Service、Mistral、Meta、Cohere、Nvidia、Hugging Face などのモデル プロバイダーから数百ものモデルが提供されています (Microsoft によってトレーニングされたモデルを含みます)。 Microsoft 以外のプロバイダーのモデルは、Microsoft の製品使用条件で定義されているとおり、Microsoft 製品ではないため、そのモデルで提供されている条件に従います。

モデル コレクション

モデルは、モデルカタログ内のコレクション別に編成されます。 モデル カタログには、次の 3 種類のコレクションがあります。

- Azure AI によってキュレーションされたモデル: Azure AI プラットフォーム上でシームレスに動作するようにパッケージ化され、最適化された、最も一般的なサードパーティ製のオープン ウェイト モデルとプロプライエタリ モデル。 これらのモデルの使用は、モデルに付与されているモデル プロバイダーのライセンス条項に従います。 Azure Machine Learning にデプロイすると、モデルの可用性は該当する Azure SLA の対象となり、Microsoft はデプロイの問題のサポートを提供します。 Meta、NVIDIA、Mistral AI などのパートナーのモデルが、カタログの "Azure AI によるキュレーション" コレクションで利用できるモデルの例です。 これらのモデルは、カタログ内のモデル タイルの緑色のチェックマークで識別できますし、"Azure AI によるキュレーション" コレクションでフィルタリングすることもできます。

- Azure OpenAI モデル (Azure でのみ利用可能): Azure OpenAI Service との統合を通じた、"Azure OpenAI" コレクションで提供する主力の Azure OpenAI モデル。 これらのモデルは Microsoft によってサポートされており、その使用は、製品使用条件と Azure OpenAI Service の SLA に従います。

- Hugging Face ハブからのオープン モデル: オンライン エンドポイントを使用したリアルタイム推論のための "Hugging Face" コレクションを使用して、HuggingFace ハブの数百のモデルにアクセスできます。 Hugging Face は、HuggingFace コレクションに掲載しているモデルを作成および維持しています。 ヘルプについては、HuggingFace フォーラムまたは HuggingFace サポートをご利用ください。 詳細については、Hugging Face からモデルをデプロイする方法に関する記事を参照してください。

モデルカタログへの追加の提案: このフォームを使用して、モデルカタログへのモデルの追加依頼を送信できます。

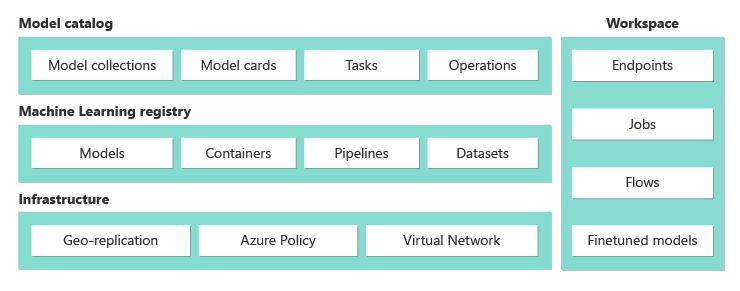

モデルカタログ機能の概要

Azure OpenAI モデルの詳細については、「Azure OpenAI Service」を参照してください。

Azure AI によってキュレーションされたモデル、およびHugging Face ハブからのOpen モデルについては、これらの一部はマネージド コンピューティング オプションを使用してデプロイできます。これらの一部は、従量課金制のサーバーレス API を使用してデプロイできます。 これらのモデルを検索、比較、評価、微調整 (サポートされている場合) し、大規模にデプロイして、エンタープライズ レベルのセキュリティとデータ ガバナンスのもとで、生成 AI アプリケーションに統合できます。

- 検索: モデル カードを確認し、サンプル推論を試し、コード サンプルを参照して、モデルの評価や微調整、デプロイなどを行います。

- 比較: 業界で利用可能なモデルとデータセットのベンチマークを比較して、どれが自社のビジネス シナリオに適合するかを評価できます。

- 評価: 独自のテスト データを提供して、モデルが特定のワークロードに適しているかどうかを評価します。 評価メトリックを使用すると、選択したモデルがシナリオでどの程度適切に実行されているかを簡単に視覚化できます。

- 微調整: 独自のトレーニング データを使用して微調整可能なモデルをカスタマイズし、すべての微調整ジョブのメトリックを比較して最適なモデルを選択します。 組み込みの最適化機能によって、微調整を高速化し、微調整に必要なメモリとコンピューティングを削減します。

- デプロイ: 事前トレーニング済みモデルまたは微調整されたモデルを推論用にシームレスにデプロイします。 マネージド コンピューティングにデプロイできるモデルもダウンロードできます。

モデル デプロイ: マネージド コンピューティングとサーバーレス API (従量課金制)

モデルカタログには、使用に際しカタログからモデルをデプロイする 2 つの異なる方法が用意されています。マネージド コンピューティング API とサーバーレス API です。 モデルごとに使用可能なデプロイ オプションは異なります。デプロイ オプションの機能と、特定のモデルで使用できるオプションの詳細については、次の表を参照してください。 デプロイ オプションを使用したデータ処理の詳細を参照してください。

| 機能 | マネージド コンピューティング | サーバーレス API (従量課金制) |

|---|---|---|

| デプロイ エクスペリエンスと課金 | モデルの重みは、マネージド オンライン エンドポイントのある専用の仮想マシンにデプロイされます。 マネージド オンライン エンドポイントは、1 つ以上のデプロイを持つことができ、推論に REST API を使用できます。 利用者は、デプロイに使用された仮想マシン コア時間に対して課金されます。 | モデルへのアクセスは、モデルにアクセスするための API をプロビジョニングするデプロイを通じて行われます。 この API は、推論のために Microsoft によって管理される中央 GPU プールでホストされているモデルへのアクセスを提供します。 このアクセス モードは、"サービスとしてのモデル" と呼ばれます。 利用者は、API への入力と出力 (通常はトークン数) に対して課金されます。この価格情報は、デプロイする前に提供されます。 |

| API 認証 | キーと Microsoft Entra ID 認証。 詳細情報。 | キーのみ。 |

| コンテンツの安全性 | Azure Content Safety サービス API を使用します。 | Azure AI Content Safety フィルターを、推論 API と統合して使用できます。 Azure AI Content Safety フィルターは、個別に課金される場合があります。 |

| ネットワークの分離 | オンライン エンドポイントを使用したマネージド仮想ネットワーク。 詳細情報。 |

配置オプション

| モデル | マネージド コンピューティング | サーバーレス API (従量課金制) |

|---|---|---|

| Llama ファミリ モデル | Llama-2-7b Llama-2-7b-chat Llama-2-13b Llama-2-13b-chat Llama-2-70b Llama-2-70b-chat Llama-3-8B-Instruct Llama-3-70B-Instruct Llama-3-8B Llama-3-70B |

Llama-3-70B-Instruct Llama-3-8B-Instruct Llama-2-7b Llama-2-7b-chat Llama-2-13b Llama-2-13b-chat Llama-2-70b Llama-2-70b-chat |

| Mistral ファミリ モデル | mistralai-Mixtral-8x22B-v0-1 mistralai-Mixtral-8x22B-Instruct-v0-1 mistral-community-Mixtral-8x22B-v0-1 mistralai-Mixtral-8x7B-v01 mistralai-Mistral-7B-Instruct-v0-2 mistralai-Mistral-7B-v01 mistralai-Mixtral-8x7B-Instruct-v01 mistralai-Mistral-7B-Instruct-v01 |

Mistral-large Mistral-small |

| Cohere ファミリ モデル | 使用不可 | Cohere-command-r-plus Cohere-command-r Cohere-embed-v3-english Cohere-embed-v3-multilingual |

| JAIS | 使用不可 | jais-30b-chat |

| Phi3 family models | Phi-3-small-128k-Instruct Phi-3-small-8k-Instruct Phi-3-mini-4k-Instruct Phi-3-mini-128k-Instruct Phi3-medium-128k-instruct Phi3-medium-4k-instruct |

Phi-3-mini-4k-Instruct Phi-3-mini-128k-Instruct Phi3-medium-128k-instruct Phi3-medium-4k-instruct |

| Nixtla | 使用不可 | TimeGEN-1 |

| その他のモデル | 使用可能 | 使用不可 |

マネージド コンピューティング

モデルをマネージド コンピューティングとしてデプロイする機能は、Azure Machine Learning のプラットフォーム機能に基づいて構築され、モデルカタログの幅広いモデル コレクションの LLMOps ライフサイクル全体においてシームレスな統合を実現します。

マネージド コンピューティングでモデルを使用できるようにする方法

モデルは、Azure Machine Learning レジストリを介して利用可能にできます。これは、機械学習資産のホスティングおよび配布のための ML ファーストの方法を有効にするためのものであり、このような資産には、モデルの重み付け、モデルを実行するためのコンテナー ランタイム、ベンチマークとサンプル用のモデルとデータセットを評価および微調整するためのパイプラインなどがあります。 これらの ML レジストリは、高度にスケーラブルでエンタープライズ対応のインフラストラクチャの上に構築されます。

geo レプリケーションが組み込まれているすべての Azure リージョンに、待機時間の短いアクセス モデル成果物を提供します。

Azure Policy を使用したモデルへのアクセス制限およびマネージド仮想ネットワークを使用したデプロイのセキュリティ保護として、エンタープライズ セキュリティ要件をサポートします。

マネージド コンピューティングを使用してデプロイされたモデルを評価および微調整する

Azure Machine Learning パイプラインを使用して、Azure Machine Learning の "Azure AI によりキュレーションされた" コレクションを評価して微調整できます。 独自の評価と微調整のコードを用意し、モデルの重み付けにアクセスするか、組み込みの評価機能と微調整機能を提供する Azure Machine Learning コンポーネントを使用するかを選択できます。 詳細については、こちらのリンクを参照してください。

マネージド コンピューティングを使用して推論用のモデルをデプロイする

マネージド コンピューティングでのデプロイに使用できるモデルは、リアルタイム推論のために Azure Machine Learning のオンライン エンドポイントにデプロイすることも、Azure Machine Learning のバッチ推論でデータをバッチ処理するために使用することもできます。 マネージド コンピューティングにデプロイするには、モデルの最適な実行に必要な特定の SKU のための仮想マシン クォータが Azure サブスクリプションに必要です。 一部のモデルでは、モデルをテストするための一時的な共有クォータへのデプロイが可能です。 モデルのデプロイの詳細については、次を参照してください。

マネージド コンピューティングを使用して生成 AI アプリを構築する

プロンプト フローには、AI アプリケーションのプロトタイプ作成、実験、反復処理、デプロイのための機能が用意されています。 プロンプト フローでマネージド コンピューティングでデプロイされたモデルは Open Model LLM ツールで使用できます。 また、Azure Machine Learning 拡張機能を使用して、LangChain などの一般的な LLM ツールでマネージド コンピューティングによって公開される REST API を使用することもできます。

マネージド コンピューティングを使用してデプロイされたモデルのコンテンツの安全性

Azure AI Content Safety (AACS) サービスは、マネージド コンピューティングででプロしたモデルで使用し、性的コンテンツ、暴力、ヘイト、自傷行為、高度な脅威 (脱獄リスク検出や保護済み素材テキスト検出など) などのさまざまなカテゴリの有害なコンテンツをスクリーニングするために利用できます。 このノートブックを参照して、AACS for Llama 2 とのリファレンス統合を参照するか、プロンプト フローでの Content Safety (テキスト) ツールを使用して、モデルから AACS に応答を渡してスクリーニングを行えます。 このような使用については、AACS の価格に従って個別に課金されます。

モデルカタログに含まれていないモデルを扱う

モデルカタログに含まれていないモデルの場合、Azure Machine Learning には、任意のモデルを扱うためのオープンで拡張可能なプラットフォームが用意されています。 Azure Machine Learning のオープンで拡張可能なプラットフォーム機能を使用して、任意のフレームワークまたはランタイムでモデルを導入できます。このような拡張機能には、フレームワークとランタイムをパッケージ化できるコンテナー用の Azure Machine Learning 環境や、モデルを評価または微調整するためのコード用の Azure Machine Learning パイプラインなどがあります。 モデルをインポートし、組み込みのランタイムとパイプラインを操作するためのサンプル リファレンスについては、このノートブックを参照してください。

従量課金制のサーバーレス API

モデルカタログ内の特定のモデルは、従量課金制のサーバーレス API としてデプロイできます。このデプロイ方法は、サービスとしてのモデル (MaaS) と呼ばれます。 MaaS を介して使用できるモデルは、Microsoft によって管理されるインフラストラクチャでホストされます。これにより、モデル プロバイダーのモデルへの API ベースのアクセスが可能になります。 API ベースのアクセスにより、モデルへのアクセス コストが大幅に削減され、プロビジョニング エクスペリエンスは大変、シンプルなものになります。 ほとんどの MaaS モデルは、トークンベースの価格で使用できます。

MaaS でサード パーティ製モデルを利用可能にする方法

従量課金制のサーバーレス API としてデプロイできるモデルは、モデル プロバイダーによって提供されますが、Microsoft が管理する Azure インフラストラクチャでホストされ、API を介してアクセスされます。 モデル プロバイダーがライセンス条項を定義し、モデルの使用価格を設定する一方、Azure Machine Learning service はホスティング インフラストラクチャを管理し、推論 API を使用できるようにします。また、MaaS 経由でデプロイされたモデルによって送信されるプロンプトとコンテンツ出力のデータ プロセッサとして機能します。 MaaS のデータ処理の詳細については、データのプライバシーに関する記事を参照してください。

MaaS でのモデル使用量に対する支払い

MaaS を介してデプロイされたモデルの検索、サブスクリプション、従量課金エクスペリエンスは、Azure AI Studio と Azure Machine Learning スタジオにあります。 ユーザーはモデルの使用に関するライセンス条項に同意し、デプロイ時に従量課金に関する価格情報が提供されます。 サード パーティ プロバイダーのモデルは、商用マーケットプレースの使用条件に従って Azure Marketplace を通じて課金されます。Microsoft のモデルは、ファースト パーティの従量課金サービスとして、Azure メーターを使用して課金されます。 製品条項で説明されているように、ファースト パーティの従量課金サービスは Azure メーターを使用して購入されますが、Azure サービスのご契約条件の対象ではありません。これらのモデルの使用には、提供されるライセンス条項が適用されます。

MaaS を使用して推論用のモデルをデプロイする

MaaS を使用してモデルをデプロイすると、ユーザーはインフラストラクチャの構成や GPU のプロビジョニングの必要なしに、推論 API を使用する準備が整い、エンジニアリング時間とリソースを節約できます。 これらの API は複数の LLM ツールと統合でき、前のセクションで説明したように、使用量に対して課金されます。

従量課金制で MaaS を使用してモデルを微調整する

MaaS を通じた利用が可能で微調整をサポートしているモデルの場合、ユーザーは、従量課金制でホストされたファインチューニングを活用し、ユーザー データを使用してモデルを調整することができます。 詳細については、Azure AI Studio での「Llama 2 モデルを微調整する」を参照してください。

MaaS を介してデプロイされたモデルでの RAG

Azure AI Studio を使用すると、ユーザーはベクトル インデックスと検索拡張生成 (RAG) を利用できます。 サーバーレス API 経由でデプロイできるモデルを使用して、カスタム データに基づいて埋め込みと推論を生成し、ユース ケースに固有の回答を生成できます。 詳細については、「取得拡張生成とインデックス」を参照してください。

オファーとモデルのリージョン別の利用可能性

従量課金制のデプロイは、モデル プロバイダーがオファーを利用可能にしている国の課金アカウントに属する Azure サブスクリプションを持つユーザーのみが利用できます (次のセクションの表の「オファーの利用可能リージョン」を参照)。 関連するリージョンでオファーを利用できる場合、ユーザーは Azure リージョン内にワークスペースを持っている必要があります。このワークスペースでは、該当する場合はモデルをデプロイまたは微調整できます (下の表の「ワークスペース リージョン」列を参照)。

| モデル | オファーの可用性リージョン | デプロイ用のワークスペース リージョン | 微調整用のワークスペース リージョン |

|---|---|---|---|

| Llama-3-70B-Instruct Llama-3-8B-Instruct |

Microsoft 管理対象国 | 米国東部 2、スウェーデン中部、米国中北部、米国中南部、米国西部、米国東部、米国西部 3 | 使用不可 |

| Llama-2-7b Llama-2-13b Llama-2-70b |

Microsoft 管理対象国 | 米国東部 2、米国東部、米国西部 3、米国西部、米国中北部、米国中南部 | 米国西部 3 |

| Llama-2-7b-chat Llama-2-13b-chat Llama-2-70b-chat |

Microsoft 管理対象国 | 米国東部 2、米国東部、米国西部 3、米国西部、米国中北部、米国中南部 | 使用不可 |

| Mistral Small | Microsoft 管理対象国 | 米国東部 2、スウェーデン中部、米国中北部、米国中南部、米国東部、米国西部 3、米国西部 | 使用不可 |

| Mistral-Large | Microsoft 管理対象の国 ブラジル 香港特別行政区 イスラエル |

米国東部、米国東部 2、米国中北部、米国中南部、スウェーデン中部、米国西部、米国西部 3 | 使用不可 |

| Cohere-command-r-plus Cohere-command-r Cohere-embed-v3-english Cohere-embed-v3-multilingual |

Microsoft 管理対象国 日本 |

米国東部 2、スウェーデン中部、米国中北部、米国中南部、米国東部、米国西部 3、米国西部 | 使用不可 |

| TimeGEN-1 | Microsoft 管理対象国 メキシコ イスラエル |

米国東部、米国東部 2、米国中北部、米国中南部、スウェーデン中部、米国西部、米国西部 3 | 使用不可 |

| jais-30b-chat | Microsoft 管理対象国 | 米国東部 2、スウェーデン中部、米国中北部、米国中南部、米国東部、米国西部 3、米国西部 | 使用不可 |

| Phi-3-mini-4k-instruct | Microsoft 管理対象国 | 米国東部 2、スウェーデン中部、カナダ中部、米国西部 3 | 使用不可 |

| Phi-3-mini-128k-instruct | Microsoft 管理対象国 | 米国東部 2、スウェーデン中部 | 使用不可 |

| Phi-3-medium-4k-instruct、Phi-3-medium-128k-instruct | Microsoft 管理対象国 | 米国東部 2、スウェーデン中部 | 使用不可 |

MaaS でデプロイされたモデルのコンテンツの安全性

重要

現在、この機能はパブリック プレビュー段階にあります。 このプレビュー バージョンはサービス レベル アグリーメントなしで提供されており、運用環境のワークロードに使用することは推奨されません。 特定の機能はサポート対象ではなく、機能が制限されることがあります。

詳しくは、Microsoft Azure プレビューの追加使用条件に関するページをご覧ください。

MaaS を使用してデプロイされた言語モデルの場合、Azure Machine Learning で、有害なコンテンツ (ヘイト、自傷行為、性的、暴力的なコンテンツ) を検出する Azure AI Content Safety テキスト モデレーション フィルターの既定の構成が実装されます。 コンテンツのフィルター処理 (プレビュー) の詳細については、「Azure AI Content Safety の有害なカテゴリ」を参照してください。

コンテンツのフィルター処理 (プレビュー) は、サービスがプロンプトを処理してコンテンツを生成する際に同期的に行われ、その使用に対し、AACS の価格に従って別個に課金される場合があります。 個々のサーバーレス エンドポイントのコンテンツのフィルター処理 (プレビュー) は、言語モデルを初めてデプロイするとき、またはデプロイの詳細ページでコンテンツのフィルター処理の切り替えを選択して、無効にすることができます。 Azure AI モデル推論 API 以外の API を通じて MaaS でモデルを使用する場合、コンテンツのフィルター処理は、Azure AI Content Safety を使用して別個に実装しない限り、有効になりません。 コンテンツのフィルター処理を行わずに MaaS でモデルを使用すると、ユーザーに有害なコンテンツが表示されるリスクが高まります。

詳細情報

- Azure Machine Learning スタジオ UI またはコード ベースの方法を用いた微調整、評価、デプロイについて、Azure Machine Learning の基盤モデルを使用する方法に関するページを参照してください。

- Azure Machine Learning スタジオでモデル カタログを調べます。 カタログを調べるには、Azure Machine Learning ワークスペースが必要です。

- Azure Machine Learning によってキュレーションされたモデルの評価、微調整、デプロイ。

フィードバック

以下は間もなく提供いたします。2024 年を通じて、コンテンツのフィードバック メカニズムとして GitHub の issue を段階的に廃止し、新しいフィードバック システムに置き換えます。 詳細については、「https://aka.ms/ContentUserFeedback」を参照してください。

フィードバックの送信と表示