重要

2023 年 9 月 20 日以降は、新しい Personalizer リソースを作成できなくなります。 Personalizer サービスは、2026 年 10 月 1 日に廃止されます。

オフライン評価を作成し、その結果を解釈する方法について説明します。

オフライン評価を使用すると、ログ (履歴) データの期間におけるアプリケーションの既定の動作と比較して Personalizer がどの程度効果的であるかを測定し、ご使用のモデルに対して他のモデル構成設定がどの程度優れたパフォーマンスを示すかを評価できます。

オフライン評価を作成すると、"最適化検出" オプションは、さまざまな学習ポリシー値に対してオフライン評価を実行して、モデルのパフォーマンスを向上させる可能性のある値を見つけます。 オフライン評価で評価する追加ポリシーを提供することもできます。

詳細については、「オフライン評価」を参照してください。

前提条件

- 構成済みの Personalizer リソース

- Personalizer リソースには、代表的な量のログ データが含まれている必要があります。意味のある評価結果を得るには、おおよそ、50,000 個以上のイベントをログに記録することをお勧めします。 必要に応じて、この評価でテストおよび比較する "学習ポリシー" ファイルを事前にエクスポートしておくこともできます。

オフライン評価を実行する

Azure portal で、Personalizer リソースを見つけます。

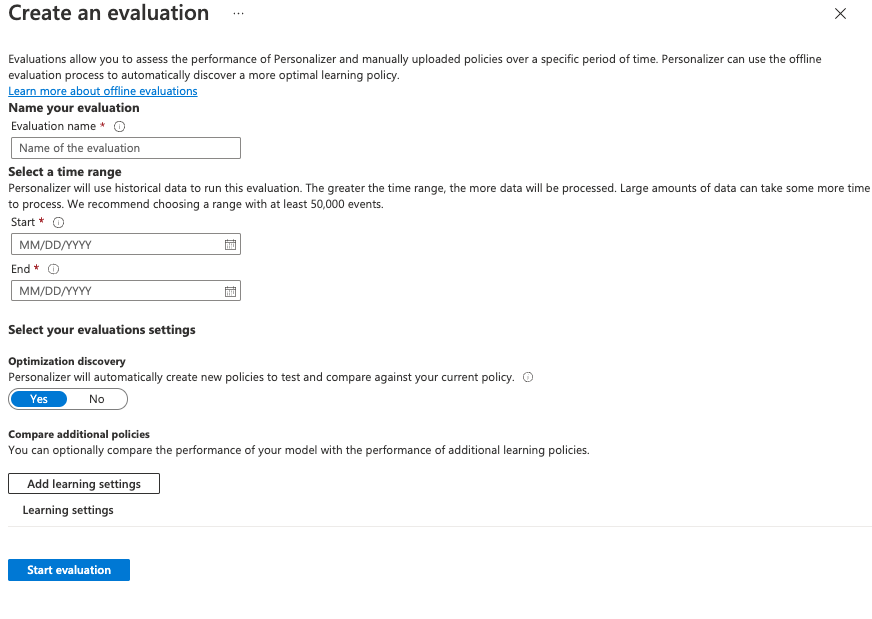

Azure portal で、 [評価] セクションに移動し、 [評価の作成] を選択します。

![Azure portal で、[評価] セクションに移動し、[評価の作成] を選択します。](media/offline-evaluation/create-new-offline-evaluation.png)

[評価の作成] ウィンドウでオプションを入力します。

- 評価名。

- [開始日] と [終了日] - これらの日付では、評価で使用するデータの範囲を指定します。 このデータは、[Data Retention](データ保有期間) 値で指定したとおりにログに存在する必要があります。

- Personalizer がより最適な学習ポリシーを探すようにしたい場合は、[最適化の検出] を [はい] に設定します。

- 学習設定の追加 - カスタムまたは以前にエクスポートされたポリシーを評価する場合は、学習ポリシー ファイルをアップロードします。

[Start evaluation] (評価を開始) を選択して評価を開始します。

評価の結果を確認する

処理するデータの量、比較する学習ポリシーの数、および最適化が要求されたかどうかによっては、評価の実行に時間がかかる場合があります。

完了したら、評価の一覧から評価を選択し、 [アプリケーションのスコアを他の潜在的な学習設定と比較します] を選択できます。 現在の学習ポリシーのパフォーマンスと新しいポリシーを比較したい場合は、この機能を選択します。

次に、学習ポリシーのパフォーマンスを確認します。

グラフにさまざまな学習ポリシーが表示されるほか、その推定平均報酬、信頼区間、特定のポリシーをダウンロードまたは適用するためのオプションも表示されます。

- "Online" - Personalizer の現在のポリシー

- "Baseline1" - アプリケーションのベースライン ポリシー

- "BaselineRand" - ランダムにアクションを実行するポリシー

- "Inter-len#" または "Hyper#" - 最適化検出によって作成されたポリシー。

モデルをデータに最適に向上させるポリシーを適用するには、 [適用] を選択します。

次のステップ

- オフライン評価のしくみについてさらに詳しく学習します。