Azure AI Studio プレイグラウンドでプロンプトを手動で評価する

重要

この記事で "(プレビュー)" と付記されている項目は、現在、パブリック プレビュー段階です。 このプレビューはサービス レベル アグリーメントなしで提供されており、運用環境ではお勧めしません。 特定の機能はサポート対象ではなく、機能が制限されることがあります。 詳しくは、Microsoft Azure プレビューの追加使用条件に関するページをご覧ください。

プロンプト エンジニアリングを開始すると、プロンプトの効果に非常に時間がかかる可能性があることを評価するために、一度にさまざまな入力をテストする必要があります。 これを行うのは、コンテンツ フィルターが適切に機能しているか、応答が正確であるかなどを確認することが重要であるためです。

このプロセスをよりシンプルにするために、Azure AI Studio の手動評価を利用できます。この評価ツールは、単一のインターフェイスでテスト データに対してプロンプトを継続的に繰り返して評価できるようにします。 また、出力 (モデルの応答) を手動で評価することもできます。これは、プロンプトへの信頼を得るのに役立ちます。

手動評価により、プロンプトがどの程度機能しているかを把握し、プロンプトを繰り返して評価することで、望ましい信頼レベルに到達したことを確認できます。

この記事では、次のことについて説明します。

- 手動評価の結果を生成する

- モデルの応答を評価する

- プロンプトを繰り返して再評価する

- 結果の保存と比較

- 組み込みメトリックを使用した評価

前提条件

手動で評価結果を作成するには、次を準備する必要があります。

次のいずれかの形式のテスト データセット: csv または jsonl。 データセットをお持ちでない場合は、UI から手動でデータを入力することもできます。

これらのモデルのいずれかのデプロイ: GPT 3.5 モデル、GPT 4 モデル、Davinci モデル。 デプロイを作成する方法の詳細については、モデルのデプロイに関するページを参照してください。

Note

現時点では、手動評価は、チャットと入力候補タスクの種類に対して Azure OpenAI モデルでのみサポートされています。

手動評価の結果を生成する

[プレイグラウンド] で [手動評価] を選択して、テスト データとプロンプトに基づいてモデル応答を手動で確認するプロセスを開始します。 プロンプトは自動的に [手動評価] に移行され、あとはプロンプトを評価するためのテスト データを追加する必要があるだけです。

これは、[入力] 列のテキスト ボックスを使用して手動で行うことができます。

また、データをインポートして、プロジェクト内の既存のデータセットから 1 つを選択するか、CSV または JSONL 形式のデータセットをアップロードすることもできます。 データを読み込んだ後、列を適切にマッピングするようプロンプトが表示されます。 終了してインポートを選択すると、以下の列にデータが適切に入力されます。

Note

手動評価には 50 行まで入力行を追加できます。 テスト データの入力行数が 50 行を超える場合は、入力列の最初の 50 行をアップロードします。

これでデータが追加され、実行すると出力列にモデルの応答を入力できます。

モデルの応答を評価する

プロンプトの出力を評価するために、各回答にサムアップまたはサムダウンの評価を付けることができます。 提供された評価に基づいて、これらの応答スコアを早見表の概要で確認できます。

プロンプトを繰り返して再評価する

概要に基づき、プロンプトに変更を加える必要がある場合があります。 上記のプロンプト コントロールを使用して、プロンプトの設定を編集できます。 これには、システム メッセージの更新、モデルの変更、パラメーターの編集などがあります。

編集後、テーブル全体を更新するためにすべてを再実行するか、初回に期待される回答を満たさなかった特定の行に焦点を当てて再実行するかを選択できます。

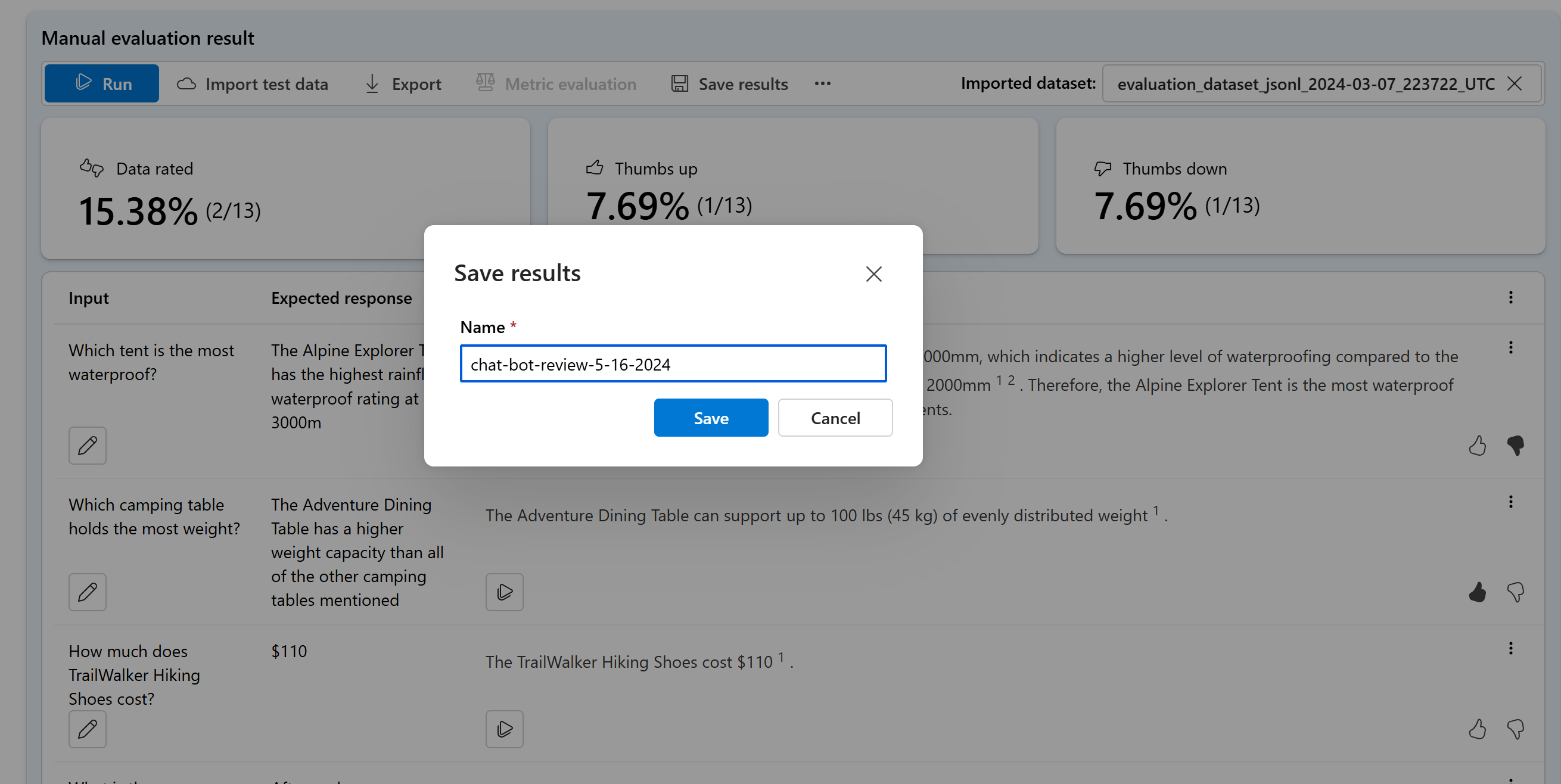

結果の保存と比較

結果を入力した後、結果を保存してチームと進捗状況を共有したり、後で中断したところから手動評価を続行したりすることができます。

また、手動評価を保存し、[評価] タブの手動評価で表示することで、異なる手動評価でサムアップとサムダウンの評価を比較することもできます。

次のステップ

生成 AI アプリケーションを評価する方法の詳細については、次を参照してください。

損害の軽減手法についての詳細情報。