Document Intelligence モデルを使用する

このコンテンツの対象:![]() v3.1 (GA) | 最新バージョン:

v3.1 (GA) | 最新バージョン:![]() v4.0 (プレビュー) | 以前のバージョン:

v4.0 (プレビュー) | 以前のバージョン:![]() v3.0

v3.0![]() v2.1

v2.1

このコンテンツの対象:![]() v3.0 (GA) | 最新バージョン:

v3.0 (GA) | 最新バージョン:![]() v4.0 (プレビュー)

v4.0 (プレビュー)![]() v3.1 | 以前のバージョン:

v3.1 | 以前のバージョン:![]() v2.1

v2.1

このコンテンツの適用対象:![]() v2.1 | 最新バージョン:

v2.1 | 最新バージョン:![]() v4.0 (プレビュー)

v4.0 (プレビュー)

このガイドでは、アプリケーションとワークフローに Document Intelligence モデルを追加する方法について説明します。 任意のプログラミング言語または REST API を使用します。

Azure AI Document Intelligence は、機械学習を使用してドキュメントから主要なテキストと構造体要素を抽出するクラウドベースの Azure AIサービス です。 このテクノロジを学習している間は、無料のサービスを使用することをお勧めします。 無料のページは 1 か月あたり 500 ページに制限されていることに注意してください。

次の Document Intelligence モデルから選択して、フォームとドキュメントからデータと値を分析および抽出します:

事前構築済みの読み取り モデルは、すべての ドキュメントインテリジェンス モデルの中核であり、行、単語、場所、言語を検出できます。 レイアウト、一般的なドキュメント、事前構築済み、カスタムの各モデルでは、ドキュメントからテキストを抽出するための基盤として

readモデルが使用されます。事前構築済みレイアウト モデルは、ドキュメントと画像からテキストとテキストの場所、テーブル、選択マーク、構造体情報を抽出します。 オプションのクエリ文字列パラメーター

features=keyValuePairsが有効になっているレイアウト モデルを使用して、キーと値のペアを抽出できます。prebuilt-contract モデルは、契約合意から重要な情報を抽出します。

prebuilt-healthInsuranceCard.us モデルは、米国の医療保険カードから重要な情報を抽出します。

事前構築済み税務書類モデルは、US 納税申告書で報告された情報を抽出します。

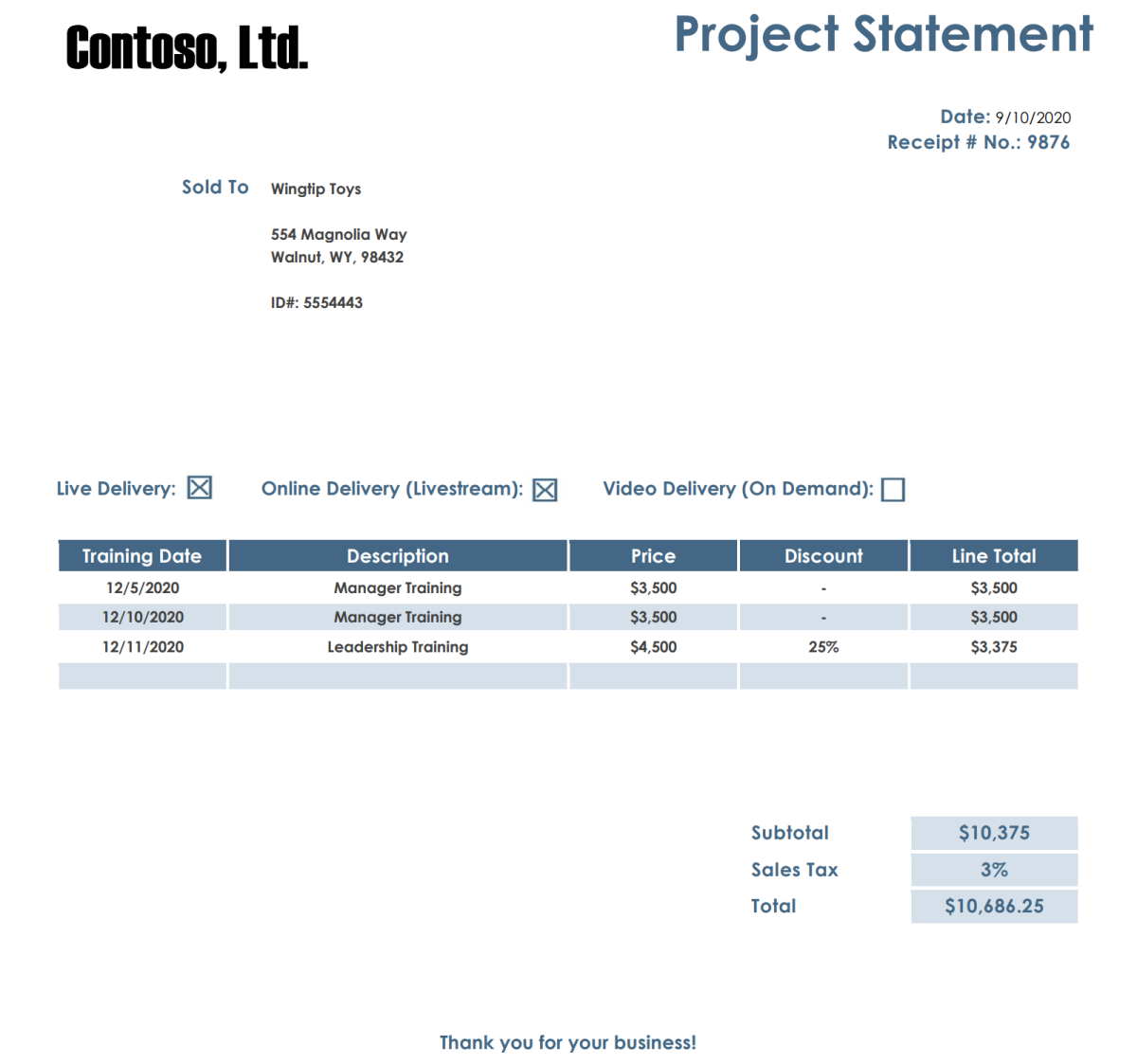

事前構築済み請求書モデルは、さまざまな形式と品質の売上請求書から主なフィールドと品目を抽出します。 フィールドには、電話でキャプチャされた画像、スキャンされたドキュメント、デジタル PDF などが含まれます。

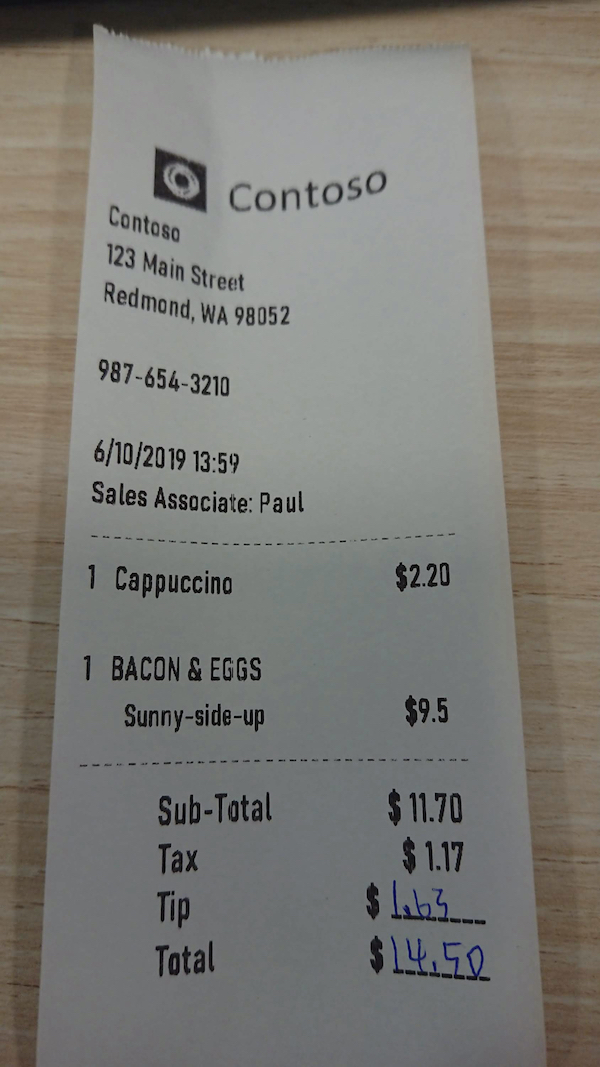

事前構築済み領収書モデルでは、印刷された領収書と手書きのレシートから重要な情報を分析して抽出します。

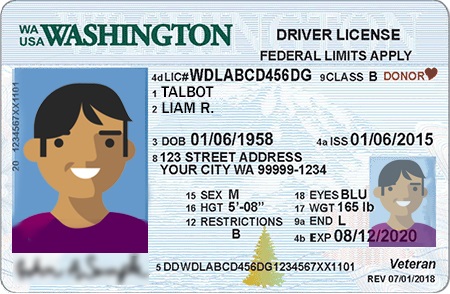

事前構築済み idDocument モデルは、米国の運転免許証、国際パスポートの略歴ページ、米国の州の ID、社会保障カード、永住者カードから重要な情報を抽出します。

- 事前構築済み businessCard モデルは、名刺の画像から重要な情報と連絡先の詳細を抽出します。

前提条件

Azure サブスクリプション。無料で作成できます。

Azure AI サービスまたは Document Intelligence リソース。 単一サービスまたはマルチサービスを作成します。 Free 価格レベル (

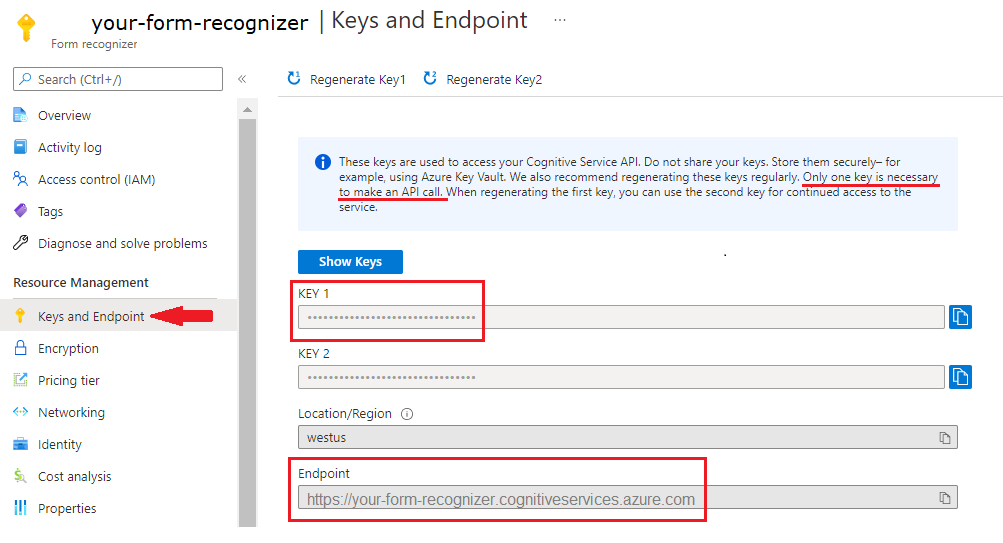

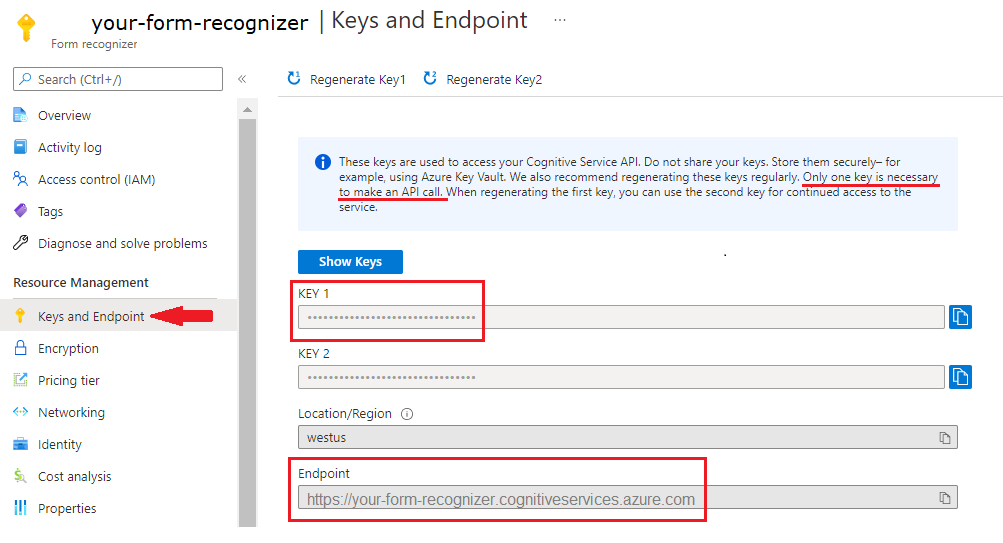

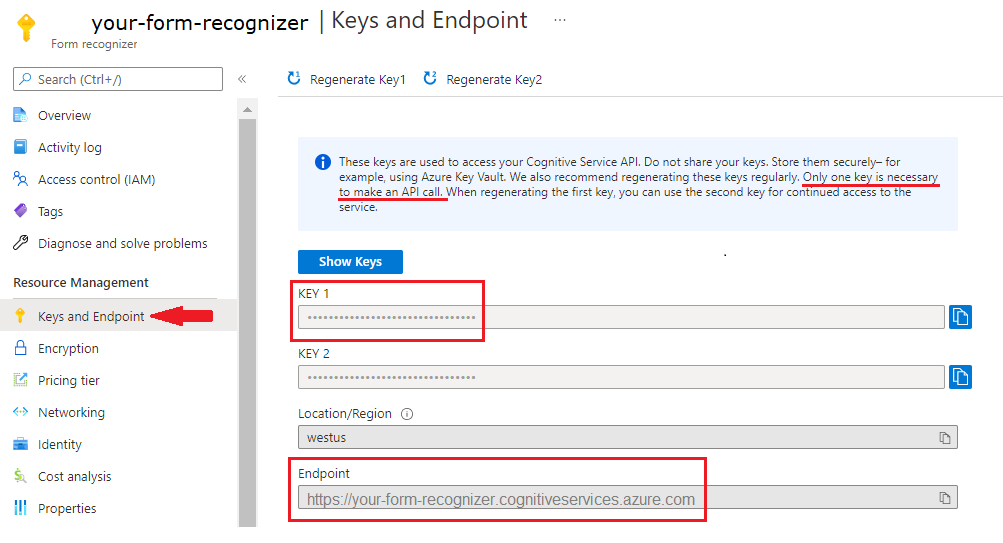

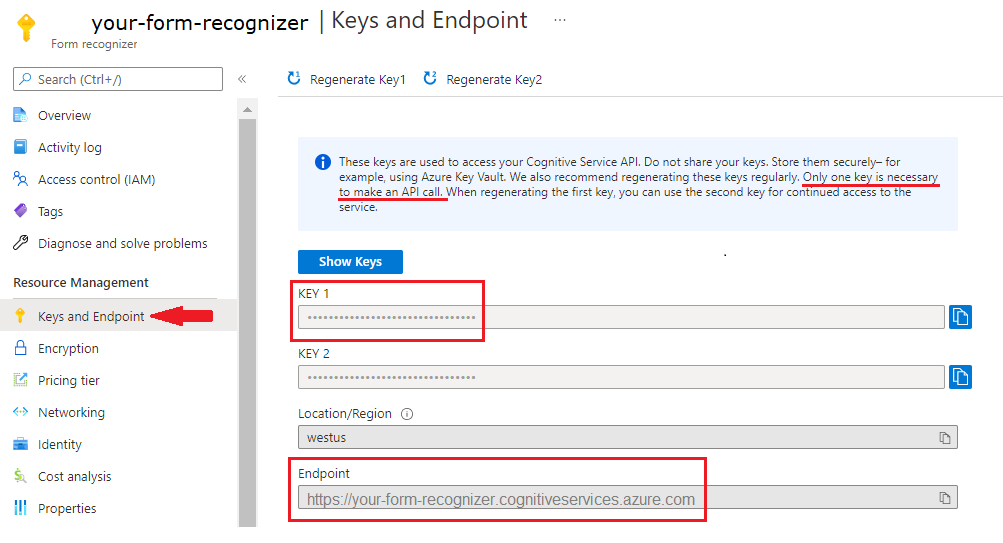

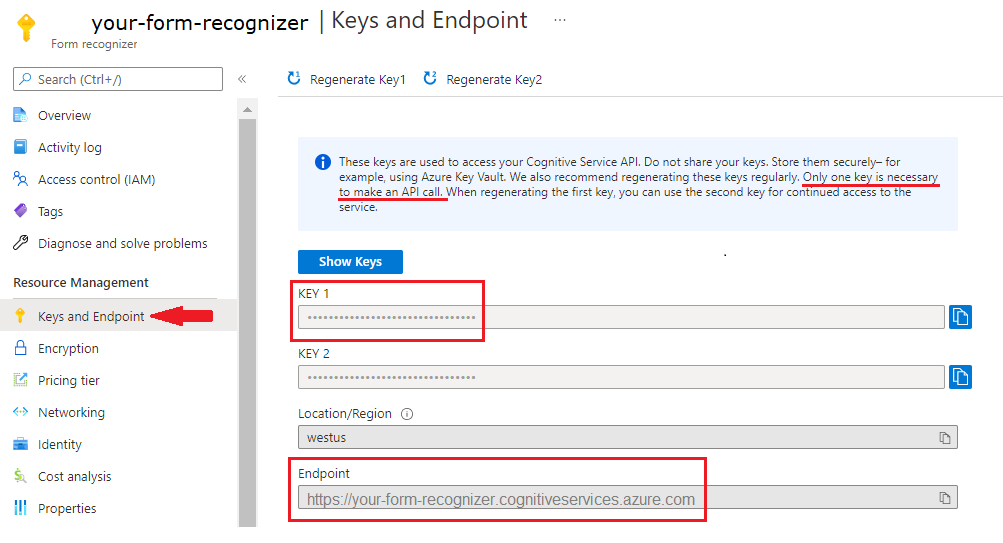

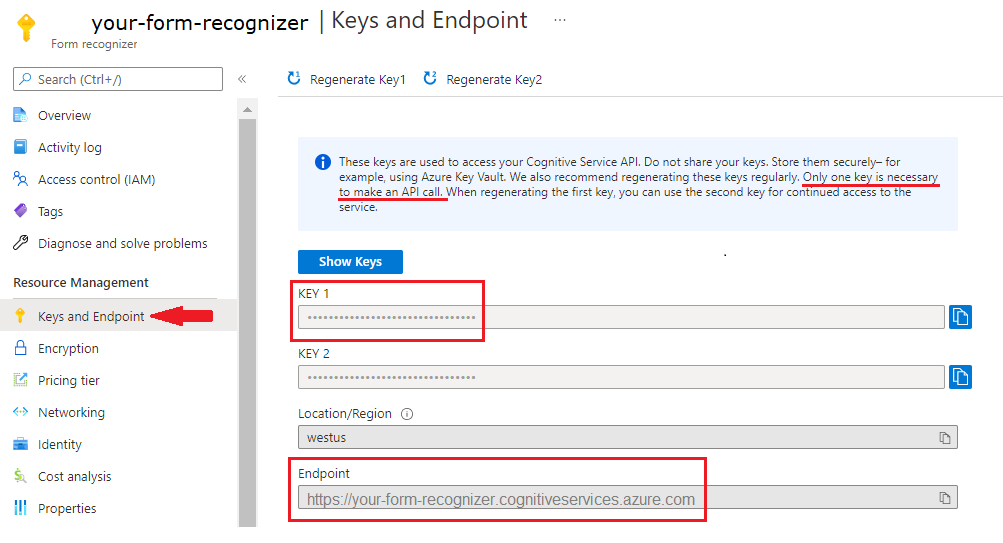

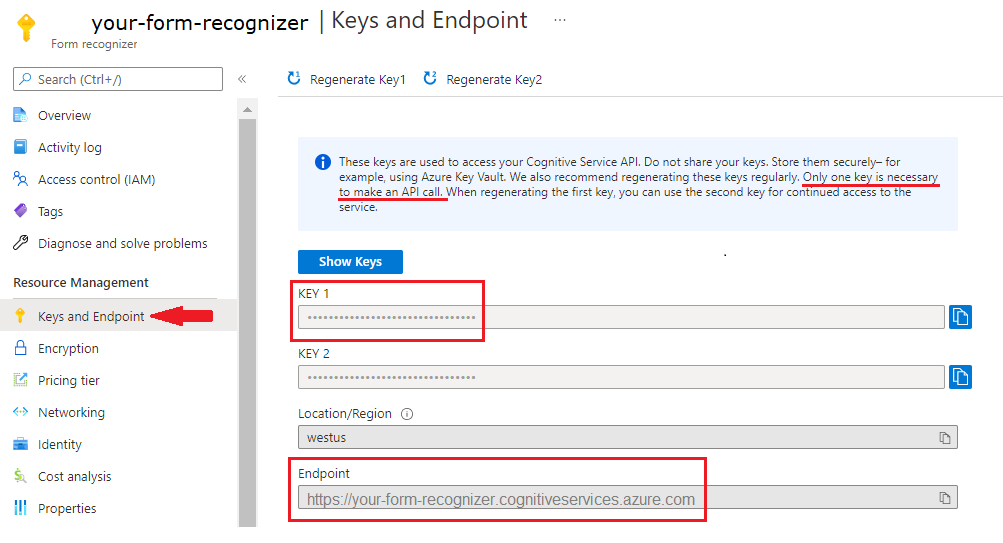

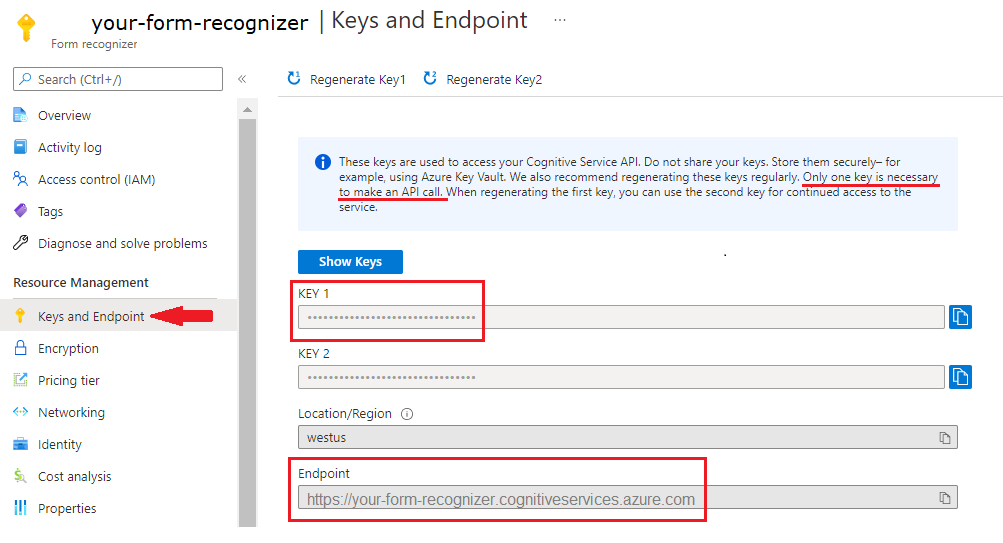

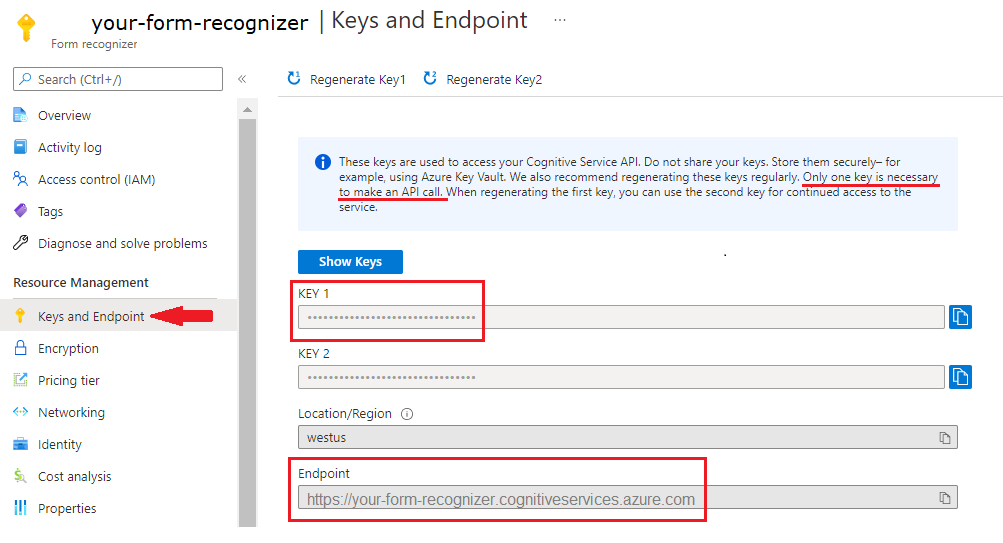

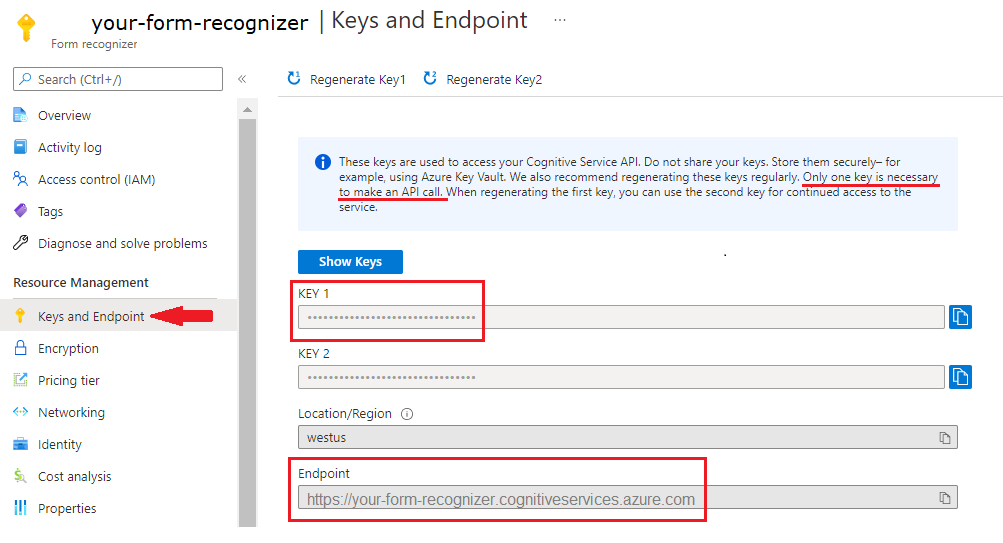

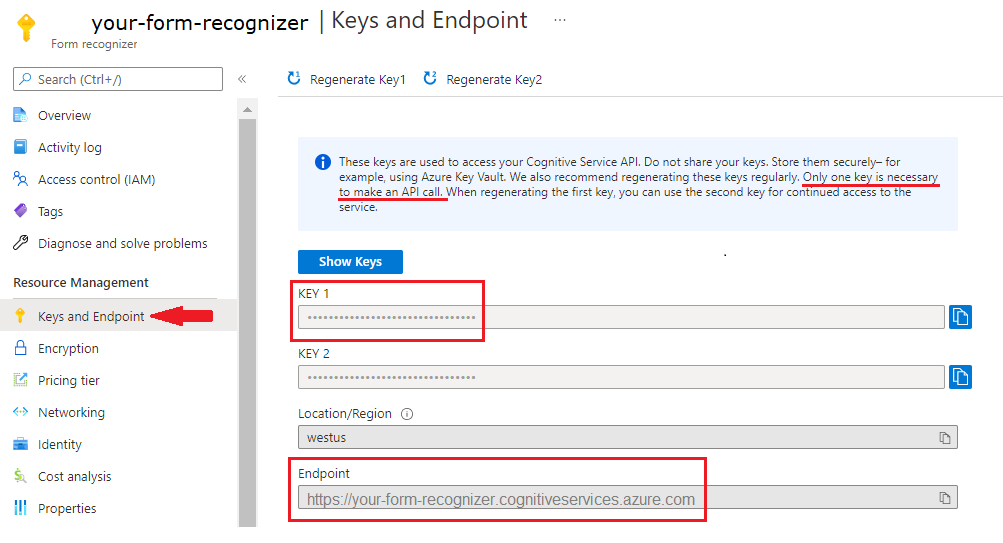

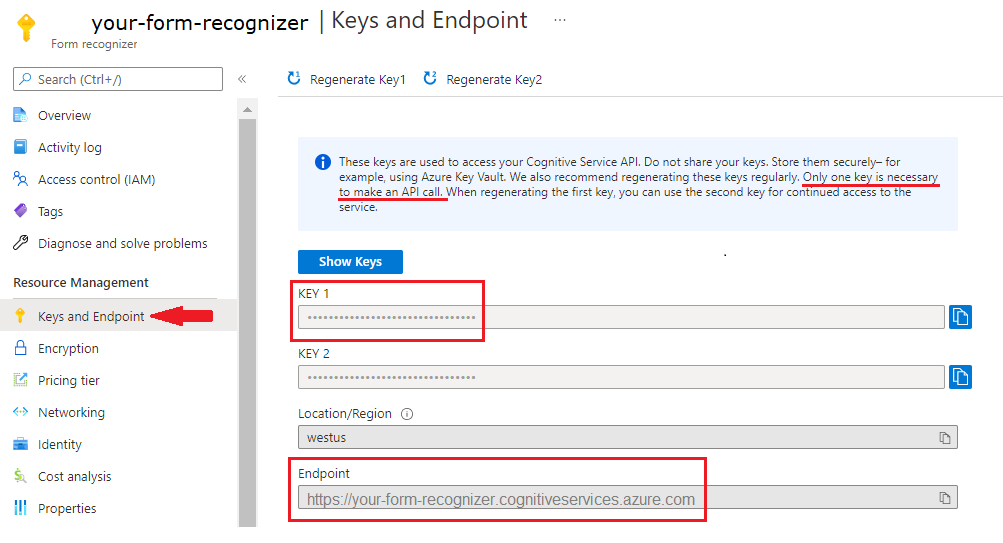

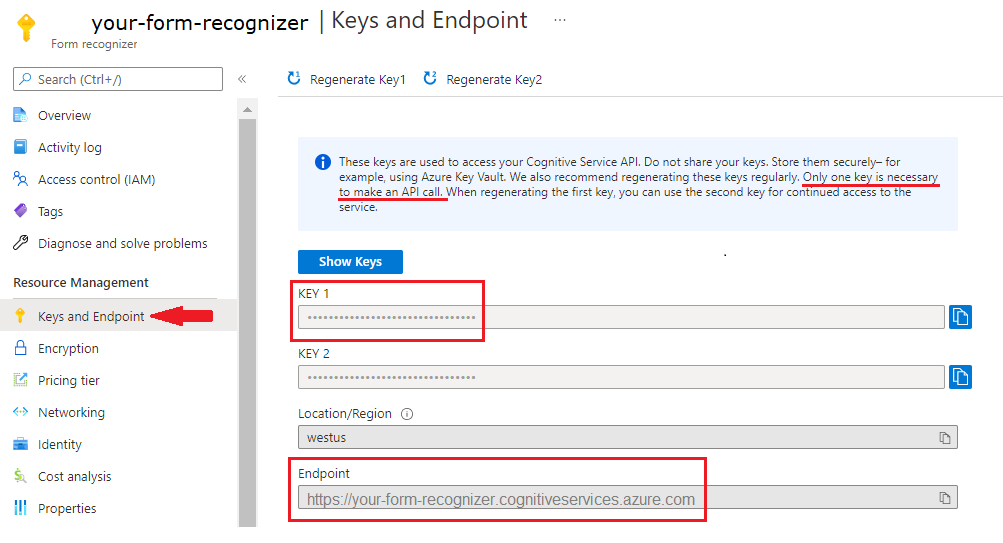

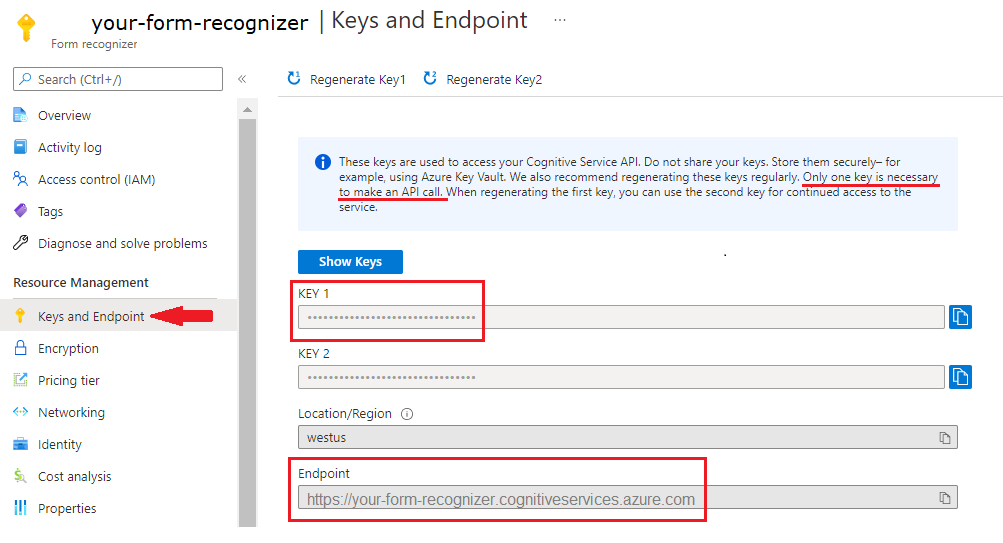

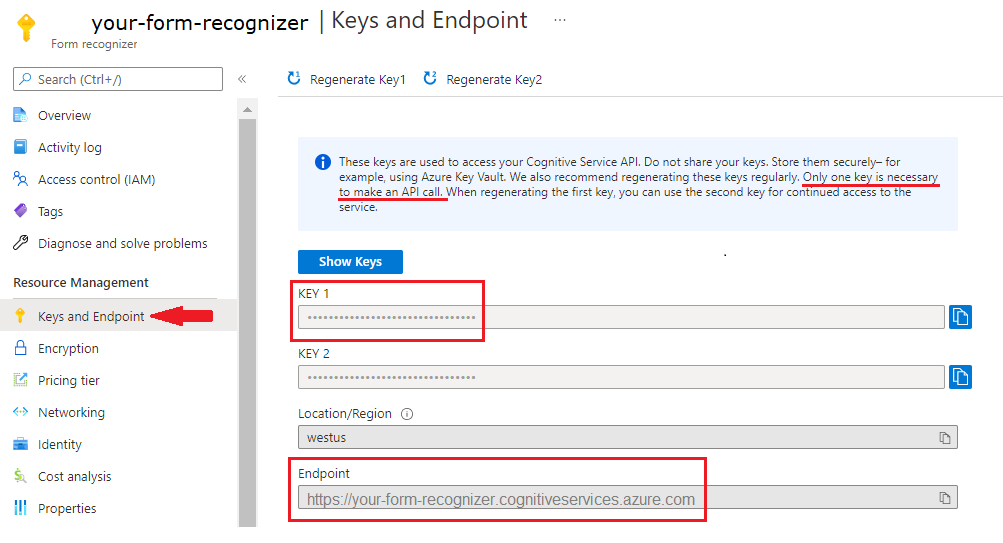

`F0` ) を使用してサービスを試用し、後から運用環境用の有料レベルにアップグレードすることができます。アプリケーションを Document Intelligence API に接続するために作成したリソースのキーとエンドポイント。

- リソースがデプロイされたら、 [リソースに移動] を選択します。

- 左側のナビゲーション メニューで、[キーとエンドポイント] を選択します。

- この記事の後半で使用するために、いずれかのキーとエンドポイントをコピーします。

URL で指定された場所にあるドキュメント ファイル。 このプロジェクトでは、各機能について、次の表に示すサンプル フォームを使用できます。

機能 modelID document-url 読み取りモデル prebuilt-read サンプル パンフレット レイアウト モデル 事前構築済みレイアウト 予約確認のサンプル W-2 フォーム モデル prebuilt-tax.us.w2 サンプル W-2 フォーム 請求書モデル prebuilt-invoice サンプル請求書 レシート モデル prebuilt-receipt サンプル レシート 身分証明書モデル prebuilt-idDocument サンプル身分証明書 名刺モデル 事前構築された名刺 サンプル名刺

環境変数を設定する

Document Intelligence サービスとやり取りするには、DocumentAnalysisClient クラスのインスタンスを作成する必要があります。 これを行うには、Azure portal から key と endpoint を使用してクライアントをインスタンス化します。 このプロジェクトでは、資格情報の格納とアクセスに環境変数を使用します。

重要

キーをコードに直接含めたり、公開したりしないでください。 運用環境では、Azure Key Vault など、資格情報を保存してアクセスするための安全な方法を使用してください。 詳しくは、「Azure AI サービスのセキュリティ」をご覧ください。

ドキュメントインテリジェンスリソース キーの環境変数を設定するには、コンソール ウィンドウを開き、オペレーティング システムと開発環境の指示に従います。 <yourKey> と <yourEndpoint> を、Azure portal 内のご自分のリソースの値に置き換えます。

Windows の環境変数では大文字と小文字は区別されません。 通常は大文字で宣言され、単語はアンダースコアで結合されます。 コマンド プロンプトで、次のコマンドを実行します。

キー変数を設定します。

setx DI_KEY <yourKey>エンドポイント変数を設定する

setx DI_ENDPOINT <yourEndpoint>環境変数を設定したら、[コマンド プロンプト] ウィンドウを閉じます。 値は、もう一度変更するまで保持されます。

環境変数を読み取る実行中のプログラムを再起動します。 たとえば、Visual Studio または Visual Studio Code をエディターとして使用している場合、サンプル コードを実行する前に再起動する必要があります。

環境変数で使用するのに役立つコマンドをいくつか次に示します。

| コマンド | アクション | 例 |

|---|---|---|

setx VARIABLE_NAME= |

値を空の文字列に設定して、環境変数を削除します。 | setx DI_KEY= |

setx VARIABLE_NAME=value |

環境変数の値を設定または変更します | setx DI_KEY=<yourKey> |

set VARIABLE_NAME |

特定の環境変数の値を表示します。 | set DI_KEY |

set |

すべての環境変数を表示します。 | set |

プログラミング環境のセットアップ

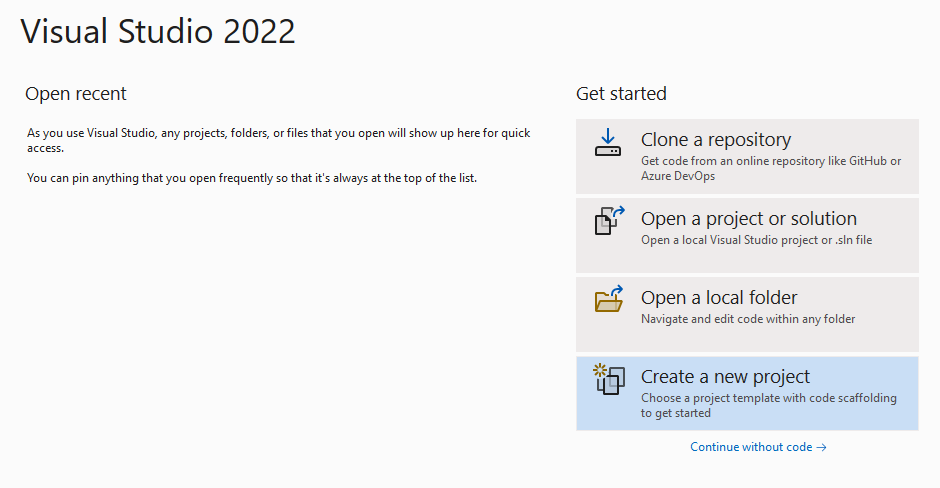

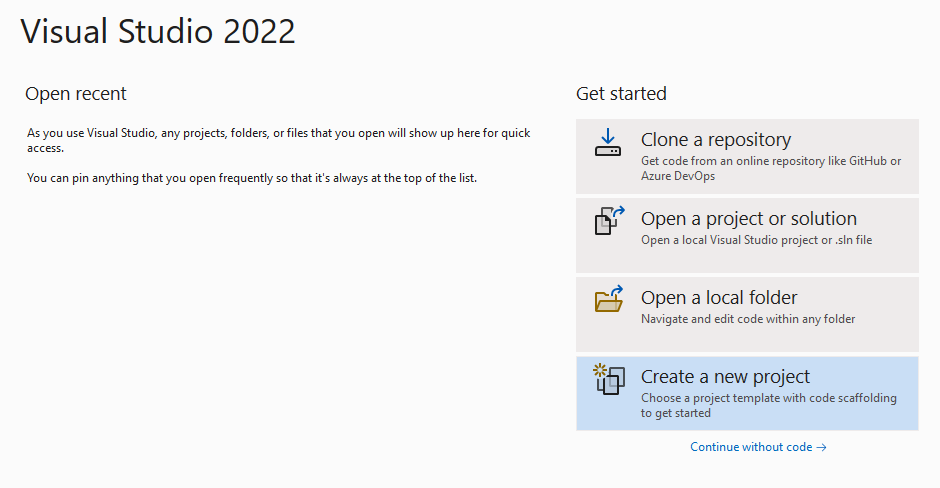

Visual Studio を起動します。

スタート ページで、[新しいプロジェクトの作成] を選択します。

[新しいプロジェクトの作成] ページで、検索ボックスに「コンソール」と入力します。 [コンソール アプリケーション] テンプレートを選択し、[次へ] を選択します。

![Visual Studio の [新しいプロジェクトの作成] ページのスクリーンショット。](../media/quickstarts/create-new-project.png?view=doc-intel-4.0.0)

[新しいプロジェクトの構成] ページの [プロジェクト名] に「docIntelligence_app」と入力します。 [次へ] を選択します。

![Visual Studio の [新しいプロジェクトの構成] ページのスクリーンショット。](../media/quickstarts/configure-new-project-console.png?view=doc-intel-4.0.0)

[追加情報] ページで、[.NET 8.0 (長期的なサポート)] を選択し、[作成] を選択します。

![Visual Studio の [追加情報] ページのスクリーンショット。](../media/quickstarts/additional-information.png?view=doc-intel-4.0.0)

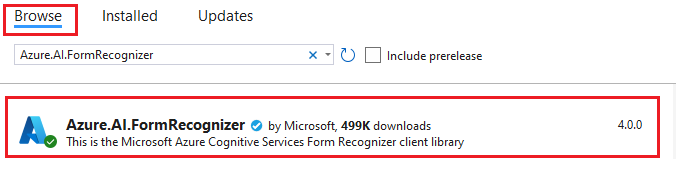

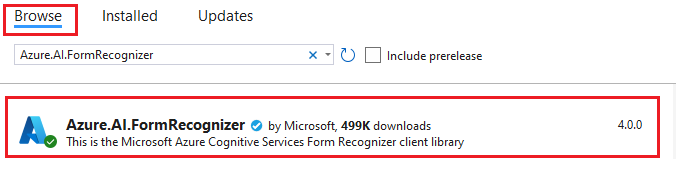

NuGet を使用してクライアント ライブラリをインストールする

docIntelligence_app プロジェクトを右クリックし、[Manage NuGet Packages...] (NuGet パッケージの管理...) を選択します。

[参照] タブを選択し、「Azure.AI.FormRecognizer」と入力します。

ドロップダウン メニューからバージョンを選択し、プロジェクトにパッケージをインストールします。

アプリケーションをビルドする

注意

.NET 6 以降では、console テンプレートを使用する新しいプロジェクトによって、以前のバージョンとは異なる新しいプログラム スタイルが生成されます。 この新しい出力では、記述する必要があるコードを簡素化できる最新の C# 機能が使用されています。

新しいバージョンで使用する場合、記述する必要があるのは、

Program.cs ファイルを開きます。

行

Console.Writeline("Hello World!")を含む既存のコードを削除します。次のいずれかのコード サンプルを選択してコピーし、アプリケーションの Program.cs ファイルに貼り付けます。

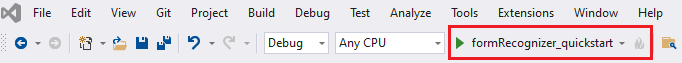

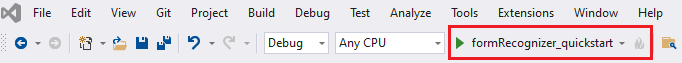

アプリケーションにコード サンプルを追加したら、プロジェクト名の横にある緑色の [開始] ボタンを選択してプログラムをビルドして実行するか、または F5 キーを押します。

読み取りモデルを使用する

using Azure;

using Azure.AI.FormRecognizer.DocumentAnalysis;

//use your `key` and `endpoint` environment variables to create your `AzureKeyCredential` and `DocumentAnalysisClient` instances

string key = Environment.GetEnvironmentVariable("DI_KEY");

string endpoint = Environment.GetEnvironmentVariable("DI_ENDPOINT");

AzureKeyCredential credential = new AzureKeyCredential(key);

DocumentAnalysisClient client = new DocumentAnalysisClient(new Uri(endpoint), credential);

//sample document

Uri fileUri = new Uri("https://raw.githubusercontent.com/Azure-Samples/cognitive-services-REST-api-samples/master/curl/form-recognizer/rest-api/read.png");

AnalyzeDocumentOperation operation = await client.AnalyzeDocumentFromUriAsync(WaitUntil.Completed, "prebuilt-read", fileUri);

AnalyzeResult result = operation.Value;

foreach (DocumentPage page in result.Pages)

{

Console.WriteLine($"Document Page {page.PageNumber} has {page.Lines.Count} line(s), {page.Words.Count} word(s),");

Console.WriteLine($"and {page.SelectionMarks.Count} selection mark(s).");

for (int i = 0; i < page.Lines.Count; i++)

{

DocumentLine line = page.Lines[i];

Console.WriteLine($" Line {i} has content: '{line.Content}'.");

Console.WriteLine($" Its bounding polygon (points ordered clockwise):");

for (int j = 0; j < line.BoundingPolygon.Count; j++)

{

Console.WriteLine($" Point {j} => X: {line.BoundingPolygon[j].X}, Y: {line.BoundingPolygon[j].Y}");

}

}

}

foreach (DocumentStyle style in result.Styles)

{

// Check the style and style confidence to see if text is handwritten.

// Note that value '0.8' is used as an example.

bool isHandwritten = style.IsHandwritten.HasValue && style.IsHandwritten == true;

if (isHandwritten && style.Confidence > 0.8)

{

Console.WriteLine($"Handwritten content found:");

foreach (DocumentSpan span in style.Spans)

{

Console.WriteLine($" Content: {result.Content.Substring(span.Index, span.Length)}");

}

}

}

Console.WriteLine("Detected languages:");

foreach (DocumentLanguage language in result.Languages)

{

Console.WriteLine($" Found language with locale'{language.Locale}' with confidence {language.Confidence}.");

}

read読み取りモデルの出力を表示するには、GitHub 上の Azure サンプル リポジトリにアクセスします。

レイアウト モデルを使用する

using Azure;

using Azure.AI.FormRecognizer.DocumentAnalysis;

//use your `key` and `endpoint` environment variables to create your `AzureKeyCredential` and `DocumentAnalysisClient` instances

string key = Environment.GetEnvironmentVariable("DI_KEY");

string endpoint = Environment.GetEnvironmentVariable("DI_ENDPOINT");

AzureKeyCredential credential = new AzureKeyCredential(key);

DocumentAnalysisClient client = new DocumentAnalysisClient(new Uri(endpoint), credential);

// sample document document

Uri fileUri = new Uri ("https://raw.githubusercontent.com/Azure-Samples/cognitive-services-REST-api-samples/master/curl/form-recognizer/rest-api/layout.png");

AnalyzeDocumentOperation operation = await client.AnalyzeDocumentFromUriAsync(WaitUntil.Completed, "prebuilt-layout", fileUri);

AnalyzeResult result = operation.Value;

foreach (DocumentPage page in result.Pages)

{

Console.WriteLine($"Document Page {page.PageNumber} has {page.Lines.Count} line(s), {page.Words.Count} word(s),");

Console.WriteLine($"and {page.SelectionMarks.Count} selection mark(s).");

for (int i = 0; i < page.Lines.Count; i++)

{

DocumentLine line = page.Lines[i];

Console.WriteLine($" Line {i} has content: '{line.Content}'.");

Console.WriteLine($" Its bounding polygon (points ordered clockwise):");

for (int j = 0; j < line.BoundingPolygon.Count; j++)

{

Console.WriteLine($" Point {j} => X: {line.BoundingPolygon[j].X}, Y: {line.BoundingPolygon[j].Y}");

}

}

for (int i = 0; i < page.SelectionMarks.Count; i++)

{

DocumentSelectionMark selectionMark = page.SelectionMarks[i];

Console.WriteLine($" Selection Mark {i} is {selectionMark.State}.");

Console.WriteLine($" Its bounding polygon (points ordered clockwise):");

for (int j = 0; j < selectionMark.BoundingPolygon.Count; j++)

{

Console.WriteLine($" Point {j} => X: {selectionMark.BoundingPolygon[j].X}, Y: {selectionMark.BoundingPolygon[j].Y}");

}

}

}

Console.WriteLine("Paragraphs:");

foreach (DocumentParagraph paragraph in result.Paragraphs)

{

Console.WriteLine($" Paragraph content: {paragraph.Content}");

if (paragraph.Role != null)

{

Console.WriteLine($" Role: {paragraph.Role}");

}

}

foreach (DocumentStyle style in result.Styles)

{

// Check the style and style confidence to see if text is handwritten.

// Note that value '0.8' is used as an example.

bool isHandwritten = style.IsHandwritten.HasValue && style.IsHandwritten == true;

if (isHandwritten && style.Confidence > 0.8)

{

Console.WriteLine($"Handwritten content found:");

foreach (DocumentSpan span in style.Spans)

{

Console.WriteLine($" Content: {result.Content.Substring(span.Index, span.Length)}");

}

}

}

Console.WriteLine("The following tables were extracted:");

for (int i = 0; i < result.Tables.Count; i++)

{

DocumentTable table = result.Tables[i];

Console.WriteLine($" Table {i} has {table.RowCount} rows and {table.ColumnCount} columns.");

foreach (DocumentTableCell cell in table.Cells)

{

Console.WriteLine($" Cell ({cell.RowIndex}, {cell.ColumnIndex}) has kind '{cell.Kind}' and content: '{cell.Content}'.");

}

}

GitHub の Azure サンプル リポジトリにアクセスし、 レイアウト モデルの出力を表示します。

一般的なドキュメント モデルを使用する

using Azure;

using Azure.AI.FormRecognizer.DocumentAnalysis;

//use your `key` and `endpoint` environment variables to create your `AzureKeyCredential` and `DocumentAnalysisClient` instances

string key = Environment.GetEnvironmentVariable("DI_KEY");

string endpoint = Environment.GetEnvironmentVariable("DI_ENDPOINT");

AzureKeyCredential credential = new AzureKeyCredential(key);

DocumentAnalysisClient client = new DocumentAnalysisClient(new Uri(endpoint), credential);

// sample document document

Uri fileUri = new Uri("https://raw.githubusercontent.com/Azure-Samples/cognitive-services-REST-api-samples/master/curl/form-recognizer/sample-layout.pdf");

AnalyzeDocumentOperation operation = await client.AnalyzeDocumentFromUriAsync(WaitUntil.Completed, "prebuilt-document", fileUri);

AnalyzeResult result = operation.Value;

Console.WriteLine("Detected key-value pairs:");

foreach (DocumentKeyValuePair kvp in result.KeyValuePairs)

{

if (kvp.Value == null)

{

Console.WriteLine($" Found key with no value: '{kvp.Key.Content}'");

}

else

{

Console.WriteLine($" Found key-value pair: '{kvp.Key.Content}' and '{kvp.Value.Content}'");

}

}

foreach (DocumentPage page in result.Pages)

{

Console.WriteLine($"Document Page {page.PageNumber} has {page.Lines.Count} line(s), {page.Words.Count} word(s),");

Console.WriteLine($"and {page.SelectionMarks.Count} selection mark(s).");

for (int i = 0; i < page.Lines.Count; i++)

{

DocumentLine line = page.Lines[i];

Console.WriteLine($" Line {i} has content: '{line.Content}'.");

Console.WriteLine($" Its bounding polygon (points ordered clockwise):");

for (int j = 0; j < line.BoundingPolygon.Count; j++)

{

Console.WriteLine($" Point {j} => X: {line.BoundingPolygon[j].X}, Y: {line.BoundingPolygon[j].Y}");

}

}

for (int i = 0; i < page.SelectionMarks.Count; i++)

{

DocumentSelectionMark selectionMark = page.SelectionMarks[i];

Console.WriteLine($" Selection Mark {i} is {selectionMark.State}.");

Console.WriteLine($" Its bounding polygon (points ordered clockwise):");

for (int j = 0; j < selectionMark.BoundingPolygon.Count; j++)

{

Console.WriteLine($" Point {j} => X: {selectionMark.BoundingPolygon[j].X}, Y: {selectionMark.BoundingPolygon[j].Y}");

}

}

}

foreach (DocumentStyle style in result.Styles)

{

// Check the style and style confidence to see if text is handwritten.

// Note that value '0.8' is used as an example.

bool isHandwritten = style.IsHandwritten.HasValue && style.IsHandwritten == true;

if (isHandwritten && style.Confidence > 0.8)

{

Console.WriteLine($"Handwritten content found:");

foreach (DocumentSpan span in style.Spans)

{

Console.WriteLine($" Content: {result.Content.Substring(span.Index, span.Length)}");

}

}

}

Console.WriteLine("The following tables were extracted:");

for (int i = 0; i < result.Tables.Count; i++)

{

DocumentTable table = result.Tables[i];

Console.WriteLine($" Table {i} has {table.RowCount} rows and {table.ColumnCount} columns.");

foreach (DocumentTableCell cell in table.Cells)

{

Console.WriteLine($" Cell ({cell.RowIndex}, {cell.ColumnIndex}) has kind '{cell.Kind}' and content: '{cell.Content}'.");

}

}

一般的なドキュメント モデルの出力を表示するには、GitHub 上の Azure サンプル リポジトリにアクセスします。

W-2 税モデルを使用する

using Azure;

using Azure.AI.FormRecognizer.DocumentAnalysis;

//use your `key` and `endpoint` environment variables to create your `AzureKeyCredential` and `DocumentAnalysisClient` instances

string key = Environment.GetEnvironmentVariable("DI_KEY");

string endpoint = Environment.GetEnvironmentVariable("DI_ENDPOINT");

AzureKeyCredential credential = new AzureKeyCredential(key);

DocumentAnalysisClient client = new DocumentAnalysisClient(new Uri(endpoint), credential);

// sample document document

Uri w2Uri = new Uri("https://raw.githubusercontent.com/Azure-Samples/cognitive-services-REST-api-samples/master/curl/form-recognizer/rest-api/w2.png");

AnalyzeDocumentOperation operation = await client.AnalyzeDocumentFromUriAsync(WaitUntil.Completed, "prebuilt-tax.us.w2", w2Uri);

AnalyzeResult result = operation.Value;

for (int i = 0; i < result.Documents.Count; i++)

{

Console.WriteLine($"Document {i}:");

AnalyzedDocument document = result.Documents[i];

if (document.Fields.TryGetValue("AdditionalInfo", out DocumentField? additionalInfoField))

{

if (additionalInfoField.FieldType == DocumentFieldType.List)

{

foreach (DocumentField infoField in additionalInfoField.Value.AsList())

{

Console.WriteLine("AdditionalInfo:");

if (infoField.FieldType == DocumentFieldType.Dictionary)

{

IReadOnlyDictionary<string, DocumentField> infoFields = infoField.Value.AsDictionary();

if (infoFields.TryGetValue("Amount", out DocumentField? amountField))

{

if (amountField.FieldType == DocumentFieldType.Double)

{

double amount = amountField.Value.AsDouble();

Console.WriteLine($" Amount: '{amount}', with confidence {amountField.Confidence}");

}

}

if (infoFields.TryGetValue("LetterCode", out DocumentField? letterCodeField))

{

if (letterCodeField.FieldType == DocumentFieldType.String)

{

string letterCode = letterCodeField.Value.AsString();

Console.WriteLine($" LetterCode: '{letterCode}', with confidence {letterCodeField.Confidence}");

}

}

}

}

}

}

if (document.Fields.TryGetValue("AllocatedTips", out DocumentField? allocatedTipsField))

{

if (allocatedTipsField.FieldType == DocumentFieldType.Double)

{

double allocatedTips = allocatedTipsField.Value.AsDouble();

Console.WriteLine($"Allocated Tips: '{allocatedTips}', with confidence {allocatedTipsField.Confidence}");

}

}

if (document.Fields.TryGetValue("Employer", out DocumentField? employerField))

{

if (employerField.FieldType == DocumentFieldType.Dictionary)

{

IReadOnlyDictionary<string, DocumentField> employerFields = employerField.Value.AsDictionary();

if (employerFields.TryGetValue("Name", out DocumentField? employerNameField))

{

if (employerNameField.FieldType == DocumentFieldType.String)

{

string name = employerNameField.Value.AsString();

Console.WriteLine($"Employer Name: '{name}', with confidence {employerNameField.Confidence}");

}

}

if (employerFields.TryGetValue("IdNumber", out DocumentField? idNumberField))

{

if (idNumberField.FieldType == DocumentFieldType.String)

{

string id = idNumberField.Value.AsString();

Console.WriteLine($"Employer ID Number: '{id}', with confidence {idNumberField.Confidence}");

}

}

if (employerFields.TryGetValue("Address", out DocumentField? addressField))

{

if (addressField.FieldType == DocumentFieldType.Address)

{

Console.WriteLine($"Employer Address: '{addressField.Content}', with confidence {addressField.Confidence}");

}

}

}

}

}

W-2 税モデルの出力を表示するには、GitHub 上の Azure サンプル リポジトリにアクセスします。

請求書モデルを使用する

using Azure;

using Azure.AI.FormRecognizer.DocumentAnalysis;

//use your `key` and `endpoint` environment variables to create your `AzureKeyCredential` and `DocumentAnalysisClient` instances

string key = Environment.GetEnvironmentVariable("DI_KEY");

string endpoint = Environment.GetEnvironmentVariable("DI_ENDPOINT");

AzureKeyCredential credential = new AzureKeyCredential(key);

DocumentAnalysisClient client = new DocumentAnalysisClient(new Uri(endpoint), credential);

// sample document document

Uri invoiceUri = new Uri("https://github.com/Azure-Samples/cognitive-services-REST-api-samples/raw/master/curl/form-recognizer/rest-api/invoice.pdf");

AnalyzeDocumentOperation operation = await client.AnalyzeDocumentFromUriAsync(WaitUntil.Completed, "prebuilt-invoice", invoiceUri);

AnalyzeResult result = operation.Value;

for (int i = 0; i < result.Documents.Count; i++)

{

Console.WriteLine($"Document {i}:");

AnalyzedDocument document = result.Documents[i];

if (document.Fields.TryGetValue("VendorName", out DocumentField vendorNameField))

{

if (vendorNameField.FieldType == DocumentFieldType.String)

{

string vendorName = vendorNameField.Value.AsString();

Console.WriteLine($"Vendor Name: '{vendorName}', with confidence {vendorNameField.Confidence}");

}

}

if (document.Fields.TryGetValue("CustomerName", out DocumentField customerNameField))

{

if (customerNameField.FieldType == DocumentFieldType.String)

{

string customerName = customerNameField.Value.AsString();

Console.WriteLine($"Customer Name: '{customerName}', with confidence {customerNameField.Confidence}");

}

}

if (document.Fields.TryGetValue("Items", out DocumentField itemsField))

{

if (itemsField.FieldType == DocumentFieldType.List)

{

foreach (DocumentField itemField in itemsField.Value.AsList())

{

Console.WriteLine("Item:");

if (itemField.FieldType == DocumentFieldType.Dictionary)

{

IReadOnlyDictionary<string, DocumentField> itemFields = itemField.Value.AsDictionary();

if (itemFields.TryGetValue("Description", out DocumentField itemDescriptionField))

{

if (itemDescriptionField.FieldType == DocumentFieldType.String)

{

string itemDescription = itemDescriptionField.Value.AsString();

Console.WriteLine($" Description: '{itemDescription}', with confidence {itemDescriptionField.Confidence}");

}

}

if (itemFields.TryGetValue("Amount", out DocumentField itemAmountField))

{

if (itemAmountField.FieldType == DocumentFieldType.Currency)

{

CurrencyValue itemAmount = itemAmountField.Value.AsCurrency();

Console.WriteLine($" Amount: '{itemAmount.Symbol}{itemAmount.Amount}', with confidence {itemAmountField.Confidence}");

}

}

}

}

}

}

if (document.Fields.TryGetValue("SubTotal", out DocumentField subTotalField))

{

if (subTotalField.FieldType == DocumentFieldType.Currency)

{

CurrencyValue subTotal = subTotalField.Value.AsCurrency();

Console.WriteLine($"Sub Total: '{subTotal.Symbol}{subTotal.Amount}', with confidence {subTotalField.Confidence}");

}

}

if (document.Fields.TryGetValue("TotalTax", out DocumentField totalTaxField))

{

if (totalTaxField.FieldType == DocumentFieldType.Currency)

{

CurrencyValue totalTax = totalTaxField.Value.AsCurrency();

Console.WriteLine($"Total Tax: '{totalTax.Symbol}{totalTax.Amount}', with confidence {totalTaxField.Confidence}");

}

}

if (document.Fields.TryGetValue("InvoiceTotal", out DocumentField invoiceTotalField))

{

if (invoiceTotalField.FieldType == DocumentFieldType.Currency)

{

CurrencyValue invoiceTotal = invoiceTotalField.Value.AsCurrency();

Console.WriteLine($"Invoice Total: '{invoiceTotal.Symbol}{invoiceTotal.Amount}', with confidence {invoiceTotalField.Confidence}");

}

}

}

請求書モデルの出力を表示するには、GitHub 上の Azure サンプル リポジトリにアクセスします。

レシート モデルを使用する

using Azure;

using Azure.AI.FormRecognizer.DocumentAnalysis;

//use your `key` and `endpoint` environment variables to create your `AzureKeyCredential` and `DocumentAnalysisClient` instances

string key = Environment.GetEnvironmentVariable("DI_KEY");

string endpoint = Environment.GetEnvironmentVariable("DI_ENDPOINT");

AzureKeyCredential credential = new AzureKeyCredential(key);

DocumentAnalysisClient client = new DocumentAnalysisClient(new Uri(endpoint), credential);

// sample document document

Uri receiptUri = new Uri("https://raw.githubusercontent.com/Azure-Samples/cognitive-services-REST-api-samples/master/curl/form-recognizer/rest-api/receipt.png");

AnalyzeDocumentOperation operation = await client.AnalyzeDocumentFromUriAsync(WaitUntil.Completed, "prebuilt-receipt", receiptUri);

AnalyzeResult receipts = operation.Value;

foreach (AnalyzedDocument receipt in receipts.Documents)

{

if (receipt.Fields.TryGetValue("MerchantName", out DocumentField merchantNameField))

{

if (merchantNameField.FieldType == DocumentFieldType.String)

{

string merchantName = merchantNameField.Value.AsString();

Console.WriteLine($"Merchant Name: '{merchantName}', with confidence {merchantNameField.Confidence}");

}

}

if (receipt.Fields.TryGetValue("TransactionDate", out DocumentField transactionDateField))

{

if (transactionDateField.FieldType == DocumentFieldType.Date)

{

DateTimeOffset transactionDate = transactionDateField.Value.AsDate();

Console.WriteLine($"Transaction Date: '{transactionDate}', with confidence {transactionDateField.Confidence}");

}

}

if (receipt.Fields.TryGetValue("Items", out DocumentField itemsField))

{

if (itemsField.FieldType == DocumentFieldType.List)

{

foreach (DocumentField itemField in itemsField.Value.AsList())

{

Console.WriteLine("Item:");

if (itemField.FieldType == DocumentFieldType.Dictionary)

{

IReadOnlyDictionary<string, DocumentField> itemFields = itemField.Value.AsDictionary();

if (itemFields.TryGetValue("Description", out DocumentField itemDescriptionField))

{

if (itemDescriptionField.FieldType == DocumentFieldType.String)

{

string itemDescription = itemDescriptionField.Value.AsString();

Console.WriteLine($" Description: '{itemDescription}', with confidence {itemDescriptionField.Confidence}");

}

}

if (itemFields.TryGetValue("TotalPrice", out DocumentField itemTotalPriceField))

{

if (itemTotalPriceField.FieldType == DocumentFieldType.Double)

{

double itemTotalPrice = itemTotalPriceField.Value.AsDouble();

Console.WriteLine($" Total Price: '{itemTotalPrice}', with confidence {itemTotalPriceField.Confidence}");

}

}

}

}

}

}

if (receipt.Fields.TryGetValue("Total", out DocumentField totalField))

{

if (totalField.FieldType == DocumentFieldType.Double)

{

double total = totalField.Value.AsDouble();

Console.WriteLine($"Total: '{total}', with confidence '{totalField.Confidence}'");

}

}

}

領収書モデルの出力を表示するには、GitHub 上の Azure サンプル リポジトリにアクセスします。

身分証明書モデル

using Azure;

using Azure.AI.FormRecognizer.DocumentAnalysis;

//use your `key` and `endpoint` environment variables to create your `AzureKeyCredential` and `DocumentAnalysisClient` instances

string key = Environment.GetEnvironmentVariable("DI_KEY");

string endpoint = Environment.GetEnvironmentVariable("DI_ENDPOINT");

AzureKeyCredential credential = new AzureKeyCredential(key);

DocumentAnalysisClient client = new DocumentAnalysisClient(new Uri(endpoint), credential);

// sample document document

Uri idDocumentUri = new Uri("https://raw.githubusercontent.com/Azure-Samples/cognitive-services-REST-api-samples/master/curl/form-recognizer/rest-api/identity_documents.png");

AnalyzeDocumentOperation operation = await client.AnalyzeDocumentFromUriAsync(WaitUntil.Completed, "prebuilt-idDocument", idDocumentUri);

AnalyzeResult identityDocuments = operation.Value;

AnalyzedDocument identityDocument = identityDocuments.Documents.Single();

if (identityDocument.Fields.TryGetValue("Address", out DocumentField addressField))

{

if (addressField.FieldType == DocumentFieldType.String)

{

string address = addressField.Value. AsString();

Console.WriteLine($"Address: '{address}', with confidence {addressField.Confidence}");

}

}

if (identityDocument.Fields.TryGetValue("CountryRegion", out DocumentField countryRegionField))

{

if (countryRegionField.FieldType == DocumentFieldType.CountryRegion)

{

string countryRegion = countryRegionField.Value.AsCountryRegion();

Console.WriteLine($"CountryRegion: '{countryRegion}', with confidence {countryRegionField.Confidence}");

}

}

if (identityDocument.Fields.TryGetValue("DateOfBirth", out DocumentField dateOfBirthField))

{

if (dateOfBirthField.FieldType == DocumentFieldType.Date)

{

DateTimeOffset dateOfBirth = dateOfBirthField.Value.AsDate();

Console.WriteLine($"Date Of Birth: '{dateOfBirth}', with confidence {dateOfBirthField.Confidence}");

}

}

if (identityDocument.Fields.TryGetValue("DateOfExpiration", out DocumentField dateOfExpirationField))

{

if (dateOfExpirationField.FieldType == DocumentFieldType.Date)

{

DateTimeOffset dateOfExpiration = dateOfExpirationField.Value.AsDate();

Console.WriteLine($"Date Of Expiration: '{dateOfExpiration}', with confidence {dateOfExpirationField.Confidence}");

}

}

if (identityDocument.Fields.TryGetValue("DocumentNumber", out DocumentField documentNumberField))

{

if (documentNumberField.FieldType == DocumentFieldType.String)

{

string documentNumber = documentNumberField.Value.AsString();

Console.WriteLine($"Document Number: '{documentNumber}', with confidence {documentNumberField.Confidence}");

}

}

if (identityDocument.Fields.TryGetValue("FirstName", out DocumentField firstNameField))

{

if (firstNameField.FieldType == DocumentFieldType.String)

{

string firstName = firstNameField.Value.AsString();

Console.WriteLine($"First Name: '{firstName}', with confidence {firstNameField.Confidence}");

}

}

if (identityDocument.Fields.TryGetValue("LastName", out DocumentField lastNameField))

{

if (lastNameField.FieldType == DocumentFieldType.String)

{

string lastName = lastNameField.Value.AsString();

Console.WriteLine($"Last Name: '{lastName}', with confidence {lastNameField.Confidence}");

}

}

if (identityDocument.Fields.TryGetValue("Region", out DocumentField regionfield))

{

if (regionfield.FieldType == DocumentFieldType.String)

{

string region = regionfield.Value.AsString();

Console.WriteLine($"Region: '{region}', with confidence {regionfield.Confidence}");

}

}

if (identityDocument.Fields.TryGetValue("Sex", out DocumentField sexfield))

{

if (sexfield.FieldType == DocumentFieldType.String)

{

string sex = sexfield.Value.AsString();

Console.WriteLine($"Sex: '{sex}', with confidence {sexfield.Confidence}");

}

}

ID ドキュメント モデルの出力を表示するには、GitHub 上の Azure サンプル リポジトリにアクセスします。

名刺モデルを使用する

using Azure;

using Azure.AI.FormRecognizer.DocumentAnalysis;

//use your `key` and `endpoint` environment variables to create your `AzureKeyCredential` and `DocumentAnalysisClient` instances

string key = Environment.GetEnvironmentVariable("DI_KEY");

string endpoint = Environment.GetEnvironmentVariable("DI_ENDPOINT");

AzureKeyCredential credential = new AzureKeyCredential(key);

DocumentAnalysisClient client = new DocumentAnalysisClient(new Uri(endpoint), credential);

// sample document document

Uri businessCardUri = new Uri("https://raw.githubusercontent.com/Azure-Samples/cognitive-services-REST-api-samples/master/curl/form-recognizer/business-card-english.jpg");

AnalyzeDocumentOperation operation = await client.AnalyzeDocumentFromUriAsync(WaitUntil.Completed, "prebuilt-businessCard", businessCardUri);

AnalyzeResult businessCards = operation.Value;

foreach (AnalyzedDocument businessCard in businessCards.Documents)

{

if (businessCard.Fields.TryGetValue("ContactNames", out DocumentField ContactNamesField))

{

if (ContactNamesField.FieldType == DocumentFieldType.List)

{

foreach (DocumentField contactNameField in ContactNamesField.Value.AsList())

{

Console.WriteLine("Contact Name: ");

if (contactNameField.FieldType == DocumentFieldType.Dictionary)

{

IReadOnlyDictionary<string, DocumentField> contactNameFields = contactNameField.Value.AsDictionary();

if (contactNameFields.TryGetValue("FirstName", out DocumentField firstNameField))

{

if (firstNameField.FieldType == DocumentFieldType.String)

{

string firstName = firstNameField.Value.AsString();

Console.WriteLine($" First Name: '{firstName}', with confidence {firstNameField.Confidence}");

}

}

if (contactNameFields.TryGetValue("LastName", out DocumentField lastNameField))

{

if (lastNameField.FieldType == DocumentFieldType.String)

{

string lastName = lastNameField.Value.AsString();

Console.WriteLine($" Last Name: '{lastName}', with confidence {lastNameField.Confidence}");

}

}

}

}

}

}

if (businessCard.Fields.TryGetValue("JobTitles", out DocumentField jobTitlesFields))

{

if (jobTitlesFields.FieldType == DocumentFieldType.List)

{

foreach (DocumentField jobTitleField in jobTitlesFields.Value.AsList())

{

if (jobTitleField.FieldType == DocumentFieldType.String)

{

string jobTitle = jobTitleField.Value.AsString();

Console.WriteLine($"Job Title: '{jobTitle}', with confidence {jobTitleField.Confidence}");

}

}

}

}

if (businessCard.Fields.TryGetValue("Departments", out DocumentField departmentFields))

{

if (departmentFields.FieldType == DocumentFieldType.List)

{

foreach (DocumentField departmentField in departmentFields.Value.AsList())

{

if (departmentField.FieldType == DocumentFieldType.String)

{

string department = departmentField.Value.AsString();

Console.WriteLine($"Department: '{department}', with confidence {departmentField.Confidence}");

}

}

}

}

if (businessCard.Fields.TryGetValue("Emails", out DocumentField emailFields))

{

if (emailFields.FieldType == DocumentFieldType.List)

{

foreach (DocumentField emailField in emailFields.Value.AsList())

{

if (emailField.FieldType == DocumentFieldType.String)

{

string email = emailField.Value.AsString();

Console.WriteLine($"Email: '{email}', with confidence {emailField.Confidence}");

}

}

}

}

if (businessCard.Fields.TryGetValue("Websites", out DocumentField websiteFields))

{

if (websiteFields.FieldType == DocumentFieldType.List)

{

foreach (DocumentField websiteField in websiteFields.Value.AsList())

{

if (websiteField.FieldType == DocumentFieldType.String)

{

string website = websiteField.Value.AsString();

Console.WriteLine($"Website: '{website}', with confidence {websiteField.Confidence}");

}

}

}

}

if (businessCard.Fields.TryGetValue("MobilePhones", out DocumentField mobilePhonesFields))

{

if (mobilePhonesFields.FieldType == DocumentFieldType.List)

{

foreach (DocumentField mobilePhoneField in mobilePhonesFields.Value.AsList())

{

if (mobilePhoneField.FieldType == DocumentFieldType.PhoneNumber)

{

string mobilePhone = mobilePhoneField.Value.AsPhoneNumber();

Console.WriteLine($"Mobile phone number: '{mobilePhone}', with confidence {mobilePhoneField.Confidence}");

}

}

}

}

if (businessCard.Fields.TryGetValue("WorkPhones", out DocumentField workPhonesFields))

{

if (workPhonesFields.FieldType == DocumentFieldType.List)

{

foreach (DocumentField workPhoneField in workPhonesFields.Value.AsList())

{

if (workPhoneField.FieldType == DocumentFieldType.PhoneNumber)

{

string workPhone = workPhoneField.Value.AsPhoneNumber();

Console.WriteLine($"Work phone number: '{workPhone}', with confidence {workPhoneField.Confidence}");

}

}

}

}

if (businessCard.Fields.TryGetValue("Faxes", out DocumentField faxesFields))

{

if (faxesFields.FieldType == DocumentFieldType.List)

{

foreach (DocumentField faxField in faxesFields.Value.AsList())

{

if (faxField.FieldType == DocumentFieldType.PhoneNumber)

{

string fax = faxField.Value.AsPhoneNumber();

Console.WriteLine($"Fax phone number: '{fax}', with confidence {faxField.Confidence}");

}

}

}

}

if (businessCard.Fields.TryGetValue("Addresses", out DocumentField addressesFields))

{

if (addressesFields.FieldType == DocumentFieldType.List)

{

foreach (DocumentField addressField in addressesFields.Value.AsList())

{

if (addressField.FieldType == DocumentFieldType.String)

{

string address = addressField.Value.AsString();

Console.WriteLine($"Address: '{address}', with confidence {addressField.Confidence}");

}

}

}

}

if (businessCard.Fields.TryGetValue("CompanyNames", out DocumentField companyNamesFields))

{

if (companyNamesFields.FieldType == DocumentFieldType.List)

{

foreach (DocumentField companyNameField in companyNamesFields.Value.AsList())

{

if (companyNameField.FieldType == DocumentFieldType.String)

{

string companyName = companyNameField.Value.AsString();

Console.WriteLine($"Company name: '{companyName}', with confidence {companyNameField.Confidence}");

}

}

}

}

}

名刺モデルの出力を表示するには、GitHub 上の Azure サンプル リポジトリにアクセスします。

前提条件

Azure サブスクリプション。無料で作成できます。

Azure AI サービスまたは Document Intelligence リソース。 単一サービスまたはマルチサービスを作成します。 Free 価格レベル (

`F0` ) を使用してサービスを試用し、後から運用環境用の有料レベルにアップグレードすることができます。アプリケーションを Document Intelligence API に接続するために作成したリソースのキーとエンドポイント。

- リソースがデプロイされたら、 [リソースに移動] を選択します。

- 左側のナビゲーション メニューで、[キーとエンドポイント] を選択します。

- この記事の後半で使用するために、いずれかのキーとエンドポイントをコピーします。

URL で指定された場所にあるドキュメント ファイル。 このプロジェクトでは、各機能について、次の表に示すサンプル フォームを使用できます。

機能 modelID document-url 読み取りモデル prebuilt-read サンプル パンフレット レイアウト モデル 事前構築済みレイアウト 予約確認のサンプル W-2 フォーム モデル prebuilt-tax.us.w2 サンプル W-2 フォーム 請求書モデル prebuilt-invoice サンプル請求書 レシート モデル prebuilt-receipt サンプル レシート 身分証明書モデル prebuilt-idDocument サンプル身分証明書 名刺モデル 事前構築された名刺 サンプル名刺

環境変数を設定する

Document Intelligence サービスとやり取りするには、DocumentAnalysisClient クラスのインスタンスを作成する必要があります。 これを行うには、Azure portal から key と endpoint を使用してクライアントをインスタンス化します。 このプロジェクトでは、資格情報の格納とアクセスに環境変数を使用します。

重要

キーをコードに直接含めたり、公開したりしないでください。 運用環境では、Azure Key Vault など、資格情報を保存してアクセスするための安全な方法を使用してください。 詳しくは、「Azure AI サービスのセキュリティ」をご覧ください。

ドキュメントインテリジェンスリソース キーの環境変数を設定するには、コンソール ウィンドウを開き、オペレーティング システムと開発環境の指示に従います。 <yourKey> と <yourEndpoint> を、Azure portal 内のご自分のリソースの値に置き換えます。

Windows の環境変数では大文字と小文字は区別されません。 通常は大文字で宣言され、単語はアンダースコアで結合されます。 コマンド プロンプトで、次のコマンドを実行します。

キー変数を設定します。

setx DI_KEY <yourKey>エンドポイント変数を設定する

setx DI_ENDPOINT <yourEndpoint>環境変数を設定したら、[コマンド プロンプト] ウィンドウを閉じます。 値は、もう一度変更するまで保持されます。

環境変数を読み取る実行中のプログラムを再起動します。 たとえば、Visual Studio または Visual Studio Code をエディターとして使用している場合、サンプル コードを実行する前に再起動する必要があります。

環境変数で使用するのに役立つコマンドをいくつか次に示します。

| コマンド | アクション | 例 |

|---|---|---|

setx VARIABLE_NAME= |

値を空の文字列に設定して、環境変数を削除します。 | setx DI_KEY= |

setx VARIABLE_NAME=value |

環境変数の値を設定または変更します | setx DI_KEY=<yourKey> |

set VARIABLE_NAME |

特定の環境変数の値を表示します。 | set DI_KEY |

set |

すべての環境変数を表示します。 | set |

プログラミング環境のセットアップ

Visual Studio を起動します。

スタート ページで、[新しいプロジェクトの作成] を選択します。

[新しいプロジェクトの作成] ページで、検索ボックスに「コンソール」と入力します。 [コンソール アプリケーション] テンプレートを選択し、[次へ] を選択します。

![Visual Studio の [新しいプロジェクトの作成] ページのスクリーンショット。](../media/quickstarts/create-new-project.png?view=doc-intel-4.0.0)

[新しいプロジェクトの構成] ページの [プロジェクト名] に「docIntelligence_app」と入力します。 [次へ] を選択します。

![Visual Studio の [新しいプロジェクトの構成] ページのスクリーンショット。](../media/quickstarts/configure-new-project-console.png?view=doc-intel-4.0.0)

[追加情報] ページで、[.NET 8.0 (長期的なサポート)] を選択し、[作成] を選択します。

![Visual Studio の [追加情報] ページのスクリーンショット。](../media/quickstarts/additional-information.png?view=doc-intel-4.0.0)

NuGet を使用してクライアント ライブラリをインストールする

docIntelligence_app プロジェクトを右クリックし、[Manage NuGet Packages...] (NuGet パッケージの管理...) を選択します。

[参照] タブを選択し、「Azure.AI.FormRecognizer」と入力します。

ドロップダウン メニューからバージョンを選択し、プロジェクトにパッケージをインストールします。

アプリケーションをビルドする

注意

.NET 6 以降では、console テンプレートを使用する新しいプロジェクトによって、以前のバージョンとは異なる新しいプログラム スタイルが生成されます。 この新しい出力では、記述する必要があるコードを簡素化できる最新の C# 機能が使用されています。

新しいバージョンで使用する場合、記述する必要があるのは、

Program.cs ファイルを開きます。

行

Console.Writeline("Hello World!")を含む既存のコードを削除します。次のいずれかのコード サンプルを選択してコピーし、アプリケーションの Program.cs ファイルに貼り付けます。

アプリケーションにコード サンプルを追加したら、プロジェクト名の横にある緑色の [開始] ボタンを選択してプログラムをビルドして実行するか、または F5 キーを押します。

読み取りモデルを使用する

using Azure;

using Azure.AI.FormRecognizer.DocumentAnalysis;

//use your `key` and `endpoint` environment variables to create your `AzureKeyCredential` and `DocumentAnalysisClient` instances

string key = Environment.GetEnvironmentVariable("DI_KEY");

string endpoint = Environment.GetEnvironmentVariable("DI_ENDPOINT");

AzureKeyCredential credential = new AzureKeyCredential(key);

DocumentAnalysisClient client = new DocumentAnalysisClient(new Uri(endpoint), credential);

//sample document

Uri fileUri = new Uri("https://raw.githubusercontent.com/Azure-Samples/cognitive-services-REST-api-samples/master/curl/form-recognizer/rest-api/read.png");

AnalyzeDocumentOperation operation = await client.AnalyzeDocumentFromUriAsync(WaitUntil.Completed, "prebuilt-read", fileUri);

AnalyzeResult result = operation.Value;

foreach (DocumentPage page in result.Pages)

{

Console.WriteLine($"Document Page {page.PageNumber} has {page.Lines.Count} line(s), {page.Words.Count} word(s),");

Console.WriteLine($"and {page.SelectionMarks.Count} selection mark(s).");

for (int i = 0; i < page.Lines.Count; i++)

{

DocumentLine line = page.Lines[i];

Console.WriteLine($" Line {i} has content: '{line.Content}'.");

Console.WriteLine($" Its bounding polygon (points ordered clockwise):");

for (int j = 0; j < line.BoundingPolygon.Count; j++)

{

Console.WriteLine($" Point {j} => X: {line.BoundingPolygon[j].X}, Y: {line.BoundingPolygon[j].Y}");

}

}

}

foreach (DocumentStyle style in result.Styles)

{

// Check the style and style confidence to see if text is handwritten.

// Note that value '0.8' is used as an example.

bool isHandwritten = style.IsHandwritten.HasValue && style.IsHandwritten == true;

if (isHandwritten && style.Confidence > 0.8)

{

Console.WriteLine($"Handwritten content found:");

foreach (DocumentSpan span in style.Spans)

{

Console.WriteLine($" Content: {result.Content.Substring(span.Index, span.Length)}");

}

}

}

Console.WriteLine("Detected languages:");

foreach (DocumentLanguage language in result.Languages)

{

Console.WriteLine($" Found language with locale'{language.Locale}' with confidence {language.Confidence}.");

}

read読み取りモデルの出力を表示するには、GitHub 上の Azure サンプル リポジトリにアクセスします。

レイアウト モデルを使用する

using Azure;

using Azure.AI.FormRecognizer.DocumentAnalysis;

//use your `key` and `endpoint` environment variables to create your `AzureKeyCredential` and `DocumentAnalysisClient` instances

string key = Environment.GetEnvironmentVariable("DI_KEY");

string endpoint = Environment.GetEnvironmentVariable("DI_ENDPOINT");

AzureKeyCredential credential = new AzureKeyCredential(key);

DocumentAnalysisClient client = new DocumentAnalysisClient(new Uri(endpoint), credential);

// sample document document

Uri fileUri = new Uri ("https://raw.githubusercontent.com/Azure-Samples/cognitive-services-REST-api-samples/master/curl/form-recognizer/rest-api/layout.png");

AnalyzeDocumentOperation operation = await client.AnalyzeDocumentFromUriAsync(WaitUntil.Completed, "prebuilt-layout", fileUri);

AnalyzeResult result = operation.Value;

foreach (DocumentPage page in result.Pages)

{

Console.WriteLine($"Document Page {page.PageNumber} has {page.Lines.Count} line(s), {page.Words.Count} word(s),");

Console.WriteLine($"and {page.SelectionMarks.Count} selection mark(s).");

for (int i = 0; i < page.Lines.Count; i++)

{

DocumentLine line = page.Lines[i];

Console.WriteLine($" Line {i} has content: '{line.Content}'.");

Console.WriteLine($" Its bounding polygon (points ordered clockwise):");

for (int j = 0; j < line.BoundingPolygon.Count; j++)

{

Console.WriteLine($" Point {j} => X: {line.BoundingPolygon[j].X}, Y: {line.BoundingPolygon[j].Y}");

}

}

for (int i = 0; i < page.SelectionMarks.Count; i++)

{

DocumentSelectionMark selectionMark = page.SelectionMarks[i];

Console.WriteLine($" Selection Mark {i} is {selectionMark.State}.");

Console.WriteLine($" Its bounding polygon (points ordered clockwise):");

for (int j = 0; j < selectionMark.BoundingPolygon.Count; j++)

{

Console.WriteLine($" Point {j} => X: {selectionMark.BoundingPolygon[j].X}, Y: {selectionMark.BoundingPolygon[j].Y}");

}

}

}

Console.WriteLine("Paragraphs:");

foreach (DocumentParagraph paragraph in result.Paragraphs)

{

Console.WriteLine($" Paragraph content: {paragraph.Content}");

if (paragraph.Role != null)

{

Console.WriteLine($" Role: {paragraph.Role}");

}

}

foreach (DocumentStyle style in result.Styles)

{

// Check the style and style confidence to see if text is handwritten.

// Note that value '0.8' is used as an example.

bool isHandwritten = style.IsHandwritten.HasValue && style.IsHandwritten == true;

if (isHandwritten && style.Confidence > 0.8)

{

Console.WriteLine($"Handwritten content found:");

foreach (DocumentSpan span in style.Spans)

{

Console.WriteLine($" Content: {result.Content.Substring(span.Index, span.Length)}");

}

}

}

Console.WriteLine("The following tables were extracted:");

for (int i = 0; i < result.Tables.Count; i++)

{

DocumentTable table = result.Tables[i];

Console.WriteLine($" Table {i} has {table.RowCount} rows and {table.ColumnCount} columns.");

foreach (DocumentTableCell cell in table.Cells)

{

Console.WriteLine($" Cell ({cell.RowIndex}, {cell.ColumnIndex}) has kind '{cell.Kind}' and content: '{cell.Content}'.");

}

}

GitHub の Azure サンプル リポジトリにアクセスし、 レイアウト モデルの出力を表示します。

一般的なドキュメント モデルを使用する

using Azure;

using Azure.AI.FormRecognizer.DocumentAnalysis;

//use your `key` and `endpoint` environment variables to create your `AzureKeyCredential` and `DocumentAnalysisClient` instances

string key = Environment.GetEnvironmentVariable("DI_KEY");

string endpoint = Environment.GetEnvironmentVariable("DI_ENDPOINT");

AzureKeyCredential credential = new AzureKeyCredential(key);

DocumentAnalysisClient client = new DocumentAnalysisClient(new Uri(endpoint), credential);

// sample document document

Uri fileUri = new Uri("https://raw.githubusercontent.com/Azure-Samples/cognitive-services-REST-api-samples/master/curl/form-recognizer/sample-layout.pdf");

AnalyzeDocumentOperation operation = await client.AnalyzeDocumentFromUriAsync(WaitUntil.Completed, "prebuilt-document", fileUri);

AnalyzeResult result = operation.Value;

Console.WriteLine("Detected key-value pairs:");

foreach (DocumentKeyValuePair kvp in result.KeyValuePairs)

{

if (kvp.Value == null)

{

Console.WriteLine($" Found key with no value: '{kvp.Key.Content}'");

}

else

{

Console.WriteLine($" Found key-value pair: '{kvp.Key.Content}' and '{kvp.Value.Content}'");

}

}

foreach (DocumentPage page in result.Pages)

{

Console.WriteLine($"Document Page {page.PageNumber} has {page.Lines.Count} line(s), {page.Words.Count} word(s),");

Console.WriteLine($"and {page.SelectionMarks.Count} selection mark(s).");

for (int i = 0; i < page.Lines.Count; i++)

{

DocumentLine line = page.Lines[i];

Console.WriteLine($" Line {i} has content: '{line.Content}'.");

Console.WriteLine($" Its bounding polygon (points ordered clockwise):");

for (int j = 0; j < line.BoundingPolygon.Count; j++)

{

Console.WriteLine($" Point {j} => X: {line.BoundingPolygon[j].X}, Y: {line.BoundingPolygon[j].Y}");

}

}

for (int i = 0; i < page.SelectionMarks.Count; i++)

{

DocumentSelectionMark selectionMark = page.SelectionMarks[i];

Console.WriteLine($" Selection Mark {i} is {selectionMark.State}.");

Console.WriteLine($" Its bounding polygon (points ordered clockwise):");

for (int j = 0; j < selectionMark.BoundingPolygon.Count; j++)

{

Console.WriteLine($" Point {j} => X: {selectionMark.BoundingPolygon[j].X}, Y: {selectionMark.BoundingPolygon[j].Y}");

}

}

}

foreach (DocumentStyle style in result.Styles)

{

// Check the style and style confidence to see if text is handwritten.

// Note that value '0.8' is used as an example.

bool isHandwritten = style.IsHandwritten.HasValue && style.IsHandwritten == true;

if (isHandwritten && style.Confidence > 0.8)

{

Console.WriteLine($"Handwritten content found:");

foreach (DocumentSpan span in style.Spans)

{

Console.WriteLine($" Content: {result.Content.Substring(span.Index, span.Length)}");

}

}

}

Console.WriteLine("The following tables were extracted:");

for (int i = 0; i < result.Tables.Count; i++)

{

DocumentTable table = result.Tables[i];

Console.WriteLine($" Table {i} has {table.RowCount} rows and {table.ColumnCount} columns.");

foreach (DocumentTableCell cell in table.Cells)

{

Console.WriteLine($" Cell ({cell.RowIndex}, {cell.ColumnIndex}) has kind '{cell.Kind}' and content: '{cell.Content}'.");

}

}

一般的なドキュメント モデルの出力を表示するには、GitHub 上の Azure サンプル リポジトリにアクセスします。

W-2 税モデルを使用する

using Azure;

using Azure.AI.FormRecognizer.DocumentAnalysis;

//use your `key` and `endpoint` environment variables to create your `AzureKeyCredential` and `DocumentAnalysisClient` instances

string key = Environment.GetEnvironmentVariable("DI_KEY");

string endpoint = Environment.GetEnvironmentVariable("DI_ENDPOINT");

AzureKeyCredential credential = new AzureKeyCredential(key);

DocumentAnalysisClient client = new DocumentAnalysisClient(new Uri(endpoint), credential);

// sample document document

Uri w2Uri = new Uri("https://raw.githubusercontent.com/Azure-Samples/cognitive-services-REST-api-samples/master/curl/form-recognizer/rest-api/w2.png");

AnalyzeDocumentOperation operation = await client.AnalyzeDocumentFromUriAsync(WaitUntil.Completed, "prebuilt-tax.us.w2", w2Uri);

AnalyzeResult result = operation.Value;

for (int i = 0; i < result.Documents.Count; i++)

{

Console.WriteLine($"Document {i}:");

AnalyzedDocument document = result.Documents[i];

if (document.Fields.TryGetValue("AdditionalInfo", out DocumentField? additionalInfoField))

{

if (additionalInfoField.FieldType == DocumentFieldType.List)

{

foreach (DocumentField infoField in additionalInfoField.Value.AsList())

{

Console.WriteLine("AdditionalInfo:");

if (infoField.FieldType == DocumentFieldType.Dictionary)

{

IReadOnlyDictionary<string, DocumentField> infoFields = infoField.Value.AsDictionary();

if (infoFields.TryGetValue("Amount", out DocumentField? amountField))

{

if (amountField.FieldType == DocumentFieldType.Double)

{

double amount = amountField.Value.AsDouble();

Console.WriteLine($" Amount: '{amount}', with confidence {amountField.Confidence}");

}

}

if (infoFields.TryGetValue("LetterCode", out DocumentField? letterCodeField))

{

if (letterCodeField.FieldType == DocumentFieldType.String)

{

string letterCode = letterCodeField.Value.AsString();

Console.WriteLine($" LetterCode: '{letterCode}', with confidence {letterCodeField.Confidence}");

}

}

}

}

}

}

if (document.Fields.TryGetValue("AllocatedTips", out DocumentField? allocatedTipsField))

{

if (allocatedTipsField.FieldType == DocumentFieldType.Double)

{

double allocatedTips = allocatedTipsField.Value.AsDouble();

Console.WriteLine($"Allocated Tips: '{allocatedTips}', with confidence {allocatedTipsField.Confidence}");

}

}

if (document.Fields.TryGetValue("Employer", out DocumentField? employerField))

{

if (employerField.FieldType == DocumentFieldType.Dictionary)

{

IReadOnlyDictionary<string, DocumentField> employerFields = employerField.Value.AsDictionary();

if (employerFields.TryGetValue("Name", out DocumentField? employerNameField))

{

if (employerNameField.FieldType == DocumentFieldType.String)

{

string name = employerNameField.Value.AsString();

Console.WriteLine($"Employer Name: '{name}', with confidence {employerNameField.Confidence}");

}

}

if (employerFields.TryGetValue("IdNumber", out DocumentField? idNumberField))

{

if (idNumberField.FieldType == DocumentFieldType.String)

{

string id = idNumberField.Value.AsString();

Console.WriteLine($"Employer ID Number: '{id}', with confidence {idNumberField.Confidence}");

}

}

if (employerFields.TryGetValue("Address", out DocumentField? addressField))

{

if (addressField.FieldType == DocumentFieldType.Address)

{

Console.WriteLine($"Employer Address: '{addressField.Content}', with confidence {addressField.Confidence}");

}

}

}

}

}

W-2 税モデルの出力を表示するには、GitHub 上の Azure サンプル リポジトリにアクセスします。

請求書モデルを使用する

using Azure;

using Azure.AI.FormRecognizer.DocumentAnalysis;

//use your `key` and `endpoint` environment variables to create your `AzureKeyCredential` and `DocumentAnalysisClient` instances

string key = Environment.GetEnvironmentVariable("DI_KEY");

string endpoint = Environment.GetEnvironmentVariable("DI_ENDPOINT");

AzureKeyCredential credential = new AzureKeyCredential(key);

DocumentAnalysisClient client = new DocumentAnalysisClient(new Uri(endpoint), credential);

// sample document document

Uri invoiceUri = new Uri("https://github.com/Azure-Samples/cognitive-services-REST-api-samples/raw/master/curl/form-recognizer/rest-api/invoice.pdf");

AnalyzeDocumentOperation operation = await client.AnalyzeDocumentFromUriAsync(WaitUntil.Completed, "prebuilt-invoice", invoiceUri);

AnalyzeResult result = operation.Value;

for (int i = 0; i < result.Documents.Count; i++)

{

Console.WriteLine($"Document {i}:");

AnalyzedDocument document = result.Documents[i];

if (document.Fields.TryGetValue("VendorName", out DocumentField vendorNameField))

{

if (vendorNameField.FieldType == DocumentFieldType.String)

{

string vendorName = vendorNameField.Value.AsString();

Console.WriteLine($"Vendor Name: '{vendorName}', with confidence {vendorNameField.Confidence}");

}

}

if (document.Fields.TryGetValue("CustomerName", out DocumentField customerNameField))

{

if (customerNameField.FieldType == DocumentFieldType.String)

{

string customerName = customerNameField.Value.AsString();

Console.WriteLine($"Customer Name: '{customerName}', with confidence {customerNameField.Confidence}");

}

}

if (document.Fields.TryGetValue("Items", out DocumentField itemsField))

{

if (itemsField.FieldType == DocumentFieldType.List)

{

foreach (DocumentField itemField in itemsField.Value.AsList())

{

Console.WriteLine("Item:");

if (itemField.FieldType == DocumentFieldType.Dictionary)

{

IReadOnlyDictionary<string, DocumentField> itemFields = itemField.Value.AsDictionary();

if (itemFields.TryGetValue("Description", out DocumentField itemDescriptionField))

{

if (itemDescriptionField.FieldType == DocumentFieldType.String)

{

string itemDescription = itemDescriptionField.Value.AsString();

Console.WriteLine($" Description: '{itemDescription}', with confidence {itemDescriptionField.Confidence}");

}

}

if (itemFields.TryGetValue("Amount", out DocumentField itemAmountField))

{

if (itemAmountField.FieldType == DocumentFieldType.Currency)

{

CurrencyValue itemAmount = itemAmountField.Value.AsCurrency();

Console.WriteLine($" Amount: '{itemAmount.Symbol}{itemAmount.Amount}', with confidence {itemAmountField.Confidence}");

}

}

}

}

}

}

if (document.Fields.TryGetValue("SubTotal", out DocumentField subTotalField))

{

if (subTotalField.FieldType == DocumentFieldType.Currency)

{

CurrencyValue subTotal = subTotalField.Value.AsCurrency();

Console.WriteLine($"Sub Total: '{subTotal.Symbol}{subTotal.Amount}', with confidence {subTotalField.Confidence}");

}

}

if (document.Fields.TryGetValue("TotalTax", out DocumentField totalTaxField))

{

if (totalTaxField.FieldType == DocumentFieldType.Currency)

{

CurrencyValue totalTax = totalTaxField.Value.AsCurrency();

Console.WriteLine($"Total Tax: '{totalTax.Symbol}{totalTax.Amount}', with confidence {totalTaxField.Confidence}");

}

}

if (document.Fields.TryGetValue("InvoiceTotal", out DocumentField invoiceTotalField))

{

if (invoiceTotalField.FieldType == DocumentFieldType.Currency)

{

CurrencyValue invoiceTotal = invoiceTotalField.Value.AsCurrency();

Console.WriteLine($"Invoice Total: '{invoiceTotal.Symbol}{invoiceTotal.Amount}', with confidence {invoiceTotalField.Confidence}");

}

}

}

請求書モデルの出力を表示するには、GitHub 上の Azure サンプル リポジトリにアクセスします。

レシート モデルを使用する

using Azure;

using Azure.AI.FormRecognizer.DocumentAnalysis;

//use your `key` and `endpoint` environment variables to create your `AzureKeyCredential` and `DocumentAnalysisClient` instances

string key = Environment.GetEnvironmentVariable("DI_KEY");

string endpoint = Environment.GetEnvironmentVariable("DI_ENDPOINT");

AzureKeyCredential credential = new AzureKeyCredential(key);

DocumentAnalysisClient client = new DocumentAnalysisClient(new Uri(endpoint), credential);

// sample document document

Uri receiptUri = new Uri("https://raw.githubusercontent.com/Azure-Samples/cognitive-services-REST-api-samples/master/curl/form-recognizer/rest-api/receipt.png");

AnalyzeDocumentOperation operation = await client.AnalyzeDocumentFromUriAsync(WaitUntil.Completed, "prebuilt-receipt", receiptUri);

AnalyzeResult receipts = operation.Value;

foreach (AnalyzedDocument receipt in receipts.Documents)

{

if (receipt.Fields.TryGetValue("MerchantName", out DocumentField merchantNameField))

{

if (merchantNameField.FieldType == DocumentFieldType.String)

{

string merchantName = merchantNameField.Value.AsString();

Console.WriteLine($"Merchant Name: '{merchantName}', with confidence {merchantNameField.Confidence}");

}

}

if (receipt.Fields.TryGetValue("TransactionDate", out DocumentField transactionDateField))

{

if (transactionDateField.FieldType == DocumentFieldType.Date)

{

DateTimeOffset transactionDate = transactionDateField.Value.AsDate();

Console.WriteLine($"Transaction Date: '{transactionDate}', with confidence {transactionDateField.Confidence}");

}

}

if (receipt.Fields.TryGetValue("Items", out DocumentField itemsField))

{

if (itemsField.FieldType == DocumentFieldType.List)

{

foreach (DocumentField itemField in itemsField.Value.AsList())

{

Console.WriteLine("Item:");

if (itemField.FieldType == DocumentFieldType.Dictionary)

{

IReadOnlyDictionary<string, DocumentField> itemFields = itemField.Value.AsDictionary();

if (itemFields.TryGetValue("Description", out DocumentField itemDescriptionField))

{

if (itemDescriptionField.FieldType == DocumentFieldType.String)

{

string itemDescription = itemDescriptionField.Value.AsString();

Console.WriteLine($" Description: '{itemDescription}', with confidence {itemDescriptionField.Confidence}");

}

}

if (itemFields.TryGetValue("TotalPrice", out DocumentField itemTotalPriceField))

{

if (itemTotalPriceField.FieldType == DocumentFieldType.Double)

{

double itemTotalPrice = itemTotalPriceField.Value.AsDouble();

Console.WriteLine($" Total Price: '{itemTotalPrice}', with confidence {itemTotalPriceField.Confidence}");

}

}

}

}

}

}

if (receipt.Fields.TryGetValue("Total", out DocumentField totalField))

{

if (totalField.FieldType == DocumentFieldType.Double)

{

double total = totalField.Value.AsDouble();

Console.WriteLine($"Total: '{total}', with confidence '{totalField.Confidence}'");

}

}

}

領収書モデルの出力を表示するには、GitHub 上の Azure サンプル リポジトリにアクセスします。

身分証明書モデル

using Azure;

using Azure.AI.FormRecognizer.DocumentAnalysis;

//use your `key` and `endpoint` environment variables to create your `AzureKeyCredential` and `DocumentAnalysisClient` instances

string key = Environment.GetEnvironmentVariable("DI_KEY");

string endpoint = Environment.GetEnvironmentVariable("DI_ENDPOINT");

AzureKeyCredential credential = new AzureKeyCredential(key);

DocumentAnalysisClient client = new DocumentAnalysisClient(new Uri(endpoint), credential);

// sample document document

Uri idDocumentUri = new Uri("https://raw.githubusercontent.com/Azure-Samples/cognitive-services-REST-api-samples/master/curl/form-recognizer/rest-api/identity_documents.png");

AnalyzeDocumentOperation operation = await client.AnalyzeDocumentFromUriAsync(WaitUntil.Completed, "prebuilt-idDocument", idDocumentUri);

AnalyzeResult identityDocuments = operation.Value;

AnalyzedDocument identityDocument = identityDocuments.Documents.Single();

if (identityDocument.Fields.TryGetValue("Address", out DocumentField addressField))

{

if (addressField.FieldType == DocumentFieldType.String)

{

string address = addressField.Value. AsString();

Console.WriteLine($"Address: '{address}', with confidence {addressField.Confidence}");

}

}

if (identityDocument.Fields.TryGetValue("CountryRegion", out DocumentField countryRegionField))

{

if (countryRegionField.FieldType == DocumentFieldType.CountryRegion)

{

string countryRegion = countryRegionField.Value.AsCountryRegion();

Console.WriteLine($"CountryRegion: '{countryRegion}', with confidence {countryRegionField.Confidence}");

}

}

if (identityDocument.Fields.TryGetValue("DateOfBirth", out DocumentField dateOfBirthField))

{

if (dateOfBirthField.FieldType == DocumentFieldType.Date)

{

DateTimeOffset dateOfBirth = dateOfBirthField.Value.AsDate();

Console.WriteLine($"Date Of Birth: '{dateOfBirth}', with confidence {dateOfBirthField.Confidence}");

}

}

if (identityDocument.Fields.TryGetValue("DateOfExpiration", out DocumentField dateOfExpirationField))

{

if (dateOfExpirationField.FieldType == DocumentFieldType.Date)

{

DateTimeOffset dateOfExpiration = dateOfExpirationField.Value.AsDate();

Console.WriteLine($"Date Of Expiration: '{dateOfExpiration}', with confidence {dateOfExpirationField.Confidence}");

}

}

if (identityDocument.Fields.TryGetValue("DocumentNumber", out DocumentField documentNumberField))

{

if (documentNumberField.FieldType == DocumentFieldType.String)

{

string documentNumber = documentNumberField.Value.AsString();

Console.WriteLine($"Document Number: '{documentNumber}', with confidence {documentNumberField.Confidence}");

}

}

if (identityDocument.Fields.TryGetValue("FirstName", out DocumentField firstNameField))

{

if (firstNameField.FieldType == DocumentFieldType.String)

{

string firstName = firstNameField.Value.AsString();

Console.WriteLine($"First Name: '{firstName}', with confidence {firstNameField.Confidence}");

}

}

if (identityDocument.Fields.TryGetValue("LastName", out DocumentField lastNameField))

{

if (lastNameField.FieldType == DocumentFieldType.String)

{

string lastName = lastNameField.Value.AsString();

Console.WriteLine($"Last Name: '{lastName}', with confidence {lastNameField.Confidence}");

}

}

if (identityDocument.Fields.TryGetValue("Region", out DocumentField regionfield))

{

if (regionfield.FieldType == DocumentFieldType.String)

{

string region = regionfield.Value.AsString();

Console.WriteLine($"Region: '{region}', with confidence {regionfield.Confidence}");

}

}

if (identityDocument.Fields.TryGetValue("Sex", out DocumentField sexfield))

{

if (sexfield.FieldType == DocumentFieldType.String)

{

string sex = sexfield.Value.AsString();

Console.WriteLine($"Sex: '{sex}', with confidence {sexfield.Confidence}");

}

}

ID ドキュメント モデルの出力を表示するには、GitHub 上の Azure サンプル リポジトリにアクセスします。

名刺モデルを使用する

using Azure;

using Azure.AI.FormRecognizer.DocumentAnalysis;

//use your `key` and `endpoint` environment variables to create your `AzureKeyCredential` and `DocumentAnalysisClient` instances

string key = Environment.GetEnvironmentVariable("DI_KEY");

string endpoint = Environment.GetEnvironmentVariable("DI_ENDPOINT");

AzureKeyCredential credential = new AzureKeyCredential(key);

DocumentAnalysisClient client = new DocumentAnalysisClient(new Uri(endpoint), credential);

// sample document document

Uri businessCardUri = new Uri("https://raw.githubusercontent.com/Azure-Samples/cognitive-services-REST-api-samples/master/curl/form-recognizer/business-card-english.jpg");

AnalyzeDocumentOperation operation = await client.AnalyzeDocumentFromUriAsync(WaitUntil.Completed, "prebuilt-businessCard", businessCardUri);

AnalyzeResult businessCards = operation.Value;

foreach (AnalyzedDocument businessCard in businessCards.Documents)

{

if (businessCard.Fields.TryGetValue("ContactNames", out DocumentField ContactNamesField))

{

if (ContactNamesField.FieldType == DocumentFieldType.List)

{

foreach (DocumentField contactNameField in ContactNamesField.Value.AsList())

{

Console.WriteLine("Contact Name: ");

if (contactNameField.FieldType == DocumentFieldType.Dictionary)

{

IReadOnlyDictionary<string, DocumentField> contactNameFields = contactNameField.Value.AsDictionary();

if (contactNameFields.TryGetValue("FirstName", out DocumentField firstNameField))

{

if (firstNameField.FieldType == DocumentFieldType.String)

{

string firstName = firstNameField.Value.AsString();

Console.WriteLine($" First Name: '{firstName}', with confidence {firstNameField.Confidence}");

}

}

if (contactNameFields.TryGetValue("LastName", out DocumentField lastNameField))

{

if (lastNameField.FieldType == DocumentFieldType.String)

{

string lastName = lastNameField.Value.AsString();

Console.WriteLine($" Last Name: '{lastName}', with confidence {lastNameField.Confidence}");

}

}

}

}

}

}

if (businessCard.Fields.TryGetValue("JobTitles", out DocumentField jobTitlesFields))

{

if (jobTitlesFields.FieldType == DocumentFieldType.List)

{

foreach (DocumentField jobTitleField in jobTitlesFields.Value.AsList())

{

if (jobTitleField.FieldType == DocumentFieldType.String)

{

string jobTitle = jobTitleField.Value.AsString();

Console.WriteLine($"Job Title: '{jobTitle}', with confidence {jobTitleField.Confidence}");

}

}

}

}

if (businessCard.Fields.TryGetValue("Departments", out DocumentField departmentFields))

{

if (departmentFields.FieldType == DocumentFieldType.List)

{

foreach (DocumentField departmentField in departmentFields.Value.AsList())

{

if (departmentField.FieldType == DocumentFieldType.String)

{

string department = departmentField.Value.AsString();

Console.WriteLine($"Department: '{department}', with confidence {departmentField.Confidence}");

}

}

}

}

if (businessCard.Fields.TryGetValue("Emails", out DocumentField emailFields))

{

if (emailFields.FieldType == DocumentFieldType.List)

{

foreach (DocumentField emailField in emailFields.Value.AsList())

{

if (emailField.FieldType == DocumentFieldType.String)

{

string email = emailField.Value.AsString();

Console.WriteLine($"Email: '{email}', with confidence {emailField.Confidence}");

}

}

}

}

if (businessCard.Fields.TryGetValue("Websites", out DocumentField websiteFields))

{

if (websiteFields.FieldType == DocumentFieldType.List)

{

foreach (DocumentField websiteField in websiteFields.Value.AsList())

{

if (websiteField.FieldType == DocumentFieldType.String)

{

string website = websiteField.Value.AsString();

Console.WriteLine($"Website: '{website}', with confidence {websiteField.Confidence}");

}

}

}

}

if (businessCard.Fields.TryGetValue("MobilePhones", out DocumentField mobilePhonesFields))

{

if (mobilePhonesFields.FieldType == DocumentFieldType.List)

{

foreach (DocumentField mobilePhoneField in mobilePhonesFields.Value.AsList())

{

if (mobilePhoneField.FieldType == DocumentFieldType.PhoneNumber)

{

string mobilePhone = mobilePhoneField.Value.AsPhoneNumber();

Console.WriteLine($"Mobile phone number: '{mobilePhone}', with confidence {mobilePhoneField.Confidence}");

}

}

}

}

if (businessCard.Fields.TryGetValue("WorkPhones", out DocumentField workPhonesFields))

{

if (workPhonesFields.FieldType == DocumentFieldType.List)

{

foreach (DocumentField workPhoneField in workPhonesFields.Value.AsList())

{

if (workPhoneField.FieldType == DocumentFieldType.PhoneNumber)

{

string workPhone = workPhoneField.Value.AsPhoneNumber();

Console.WriteLine($"Work phone number: '{workPhone}', with confidence {workPhoneField.Confidence}");

}

}

}

}

if (businessCard.Fields.TryGetValue("Faxes", out DocumentField faxesFields))

{

if (faxesFields.FieldType == DocumentFieldType.List)

{

foreach (DocumentField faxField in faxesFields.Value.AsList())

{

if (faxField.FieldType == DocumentFieldType.PhoneNumber)

{

string fax = faxField.Value.AsPhoneNumber();

Console.WriteLine($"Fax phone number: '{fax}', with confidence {faxField.Confidence}");

}

}

}

}

if (businessCard.Fields.TryGetValue("Addresses", out DocumentField addressesFields))

{

if (addressesFields.FieldType == DocumentFieldType.List)

{

foreach (DocumentField addressField in addressesFields.Value.AsList())

{

if (addressField.FieldType == DocumentFieldType.String)

{

string address = addressField.Value.AsString();

Console.WriteLine($"Address: '{address}', with confidence {addressField.Confidence}");

}

}

}

}

if (businessCard.Fields.TryGetValue("CompanyNames", out DocumentField companyNamesFields))

{

if (companyNamesFields.FieldType == DocumentFieldType.List)

{

foreach (DocumentField companyNameField in companyNamesFields.Value.AsList())

{

if (companyNameField.FieldType == DocumentFieldType.String)

{

string companyName = companyNameField.Value.AsString();

Console.WriteLine($"Company name: '{companyName}', with confidence {companyNameField.Confidence}");

}

}

}

}

}

名刺モデルの出力を表示するには、GitHub 上の Azure サンプル リポジトリにアクセスします。

クライアント ライブラリ | SDK リファレンス | API リファレンス | パッケージ (Maven) | サンプル |サポートされている REST API バージョン

前提条件

Azure サブスクリプション。無料で作成できます。

Visual Studio Code または好みの IDE の最新バージョン。 「Java in Visual Studio Code」を参照してください。

- Visual Studio Code には、Windows および macOS 向けに Coding Pack for Javaが用意されています。 このコーディング パックは、

VSCode、Java Development Kit (JDK)、および Microsoft が推奨する拡張機能のコレクションのバンドルです。 コーディング パックを使用して、既存の開発環境を修正できます。 VSCode と Coding Pack For Java を使用している場合は、Gradle for Java 拡張機能をインストールします。

Visual Studio Code を使用していない場合、開発環境に次のものがインストールされていることを確認してください。

- Java Development Kit (JDK) バージョン 8 以降。 詳しくは、「Microsoft Build of OpenJDK」を参照してください。

- Gradle、バージョン 6.8 以降。

- Visual Studio Code には、Windows および macOS 向けに Coding Pack for Javaが用意されています。 このコーディング パックは、

Azure AI サービスまたは Document Intelligence リソース。 単一サービスまたはマルチサービスを作成します。 Free 価格レベル (

`F0` ) を使用してサービスを試用し、後から運用環境用の有料レベルにアップグレードすることができます。ヒント

1 つのエンドポイントとキーを使用して複数の Azure AI サービスにアクセスする予定の場合は、Azure AI サービス リソースを作成します。 Document Intelligence へのアクセスのみの場合は、Document Intelligence リソースを作成します。 Microsoft Entra 認証を使用する場合は、単一サービス リソースが必要です。

アプリケーションを Document Intelligence API に接続するために作成したリソースのキーとエンドポイント。

- リソースがデプロイされたら、 [リソースに移動] を選択します。

- 左側のナビゲーション メニューで、[キーとエンドポイント] を選択します。

- この記事の後半で使用するために、いずれかのキーとエンドポイントをコピーします。

URL で指定されたドキュメント ファイル。 このプロジェクトでは、各機能について、次の表に示すサンプル フォームを使用できます。

機能 modelID document-url 読み取りモデル prebuilt-read サンプル パンフレット レイアウト モデル 事前構築済みレイアウト 予約確認のサンプル W-2 フォーム モデル prebuilt-tax.us.w2 サンプル W-2 フォーム 請求書モデル prebuilt-invoice サンプル請求書 レシート モデル prebuilt-receipt サンプル レシート 身分証明書モデル prebuilt-idDocument サンプル身分証明書

環境変数を設定する

Document Intelligence サービスとやり取りするには、DocumentAnalysisClient クラスのインスタンスを作成する必要があります。 これを行うには、Azure portal から key と endpoint を使用してクライアントをインスタンス化します。 このプロジェクトでは、資格情報の格納とアクセスに環境変数を使用します。

重要

キーをコードに直接含めたり、公開したりしないでください。 運用環境では、Azure Key Vault など、資格情報を保存してアクセスするための安全な方法を使用してください。 詳しくは、「Azure AI サービスのセキュリティ」をご覧ください。

ドキュメントインテリジェンスリソース キーの環境変数を設定するには、コンソール ウィンドウを開き、オペレーティング システムと開発環境の指示に従います。 <yourKey> と <yourEndpoint> を、Azure portal 内のご自分のリソースの値に置き換えます。

Windows の環境変数では大文字と小文字は区別されません。 通常は大文字で宣言され、単語はアンダースコアで結合されます。 コマンド プロンプトで、次のコマンドを実行します。

キー変数を設定します。

setx DI_KEY <yourKey>エンドポイント変数を設定する

setx DI_ENDPOINT <yourEndpoint>環境変数を設定したら、[コマンド プロンプト] ウィンドウを閉じます。 値は、もう一度変更するまで保持されます。

環境変数を読み取る実行中のプログラムを再起動します。 たとえば、Visual Studio または Visual Studio Code をエディターとして使用している場合、サンプル コードを実行する前に再起動する必要があります。

環境変数で使用するのに役立つコマンドをいくつか次に示します。

| コマンド | アクション | 例 |

|---|---|---|

setx VARIABLE_NAME= |

値を空の文字列に設定して、環境変数を削除します。 | setx DI_KEY= |

setx VARIABLE_NAME=value |

環境変数の値を設定または変更します | setx DI_KEY=<yourKey> |

set VARIABLE_NAME |

特定の環境変数の値を表示します。 | set DI_KEY |

set |

すべての環境変数を表示します。 | set |

プログラミング環境のセットアップ

プログラミング環境を設定するには、Gradle プロジェクトを作成し、クライアント ライブラリをインストールします。

Gradle プロジェクトを作成する

コンソール ウィンドウで、アプリの新しいディレクトリを doc-intelligence-app という名前で作成し、そのディレクトリに移動します。

mkdir doc-intelligence-app cd doc-intelligence-app作業ディレクトリから

gradle initコマンドを実行します。 このコマンドによって、Gradle 用の重要なビルド ファイルが作成されます。たとえば、実行時にアプリケーションを作成して構成するために使用される build.gradle.kts などです。gradle init --type basicDSL を選択するよう求められたら、Kotlin を選択します。

[Enter] を選択して、既定のプロジェクト名 doc-intelligence-app をそのまま使用します。

クライアント ライブラリをインストールする

この記事では、Gradle 依存関係マネージャーを使用します。 クライアント ライブラリとその他の依存関係マネージャーの情報については、Maven Central Repository を参照してください。

IDE でプロジェクトの build.gradle.kts ファイルを開きます。 次のコードをコピーして貼り付け、必要なプラグインと設定と共に、クライアント ライブラリを

implementationステートメントとして含めます。plugins { java application } application { mainClass.set("DocIntelligence") } repositories { mavenCentral() } dependencies { implementation group: 'com.azure', name: 'azure-ai-documentintelligence', version: '1.0.0-beta.2' }

Java アプリケーションの作成

Document Intelligence サービスとやり取りするために、DocumentIntelligenceClient クラスのインスタンスを作成します。 これを行うために、Azure portal の key を使用して AzureKeyCredential を作成し、その AzureKeyCredential と Document Intelligence の endpoint を使用して DocumentIntelligenceClient インスタンスを作成します。

doc-intelligence-app ディレクトリから、次のコマンドを実行します。

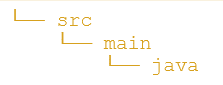

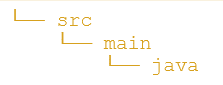

mkdir -p src/main/java

このコマンドにより、次のディレクトリ構造が作成されます。

javaディレクトリに移動して、DocIntelligence.java という名前のファイルを作成します。ヒント

PowerShell を使用して新しいファイルを作成できます。 Shift キーを押しながらフォルダーを右クリックして、プロジェクト ディレクトリで PowerShell ウィンドウを開き、次のコマンドを入力します。New-Item DocIntelligence.java。

DocIntelligence.java ファイルを開き、次のいずれかのコード サンプルを選択してコピーし、アプリケーションに貼り付けます。

- 事前構築済みの読み取り モデルは、すべての ドキュメントインテリジェンス モデルの中核であり、行、単語、場所、言語を検出できます。 レイアウト、一般的なドキュメント、事前構築済み、カスタムの各モデルでは、ドキュメントからテキストを抽出するための基盤として

readモデルが使用されます。 - 事前構築済みレイアウト モデルは、ドキュメントと画像からテキストとテキストの場所、テーブル、選択マーク、構造体情報を抽出します。

- 事前構築済み tax.us.w2 モデルは、米国内国歳入庁 (IRS) の税フォームで報告された情報を抽出します。

- 事前構築済み請求書モデルは、さまざまな形式の売上請求書から主なフィールドと品目を抽出します。

- 事前構築済み領収書モデルでは、印刷された領収書と手書きのレシートから重要な情報を分析して抽出します。

- 事前構築済み idDocument モデルは、米国の運転免許証、国際パスポートの略歴ページ、米国の州の ID、社会保障カード、永住者カードから重要な情報を抽出します。

- 事前構築済みの読み取り モデルは、すべての ドキュメントインテリジェンス モデルの中核であり、行、単語、場所、言語を検出できます。 レイアウト、一般的なドキュメント、事前構築済み、カスタムの各モデルでは、ドキュメントからテキストを抽出するための基盤として

次のコマンドを入力します。

gradle build gradle run

読み取りモデルを使用する

import com.azure.ai.documentintelligence;

import com.azure.ai.documentintelligence.models.AnalyzeDocumentRequest;

import com.azure.ai.documentintelligence.models.AnalyzeResult;

import com.azure.ai.documentintelligence.models.AnalyzeResultOperation;

import com.azure.ai.documentintelligence.models.Document;

import com.azure.ai.documentintelligence.models.DocumentField;

import com.azure.ai.documentintelligence.models.DocumentFieldType;

import com.azure.core.credential.AzureKeyCredential;

import com.azure.core.util.polling.SyncPoller;

import java.io.IOException;

import java.time.LocalDate;

import java.util.List;

import java.util.Map;

public class DocIntelligence {

//use your `key` and `endpoint` environment variables

private static final String key = System.getenv("FR_KEY");

private static final String endpoint = System.getenv("FR_ENDPOINT");

public static void main(final String[] args) {

// create your `DocumentIntelligenceClient` instance and `AzureKeyCredential` variable

DocumentIntelligenceClient client = new DocumentIntelligenceClientBuilder()

.credential(new AzureKeyCredential(key))

.endpoint(endpoint)

.buildClient();

//sample document

String documentUrl = "https://raw.githubusercontent.com/Azure-Samples/cognitive-services-REST-api-samples/master/curl/form-recognizer/rest-api/read.png";