Important

Lakeflow パイプライン エディターは パブリック プレビュー段階です。

Azure Databricks では、パイプラインとそのパイプラインに関連付けられているすべてのコードをソース管理できます。 パイプラインに関連付けられているすべてのファイルをソース管理することで、変換コード、探索コード、パイプライン構成に対する変更はすべて Git でバージョン管理され、開発でテストされ、自信を持って運用環境にデプロイできます。

ソース管理パイプラインには、次の利点があります。

- 追跡可能性: Git 履歴のすべての変更をキャプチャします。

- テスト: 共有運用ワークスペースに昇格する前に、開発ワークスペースのパイプラインの変更を検証します。 すべての開発者は、Git フォルダーと独自のスキーマ内の独自のコード ブランチに独自の開発パイプラインを持っています。

- コラボレーション: 個々の開発とテストが完了すると、コードの変更がメインの運用パイプラインにプッシュされます。

- ガバナンス: エンタープライズ CI/CD とデプロイ標準に合わせます。

Azure Databricks を使用すると、Databricks アセット バンドルを使用してパイプラインとそのソース ファイルをソース管理できます。 バンドルでは、パイプライン構成は、パイプラインの Python または SQL ソース ファイルと共に YAML 構成ファイルの形式でソース管理されます。 1 つのバンドルには、1 つまたは複数のパイプラインと、ジョブなどの他のリソースの種類が含まれる場合があります。

このページでは、Databricks アセット バンドルを使用してソース管理パイプラインを設定する方法を示します。 バンドルの詳細については、「 Databricks アセット バンドルとは」を参照してください。

Requirements

ソース管理パイプラインを作成するには、既に以下が必要です。

- ワークスペースに作成され、構成された Git フォルダー。 Git フォルダーを使用すると、個々のユーザーは変更を作成してテストしてから、Git リポジトリにコミットできます。 Azure Databricks Git フォルダーを参照してください。

- Lakeflow Pipelines エディターが有効になっています。 このチュートリアルで説明する UI は、このエディター エクスペリエンスでのみ使用できます。 Lakeflow パイプライン エディターを使用した ETL パイプラインの開発とデバッグを参照してください。

バンドルに新しいパイプラインを作成する

注

Databricks では、最初からソース管理されたパイプラインを作成することをお勧めします。 または、既にソース管理されているバンドルに既存のパイプラインを追加することもできます。 「既存のリソースをバンドルに移行する」を参照してください。

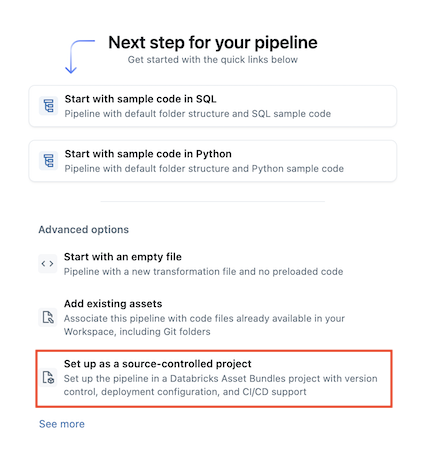

新しいソース管理パイプラインを作成するには:

ワークスペースで、[プラス] アイコンに移動

新規>

ETL パイプライン。

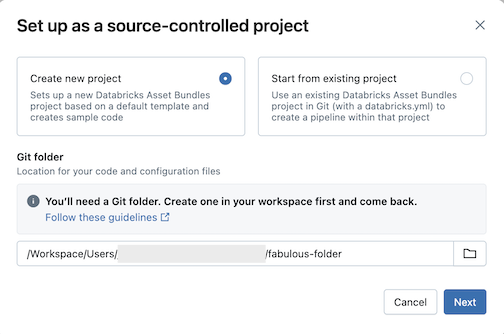

ソース管理プロジェクトとしてのセットアップ:

[ 新しいプロジェクトの作成] をクリックし、コードと構成を配置する Git フォルダーを選択します。

[次へ] をクリックします。

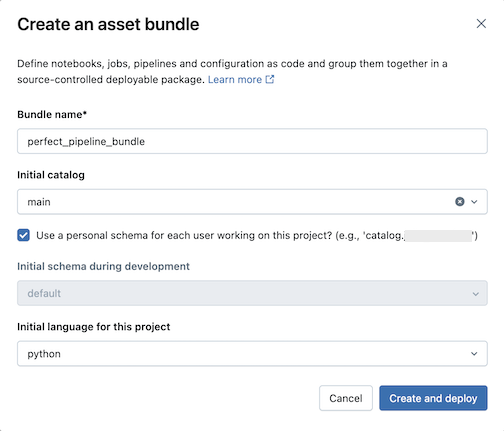

[アセット バンドルの作成] ダイアログで、次のように入力します。

- バンドル名: バンドルの名前。

- 初期カタログ: 使用するスキーマを含むカタログの名前。

- 個人用スキーマを使用する: 編集内容を個人用スキーマに分離する場合は、このチェック ボックスをオンのままにします。これにより、組織内のユーザーが同じプロジェクトで共同作業を行うときに、開発におけるお互いの変更が上書きされることはありません。

- 初期言語: プロジェクトのサンプル パイプライン ファイル (Python または SQL) に使用する最初の言語。

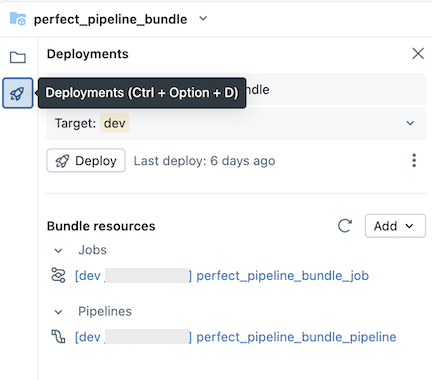

作成してデプロイをクリックします。 パイプラインを含むバンドルが Git フォルダーに作成されます。

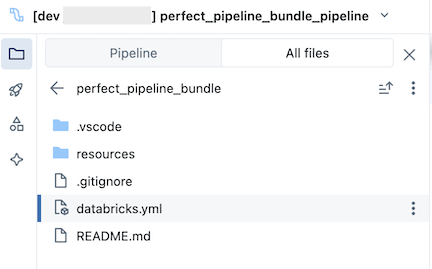

パイプライン バンドルを調べる

次に、作成されたパイプライン バンドルを探索します。

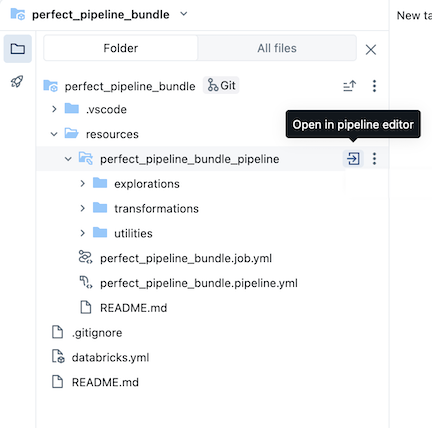

Git フォルダーにあるバンドルには、バンドル システム ファイルと、変数、ターゲット ワークスペースの URL とアクセス許可、バンドルのその他の設定を定義する databricks.yml ファイルが含まれています。 バンドルの resources フォルダーには、パイプラインなどのリソースの定義が含まれています。

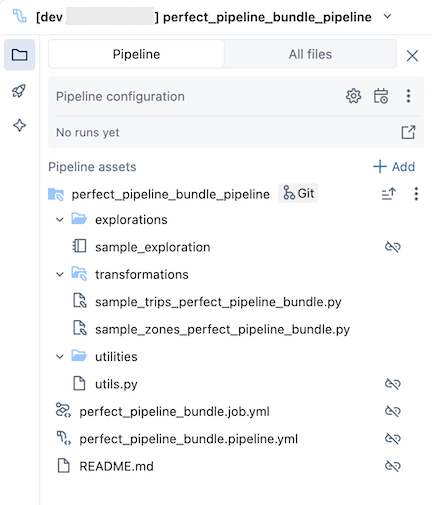

resources フォルダーを開き、パイプライン エディター ボタンをクリックしてソース管理パイプラインを表示します。

サンプル パイプライン バンドルには、次のファイルが含まれています。

サンプル探索ノートブック

テーブルに対して変換を実行する 2 つのサンプル コード ファイル

ユーティリティ関数を含むサンプル コード ファイル

パイプラインを実行するバンドル内のジョブを定義するジョブ構成 YAML ファイル

パイプラインを定義するパイプライン構成 YAML ファイル

Important

このファイルを編集して、UI を介して行われた変更を含め、パイプラインに対する構成変更を永続的に保持する必要があります。それ以外の場合、バンドルを再デプロイすると UI の変更がオーバーライドされます。 たとえば、パイプラインに別の既定のカタログを設定するには、この構成ファイルの

catalogフィールドを編集します。サンプル パイプライン バンドルに関する詳細とパイプラインの実行方法に関する手順を含む README ファイル

パイプライン ファイルの詳細については、「 パイプライン資産ブラウザー」を参照してください。

パイプライン バンドルへの変更の作成とデプロイの詳細については、「 ワークスペースでのバンドルの作成 」および「 バンドルのデプロイ」を参照し、ワークスペースからワークフローを実行します。

パイプラインを実行する

個々の変換またはソース管理パイプライン全体を実行できます。

- パイプラインで 1 つの変換を実行してプレビューするには、ワークスペース ブラウザー ツリーで変換ファイルを選択して、ファイル エディターで開きます。 エディターのファイルの上部にある [ファイルの再生の 実行 ] ボタンをクリックします。

- パイプライン内のすべての変換を実行するには、Databricks ワークスペースの右上にある [ パイプラインの実行 ] ボタンをクリックします。

パイプラインの実行の詳細については、「パイプライン コードの実行」を参照してください。

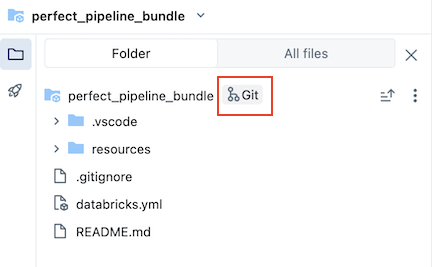

パイプラインを更新する

パイプライン内の成果物を更新したり、探索や変換を追加したりできますが、それらの変更を GitHub にプッシュする必要があります。 フォーク アイコンをクリックパイプライン バンドルに関連付けられている Git アイコン、またはフォルダーの kebab をクリックし、Git... をクリックして、プッシュする変更を選択します。

コミットとプッシュの変更を参照してください。

さらに、パイプライン構成ファイルを更新したり、バンドルからファイルを追加または削除したりすると、バンドルを明示的にデプロイするまで、これらの変更はターゲット ワークスペースに反映されません。 「バンドルのデプロイとワークスペースからのワークフローの実行」を参照してください。

注

Databricks では、ソース管理パイプラインの既定のセットアップを維持することをお勧めします。 既定のセットアップは、UI を介して追加のファイルを追加するときにパイプライン バンドルの YAML 構成を編集する必要がないように構成されています。

既存のパイプラインをバンドルに追加する

既存のパイプラインをバンドルに追加するには、まずワークスペースにバンドルを作成してから、次のページで説明するように、パイプライン YAML 定義をバンドルに追加します。

Databricks CLI を使用してリソースをバンドルに移行する方法については、「既存の リソースをバンドルに移行する」を参照してください。

その他のリソース

パイプラインのその他のチュートリアルとリファレンス 資料については、「 Lakeflow Spark 宣言型パイプライン」を参照してください。