アダプティブ クエリ実行 (AQE) は、クエリの実行中に発生するクエリの再最適化です。

実行時に再最適化を行う理由は、Azure Databricks では、シャッフルおよびブロードキャスト交換 (AQE ではクエリ ステージと呼ばれます) の最後に最新の正確な統計情報が得られることにあります。 その結果、Azure Databricks は、より優れた物理戦略を選択したり、最適なポストシャッフル パーティションのサイズと数を選択したり、ヒントを必要とするために使用される最適化 (スキュー結合処理など) を実行したりできます。

これは、統計収集が有効でない場合や統計が古い場合に非常に便利です。 また、複雑なクエリの途中やデータ スキューの発生後など、静的に派生した統計が不正確な場合にも役立ちます。

資格

AQE は既定で有効になっています。 これには 4 つの主要な機能があります。

- 並べ替えマージ結合をブロードキャスト ハッシュ結合に動的に変更します。

- シャッフル交換後にパーティションを動的に結合します (小さなパーティションを合理的なサイズのパーティションに結合します)。 非常に小さいタスクでは、I/O スループットが低下し、スケジュールのオーバーヘッドとタスクのセットアップのオーバーヘッドが多くなる傾向があります。 小さなタスクを組み合わせると、リソースが節約され、クラスターのスループットが向上します。

- 傾斜したタスクをほぼ均等なサイズのタスクに分割 (および必要に応じてレプリケート) することで、並べ替えマージ結合とシャッフル ハッシュ結合のスキューを動的に処理します。

- 空のリレーションを動的に検出して伝達します。

アプリケーション

AQE は、次のすべてのクエリに適用されます。

- 非ストリーミング

- 少なくとも 1 つの交換 (通常、結合、集計、またはウィンドウがある場合)、1 つのサブクエリ、またはその両方を含みます。

すべての AQE 適用クエリが必ずしも再最適化されるとは限りません。 再最適化では、静的にコンパイルされたクエリ プランとは異なるクエリ プランが発生する場合もあれば、そうでない場合もあります。 クエリのプランが AQE によって変更されたかどうかを確認するには、次のセクション「 クエリ プラン」を参照してください。

クエリ プラン

このセクションでは、さまざまな方法でクエリ プランを調べる方法について説明します。

このセクションでは、次の操作を行います。

Spark ユーザーインターフェイス (UI)

AdaptiveSparkPlan ノード

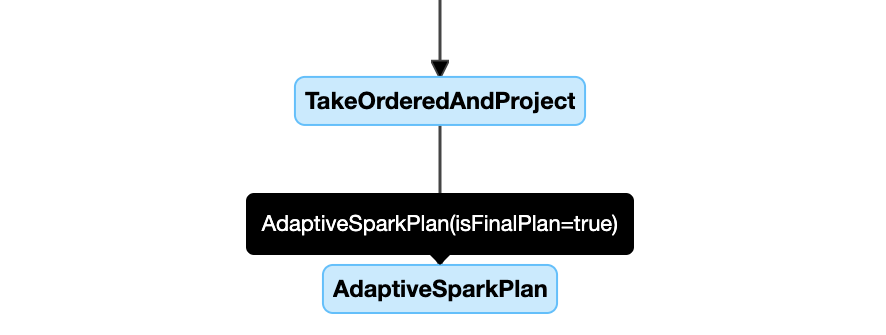

AQE 適用クエリには、通常、各メイン クエリまたはサブクエリのルート ノードとして、1 つ以上の AdaptiveSparkPlan ノードが含まれます。

クエリが実行される前または実行される前に、対応する isFinalPlan ノードの AdaptiveSparkPlan フラグが falseとして表示されます。クエリの実行が完了すると、isFinalPlan フラグが true. に変わります

進化する計画

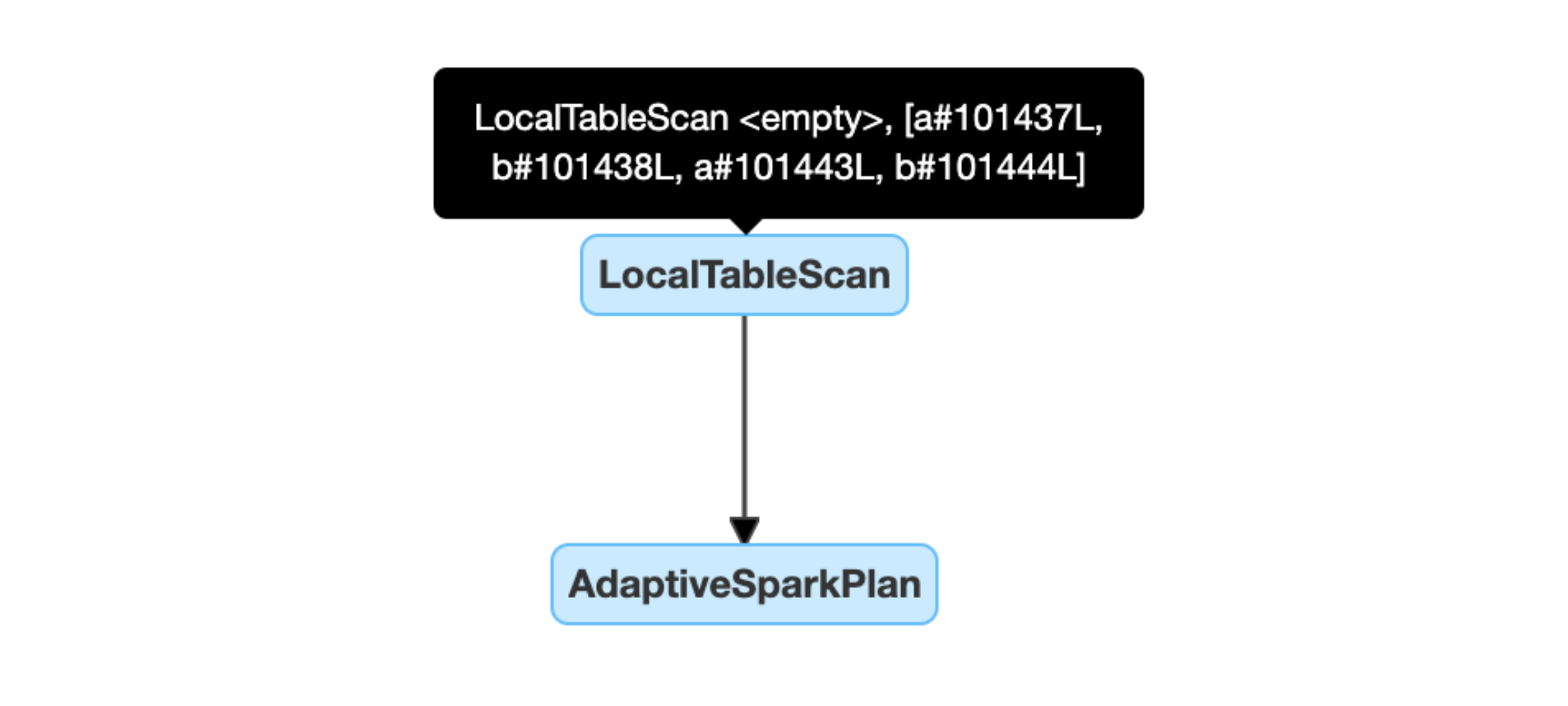

クエリ プラン図は、実行が進行するにつれて進化し、実行中の最新のプランが反映されます。 実行されているノード(メトリックが使用可能なもの)は変更されませんが、まだ実行されていないノードは、再最適化の結果として時間と共に変更される可能性があります。

クエリ プラン図の例を次に示します。

DataFrame.explain()

AdaptiveSparkPlan ノード

AQE 適用クエリには、通常、各メイン クエリまたはサブクエリのルート ノードとして、1 つ以上の AdaptiveSparkPlan ノードが含まれます。 クエリが実行される前または実行される前に、対応する isFinalPlan ノードの AdaptiveSparkPlan フラグが falseとして表示されます。クエリの実行が完了すると、isFinalPlan フラグが trueに変わります。

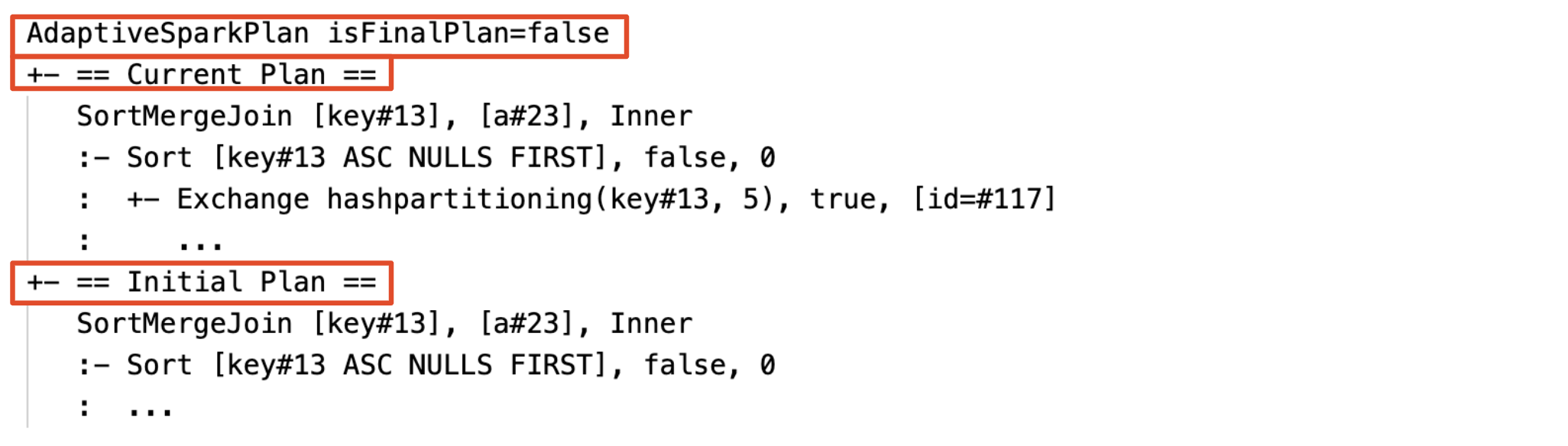

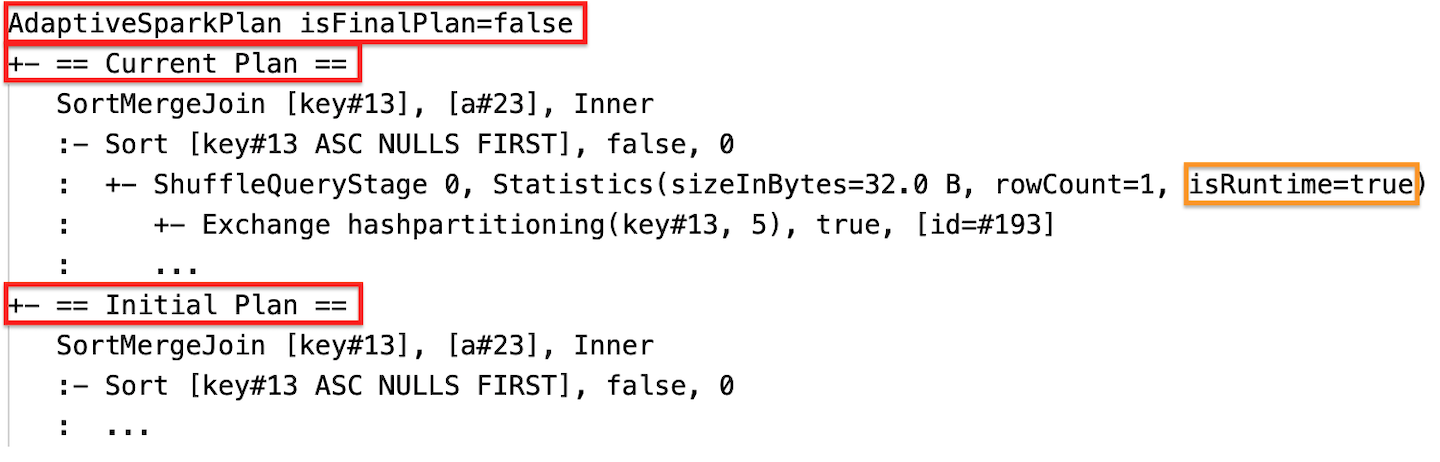

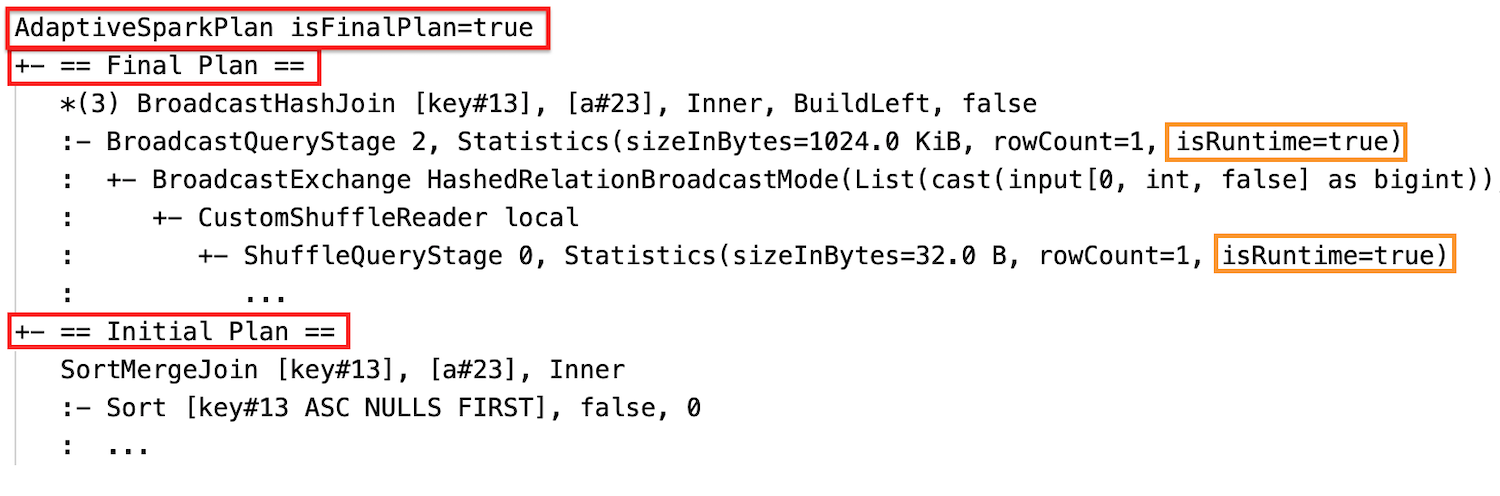

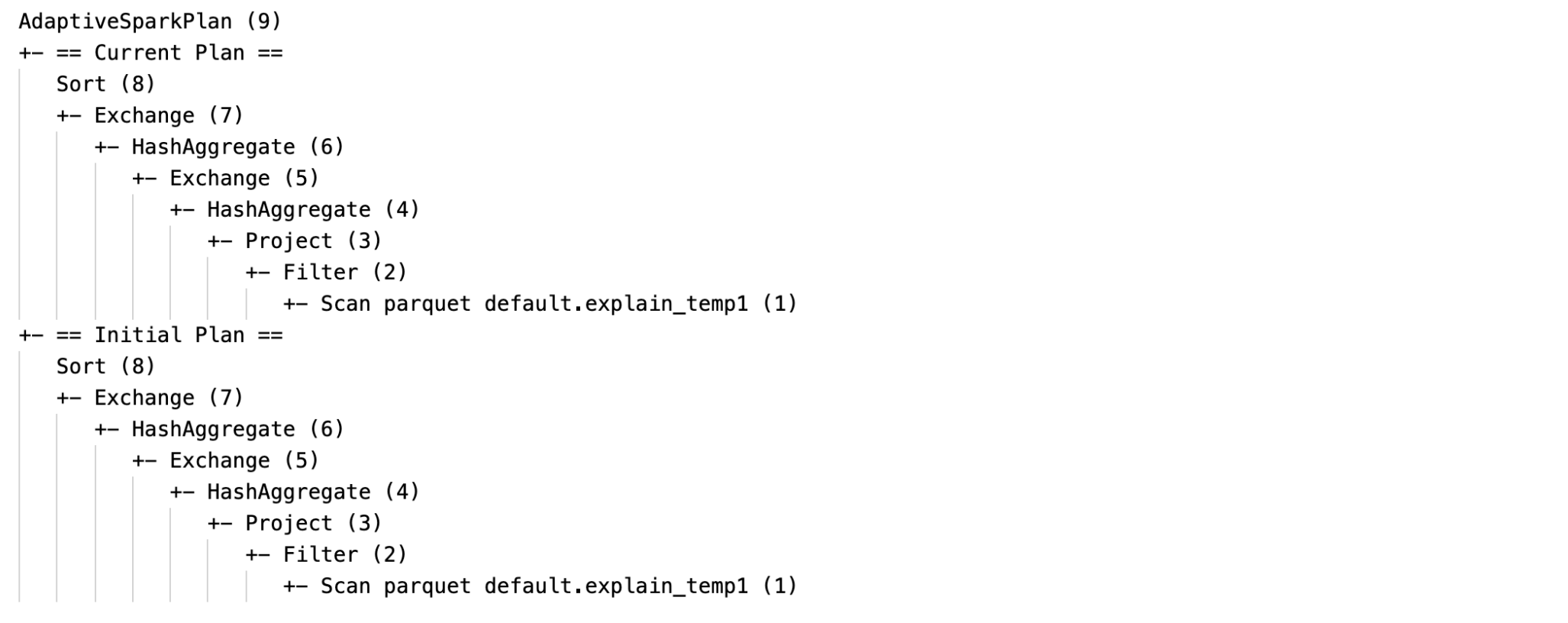

現在のプランと初期プラン

各 AdaptiveSparkPlan ノードの下には、実行が完了したかどうかに応じて、初期プラン (AQE 最適化を適用する前のプラン) と現在のプランまたは最終プランの両方があります。 現在のプランは、実行が進むにつれて進化します。

ランタイム統計

各シャッフル ステージとブロードキャスト ステージには、データ統計が含まれています。

ステージの実行前または実行中は、統計はコンパイル時の推定値であり、例えばフラグ isRuntime が falseの状態になります(例: Statistics(sizeInBytes=1024.0 KiB, rowCount=4, isRuntime=false);)。

ステージの実行が完了すると、統計は実行時に収集され、フラグ isRuntime は trueになります (例: Statistics(sizeInBytes=658.1 KiB, rowCount=2.81E+4, isRuntime=true)

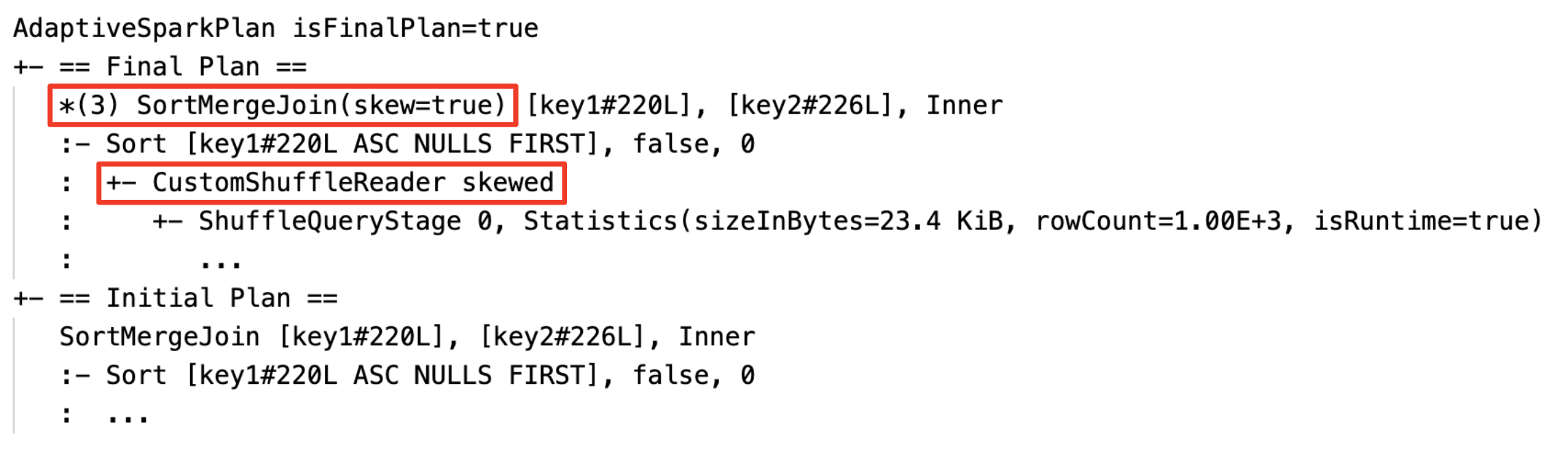

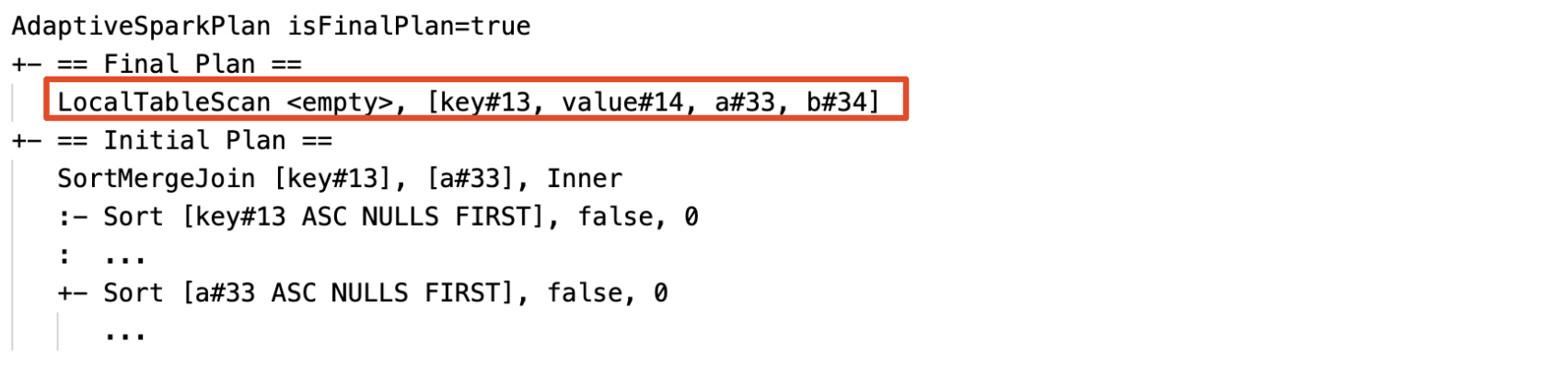

DataFrame.explain の例を次に示します。

実行前

実行中

実行中の

実行後

SQL EXPLAIN

AdaptiveSparkPlan ノード

AQE 適用クエリには、通常、各メイン クエリまたはサブクエリのルート ノードとして、1 つ以上の AdaptiveSparkPlan ノードが含まれます。

現在のプランはありません

SQL EXPLAINはクエリを実行しないため、現在のプランは常に初期プランと同じであり、最終的に AQE によって実行される内容は反映されません。

SQL の説明の例を次に示します。

有効性

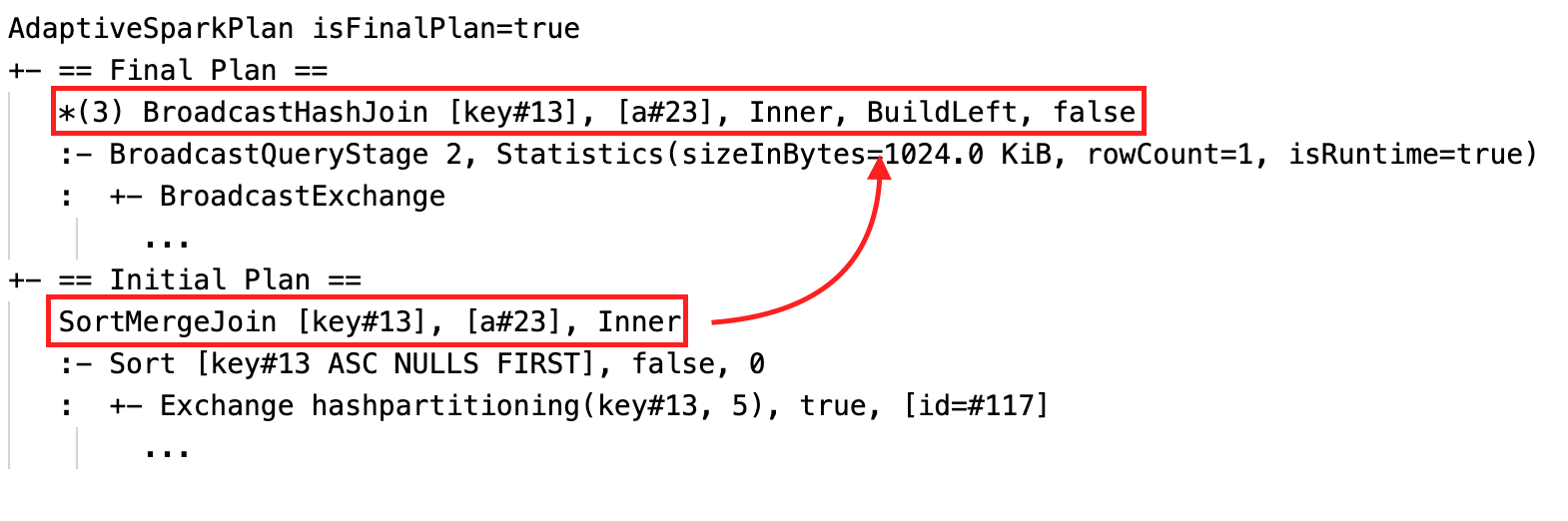

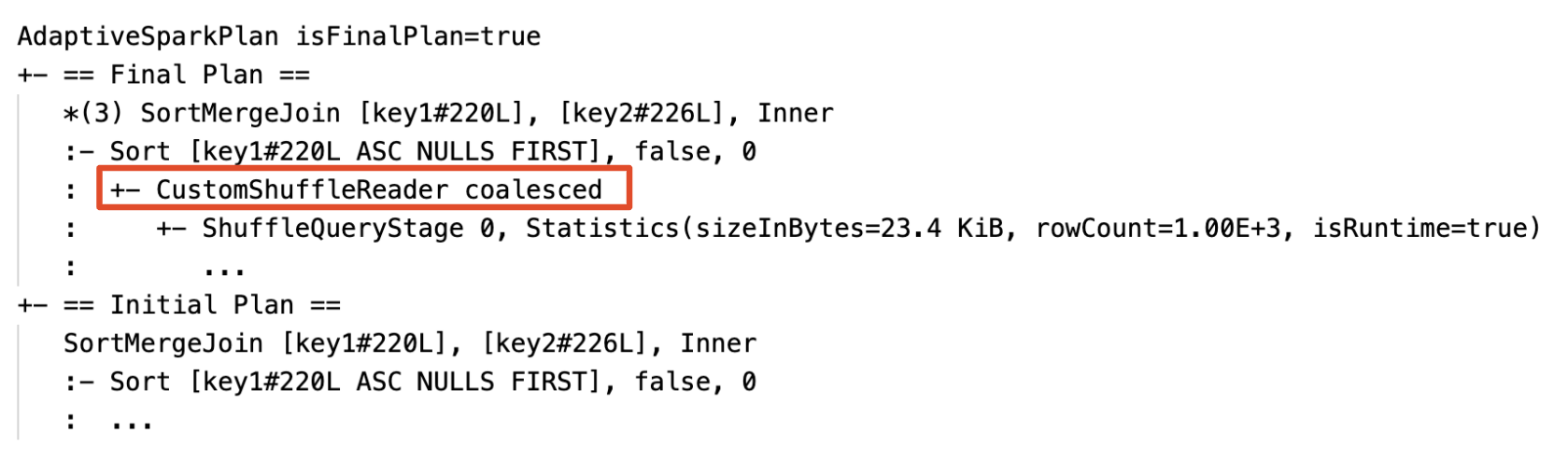

1 つ以上の AQE 最適化が有効になると、クエリ プランが変更されます。 これらの AQE 最適化の効果は、現在のプランと最終的なプランの差異、および初期プランと特定プランノードの差異によって示されています。

並べ替えマージ結合をブロードキャスト ハッシュ結合に動的に切り替える: 現在のプランと最終プラン、および初期プランの間で異なる物理結合ノード

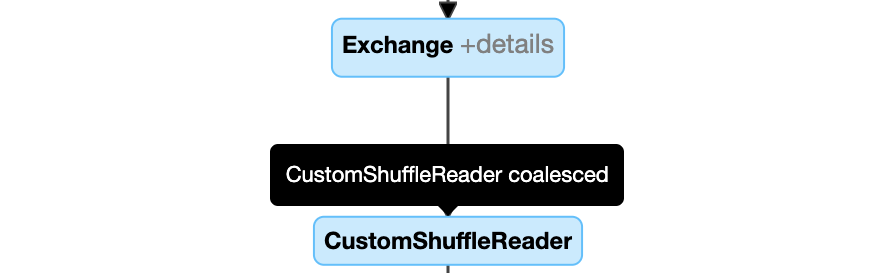

パーティションを動的に結合する: ノード

CustomShuffleReaderとプロパティCoalesced

スキュー結合を動的に処理する: フィールド

SortMergeJoinが true のノードisSkew。

空のリレーションを動的に検出して伝達します。プランの一部 (または全体) は、ノード LocalTableScan に置き換えられ、リレーション フィールドは空になります。

構成

このセクションでは、次の操作を行います。

- アダプティブ クエリ実行 を有効または無効にする

- 自動最適化シャッフル を有効にする

- 並べ替えマージ結合をブロードキャスト ハッシュ結合に動的に変更する

- パーティションを動的に結合する

- スキュー結合を動的に扱う

- 空のリレーションを動的に検出して伝達

アダプティブ クエリ実行を有効または無効にする

| 財産 |

|---|

|

spark.databricks.optimizer.adaptive.enabled 型: Booleanアダプティブ クエリ実行を有効または無効にするかどうか。 既定値: true |

自動最適化シャッフル機能を有効にする

| 財産 |

|---|

|

spark.sql.shuffle.partitions 型: Integer結合または集計のデータをシャッフルするときに使用する既定のパーティション数。 auto 値を設定すると、自動最適化シャッフルが有効になり、クエリ プランとクエリ入力データ サイズに基づいてこの数が自動的に決定されます。注: 構造化ストリーミングの場合、同じチェックポイントの場所からクエリを再起動する間は、この構成を変更できません。 既定値: 200 |

ソートマージ結合を動的に変更して、ブロードキャストハッシュ結合にする

| 財産 |

|---|

|

spark.databricks.adaptive.autoBroadcastJoinThreshold 型: Byte String実行時にブロードキャスト結合への切り替えをトリガーするしきい値。 既定値: 30MB |

パーティションを動的に結合する

| 財産 |

|---|

|

spark.sql.adaptive.coalescePartitions.enabled 型: Booleanパーティション結合を有効または無効にするかどうか。 既定値: true |

|

spark.sql.adaptive.advisoryPartitionSizeInBytes 型: Byte String結合後のターゲット サイズ。 結合されたパーティション サイズは、このターゲット サイズに近くなりますが、このターゲット サイズより大きくはありません。 既定値: 64MB |

|

spark.sql.adaptive.coalescePartitions.minPartitionSize 型: Byte String結合後のパーティションの最小サイズ。 結合されたパーティション サイズは、このサイズより小さくはなりません。 既定値: 1MB |

|

spark.sql.adaptive.coalescePartitions.minPartitionNum 型: Integer結合後のパーティションの最小数。 この設定は次のものを明示的にオーバーライドするため、推奨されません: spark.sql.adaptive.coalescePartitions.minPartitionSize。既定値: クラスターコア数の2倍 |

スキュー結合を動的に処理する

| 財産 |

|---|

|

spark.sql.adaptive.skewJoin.enabled 型: Booleanスキュー結合処理を有効または無効にするかどうか。 既定値: true |

|

spark.sql.adaptive.skewJoin.skewedPartitionFactor 型: Integerパーティションの中央値サイズに乗じることで、それが偏っているかどうかを判断する要因。 既定値: 5 |

|

spark.sql.adaptive.skewJoin.skewedPartitionThresholdInBytes 型: Byte Stringパーティションが歪んでいるかどうかを判断するためのしきい値。 既定値: 256MB |

パーティションは、 (partition size > skewedPartitionFactor * median partition size) と (partition size > skewedPartitionThresholdInBytes) の両方が trueされると歪んでいると見なされます。

空のリレーションを動的に検出して伝達する

| 財産 |

|---|

|

spark.databricks.adaptive.emptyRelationPropagation.enabled 型: Boolean動的な空のリレーション伝達を有効または無効にするかどうか。 既定値: true |

よく寄せられる質問 (FAQ)

このセクションでは、次の操作を行います。

- AQE が小さな結合テーブルをブロードキャストしなかったのはなぜですか?

- AQE が有効になっているブロードキャスト参加戦略ヒントを引き続き使用する必要がありますか?

- スキュー結合ヒントと AQE スキュー結合の最適化の違いは何ですか? どれを使用する必要がありますか?

- AQE が結合順序を自動的に調整しなかったのはなぜですか?

- AQE がデータ スキューを検出しなかったのはなぜですか?

AQE が小さな結合テーブルをブロードキャストしなかったのはなぜですか?

ブロードキャストが予想される関係のサイズがこのしきい値に該当するが、まだブロードキャストされていない場合:

- 結合の種類を確認します。 ブロードキャストは、特定の結合の種類ではサポートされていません。たとえば、

LEFT OUTER JOINの左関係はブロードキャストできません。 - また、リレーションシップに多数の空のパーティションが含まれている可能性があります。その場合、タスクの大部分は、並べ替えマージ結合を使用してすばやく完了したり、スキュー結合処理で最適化したりすることができます。 AQE では、空でないパーティションの割合が

spark.sql.adaptive.nonEmptyPartitionRatioForBroadcastJoinより低い場合に、このような並べ替えマージ結合をブロードキャスト ハッシュ結合に変更することを回避します。

AQE が有効になっているブロードキャスト参加戦略ヒントを引き続き使用する必要がありますか?

はい。 静的に計画されたブロードキャスト結合は、通常、AQE によって動的に計画された結合よりもパフォーマンスが高くなります。AQE は、結合の両側に対してシャッフルを実行するまでブロードキャスト結合に切り替えない場合があるためです (この時点で実際の関係サイズが取得されます)。 そのため、クエリがわかっている場合は、ブロードキャスト ヒントを使用することをお勧めします。 AQE では、静的最適化と同じ方法でクエリ ヒントが考慮されますが、ヒントの影響を受けず動的最適化を適用することもできます。

スキュー結合ヒントと AQE スキュー結合の最適化の違いは何ですか? どれを使用する必要がありますか?

AQE スキュー結合は完全に自動であり、一般に、対応するヒントよりもパフォーマンスが優れているため、スキュー結合ヒントを使用するのではなく、AQE スキュー結合処理に依存することをお勧めします。

AQE が結合順序を自動的に調整しなかったのはなぜですか?

動的結合の順序変更は AQE の一部ではありません。

AQE がデータ スキューを検出しなかったのはなぜですか?

AQE がパーティションを傾斜したパーティションとして検出するには、次の 2 つのサイズ条件を満たす必要があります。

- パーティション サイズが

spark.sql.adaptive.skewJoin.skewedPartitionThresholdInBytesより大きい (既定値は 256 MB) - パーティションサイズが、すべてのパーティションの中央値のサイズの傾斜係数

spark.sql.adaptive.skewJoin.skewedPartitionFactor(デフォルトは5)倍よりも大きい

さらに、スキュー処理のサポートは、たとえば、 LEFT OUTER JOINでは、左側のスキューのみを最適化できる特定の結合の種類に制限されます。

遺産

"アダプティブ実行" という用語は Spark 1.6 以降に存在しましたが、Spark 3.0 の新しい AQE は根本的に異なります。 機能面では、Spark 1.6 は "パーティションを動的に結合する" 部分のみを実行します。 技術的なアーキテクチャに関しては、新しい AQE はランタイム統計に基づくクエリの動的な計画と再計画のフレームワークであり、この記事で説明した最適化など、さまざまな最適化をサポートし、より潜在的な最適化を可能にするために拡張できます。