これらの機能には、ソフトウェアとハードウェアの両方のコンポーネントがあります。 このソフトウェアは、機能が動作するために必要なハードウェア機能と密接に関連付けられています。 その例として、VMMQ、VMQ、送信側 IPv4 チェックサム オフロード、RSS などがあります。 詳細については、「Azure Localのホスト ネットワーク要件」を参照してください。

ヒント

インストールされている NIC でサポートされている場合は、SH および HO 機能を使用できます。 以下の機能の説明では、NIC がこの機能をサポートしているかどうかを確認する方法について説明します。

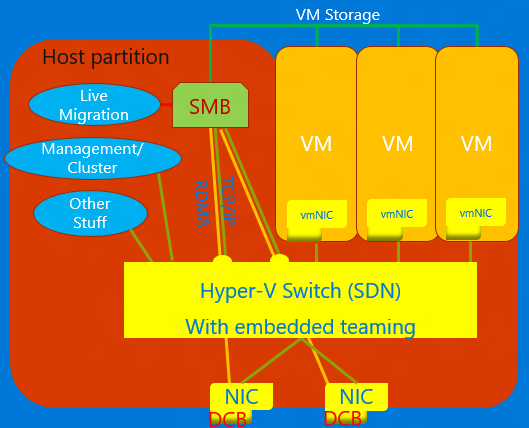

コンバージド NIC

コンバージド NIC は、Hyper-V ホスト内の仮想 NIC が RDMA サービスをホスト プロセスに公開できるようにするテクノロジです。 Windows Server 2016 は、RDMA 用に個別の NIC を必要としなくなりました。 コンバージド NIC 機能を使用すると、ホスト パーティション内の仮想 NIC (vNIC) で RDMA をホスト パーティションに公開し、RDMA トラフィックと VM と他の TCP/UDP トラフィックの間で NIC の帯域幅を公平かつ管理可能な方法で共有できます。

コンバージド NIC の操作は、VMM または Windows PowerShell を使用して管理できます。 PowerShell コマンドレットは、RDMA に使用されるコマンドレットと同じです (下記参照)。

コンバージド NIC 機能を使用するには

DCB 用にホストを設定します。

NIC で RDMA を有効にするか、SET チームの場合は NIC が Hyper-V スイッチにバインドされていることを確認します。

ホストで RDMA 用に指定された vNIC で RDMA を有効にします。

RDMA と SET の詳細については、「リモート ダイレクト メモリ アクセス (RDMA) とスイッチ埋め込みチーミング (SET)」を参照してください。

データ センター ブリッジング (DCB)

DCB は、データ センターでコンバージド ファブリックを使用できるようにする IEEE (Institute of Electrical and Electronics Engineers) 標準のスイートです。 DCB は、隣接するスイッチと連携して、ホストでハードウェア キューベースの帯域幅管理を提供します。 ストレージ、データ ネットワーク、クラスターのプロセス間通信 (IPC)、管理のすべてのトラフィックは、同じイーサネット ネットワーク インフラストラクチャを共有します。 Windows Server 2016 では、DCB は任意の NIC に個別に適用することができ、NIC は Hyper-V スイッチにバインドされます。

DCB の場合、Windows Server では、IEEE 802.1Qbb で標準化された優先順位ベースのフロー制御 (PFC) が使用されます。 PFC は、トラフィック クラス内のオーバーフローを防ぐことで、(ほぼ) 損失のないネットワーク ファブリックを作成します。 Windows Server は、IEEE 802.1Qaz で標準化された拡張送信選択 (ETS) も使用します。 ETS を使用すると、最大 8 クラスのトラフィックの予約済み部分に帯域幅を分割できます。 各トラフィック クラスには専用の送信キューがあり、PFC を使用して、クラス内の送信を開始および停止できます。

Hyper-V ネットワーク仮想化

| バージョン | 説明 |

|---|---|

| v1 (HNVv1) | Windows Server 2012 で導入された、Hyper-V ネットワーク仮想化 (HNV) を使用すると、共有の物理ネットワーク インフラストラクチャ上で顧客のネットワークを仮想化することができます。 物理ネットワーク ファブリックで最小限の変更を行う必要がありますが、HMV を使用すると、サービス プロバイダーは、サービス プロバイダー クラウド、プライベート クラウド、または Microsoft Azure パブリック クラウドの 3 つのクラウド全体の任意の場所に、テナントのワークロードを展開および移行する機敏性を得ることができます。 |

| v2 NVGRE (HNVv2 NVGRE) | Windows Server 2016 および System Center Virtual Machine Manager では、Microsoft は、RAS ゲートウェイ、ソフトウェア負荷分散、ネットワーク コントローラーを含む、エンドツーエンドのネットワーク仮想化ソリューションを提供しています。 詳細については、Windows Server 2016 での Hyper-V ネットワーク仮想化の概要に関するページを参照してください。 |

| v2 VxLAN (HNVv2 VxLAN) | Windows Server 2016 では、ネットワーク コントローラーを介して管理する SDN 拡張機能の一部です。 |

IPsec タスク オフロード (IPsecTO)

IPsec タスク オフロードは、オペレーティング システムが IPsec 暗号化作業のために NIC 上のプロセッサを使用できるようにする NIC 機能です。

重要

IPsec タスク オフロードは、ほとんどのネットワーク アダプターではサポートされていないレガシ テクノロジであり、存在する場所では既定で無効になっています。

プライベート仮想ローカル エリア ネットワーク (PVLAN)

PVLAN では、同じ仮想化サーバー上の仮想マシン間の通信のみを許可します。 プライベート仮想ネットワークは、物理ネットワーク アダプターにバインドされません。 プライベート仮想ネットワークは仮想化サーバーのすべての外部ネットワーク トラフィックから分離され、管理オペレーティング システムと外部ネットワークの間のネットワーク トラフィックからも分離されます。 この種類のネットワークは、隔離されたテスト ドメインなど、隔離されたネットワーク環境を構築する必要がある場合に役立ちます。 Hyper-V スタックと SDN スタックは、PVLAN 分離ポート モードのみをサポートします。

PVLAN 分離の詳細については、「System Center: Virtual Machine Manager Engineering Blog」を参照してください。

リモート ダイレクト メモリ アクセス (RDMA)

RDMA は、CPU 使用率を最小限に抑える、高スループット、低待機時間の通信を実現するネットワーク テクノロジです。 RDMA では、ネットワーク アダプターがアプリケーション メモリとの間で直接データを転送できるようにすることで、ゼロ コピー ネットワークがサポートされます。 RDMA 対応とは、NIC (物理または仮想) が RDMA クライアントに RDMA を公開できることを意味します。 一方、RDMA 有効とは、RDMA 対応 NIC が RDMA インターフェイスをスタック上に公開していることを意味します。

RDMA の詳細については、「リモート ダイレクト メモリ アクセス (RDMA) とスイッチ埋め込みチーミング (SET)」を参照してください。

Receive Side Scaling(RSS)(受信側スケーリング(RSS))

RSS は、さまざまなストリーム セットを分離し、処理のために異なるプロセッサに配信する NIC 機能です。 RSS はネットワーク処理を並列化し、ホストを非常に高いデータ レートにスケーリングすることができます。

詳細については、「Receive Side Scaling (RSS)」を参照してください。

単一ルート入出力仮想化 (SR-IOV)

SR-IOV を使用すると、HYPER-V ホストを経由せずに、VM トラフィックを NIC から VM に直接移動できます。 SR-IOV は VM のパフォーマンスを大幅に向上させますが、ホストでパイプを管理する機能はありません。 ワークロードが正常に動作し、信頼され、通常はホスト内の唯一の VM である場合にのみ、SR-IOV を使用してください。

SR-IOV を使用するトラフィックは Hyper-V スイッチをバイパスします。これは、ACL や帯域幅管理など、すべてのポリシーが適用されないことを意味します。 SR-IOV トラフィックは、どのネットワーク仮想化機能も経由できないので、NV-GRE または VxLAN のカプセル化を適用できません。 特定の状況で十分に信頼できるワークロードにのみ SR-IOV を使用してください。 また、ホスト ポリシー、帯域幅管理、仮想化テクノロジを使用することはできません。

将来的に、SR-IOV は、Generic Flow Tables (GFT) とハードウェア QoS オフロード (NIC での帯域幅管理) という 2 つのテクノロジを可能にし、Microsoft のエコシステム内の NIC でそれらをサポートする予定です。 これら 2 つのテクノロジを組み合わせて使用すると、すべての VM で SR-IOV が役に立ち、またポリシー、仮想化、帯域幅の管理規則を適用できるようになり、結果として、SR-IOV の一般的なアプリケーションで大きな飛躍を実現できる可能性があります。

詳細については、「シングル ルート I/O 仮想化 (SR-IOV) の概要」を参照してください。

TCP Chimney オフロード

TCP Chimney Offload (TCP Engine Offload (TOE) とも呼ばれます) は、ホストがすべての TCP 処理を NIC にオフロードできるようにするテクノロジです。 Windows Server TCP スタックは、ほぼ常に TOE エンジンよりも効率的なので、TCP Chimney Offload の使用は推奨されません。

重要

TCP Chimney Offload は非推奨のテクノロジです。 Microsoft が今後サポートを停止する可能性があるので、TCP Chimney Offload を使用しないことをお勧めします。

仮想ローカル エリア ネットワーク (VLAN)

VLAN はイーサネット フレーム ヘッダーの拡張機能で、LAN を複数の VLAN にパーティション分割し、それぞれが専用のアドレス空間を使用できるようにします。 Windows Server 2016 では、VLAN は、Hyper-V スイッチのポートに設定するか、NIC チーミング チームにチーム インターフェイスを設定することで設定されます。

仮想マシン キュー (VMQ)

VMQ は、各 VM のキューを割り当てる NIC 機能です。 Hyper-V を有効にしている場合は、常に、VMQ も有効にする必要があります。 Windows Server 2016 では、VMQ は、vPort に割り当てられた 1 つのキューを持つ NIC スイッチ vPort を使用して、同じ機能を提供します。

仮想マシンの複数のキュー (VMMQ)

VMMQ は、VM のトラフィックを複数のキューに分散し、それぞれを異なる物理プロセッサで処理できるようにする NIC 機能です。 その後、vRSS と同様に、トラフィックは VM 内の複数の LP に渡されます。これにより、かなりのネットワーク帯域幅を VM に提供できます。