Azure Data Explorer 데이터 수집 개요

데이터 수집에는 클러스터의 테이블에 데이터를 로드하는 작업이 포함됩니다. Azure Data Explorer는 데이터 유효성을 보장하고, 필요에 따라 형식을 변환하며, 스키마 일치, 조직, 인덱싱, 인코딩 및 압축과 같은 조작을 수행합니다. 수집되면 쿼리에 데이터를 사용할 수 있습니다.

Azure Data Explorer는 스트리밍 또는 큐에 대기 중인 수집을 사용하여 일회성 수집 또는 연속 수집 파이프라인의 설치를 제공합니다. 적합한 항목을 확인하려면 일회성 데이터 수집 및 연속 데이터 수집을 참조하세요.

참고 항목

데이터는 설정된 보존 정책에 따라 스토리지에 유지됩니다.

일회성 데이터 수집

일회성 수집은 기록 데이터 전송, 누락된 데이터 채우기, 프로토타입 생성 및 데이터 분석의 초기 단계에 유용합니다. 이 방법은 연속 파이프라인 약정 없이도 빠른 데이터 통합을 용이하게 합니다.

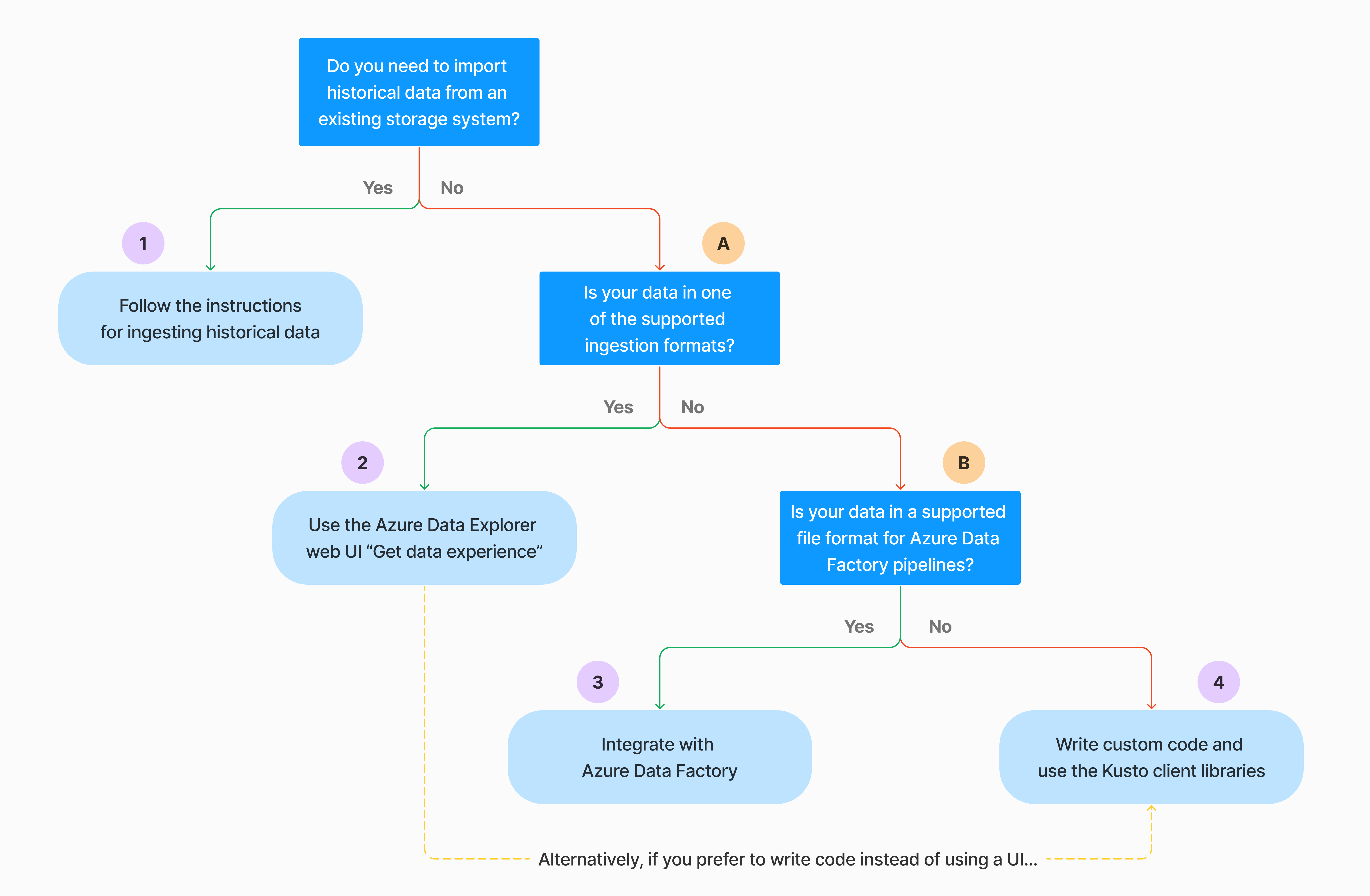

일회성 데이터 수집을 수행하는 방법에는 여러 가지가 있습니다. 다음 의사 결정 트리를 사용하여 사용 사례에 가장 적합한 옵션을 결정합니다.

자세한 내용은 관련 설명서를 참조하세요.

| 설명선 제목 | 관련 설명서 |

|---|---|

|

수집을 위해 Azure Data Explorer에서 지원하는 데이터 형식을 참조하세요. |

|

Azure Data Factory 파이프라인에 지원되는 파일 형식을 참조하세요. |

|

기존 스토리지 시스템에서 데이터를 가져오려면 기록 데이터를 Azure Data Explorer로 수집하는 방법을 참조하세요. |

|

Azure Data Explorer 웹 UI에서 로컬 파일, Amazon S3 또는 Azure Storage에서 데이터를 가져올 수 있습니다. |

|

Azure Data Factory와 통합하려면 Azure Data Factory를 사용하여 Azure Data Explorer에 데이터 복사를 참조하세요. |

|

Kusto 클라이언트 라이브러리 는 C#, Python, Java, JavaScript, TypeScript 및 Go에 사용할 수 있습니다. 코드를 작성하여 데이터를 조작한 다음 Kusto 수집 라이브러리를 사용하여 Azure Data Explorer 테이블에 데이터를 수집할 수 있습니다. 데이터는 수집하기 전에 지원되는 형식 중 하나여야 합니다. |

지속적인 데이터 수집

연속 수집은 라이브 데이터에서 즉각적인 인사이트를 요구하는 상황에서 탁월합니다. 예를 들어 지속적인 수집은 모니터링 시스템, 로그 및 이벤트 데이터 및 실시간 분석에 유용합니다.

연속 데이터 수집에는 스트리밍 또는 큐에 대기 중인 수집을 사용하여 수집 파이프라인을 설정하는 작업이 포함됩니다.

스트리밍 수집: 이 메서드는 테이블당 작은 데이터 집합에 대해 거의 실시간으로 대기 시간을 보장합니다. 데이터는 스트리밍 원본에서 마이크로 일괄 처리로 수집되고, 처음에는 행 저장소에 배치된 다음, 열 저장소 익스텐트로 전송됩니다. 자세한 내용은 스트리밍 수집 구성을 참조 하세요.

대기 중인 수집: 이 메서드는 높은 수집 처리량에 최적화되어 있습니다. 데이터는 수집 속성에 따라 일괄 처리되며, 작은 일괄 처리는 빠른 쿼리 결과에 대해 병합되고 최적화됩니다. 기본적으로 대기 중인 최대 값은 5분, 1000개 항목 또는 총 크기 1GB입니다. 대기 중인 수집 명령에 대한 데이터 크기 제한은 6GB입니다. 이 메서드는 재시도 메커니즘을 사용하여 일시적인 오류를 완화하고 '한 번 이상' 메시징 의미 체계를 따라 프로세스에서 메시지가 손실되지 않도록 합니다. 대기 중인 수집에 대한 자세한 내용은 수집 일괄 처리 정책을 참조하세요.

참고 항목

대부분의 시나리오에서는 성능이 더 좋은 옵션이므로 대기 중인 수집을 사용하는 것이 좋습니다.

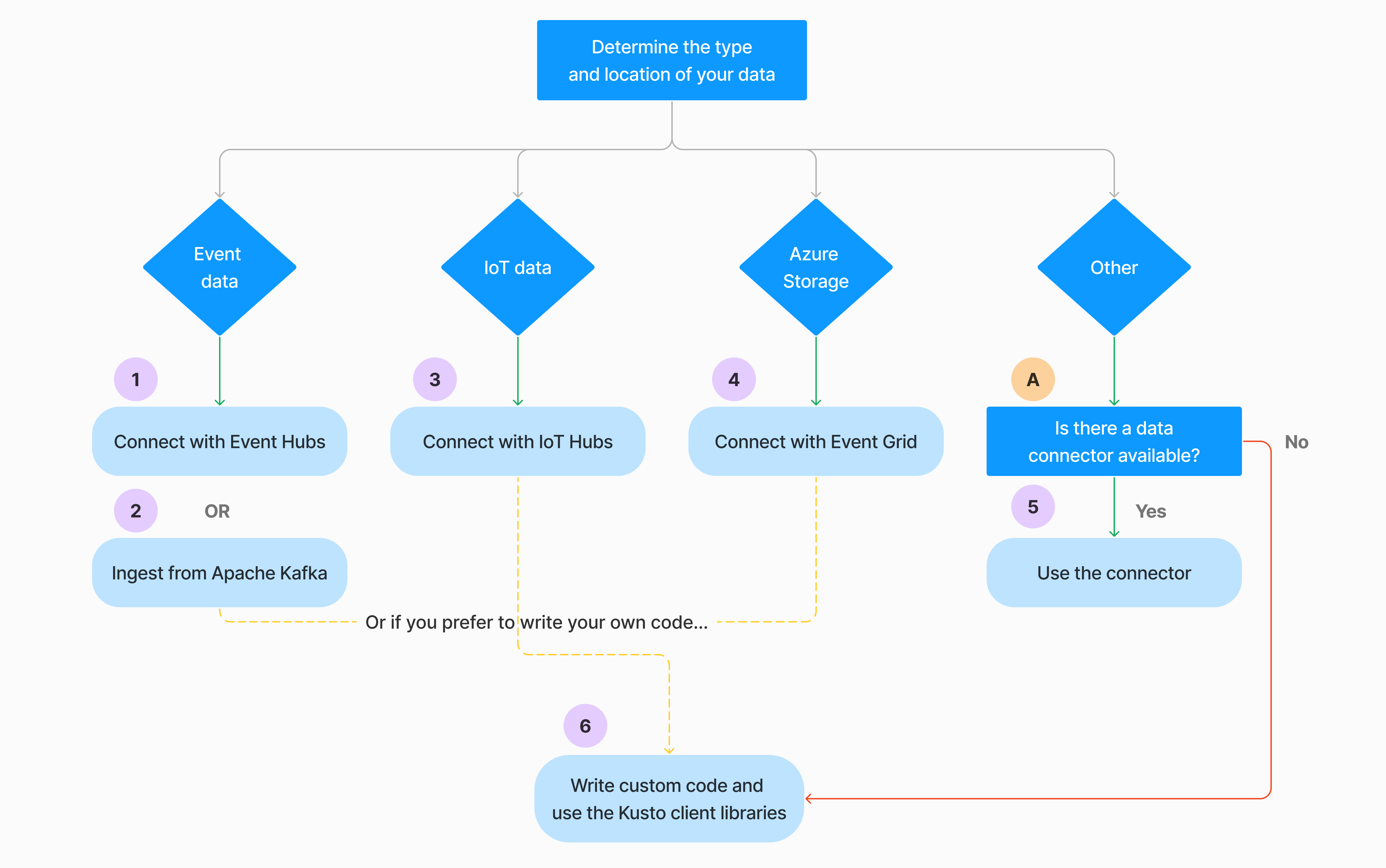

연속 데이터 수집을 구성하는 방법에는 여러 가지가 있습니다. 다음 의사 결정 트리를 사용하여 사용 사례에 가장 적합한 옵션을 결정합니다.

자세한 내용은 관련 설명서를 참조하세요.

| 설명선 제목 | 관련 설명서 |

|---|---|

|

커넥터 목록은 커넥터 개요를 참조하세요. |

|

Event Hubs 데이터 연결을 만듭니다. Event Hubs와 통합하면 제한, 재시도, 모니터링 및 경고와 같은 서비스가 제공됩니다. |

|

실시간 스트리밍 데이터 파이프라인을 빌드하기 위한 분산 스트리밍 플랫폼인 Apache Kafka에서 데이터를 수집합니다. |

|

IoT Hub 데이터 연결을 만듭니다. IoT Hubs와 통합하면 제한, 재시도, 모니터링 및 경고와 같은 서비스를 제공합니다. |

|

Event Grid 데이터 연결을 만듭니다. Event Grid와의 통합은 제한, 재시도, 모니터링 및 경고와 같은 서비스를 제공합니다. |

|

Apache Spark, Apache Kafka, Azure Cosmos DB, Fluent Bit, Logstash, Open Telemetry, Power Automate, Splunk 등과 같은 관련 커넥터에 대한 지침을 참조하세요. 자세한 내용은 커넥터 개요를 참조하세요. |

|

Kusto 클라이언트 라이브러리 는 C#, Python, Java, JavaScript, TypeScript 및 Go에 사용할 수 있습니다. 코드를 작성하여 데이터를 조작한 다음 Kusto 수집 라이브러리를 사용하여 Azure Data Explorer 테이블에 데이터를 수집할 수 있습니다. 데이터는 수집하기 전에 지원되는 형식 중 하나여야 합니다. |

참고 항목

스트리밍 수집은 모든 수집 방법에 대해 지원되지 않습니다. 지원 세부 정보는 설명서에서 특정 수집 방법을 확인하세요.

관리 명령을 사용하여 직접 수집

Azure Data Explorer는 데이터 관리 서비스를 사용하는 대신 클러스터에 직접 데이터를 수집하는 다음 수집 관리 명령을 제공합니다. 프로덕션 또는 대용량 시나리오에서는 사용하지 않고 탐색 및 프로토타입 생성에만 사용해야 합니다.

- 인라인 수집: .ingest 인라인 명령에는 명령 텍스트 자체의 일부로 수집할 데이터가 포함됩니다. 이 방법은 임시 테스트 용도로 사용됩니다.

- 쿼리에서 수집: .set, .append, .set-or-append 또는 .set-or-replace 명령은 쿼리 또는 명령 의 결과로 수집할 데이터를 간접적으로 지정합니다.

- 스토리지에서 수집: .ingest into 명령은 클러스터에서 액세스할 수 있고 명령 이 가리키는 Azure Blob Storage와 같은 외부 스토리지에서 수집할 데이터를 가져옵니다.

참고 항목

오류가 발생할 경우 수집이 다시 수행되고 시도 사이의 대기 시간 동안 지수 백오프 메서드를 사용하여 최대 48시간 동안 다시 시도됩니다.

수집 방법 비교

다음 표에서는 기본 수집 메서드를 비교합니다.

| 수집 이름 | 데이터 형식 | 최대 파일 크기 | 스트리밍, 큐에 대기 중, 직접 | 가장 일반적인 시나리오 | 고려 사항 |

|---|---|---|---|---|---|

| Apache Spark 커넥터 | Spark 환경에서 지원되는 모든 형식 | 제한 없음 | 대기 중 | 기존 파이프라인, 수집 전에 Spark에서 사전 처리, Spark 환경이 지원하는 다양한 소스에서 안전한(Spark) 스트리밍 파이프라인을 만드는 빠른 방법. | Spark 클러스터의 비용을 고려합니다. 일괄 쓰기의 경우 Event Grid에 대한 Azure Data Explorer 데이터 연결과 비교합니다. Spark 스트리밍의 경우 이벤트 허브에 대한 데이터 연결과 비교합니다. |

| ADF(Azure Data Factory) | 지원되는 데이터 형식 | 무제한. ADF 제한을 상속합니다. | 대기 중 또는 ADF 트리거당 | Excel 및 XML과 같이 지원되지 않는 형식을 지원하며, 90개가 넘는 원본에서 온-클라우드로 큰 파일을 복사할 수 있습니다. | 이 메서드는 데이터가 수집될 때까지 상대적으로 더 많은 시간이 걸립니다. ADF는 모든 데이터를 메모리에 업로드한 다음, 수집을 시작합니다. |

| Event Grid | 지원되는 데이터 형식 | 1GB 미압축 | 대기 중 | Azure 스토리지에서 지속적으로 수집, Azure 스토리지의 외부 데이터 | 수집은 Blob 이름 바꾸기 또는 Blob 만들기 작업에 의해 트리거될 수 있습니다. |

| Event Hub | 지원되는 데이터 형식 | 해당 없음 | 큐에 대기 중, 스트리밍 | 메시지, 이벤트 | |

| 데이터 환경 가져오기 | *SV, JSON | 1GB 미압축 | 큐에 대기 중 또는 직접 수집 | 일회성, 테이블 스키마 만들기, Event Grid를 사용한 연속 수집 정의, 컨테이너를 통한 대량 수집(최대 5,000개의 Blob, 기록 수집 사용 시 제한 없음) | |

| IoT Hub | 지원되는 데이터 형식 | 해당 없음 | 큐에 대기 중, 스트리밍 | IoT 메시지, IoT 이벤트, IoT 속성 | |

| Kafka 커넥터 | Avro, ApacheAvro, JSON, CSV, Parquet 및 ORC | 무제한. Java 제한을 상속합니다. | 큐에 대기 중, 스트리밍 | 기존 파이프라인, 소스에서 대량 소비. | 기본 설정은 여러 생산자 또는 소비자 서비스의 기존 사용 또는 원하는 서비스 관리 수준에 따라 결정될 수 있습니다. |

| Kusto 클라이언트 라이브러리 | 지원되는 데이터 형식 | 1GB 미압축 | 큐에 대기 중, 스트리밍, 직접 | 조직의 요구 사항에 맞게 사용자 고유의 코드 작성 | 프로그래밍 방식 수집은 수집 프로세스 중 및 그 후에 스토리지 트랜잭션을 최소화하여 COG(수집 비용)를 줄이는 데 최적화되어 있습니다. |

| LightIngest | 지원되는 데이터 형식 | 1GB 미압축 | 큐에 대기 중 또는 직접 수집 | 데이터 마이그레이션, 조정된 수집 타임스탬프가 있는 기록 데이터, 대량 수집 | 대/소문자 구분 및 공간 구분 |

| 논리 앱 | 지원되는 데이터 형식 | 1GB 미압축 | 대기 중 | 파이프라인을 자동화하는 데 사용됩니다. | |

| LogStash | JSON | 무제한. Java 제한을 상속합니다. | 대기 중 | 기존 파이프라인은 입력에서 대량 소비를 위해 Logstash의 완성도 높은 오픈 소스 특성을 사용합니다. | 기본 설정은 여러 생산자 또는 소비자 서비스의 기존 사용 또는 원하는 서비스 관리 수준에 따라 결정될 수 있습니다. |

| Power Automate | 지원되는 데이터 형식 | 1GB 미압축 | 대기 중 | 수집 명령은 흐름의 일부입니다. 파이프라인을 자동화하는 데 사용됩니다. |

다른 커넥터에 대한 자세한 내용은 커넥터 개요를 참조하세요.

사용 권한

다음 목록에서는 다양한 수집 시나리오에 필요한 사용 권한을 설명합니다.

- 새 테이블을 만들려면 데이터베이스 사용자 이상의 권한이 필요합니다.

- 스키마를 변경하지 않고 기존 테이블로 데이터를 수집하려면 데이터베이스 수집기 이상의 권한이 필요합니다.

- 기존 테이블의 스키마를 변경하려면 적어도 테이블 관리자 또는 데이터베이스 관리자 권한이 필요합니다.

자세한 내용은 Kusto 역할 기반 액세스 제어를 참조하세요.

수집 프로세스

다음 단계에서는 일반 수집 프로세스를 간략하게 설명합니다.

일괄 처리 정책 설정(선택 사항): 데이터는 수집 일괄 처리 정책에 따라 일괄 처리됩니다. 지침은 처리량 최적화를 참조 하세요.

보존 정책 설정(선택 사항): 데이터베이스 보존 정책이 요구 사항에 적합하지 않은 경우 테이블 수준에서 재정의합니다. 자세한 정보는 보존 정책을 참조하세요.

테이블 만들기: 데이터 가져오기 환경을 사용하는 경우 수집 흐름의 일부로 테이블을 만들 수 있습니다. 그렇지 않으면 Azure Data Explorer 웹 UI 또는 .create table 명령을 사용하여 수집하기 전에 테이블을 만듭니다.

스키마 매핑 만들기: 스키마 매핑은 원본 데이터 필드를 대상 테이블 열에 바인딩하는 데 도움이 됩니다. CSV, JSON 및 AVRO와 같은 행 지향 형식 및 Parquet과 같은 열 지향 형식을 포함하여 다양한 유형의 매핑이 지원됩니다. 대부분의 메서드에서 매핑은 테이블에서 미리 작성될 수도 있습니다.

업데이트 정책 설정(선택 사항): Parquet, JSON 및 Avro와 같은 특정 데이터 형식을 사용하면 간단한 수집 시간 변환이 가능합니다. 수집 중에 더 복잡한 처리를 위해 업데이트 정책을 사용합니다. 이 정책은 원래 테이블 내에서 수집된 데이터에 대한 추출 및 변환을 자동으로 실행한 다음 수정된 데이터를 하나 이상의 대상 테이블로 수집합니다.

데이터 수집: 원하는 수집 도구, 커넥터 또는 메서드를 사용하여 데이터를 가져옵니다.