비고

패브릭 런타임 2.0은 현재 실험적 미리 보기 단계에 있습니다. 자세한 내용은 제한 사항 및 참고 사항을 참조하세요.

패브릭 런타임은 Microsoft Fabric 에코시스템 내에서 원활한 통합을 제공하여 Apache Spark에서 제공하는 데이터 엔지니어링 및 데이터 과학 프로젝트를 위한 강력한 환경을 제공합니다.

이 문서에서는 Microsoft Fabric의 빅 데이터 계산을 위해 설계된 최신 런타임인 Fabric Runtime 2.0 실험적(미리 보기)을 소개합니다. 이 릴리스를 확장 가능한 분석 및 고급 워크로드를 위한 중요한 단계로 만드는 주요 기능 및 구성 요소를 강조 표시합니다.

Fabric Runtime 2.0은 데이터 처리 기능을 향상시키기 위해 설계된 다음 구성 요소 및 업그레이드를 통합합니다.

- Apache Spark 4.0

- 운영 체제: Azure Linux 3.0(Mariner 3.0)

- Java: 21

- Scala: 2.13

- Python: 3.12

- 델타 레이크: 4.0

런타임 2.0 사용

작업 영역 수준 또는 환경 항목 수준에서 런타임 2.0을 사용하도록 설정할 수 있습니다. 작업 영역 설정을 사용하여 작업 영역의 모든 Spark 워크로드에 대한 기본값으로 런타임 2.0을 적용합니다. 대안적으로, 런타임 2.0을 사용하는 환경 항목을 만들어 특정 노트북 또는 스파크 작업 정의와 함께 사용하고, 이를 통해 작업 영역 기본값을 재정의합니다.

작업 영역 설정에서 런타임 2.0 사용

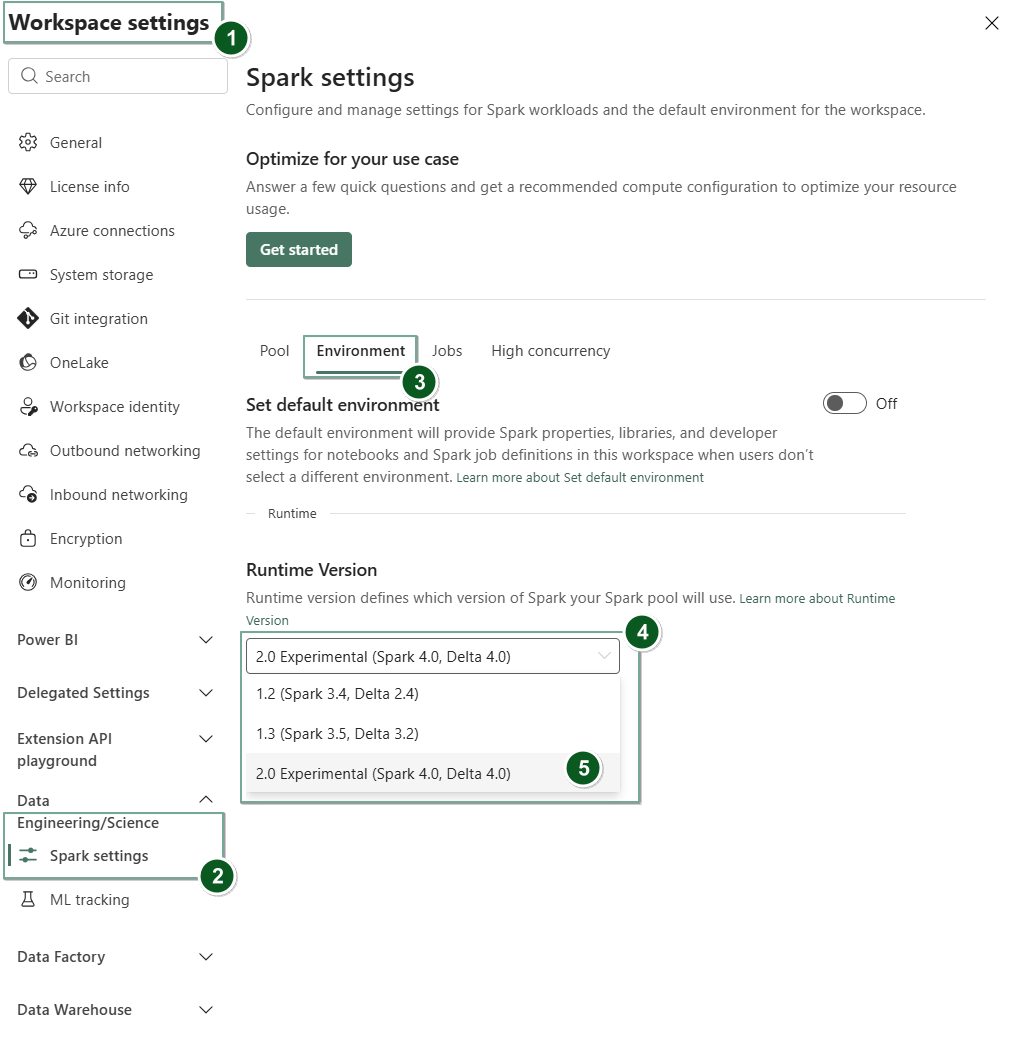

런타임 2.0을 전체 작업 영역의 기본값으로 설정하려면 다음을 수행합니다.

Fabric 작업 영역 내의 작업 영역 설정 탭으로 이동합니다.

데이터 엔지니어링/과학 탭으로 이동하여 Spark 설정을 선택합니다.

환경 탭을 선택합니다.

런타임 버전 드롭다운에서 2.0 실험적(Spark 4.0, Delta 4.0)을 선택하고 변경 내용을 저장합니다. 이 작업은 런타임 2.0을 작업 영역의 기본 런타임으로 설정합니다.

환경 항목에서 런타임 2.0 사용

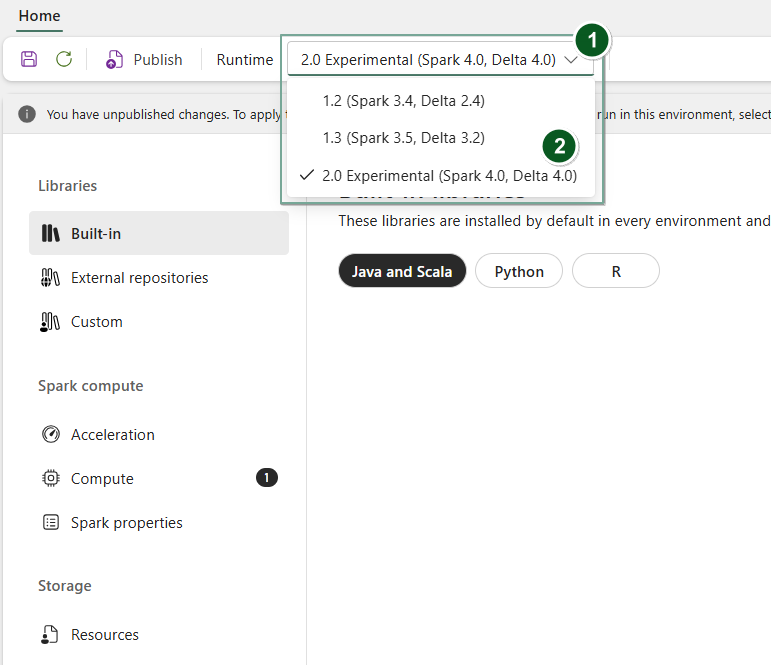

특정 Notebook 또는 Spark 작업 정의와 함께 런타임 2.0을 사용하려면 다음을 수행합니다.

새 환경 항목을 만들거나 기존 환경 항목을 엽니다.

런타임 드롭다운에서 2.0 실험적(Spark 4.0, 델타 4.0)

Save및Publish변경 내용을 선택합니다.중요합니다

시작 풀이 초기 실험 릴리스의 일부가 아니기 때문에 Spark 2.0 세션을 시작하는 데 약 2-5분이 걸릴 수 있습니다.

다음으로, 또는

Notebook항목을 사용자와 함께 사용할 수 있습니다.

이제 패브릭 런타임 2.0(Spark 4.0 및 Delta Lake 4.0)에 도입된 최신 개선 사항 및 기능 실험을 시작할 수 있습니다.

실험적 공개 미리 보기

Fabric 런타임 2.0 실험 미리 보기 단계는 Spark 4.0 및 Delta Lake 4.0 모두에서 새로운 기능 및 API에 대한 초기 액세스를 제공합니다. 미리 보기를 사용하면 최신 Spark 기반의 향상된 기능을 즉시 사용할 수 있으므로 최신 Java, Scala 및 Python 버전과 같은 향후 변경 내용을 원활하게 준비 및 전환할 수 있습니다.

팁 (조언)

최신 정보, 자세한 변경 내용 목록 및 Fabric 런타임에 대한 특정 릴리스 정보는 Spark 런타임 릴리스 및 업데이트를 확인하고 구독 합니다.

제한 사항 및 참고 사항

패브릭 런타임 2.0은 현재 사용자가 개발 또는 테스트 환경에서 Spark 및 Delta Lake의 최신 기능 및 API를 탐색하고 실험할 수 있도록 설계된 실험적 공개 미리 보기 단계에 있습니다. 이 버전은 핵심 기능에 대한 액세스를 제공하지만 다음과 같은 특정 제한 사항이 있습니다.

Spark 4.0 세션을 사용하고, Notebook에서 코드를 작성하고, Spark 작업 정의를 예약하고, PySpark, Scala 및 Spark SQL에서 사용할 수 있습니다. 그러나 R 언어는 이 초기 릴리스에서 지원되지 않습니다.

pip 및 conda를 사용하여 코드에 직접 라이브러리를 설치할 수 있습니다. Notebook 및 SJD(Spark 작업 정의)의 %%configure 옵션을 통해 Spark 설정을 설정할 수 있습니다.

Delta Lake 4.0을 사용하여 Lakehouse에 읽고 쓸 수 있지만 V-order, 네이티브 Parquet 쓰기, 자동 압축, 쓰기 최적화, 낮은 셔플 병합, 병합, 스키마 진화 및 시간 여행과 같은 일부 고급 기능은 이 초기 릴리스에 포함되지 않습니다.

Spark Advisor는 현재 사용할 수 없습니다. 그러나 Spark UI 및 로그와 같은 모니터링 도구는 이 초기 릴리스에서 지원됩니다.

Kusto, SQL Analytics, Cosmos DB 및 MySQL Java Connector를 비롯한 코필로트 및 커넥터를 포함한 데이터 과학 통합과 같은 기능은 현재 이 초기 릴리스에서 지원되지 않습니다. 데이터 과학 라이브러리는 PySpark 환경에서 지원되지 않습니다. PySpark는 추가 라이브러리 없이 PySpark만 포함하는 기본 Conda 설정에서만 작동합니다.

환경 항목 및 Visual Studio Code와의 통합은 이 초기 릴리스에서 지원되지 않습니다.

WASB 또는 ABFS 프로토콜을 사용하여 GPv2(범용 v2) Azure Storage 계정에 데이터를 읽고 쓰는 것은 지원되지 않습니다.

비고

Ideas 플랫폼에서 Fabric 런타임에 대한 피드백을 공유합니다. 참조하는 버전 및 릴리스 단계를 반드시 언급해야 합니다. 커뮤니티 피드백을 소중히 여기고 투표에 따라 개선의 우선 순위를 지정하여 사용자 요구를 충족하는지 확인합니다.

주요 하이라이트

Apache Spark 4.0

Apache Spark 4.0은 4.x 시리즈의 첫 번째 릴리스로 중요한 이정표를 세우며 활기찬 오픈 소스 커뮤니티의 공동 노력을 구현합니다.

이 버전에서 Spark SQL은 VARIANT 데이터 형식 지원, SQL 사용자 정의 함수, 세션 변수, 파이프 구문 및 문자열 데이터 정렬과 같은 SQL 워크로드의 표현력과 다양성을 향상하도록 설계된 강력한 새 기능으로 크게 보강되었습니다. PySpark는 기능적 폭과 전체 개발자 환경 모두에 대한 지속적인 헌신을 통해 네이티브 그리기 API, 새로운 Python 데이터 원본 API, Python UTF 지원 및 PySpark UDF에 대한 통합 프로파일링과 다양한 다른 향상된 기능을 제공합니다. 구조적 스트리밍은 보다 유연한 상태 관리를 위한 임의 상태 API v2 및 더 쉬운 디버깅을 위한 상태 데이터 원본을 도입하는 등 더 큰 제어와 디버깅의 용이성을 제공하는 주요 추가 기능으로 발전합니다.

여기에서 전체 목록 및 자세한 변경 내용을 https://spark.apache.org/releases/spark-release-4-0-0.html에서 확인할 수 있습니다.

비고

Spark 4.0에서는 SparkR이 더 이상 사용되지 않으며 이후 버전에서 제거될 수 있습니다.

Delta Lake 4.0

Delta Lake 4.0은 Delta Lake를 형식 간에 상호 운용 가능하고, 작업하기 쉽고, 성능이 향상되도록 하기 위한 공동의 노력을 표시합니다. Delta 4.0은 오픈 데이터 레이크하우스의 미래를 위한 강력한 새로운 기능, 성능 최적화 및 기본적인 향상된 기능으로 가득찬 마일스톤 릴리스입니다.

여기에서 Delta Lake 3.3 및 4.0에 도입된 전체 목록 및 자세한 변경 내용을 확인할 수 있습니다 https://github.com/delta-io/delta/releases/tag/v3.3.0. https://github.com/delta-io/delta/releases/tag/v4.0.0;

중요합니다

Delta Lake 4.0 특정 기능은 실험적이며 Notebook 및 Spark 작업 정의와 같은 Spark 환경에서만 작동합니다. 여러 Microsoft Fabric 워크로드에서 동일한 Delta Lake 테이블을 사용해야 하는 경우 이러한 기능을 사용하도록 설정하지 마세요. 모든 Microsoft Fabric 환경에서 호환되는 프로토콜 버전 및 기능에 대해 자세히 알아보려면 Delta Lake 테이블 형식 상호 운용성을 참조하세요.