Microsoft Foundry on Windows은 Copilot+ PC에서 항상 로컬 및 백그라운드에서 실행되는 여러 AI 지원 기능과 APIs을 제공합니다.

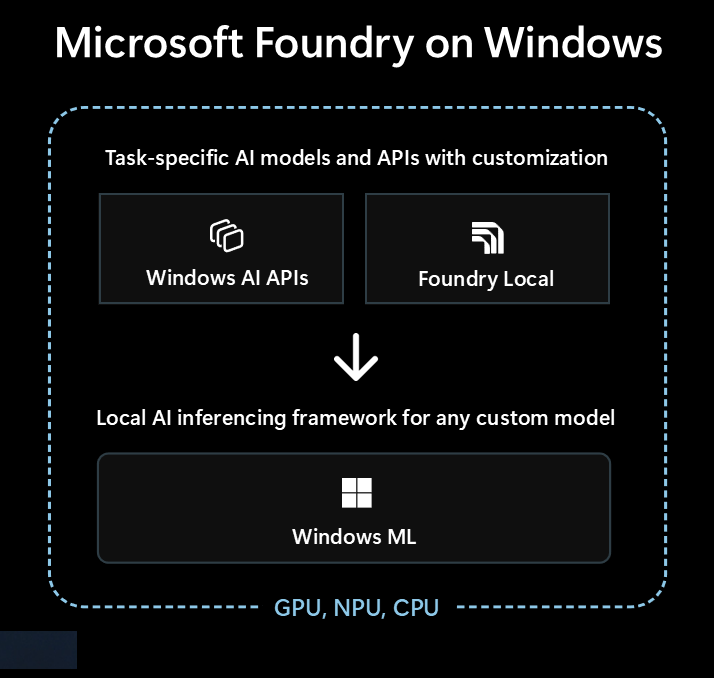

Microsoft Foundry on Windows 에는 고유한 AI 환경을 지원하는 몇 가지 구성 요소가 포함되어 있습니다.

Windows AI APIs: 기본 제공 Windows AI APIs 를 사용하여 AI 서비스를 Windows 앱에 통합합니다. 여기에는 다음이 포함됩니다 APIs .

- Phi Silica: 즉시 사용할 수 있는 로컬 언어 모델입니다.

- 언어 모델 사용자 지정: LoRA(낮은 순위 적응)를 사용하여 Phi Silica 모델을 미세 조정합니다.

- 이미징: 이미지 크기 조정 및 선명화(이미지 슈퍼 해상도), 이미지를 설명하는 텍스트 생성(이미지 설명), 이미지 내의 개체 식별(이미지 구분), 이미지에서 개체 제거(개체 지우기), 프롬프트 텍스트에서 이미지 생성(이미지 생성)

- VSR(비디오 초해상도): 저해상도 비디오 스트림을 스케일 업스케일합니다.

- 텍스트 인텔리전스: 이미지 내에서 텍스트를 검색 및 추출하고 머신에서 읽을 수 있는 문자 스트림()Text Recognition으로 변환하고, 프롬프트 응답의 형식을 정형 테이블 형식으로 지정하고, 프롬프트 텍스트와 대화를 요약하고, 프롬프트 텍스트를 다시 작성하여 선명도, 가독성 및 톤(또는 스타일)을 최적화합니다.

- 앱 콘텐츠 검색: 앱 내 콘텐츠를 인덱싱하여 키워드 또는 의미 체계를 기준으로 검색할 수 있도록 하고 로컬 또는 클라우드 기반 LLM(대규모 언어 모델)에 대한 로컬 RAG(검색 증강 세대) 파이프라인 및 디바이스 기술 자료를 빌드합니다.

Foundry Local: 앱에 활용하고 끌어올 수 있는 인기 있는 OSS 모델

Windows ML: 고유한 ONNX 모델을 사용하여 AI 추론을 사용하도록 설정

개발자 도구: AI 기능을 성공적으로 빌드하는 데 도움이 되는 Visual Studio AI Toolkit 및 AI 개발자 갤러리 와 같은 도구

Windows 앱에서 AI를 어떻게 사용할 수 있나요?

Windows 앱이 ML(Machine Learning) 모델을 활용하여 AI로 기능 및 사용자 환경을 향상시킬 수 있는 몇 가지 방법은 다음과 같습니다.

- 앱은 생성 AI 모델을 사용하여 복잡한 항목을 이해하여 요약, 다시 작성, 보고 또는 확장할 수 있습니다.

- 앱은 자유 형식 콘텐츠를 앱이 이해할 수 있는 구조화된 형식으로 변환하는 모델을 사용할 수 있습니다.

- 앱은 의미상 콘텐츠를 검색하고 관련 콘텐츠를 빠르게 찾을 수 있는 의미 체계 검색 모델을 사용할 수 있습니다.

- 앱은 자연어 처리 모델을 사용하여 복잡한 자연어 요구 사항을 추론하고 사용자의 요청을 수행하기 위한 작업을 계획하고 실행할 수 있습니다.

- 앱은 이미지 조작 모델을 사용하여 이미지를 지능적으로 수정하거나, 주제를 지우거나 추가하거나, 스케일링하거나, 새 콘텐츠를 생성할 수 있습니다.

- 앱은 예측 진단 모델을 사용하여 문제를 식별하고 예측하고 사용자를 안내하거나 이를 수행할 수 있습니다.

Windows AI APIs 사용 및 사용자 고유의 모델 가져오기

Windows AI 사용 APIs

로컬 AI 모델이 올바른 솔루션인 경우 Windows AI APIs 를 사용하여 Copilot+ PC의 사용자를 위한 AI 서비스를 통합할 수 있습니다. 이러한 APIs 기능은 PC에 기본 제공되며 상대적으로 오버헤드가 적은 고유한 AI 기반 기능을 사용하도록 설정합니다.

고유한 모델 학습

TensorFlow 또는 PyTorch같은 플랫폼에서 고유한 프라이빗 데이터를 사용하여 고유한 모델을 학습할 수 있는 기능이 있는 경우. Visual Studio Code용 ONNX Runtime 및 AI Toolkit 사용하여 디바이스 하드웨어에서 로컬로 실행하여 해당 사용자 지정 모델을 Windows 애플리케이션에 통합할 수 있습니다.

Visual Studio CodeAI Toolkit는 AI 모델을 로컬에서 다운로드하고 실행할 수 있게 해주는 VS Code 확장 프로그램으로, 하드웨어 가속을 통해 성능을 향상시키고 DirectML을 통해 규모를 확장할 수 있습니다. AI Tookit은 다음을 수행할 수도 있습니다.

- 직관적인 플레이그라운드 또는 REST API를 사용하여 애플리케이션에서 모델을 테스트합니다.

- 로컬 또는 클라우드(가상 머신)에서 AI 모델을 미세 조정하여 새 기술을 만들고 응답의 안정성을 개선하며 응답의 톤과 형식을 설정합니다.

- Phi-3 및 Mistral같은 인기 있는 SLLM(작은 언어 모델)을 미세 조정합니다.

- 클라우드 또는 디바이스에서 실행되는 애플리케이션을 사용하여 AI 기능을 배포합니다.

- DirectML을 사용하여 AI 기능을 사용하여 성능 향상을 위해 하드웨어 가속을 활용합니다. DirectML은 Windows 디바이스 하드웨어가 디바이스 GPU 또는 NPU를 사용하여 ML 모델의 성능을 가속화할 수 있도록 하는 하위 수준 API입니다. DirectML을 ONNX Runtime 페어링하는 것은 일반적으로 개발자가 대규모로 사용자에게 하드웨어 가속 AI를 가져오는 가장 간단한 방법입니다. 자세한 정보: DirectML 개요.

- 모델 변환 기능을 사용하여 NPU에서 사용할 모델 수량화 및 유효성 검사

또한 이러한 모델 미세 조정 개념 조사하여 데이터에 더 잘 맞게 미리 학습된 모델을 조정할 수도 있습니다.

클라우드 AI 모델 사용

로컬 AI 기능을 사용하는 것이 올바른 경로가 아닌 경우 클라우드 AI 모델 및 리소스를 사용하는 것이 솔루션이 될 수 있습니다.

기타 AI 기능

- Windows의 앱 작업: 소비자에게 새롭고 고유한 AI 기능을 사용하도록 설정하는 앱에 대한 작업 만들기

책임 있는 AI 관행 사용

Windows 앱에 AI 기능을 통합할 때마다 Windows 지침에서 책임 있는 생성 AI 애플리케이션 및 기능 개발 따라 매우 권장할 있습니다.