Prisscenario ved hjelp av Dataflyt gen2 for å laste inn 2 GB parquetdata til en Lakehouse-tabell

I dette scenarioet ble Dataflow Gen2 brukt til å laste inn 2 GB parquetdata lagret i Azure Data Lake Storage (ADLS) Gen2 til en Lakehouse-tabell i Microsoft Fabric. Vi brukte NYC Taxi-grønne eksempeldata for Parquet-dataene.

Prisene som brukes i eksemplet nedenfor, er hypotetiske og har ikke til hensikt å antyde nøyaktig faktiske priser. Dette er bare for å demonstrere hvordan du kan beregne, planlegge og administrere kostnader for Data Factory-prosjekter i Microsoft Fabric. Siden stoffkapasiteten er priset unikt på tvers av områder, bruker vi prissettingen for en Fabric-kapasitet på US West 2 (et typisk Azure-område) på USD 0,18 per CU per time. Se her til Microsoft Fabric – Priser for å utforske andre prisalternativer for fabric-kapasitet.

Konfigurasjon

Hvis du vil utføre dette scenarioet, må du opprette en dataflyt med følgende fremgangsmåte:

- Initialiser dataflyt: Hent 2 GB Parquet-filer fra ADLS Gen2-lagringskonto.

- Konfigurer Power Query:

- Gå til Power Query.

- Kontroller at alternativet for oppsamling av spørringen er aktivert.

- Fortsett for å kombinere parquet-filene.

- Datatransformasjon:

- Hev topptekster for klarhet.

- Fjern unødvendige kolonner.

- Juster kolonnedatatyper etter behov.

- Definer mål for utdata:

- Konfigurer Lakehouse som mål for datautdata.

- I dette eksemplet ble et Lakehouse i Fabric opprettet og benyttet.

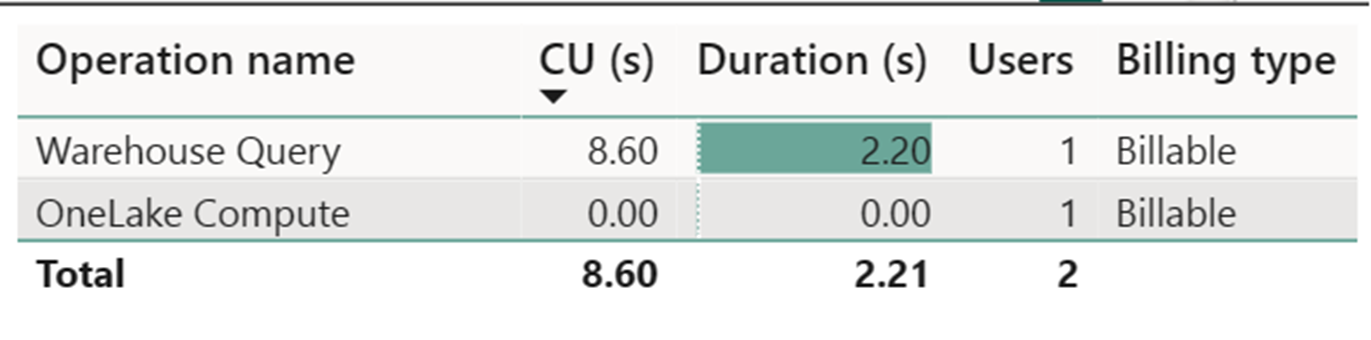

Kostnadsberegning ved hjelp av Fabric Metrics App

Dataflytdatabehandlingsmåleren med høy skala registrerte ubetydelig aktivitet. Standard beregningsmåler for oppdateringsoperasjoner for dataflyt gen2 bruker 112 098,540 databehandlingsenheter (CUer). Det er viktig å tenke på at andre operasjoner, inkludert Lagerspørring, SQL Endpoint Query og Oppdatering av datasett ved behov, utgjør detaljerte aspekter ved implementering av Dataflyt Gen2 som for øyeblikket er gjennomsiktige og nødvendige for sine respektive operasjoner. Disse operasjonene skjules imidlertid i fremtidige oppdateringer og bør ignoreres ved beregning av kostnader for Dataflyt gen2.

Merk

Selv om den rapporteres som en metrikkverdi, er ikke den faktiske varigheten av kjøringen relevant når du beregner de effektive CU-timene med Fabric Metrics App siden CU-sekunders måleverdien den også rapporterer allerede står for varigheten.

| Metric | Standard Compute | Høyskala databehandling |

|---|---|---|

| Totalt antall CU-sekunder | 112 098,54 CU sekunder | 0 CU sekunder |

| Effektive CU-timer fakturert | 112 098,54 / (60*60) = 31,14 CU-timer | 0 / (60*60) = 0 CU timer |

Totale kjørekostnader på KR 0,18/CU-time = (31,14 CU-timer) * ($0,18/CU-time) ~= KR 59,00

Relatert innhold

Tilbakemeldinger

Kommer snart: Gjennom 2024 faser vi ut GitHub Issues som tilbakemeldingsmekanisme for innhold, og erstatter det med et nytt system for tilbakemeldinger. Hvis du vil ha mer informasjon, kan du se: https://aka.ms/ContentUserFeedback.

Send inn og vis tilbakemelding for