Obs!

Tilgang til denne siden krever autorisasjon. Du kan prøve å logge på eller endre kataloger.

Tilgang til denne siden krever autorisasjon. Du kan prøve å endre kataloger.

Data Wrangler, et notatblokkbasert verktøy for utforskende dataanalyse, støtter nå både Spark DataFrames og pandas DataFrames. Den genererer PySpark-kode, i tillegg til Python-kode. Hvis du vil ha en generell oversikt over Data Wrangler, som dekker hvordan du utforsker og transformerer Pandas DataFrames, kan du gå til hovedopplæringen. Denne opplæringen viser hvordan du bruker Data Wrangler til å utforske og transformere Spark DataFrames.

Forutsetning

Få et Microsoft Fabric-abonnement. Eller registrer deg for en gratis prøveversjon av Microsoft Fabric.

Logg på Microsoft Fabric.

Bruk opplevelsesbryteren nederst til venstre på hjemmesiden for å bytte til Fabric.

Begrensninger

- Egendefinerte kodeoperasjoner støttes for øyeblikket bare for pandas DataFrames.

- Data Wrangler-skjermen fungerer best på store skjermer, selv om du kan minimere eller skjule ulike deler av grensesnittet for å få plass til mindre skjermer.

Starte Data Wrangler med en Spark DataFrame

Brukere kan åpne Spark DataFrames i Data Wrangler direkte fra en Microsoft Fabric-notatblokk, ved å navigere til den samme rullegardinlisten der pandas DataFrames vises. En liste over aktive Spark DataFrames vises i rullegardinlisten under listen over aktive pandavariabler.

Denne kodesnutten oppretter en Spark DataFrame med de samme eksempeldataene som brukes i pandas Data Wrangler-opplæringen:

import pandas as pd

# Read a CSV into a Spark DataFrame

sdf = spark.createDataFrame(pd.read_csv("https://raw.githubusercontent.com/plotly/datasets/master/titanic.csv"))

display(sdf)

Bruk rullegardinlisten Data Wrangler til å bla gjennom aktive DataFrames som er tilgjengelige for redigering, på notatblokkbåndets Hjem-fane. Velg den du vil åpne i Data Wrangler.

Tips

Data-Wrangler kan ikke åpnes mens notatblokkkjernen er opptatt. En kjørende celle må fullføre kjøringen før Data Wrangler kan starte, som vist i dette skjermbildet:

Velge egendefinerte eksempler

Data Wrangler konverterer automatisk Spark DataFrames til pandas-eksempler av ytelsesårsaker. All kode som verktøyet genererer, oversettes imidlertid til PySpark når det eksporteres tilbake til notatblokken. Som med alle pandaer i DataFrame, kan du tilpasse standardeksempelet. Hvis du vil åpne et egendefinert eksempel på en aktiv DataFrame med Data Wrangler, velger du «Velg egendefinert eksempel» fra rullegardinlisten, som vist i dette skjermbildet:

Dette starter et popup-vindu med alternativer for å angi størrelsen på det ønskede eksemplet (antall rader) og samplingsmetoden (første poster, siste poster eller et tilfeldig sett), som vist i dette skjermbildet:

Vise sammendragsstatistikk

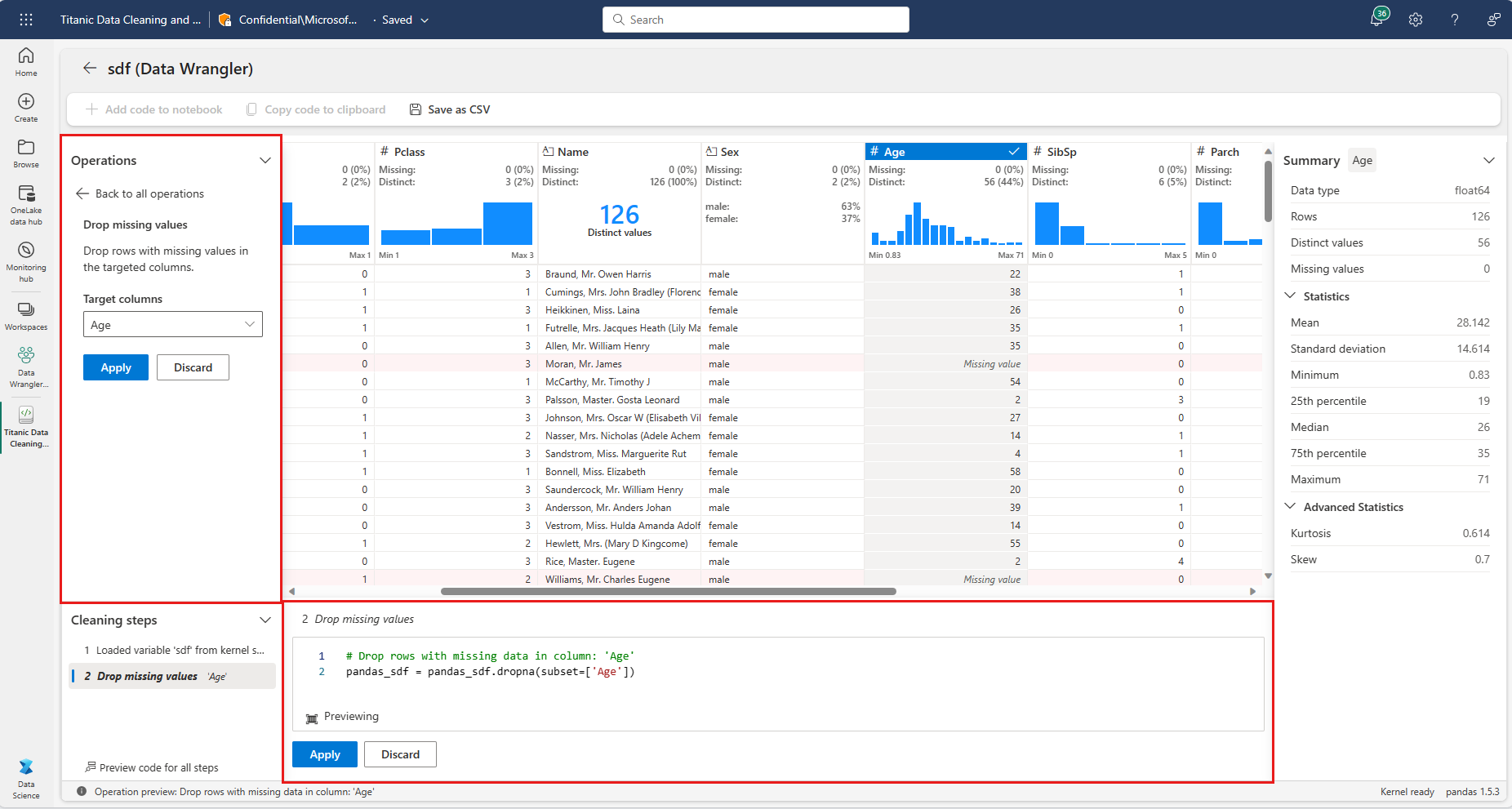

Når Data Wrangler lastes inn, vises et informasjonsbanner over forhåndsvisningsrutenettet. Dette banneret forklarer at Spark DataFrames konverteres midlertidig til pandas-eksempler, men all generert kode konverteres til PySpark. Tidligere er det ikke annerledes å bruke Data Wrangler på Spark DataFrames enn å bruke det på pandas DataFrames. En beskrivende oversikt i Sammendrag-panelet viser informasjon om eksemplets dimensjoner, manglende verdier og mer. Valg av en kolonne i Data Wrangler-rutenettet ber Sammendrag-panelet om å oppdatere og vise beskrivende statistikk om den bestemte kolonnen. Rask innsikt om hver kolonne er også tilgjengelig i toppteksten.

Tips

Kolonnespesifikk statistikk og visualobjekter (både i Sammendrag-panelet og i kolonneoverskriftene) avhenger av kolonnedatatypen. Et binned histogram for en numerisk kolonne vises for eksempel bare i kolonneoverskriften hvis kolonnen er avgitt som en numerisk type, som vist i dette skjermbildet:

Bla gjennom datarengjøringsoperasjoner

Du finner en søkbar liste over trinn for datarengjøring i «Operasjoner»-panelet. I «Operasjoner»-panelet ber valg av et datarengjøringstrinn deg om å angi en målkolonne eller kolonner, sammen med eventuelle nødvendige parametere for å fullføre trinnet. For eksempel krever ledeteksten for numerisk skalering av en kolonne et nytt verdiområde, som vist i dette skjermbildet:

Tips

Du kan bruke et mindre utvalg av operasjoner fra menyen i hver kolonneoverskrift, som vist i dette skjermbildet:

Forhåndsvise og bruke operasjoner

Data Wrangler-visningsrutenettet forhåndsviser automatisk resultatene av en valgt operasjon, og den tilsvarende koden vises automatisk i panelet under rutenettet. Hvis du vil utføre den forhåndsviste koden, velger du Bruk på begge steder. Hvis du vil slette den forhåndsviste koden og prøve en ny operasjon, velger du «Forkast» som vist i dette skjermbildet:

Når en operasjon er brukt, viser data-Wrangler-rutenettet og sammendragsstatistikken oppdatering for å gjenspeile resultatene. Koden vises i den løpende listen over forpliktede operasjoner, plassert i panelet «Rengjøringstrinn», som vist i dette skjermbildet:

Tips

Du kan alltid angre det sist brukte trinnet. I panelet «Rengjøringstrinn» vises et papirkurvikon hvis du holder markøren over det siste brukte trinnet, som vist i dette skjermbildet:

Denne tabellen oppsummerer operasjonene som Data Wrangler for øyeblikket støtter:

| Operasjon | Beskrivelse |

|---|---|

| Sorter | Sortere en kolonne i stigende eller synkende rekkefølge |

| Filter | Filtrere rader basert på én eller flere betingelser |

| En-hot kode | Opprett nye kolonner for hver unike verdi i en eksisterende kolonne, som angir tilstedeværelse eller fravær av disse verdiene per rad |

| En-hot kode med skilletegn | Del og en-hot kode kategoriske data ved hjelp av et skilletegn |

| Endre kolonnetype | Endre datatypen for en kolonne |

| Slipp kolonne | Slette én eller flere kolonner |

| Velg kolonne | Velg én eller flere kolonner du vil beholde, og slett resten |

| Gi nytt navn til kolonne | Gi nytt navn til en kolonne |

| Slipp manglende verdier | Fjerne rader med manglende verdier |

| Slipp dupliserte rader | Slipp alle rader som har dupliserte verdier i én eller flere kolonner |

| Fyll manglende verdier | Erstatt celler med manglende verdier med en ny verdi |

| Søk etter og erstatt | Erstatt celler med et nøyaktig samsvarende mønster |

| Grupper etter kolonne og aggreger | Grupper etter kolonneverdier og aggreger resultater |

| Stripe mellomrom | Fjerne mellomrom fra begynnelsen og slutten av teksten |

| Dele tekst | Dele en kolonne i flere kolonner basert på et brukerdefinert skilletegn |

| Konvertere tekst til små bokstaver | Konvertere tekst til små bokstaver |

| Konvertere tekst til store bokstaver | Konvertere tekst til STORE BOKSTAVER |

| Skaler min/maks.verdier | Skalere en numerisk kolonne mellom en minimums- og maksimumsverdi |

| Rask utfylling | Opprett automatisk en ny kolonne basert på eksempler avledet fra en eksisterende kolonne |

Endre visningen

Når som helst kan du tilpasse grensesnittet med «Visninger»-fanen på verktøylinjen som er plassert over visningsrutenettet for Data Wrangler. Dette kan skjule eller vise forskjellige ruter basert på innstillinger og skjermstørrelse, som vist i dette skjermbildet:

Lagre og eksportere kode

Verktøylinjen over visningsrutenettet for Data Wrangler inneholder alternativer for å lagre den genererte koden. Du kan kopiere koden til utklippstavlen eller eksportere den til notatblokken som en funksjon. For Spark DataFrames oversettes all koden som genereres på pandas-eksemplet, til PySpark før den lander tilbake i notatblokken. Før Data Wrangler lukkes, viser verktøyet en forhåndsvisning av den oversatte PySpark-koden, og den gir også et alternativ for å eksportere den mellomliggende pandakoden.

Tips

Data Wrangler genererer kode som bare brukes når du kjører den nye cellen manuelt, og den vil ikke overskrive den opprinnelige DataFrame, som vist i dette skjermbildet:

Koden konverteres til PySpark, som vist i dette skjermbildet:

Deretter kan du kjøre den eksporterte koden, som vist i dette skjermbildet:

Relatert innhold

- Hvis du vil ha en oversikt over Data Wrangler, kan du gå til denne hjelpeartikkelen

- Hvis du vil prøve Data Wrangler i Visual Studio Code, går du til Data Wrangler i VS Code

- Gikk vi glipp av en funksjon du trenger? Gi oss beskjed! Foreslå det på Fabric Ideas-forumet