Integrer OneLake med Azure Synapse Analytics

Azure Synapse er en ubegrenset analysetjeneste der bedriftsdatalagring og stordataanalyse er samlet. Denne opplæringen viser hvordan du kobler til OneLake ved hjelp av Azure Synapse Analytics.

Skrive data fra Synapse ved hjelp av Apache Spark

Følg disse trinnene for å bruke Apache Spark til å skrive eksempeldata til OneLake fra Azure Synapse Analytics.

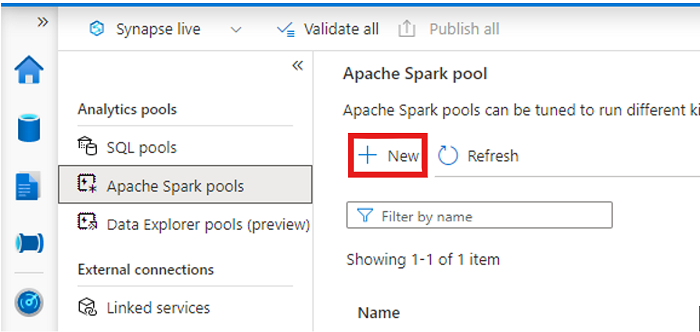

Åpne Synapse-arbeidsområdet, og opprett et Apache Spark-utvalg med dine foretrukne parametere.

Opprett en ny Apache Spark-notatblokk.

Åpne notatblokken, angi språket til PySpark (Python) og koble det til det nyopprettede Spark-utvalget.

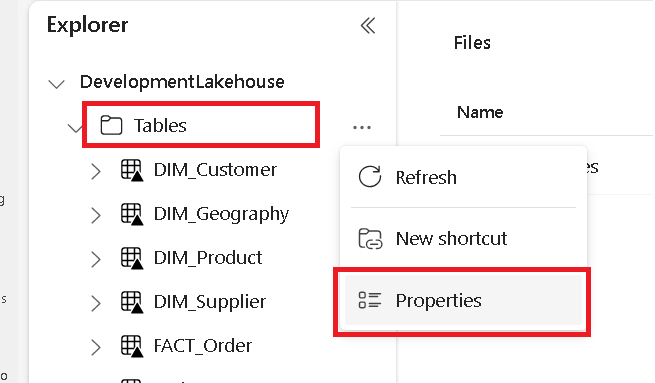

Gå til Microsoft Fabric Lakehouse i en egen fane, og finn tabellmappen på øverste nivå.

Høyreklikk tabellmappen, og velg Egenskaper.

Kopier ABFS-banen fra egenskapsruten.

Tilbake i Azure Synapse-notatblokken, i den første nye kodecellen, gir du lakehouse-banen. Dette lakehouse er der dataene er skrevet senere. Kjør cellen.

# Replace the path below with the ABFS path to your lakehouse Tables folder. oneLakePath = 'abfss://WorkspaceName@onelake.dfs.fabric.microsoft.com/LakehouseName.lakehouse/Tables'Last inn data fra et Azure-åpent datasett i en ny kodecelle i en ny kodecelle. Dette datasettet er det du laster inn i lakehouse. Kjør cellen.

yellowTaxiDf = spark.read.parquet('wasbs://nyctlc@azureopendatastorage.blob.core.windows.net/yellow/puYear=2018/puMonth=2/*.parquet') display(yellowTaxiDf.limit(10))Filtrer, transformer eller klargjør dataene i en ny kodecelle. I dette scenarioet kan du trimme ned datasettet for raskere innlasting, bli med i andre datasett eller filtrere ned til bestemte resultater. Kjør cellen.

filteredTaxiDf = yellowTaxiDf.where(yellowTaxiDf.tripDistance>2).where(yellowTaxiDf.passengerCount==1) display(filteredTaxiDf.limit(10))Skriv den filtrerte datarammen i en ny kodecelle ved hjelp av OneLake-banen til et nytt Delta-Parquet-bord i Fabric Lakehouse. Kjør cellen.

filteredTaxiDf.write.format("delta").mode("overwrite").save(oneLakePath + '/Taxi/')Til slutt, i en ny kodecelle, kan du teste at dataene ble skrevet ved å lese den nylig lastede filen fra OneLake. Kjør cellen.

lakehouseRead = spark.read.format('delta').load(oneLakePath + '/Taxi/') display(lakehouseRead.limit(10))

Gratulerer. Nå kan du lese og skrive data i OneLake ved hjelp av Apache Spark i Azure Synapse Analytics.

Lese data fra Synapse ved hjelp av SQL

Følg disse trinnene for å bruke SQL serverless til å lese data fra OneLake fra Azure Synapse Analytics.

Åpne et fabric lakehouse og identifiser en tabell som du vil spørre fra Synapse.

Høyreklikk på tabellen, og velg Egenskaper.

Kopier ABFS-banen for tabellen.

Åpne Synapse-arbeidsområdet i Synapse Studio.

Opprett et nytt SQL-skript.

Skriv inn følgende spørring i redigeringsprogrammet for SQL-spørring, og erstatt

ABFS_PATH_HEREmed banen du kopierte tidligere.SELECT TOP 10 * FROM OPENROWSET( BULK 'ABFS_PATH_HERE', FORMAT = 'delta') as rows;Kjør spørringen for å vise de ti øverste radene i tabellen.

Gratulerer. Nå kan du lese data fra OneLake ved hjelp av SQL serverless i Azure Synapse Analytics.