Merk

Tilgang til denne siden krever autorisasjon. Du kan prøve å logge på eller endre kataloger.

Tilgang til denne siden krever autorisasjon. Du kan prøve å endre kataloger.

Denne artikkelen forklarer prompter og prompt-utvikling som nøkkelkonsepter for å hjelpe deg med å lage kraftige generative AI-funksjoner som kan brukes i Copilot Studio.

Viktig!

- Prompts bruker modeller drevet av Azure Foundry.

- Denne funksjonen kan være underlagt bruksbegrensninger eller kapasitetsbegrensning.

Forutsetninger

- Miljøet er på listen over tilgjengelige områder.

- Du trenger copilot-kreditter.

- Microsoft Dataverse er installert i miljøet.

Hva er en prompt

En prompt består hovedsakelig av en naturlig språkundervisning som forteller en generativ AI-modell å utføre en oppgave. Modellen følger spørringen for å bestemme strukturen og innholdet i teksten den må generere. Spørringsteknikk er prosessen med å lage og avgrense spørringen som brukes av modellen.

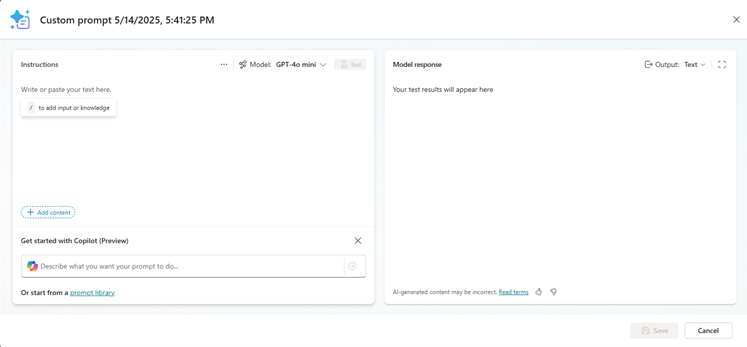

En promptbyggeropplevelse lar skapere bygge, teste og lagre gjenbrukbare prompter. I denne erfaringen kan du også bruke inputvariabler og kunnskapsdata for å gi dynamiske kontekstdata under kjøring. Du kan dele disse promptene med andre og bruke dem som agenter, arbeidsflyter eller apper.

Disse spørringene kan brukes til mange oppgaver eller forretningsscenarioer, for eksempel oppsummering av innhold, kategorisering av data, utpakking av enheter, oversette språk, vurdere sentiment eller formulere et svar på en kommentar. For eksempel kan du lage en prompt for å plukke ut handlingspunkter fra bedriftens e-poster og bruke den i en Power Automate-arbeidsflyt for å bygge en automatisering av e-postbehandling.

I Copilot Studio kan prompts brukes som agentverktøy for å forbedre chatopplevelsen eller muliggjøre avanserte AI-automatiseringer eller arbeidsflytnoder for å integrere AI-handlinger i deterministiske automatiseringer.

Menneskelig oversikt

Menneskelig tilsyn er et viktig steg når man arbeider med innhold generert fra en generativ AI-modell. Slike modeller trenes på enorme mengder data og kan inneholde feil og skjevheter. Et menneske bør se gjennom det før du publiserer det på nettet, sender det til en kunde eller baserer en forretningsbeslutning på det. Menneskelig tilsyn hjelper deg å identifisere potensielle feil og skjevheter. Det sørger også for at innholdet er relevant for det tiltenkte brukstilfellet og samsvarer med selskapets verdier.

En gjennomgang av mennesker kan også bidra til å identifisere eventuelle problemer med selve modellen. Hvis modellen for eksempel genererer innhold som ikke er relevant for det tiltenkte brukstilfellet, kan det hende at du må justere spørsmålet.

Ansvarlig kunstig intelligens

Vi går inn for å skape ansvarlig KI i form av design. Vårt arbeid styres av et kjernesett med prinsipper: rettferdighet, pålitelighet og sikkerhet, personvern og sikkerhet, fortrolighet, fortrolighet og ansvarlighet. Vi setter disse prinsippene ut i praksis over hele selskapet for å utvikle og distribuere kunstig intelligens som har en positiv innvirkning på samfunnet. Vi har en omfattende tilnærming som kombinerer nyskapende forskning, enestående teknikk og ansvarlig styring. Ved siden av OpenAI sin ledende forskning på KI-justering, fremmer vi et rammeverk for sikker distribusjon av vår egen KI-teknologi som har som mål å hjelpe bransjen med å komme i gang med mer ansvarlige resultater.

Lær mer om åpenhet i Transparency Note for Azure OpenAI.