Notitie

Voor toegang tot deze pagina is autorisatie vereist. U kunt proberen u aan te melden of de directory te wijzigen.

Voor toegang tot deze pagina is autorisatie vereist. U kunt proberen de mappen te wijzigen.

Van toepassing op: Alle API Management-lagen

In dit artikel leest u hoe u een OpenAI-compatibele Google Gemini-API importeert voor toegang tot modellen zoals gemini-2.0-flash. Voor deze modellen kan Azure API Management een eindpunt voor voltooiing van een openAI-compatibele chat beheren.

Meer informatie over het beheren van AI-API's in API Management:

Vereiste voorwaarden

- Een bestaand API Management-exemplaar. Maak er een als u dat nog niet hebt gedaan.

- Een API-sleutel voor de Gemini-API. Als u er nog geen hebt, maakt u deze in Google AI Studio en slaat u deze op een veilige locatie op.

Een OpenAI-compatibele Gemini-API importeren met behulp van de portal

Blader in Azure Portal naar uw API Management-exemplaar.

Selecteer in het linkermenu onder API'sAPI's, >.

Selecteer onder Een nieuwe API definiërende taalmodel-API.

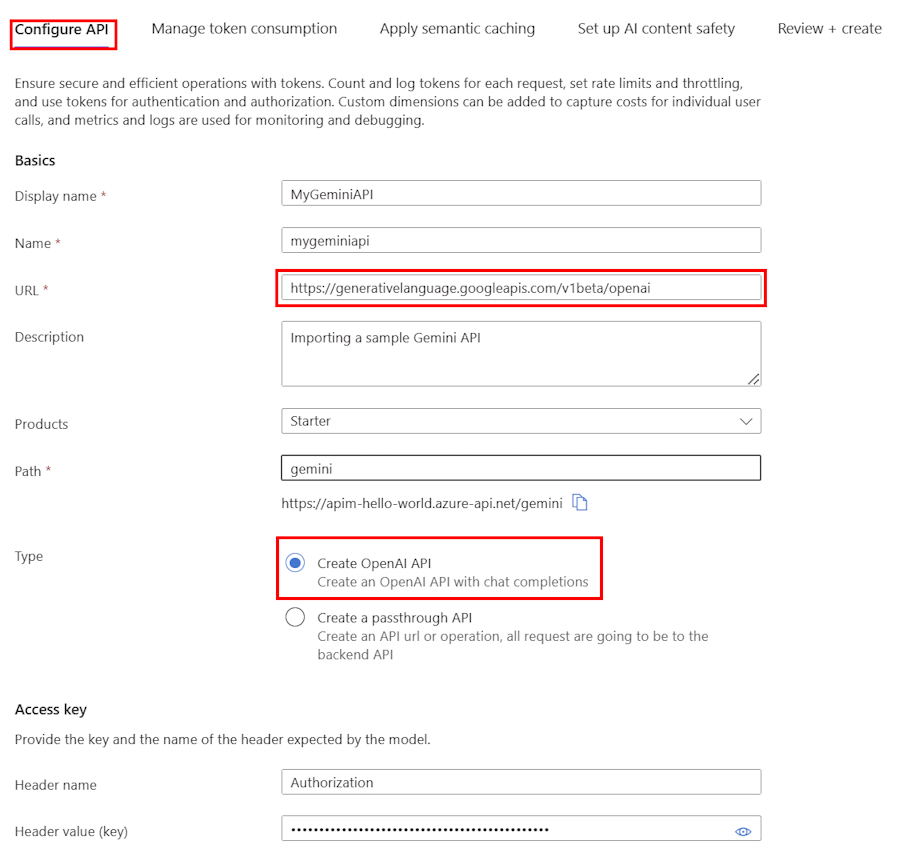

Op het tabblad API configureren :

Voer een weergavenaam en een optionele beschrijving voor de API in.

Voer in de URL de volgende basis-URL in uit de compatibiliteitsdocumentatie van Gemini OpenAI:

https://generativelanguage.googleapis.com/v1beta/openaiVoeg in Pad een pad toe dat uw API Management-exemplaar gebruikt om aanvragen naar de Gemini-API-eindpunten te routeren.

Selecteer Bij TypeopenAI-API maken.

Voer in Access-sleutel het volgende in:

- Headernaam: Autorisatie.

-

Headerwaarde (sleutel):

Bearergevolgd door uw API-sleutel voor de Gemini-API.

Configureer op de resterende tabbladen eventueel beleidsregels voor het beheren van tokenverbruik, semantische caching en beveiliging van AI-inhoud. Zie Een taalmodel-API importeren voor meer informatie.

Selecteer Beoordelen.

Nadat de instellingen zijn gevalideerd, selecteert u Maken.

API Management maakt de API en configureert het volgende:

- Een back-endresource en een set-backend-servicebeleid waarmee API-aanvragen worden doorgestuurd naar het Google Gemini-eindpunt.

- Toegang tot de LLM-back-end met behulp van de Gemini-API-sleutel die u hebt opgegeven. De sleutel wordt beveiligd als een geheim benoemde waarde in API Management.

- (optioneel) Beleidsregels waarmee u de API kunt bewaken en beheren.

Gemini-model testen

Nadat u de API hebt geïmporteerd, kunt u het eindpunt voor voltooiing van de chat testen voor de API.

Selecteer de API die u in de vorige stap hebt gemaakt.

Selecteer het tabblad Testen.

Selecteer de

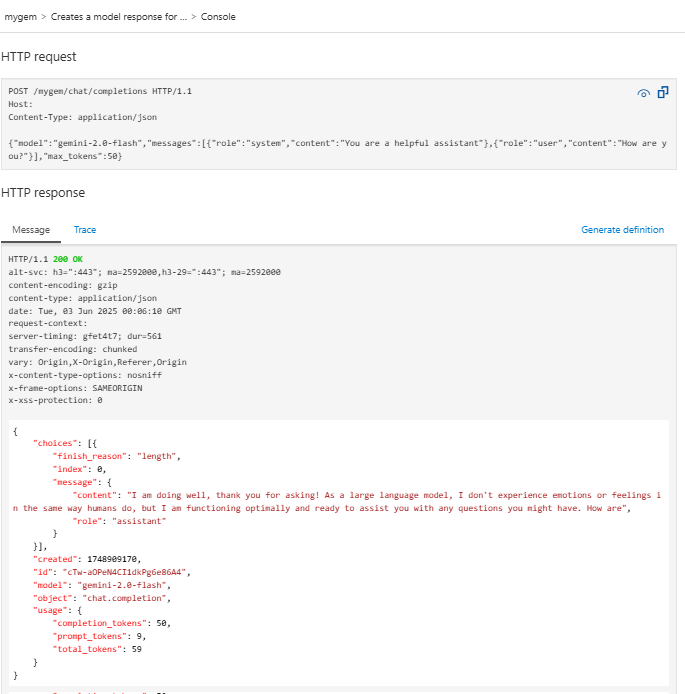

POST Creates a model response for the given chat conversationbewerking. Dit is eenPOSTaanvraag voor het/chat/completionseindpunt.Voer in de sectie Aanvraagtekst de volgende JSON in om het model en een voorbeeldprompt op te geven. In dit voorbeeld wordt het

gemini-2.0-flashmodel gebruikt.{ "model": "gemini-2.0-flash", "messages": [ { "role": "system", "content": "You are a helpful assistant" }, { "role": "user", "content": "How are you?" } ], "max_tokens": 50 }Wanneer de test is geslaagd, reageert de back-end met een geslaagde HTTP-antwoordcode en enkele gegevens. Toegevoegd aan het antwoord zijn tokengebruiksgegevens om u te helpen bij het bewaken en beheren van het tokenverbruik van uw taalmodel.