Tracering en logboekregistratie van gebeurtenissen voor uw Azure Data Box- en Azure Data Box Heavy-importorder

Een Data Box- of Data Box Heavy-importorder doorloopt de volgende stappen: volgorde, instellen, kopiëren van gegevens, retourneren, uploaden naar Azure en controleren en gegevensverwijdering. Overeenkomstig elke stap in de volgorde kunt u meerdere acties uitvoeren om de toegang tot de order te beheren, de gebeurtenissen te controleren, de volgorde bij te houden en de verschillende logboeken te interpreteren die worden gegenereerd.

De volgende tabel bevat een overzicht van elke stap bij het verwerken van een importorder en de hulpprogramma's die beschikbaar zijn om de order tijdens de stap bij te houden en te controleren.

| Importorderfase van Data Box | Hulpprogramma voor het bijhouden en controleren van |

|---|---|

| Order maken | Toegangsbeheer instellen op de bestelling via Azure RBAC |

| Order verwerkt | De bestelling volgen via

|

| Apparaat instellen | Toegang tot apparaatreferenties die zijn vastgelegd in activiteitenlogboeken |

| Gegevens kopiëren naar apparaat | Error.xml-bestanden weergeven voor het kopiëren van gegevens |

| Voorbereiding voor verzending | Controleer de BOM-bestanden of de manifestbestanden op het apparaat |

| Uploaden van gegevens naar Azure | Kopieerlogboeken controleren op fouten tijdens het uploaden van gegevens in Het Azure-datacenter |

| Gegevensverwijdering van apparaat | Keten van bewakingslogboeken weergeven, inclusief auditlogboeken en bestelgeschiedenis |

In dit artikel worden de verschillende mechanismen of hulpprogramma's beschreven die beschikbaar zijn voor het bijhouden en controleren van data box- of Data Box Heavy-importorders. De informatie in dit artikel is van toepassing op zowel Data Box- als Data Box Heavy-importorders. In de volgende secties zijn alle verwijzingen naar Data Box ook van toepassing op Data Box Heavy.

Notitie

Als firewallregels zijn ingesteld voor het opslagaccount voor uw Data Box, hebt u mogelijk geen toegang tot kopieerlogboeken vanuit Azure Portal met behulp van COPY LOG PATH in het deelvenster Overzicht . Als u toegang wilt krijgen tot de logboeken, wijzigt u de instellingen van de opslagfirewall om het huidige systeem toe te staan of gebruikt u een systeem dat zich in het firewallnetwerk bevindt.

Toegangsbeheer instellen voor de bestelling

U kunt bepalen wie toegang heeft tot uw bestelling wanneer de bestelling voor het eerst wordt gemaakt. Stel Azure-rollen in op verschillende bereiken om de toegang tot de Data Box-bestelling te beheren. Een Azure-rol bepaalt het type toegang: lezen/schrijven, alleen-lezen, lezen/schrijven naar een subset van bewerkingen.

De twee rollen die kunnen worden gedefinieerd voor de Azure Data Box-service zijn:

- Data Box Reader : alleen-lezentoegang hebben tot een order(en) zoals gedefinieerd door het bereik. Ze kunnen alleen details van een bestelling bekijken. Ze hebben geen toegang tot andere gegevens met betrekking tot opslagaccounts of het bewerken van de ordergegevens, zoals adres, enzovoort.

- Data Box-inzender : kan alleen een order maken om gegevens over te dragen naar een bepaald opslagaccount als ze al schrijftoegang hebben tot een opslagaccount. Als ze geen toegang hebben tot een opslagaccount, kunnen ze zelfs geen Data Box-bestelling maken om gegevens naar het account te kopiëren. Deze rol definieert geen machtigingen voor opslagaccounts en verleent geen toegang tot opslagaccounts.

Als u de toegang tot een bestelling wilt beperken, kunt u het volgende doen:

- Wijs een rol toe op orderniveau. De gebruiker heeft alleen die machtigingen zoals gedefinieerd door de rollen om te communiceren met die specifieke Data Box-bestelling en niets anders.

- Wijs een rol toe op het niveau van de resourcegroep. De gebruiker heeft toegang tot alle Data Box-orders binnen een resourcegroep.

Zie Best practices voor Azure RBAC voor meer informatie over het voorgestelde gebruik van Azure RBAC.

De bestelling volgen

U kunt uw bestelling volgen via Azure Portal en via de website van de vervoerder. De volgende mechanismen zijn aanwezig om de Data Box-bestelling op elk gewenst moment bij te houden:

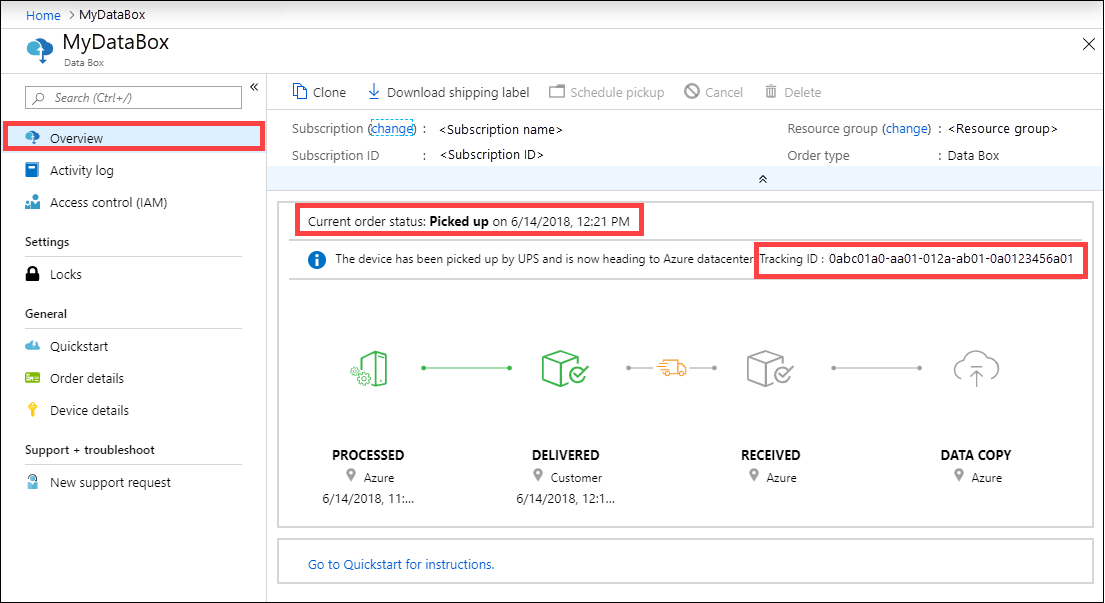

Als u de bestelling wilt bijhouden wanneer het apparaat zich in het Azure-datacenter of uw locatie bevindt, gaat u naar uw Data Box-orderoverzicht > in Azure Portal.

Als u de bestelling wilt bijhouden terwijl het apparaat onderweg is, gaat u naar de website van de regionale vervoerder, bijvoorbeeld de UPS-website in de VS. Geef het traceringsnummer op dat is gekoppeld aan uw bestelling.

Data Box verzendt ook e-mailmeldingen wanneer de orderstatus verandert op basis van de e-mailberichten die zijn opgegeven toen de bestelling werd gemaakt. Zie Orderstatus weergeven voor een lijst met alle Statussen van Data Box-bestellingen. Zie Meldingsgegevens bewerken als u de meldingsinstellingen wilt wijzigen die aan de bestelling zijn gekoppeld.

Queryactiviteitslogboeken tijdens de installatie

Uw Data Box arriveert op uw locatie in een vergrendelde status. U kunt de apparaatreferenties gebruiken die beschikbaar zijn in Azure Portal voor uw bestelling.

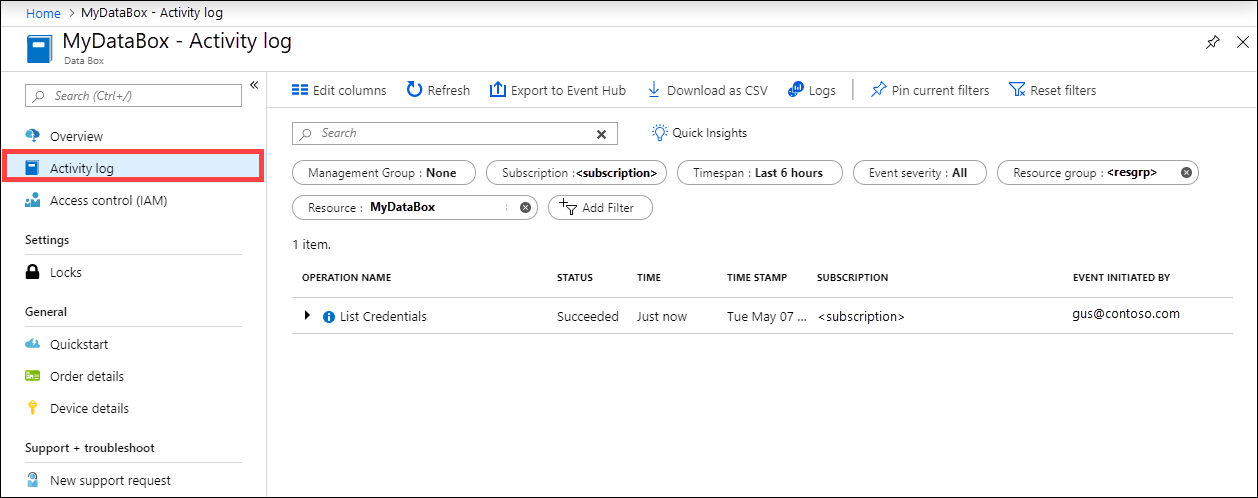

Wanneer een Data Box is ingesteld, moet u mogelijk weten wie toegang heeft tot de apparaatreferenties. Als u wilt weten wie toegang heeft tot de blade Apparaatreferenties , kunt u een query uitvoeren op de activiteitenlogboeken. Elke actie waarbij de blade Referenties voor apparaatgegevens > wordt geopend, wordt als actie aangemeld in de activiteitenlogboeken

ListCredentials.

Elke aanmelding bij de Data Box wordt in realtime geregistreerd. Deze informatie is echter alleen beschikbaar in de auditlogboeken nadat de bestelling is voltooid.

Foutenlogboek weergeven tijdens het kopiëren van gegevens

Tijdens het kopiëren van gegevens naar Data Box of Data Box Heavy wordt een foutbestand gegenereerd als er problemen zijn met de gegevens die worden gekopieerd.

Error.xml bestand

Zorg ervoor dat de kopieertaken zonder fouten zijn voltooid. Als er fouten optreden tijdens het kopieerproces, downloadt u de logboeken op de pagina Verbinding maken en kopiëren.

- Als u een bestand hebt gekopieerd dat niet 512 bytes is uitgelijnd op een beheerde schijfmap in uw Data Box, wordt het bestand niet geüpload als een pagina-blob naar uw faseringsopslagaccount. In de logboeken wordt een fout vermeld. Verwijder het bestand en kopieer een bestand dat 512 bytes is uitgelijnd.

- Als u een VHDX of een dynamische VHD of een differentiërende VHD hebt gekopieerd, ziet u een fout in de logboeken. Deze bestandstypen worden niet ondersteund.

Hier volgt een voorbeeld van de error.xml voor verschillende fouten bij het kopiëren naar beheerde schijven.

<file error="ERROR_BLOB_OR_FILE_TYPE_UNSUPPORTED">\StandardHDD\testvhds\differencing-vhd-022019.vhd</file>

<file error="ERROR_BLOB_OR_FILE_TYPE_UNSUPPORTED">\StandardHDD\testvhds\dynamic-vhd-022019.vhd</file>

<file error="ERROR_BLOB_OR_FILE_TYPE_UNSUPPORTED">\StandardHDD\testvhds\insidefixedvhdx-022019.vhdx</file>

<file error="ERROR_BLOB_OR_FILE_TYPE_UNSUPPORTED">\StandardHDD\testvhds\insidediffvhd-022019.vhd</file>

Hier volgt een voorbeeld van de error.xml voor verschillende fouten bij het kopiëren naar pagina-blobs.

<file error="ERROR_BLOB_OR_FILE_SIZE_ALIGNMENT">\PageBlob512NotAligned\File100Bytes</file>

<file error="ERROR_BLOB_OR_FILE_SIZE_ALIGNMENT">\PageBlob512NotAligned\File786Bytes</file>

<file error="ERROR_BLOB_OR_FILE_SIZE_ALIGNMENT">\PageBlob512NotAligned\File513Bytes</file>

<file error="ERROR_BLOB_OR_FILE_SIZE_ALIGNMENT">\PageBlob512NotAligned\File10Bytes</file>

<file error="ERROR_BLOB_OR_FILE_SIZE_ALIGNMENT">\PageBlob512NotAligned\File500Bytes</file>

Hier volgt een voorbeeld van de error.xml voor verschillende fouten bij het kopiëren naar blok-blobs.

<file error="ERROR_CONTAINER_OR_SHARE_NAME_LENGTH">\ab</file>

<file error="ERROR_CONTAINER_OR_SHARE_NAME_ALPHA_NUMERIC_DASH">\invalid dns name</file>

<file error="ERROR_CONTAINER_OR_SHARE_NAME_LENGTH">\morethan63charactersfortestingmorethan63charactersfortestingmorethan63charactersfortestingmorethan63charactersfortestingmorethan63charactersfortestingmorethan63charactersfortesting</file>

<file error="ERROR_CONTAINER_OR_SHARE_NAME_ALPHA_NUMERIC_DASH">\testdirectory-~!@#$%^&()_+{}</file>

<file error="ERROR_CONTAINER_OR_SHARE_NAME_ALPHA_NUMERIC_DASH">\test__doubleunderscore</file>

<file error="ERROR_CONTAINER_OR_SHARE_NAME_IMPROPER_DASH">\-startingwith-hyphen</file>

<file error="ERROR_CONTAINER_OR_SHARE_NAME_ALPHA_NUMERIC_DASH">\Starting with Capital</file>

<file error="ERROR_CONTAINER_OR_SHARE_NAME_ALPHA_NUMERIC_DASH">\_startingwith_underscore</file>

<file error="ERROR_CONTAINER_OR_SHARE_NAME_IMPROPER_DASH">\55555555--4444--3333--2222--111111111111</file>

<file error="ERROR_CONTAINER_OR_SHARE_NAME_LENGTH">\1</file>

<file error="ERROR_CONTAINER_OR_SHARE_NAME_ALPHA_NUMERIC_DASH">\11111111-_2222-_3333-_4444-_555555555555</file>

<file error="ERROR_CONTAINER_OR_SHARE_NAME_IMPROPER_DASH">\test--doublehyphen</file>

<file error="ERROR_BLOB_OR_FILE_NAME_CHARACTER_ILLEGAL" name_encoding="Base64">XEludmFsaWRVbmljb2RlRmlsZXNcU3BjQ2hhci01NTI5Ni3vv70=</file>

<file error="ERROR_BLOB_OR_FILE_NAME_CHARACTER_ILLEGAL" name_encoding="Base64">XEludmFsaWRVbmljb2RlRmlsZXNcU3BjQ2hhci01NTMwMS3vv70=</file>

<file error="ERROR_BLOB_OR_FILE_NAME_CHARACTER_ILLEGAL" name_encoding="Base64">XEludmFsaWRVbmljb2RlRmlsZXNcU3BjQ2hhci01NTMwMy3vv70=</file>

<file error="ERROR_BLOB_OR_FILE_NAME_CHARACTER_CONTROL">\InvalidUnicodeFiles\Ã.txt</file>

<file error="ERROR_BLOB_OR_FILE_NAME_CHARACTER_ILLEGAL" name_encoding="Base64">XEludmFsaWRVbmljb2RlRmlsZXNcU3BjQ2hhci01NTMwNS3vv70=</file>

<file error="ERROR_BLOB_OR_FILE_NAME_CHARACTER_ILLEGAL" name_encoding="Base64">XEludmFsaWRVbmljb2RlRmlsZXNcU3BjQ2hhci01NTI5OS3vv70=</file>

<file error="ERROR_BLOB_OR_FILE_NAME_CHARACTER_ILLEGAL" name_encoding="Base64">XEludmFsaWRVbmljb2RlRmlsZXNcU3BjQ2hhci01NTMwMi3vv70=</file>

<file error="ERROR_BLOB_OR_FILE_NAME_CHARACTER_ILLEGAL" name_encoding="Base64">XEludmFsaWRVbmljb2RlRmlsZXNcU3BjQ2hhci01NTMwNC3vv70=</file>

<file error="ERROR_BLOB_OR_FILE_NAME_CHARACTER_ILLEGAL" name_encoding="Base64">XEludmFsaWRVbmljb2RlRmlsZXNcU3BjQ2hhci01NTI5OC3vv70=</file>

<file error="ERROR_BLOB_OR_FILE_NAME_CHARACTER_ILLEGAL" name_encoding="Base64">XEludmFsaWRVbmljb2RlRmlsZXNcU3BjQ2hhci01NTMwMC3vv70=</file>

<file error="ERROR_BLOB_OR_FILE_NAME_CHARACTER_ILLEGAL" name_encoding="Base64">XEludmFsaWRVbmljb2RlRmlsZXNcU3BjQ2hhci01NTI5Ny3vv70=</file>

Hier volgt een voorbeeld van de error.xml voor verschillende fouten bij het kopiëren naar Azure Files.

<file error="ERROR_BLOB_OR_FILE_SIZE_LIMIT">\AzFileMorethan1TB\AzFile1.2TB</file>

<file error="ERROR_CONTAINER_OR_SHARE_NAME_ALPHA_NUMERIC_DASH">\testdirectory-~!@#$%^&()_+{}</file>

<file error="ERROR_CONTAINER_OR_SHARE_NAME_IMPROPER_DASH">\55555555--4444--3333--2222--111111111111</file>

<file error="ERROR_CONTAINER_OR_SHARE_NAME_IMPROPER_DASH">\-startingwith-hyphen</file>

<file error="ERROR_CONTAINER_OR_SHARE_NAME_ALPHA_NUMERIC_DASH">\11111111-_2222-_3333-_4444-_555555555555</file>

<file error="ERROR_CONTAINER_OR_SHARE_NAME_IMPROPER_DASH">\test--doublehyphen</file>

<file error="ERROR_CONTAINER_OR_SHARE_NAME_LENGTH">\ab</file>

<file error="ERROR_CONTAINER_OR_SHARE_NAME_ALPHA_NUMERIC_DASH">\invalid dns name</file>

<file error="ERROR_CONTAINER_OR_SHARE_NAME_ALPHA_NUMERIC_DASH">\test__doubleunderscore</file>

<file error="ERROR_CONTAINER_OR_SHARE_NAME_LENGTH">\morethan63charactersfortestingmorethan63charactersfortestingmorethan63charactersfortestingmorethan63charactersfortestingmorethan63charactersfortestingmorethan63charactersfortesting</file>

<file error="ERROR_CONTAINER_OR_SHARE_NAME_ALPHA_NUMERIC_DASH">\_startingwith_underscore</file>

<file error="ERROR_CONTAINER_OR_SHARE_NAME_LENGTH">\1</file>

<file error="ERROR_CONTAINER_OR_SHARE_NAME_ALPHA_NUMERIC_DASH">\Starting with Capital</file>

Los in elk van de bovenstaande gevallen de fouten op voordat u verdergaat met de volgende stap. Voor meer informatie over de fouten die zijn ontvangen tijdens het kopiëren van gegevens naar Data Box via SMB- of NFS-protocollen, gaat u naar Problemen met Data Box en Data Box Heavy oplossen. Voor informatie over fouten die zijn ontvangen tijdens het kopiëren van gegevens naar Data Box via REST, gaat u naar Problemen met Data Box Blob Storage oplossen.

Bom inspecteren tijdens voorbereiding voor verzending

Tijdens de voorbereiding voor verzending wordt een lijst met bestanden gemaakt die bekend staat als de stuklijst (Bill of Materials) of het manifestbestand.

- Gebruik dit bestand om te controleren op basis van de werkelijke namen en het aantal bestanden dat naar de Data Box is gekopieerd.

- Gebruik dit bestand om te controleren op basis van de werkelijke grootte van de bestanden.

- Controleer of de crc64 overeenkomt met een tekenreeks die niet nul is.

Voor meer informatie over de fouten die zijn ontvangen tijdens de voorbereiding voor verzending, gaat u naar Problemen met Data Box en Data Box Heavy oplossen.

BOM- of manifestbestand

Het BOM- of manifestbestand bevat de lijst met alle bestanden die naar het Data Box-apparaat worden gekopieerd. Het BOM-bestand heeft bestandsnamen en bestandsgrootten en de controlesom. Er wordt een afzonderlijk BOM-bestand gemaakt voor de blok-blobs, pagina-blobs, Azure Files, voor kopie via de REST API's en voor de kopie naar beheerde schijven in de Data Box. U kunt de BOM-bestanden downloaden uit de lokale webgebruikersinterface van het apparaat tijdens de voorbereiding voor verzending.

Deze bestanden bevinden zich ook op het Data Box-apparaat en worden geüpload naar het bijbehorende opslagaccount in het Azure-datacenter.

BOM-bestandsindeling

BOM- of manifestbestand heeft de volgende algemene indeling:

<file size = "file-size-in-bytes" crc64="cyclic-redundancy-check-string">\folder-path-on-data-box\name-of-file-copied.md</file>

Hier volgt een voorbeeld van een manifest dat wordt gegenereerd wanneer de gegevens zijn gekopieerd naar de blok-blobshare op de Data Box.

<file size="10923" crc64="0x51c78833c90e4e3f">\databox\media\data-box-deploy-copy-data\connect-shares-file-explorer1.png</file>

<file size="15308" crc64="0x091a8b2c7a3bcf0a">\databox\media\data-box-deploy-copy-data\get-share-credentials2.png</file>

<file size="53486" crc64="0x053da912fb45675f">\databox\media\data-box-deploy-copy-data\nfs-client-access.png</file>

<file size="6093" crc64="0xadb61d0d7c6d4deb">\databox\data-box-cable-options.md</file>

<file size="6499" crc64="0x080add29add367d9">\databox\data-box-deploy-copy-data-via-nfs.md</file>

<file size="11089" crc64="0xc3ce6b13a4fe3001">\databox\data-box-deploy-copy-data-via-rest.md</file>

<file size="7749" crc64="0xd2e346a4588e307a">\databox\data-box-deploy-ordered.md</file>

<file size="14275" crc64="0x260296e5d1b1608a">\databox\data-box-deploy-copy-data.md</file>

<file size="4077" crc64="0x2bb0a170225bceec">\databox\data-box-deploy-picked-up.md</file>

<file size="15447" crc64="0xcec0ca8527720b3c">\databox\data-box-portal-admin.md</file>

<file size="9126" crc64="0x820856b5a54321ad">\databox\data-box-overview.md</file>

<file size="10963" crc64="0x5e9a14f9f4784fd8">\databox\data-box-safety.md</file>

<file size="5941" crc64="0x8631d62fbc038760">\databox\data-box-security.md</file>

<file size="12536" crc64="0x8c8ff93e73d665ec">\databox\data-box-system-requirements-rest.md</file>

<file size="3220" crc64="0x7257a263c434839a">\databox\data-box-system-requirements.md</file>

De stuklijst- of manifestbestanden worden ook gekopieerd naar het Azure-opslagaccount. U kunt de stuklijst- of manifestbestanden gebruiken om te controleren of bestanden die zijn geüpload naar Azure overeenkomen met de gegevens die naar de Data Box zijn gekopieerd.

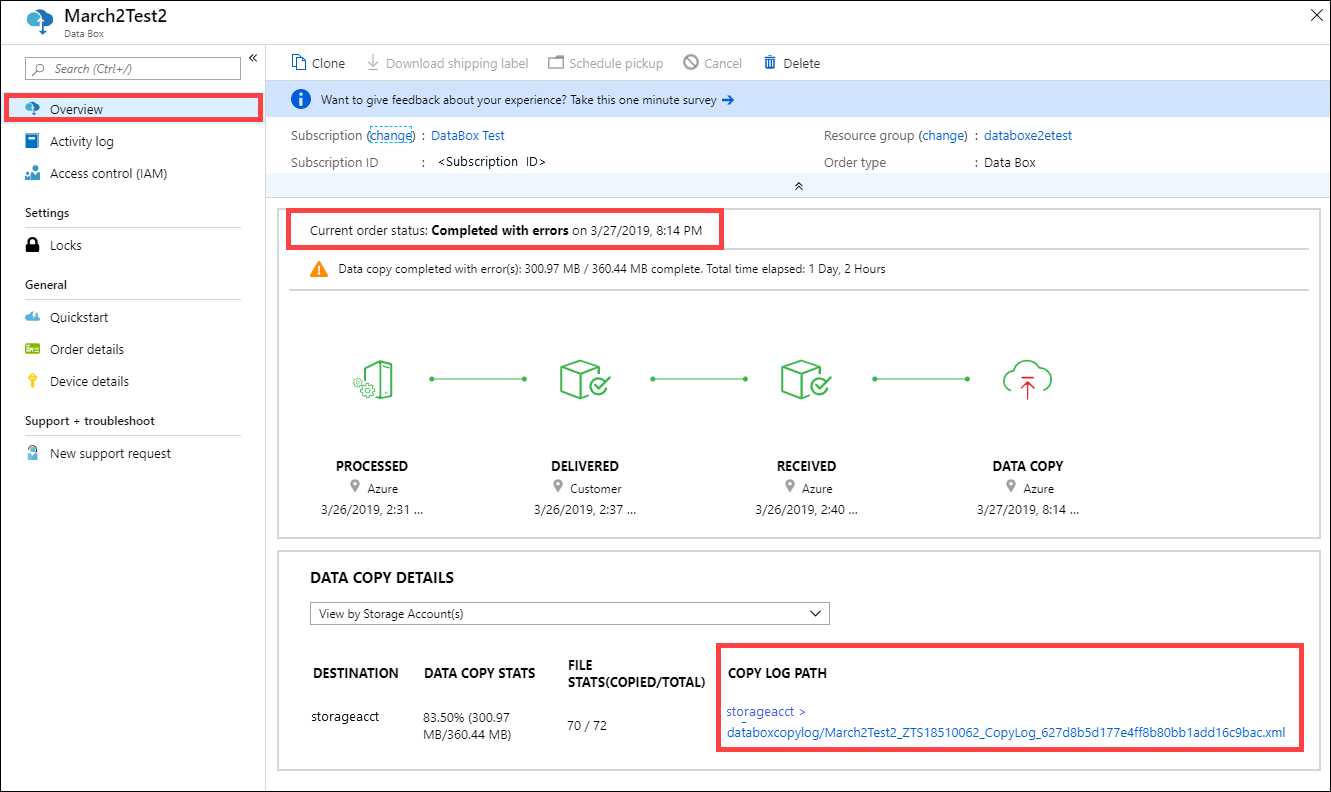

Kopieerlogboek controleren tijdens uploaden naar Azure

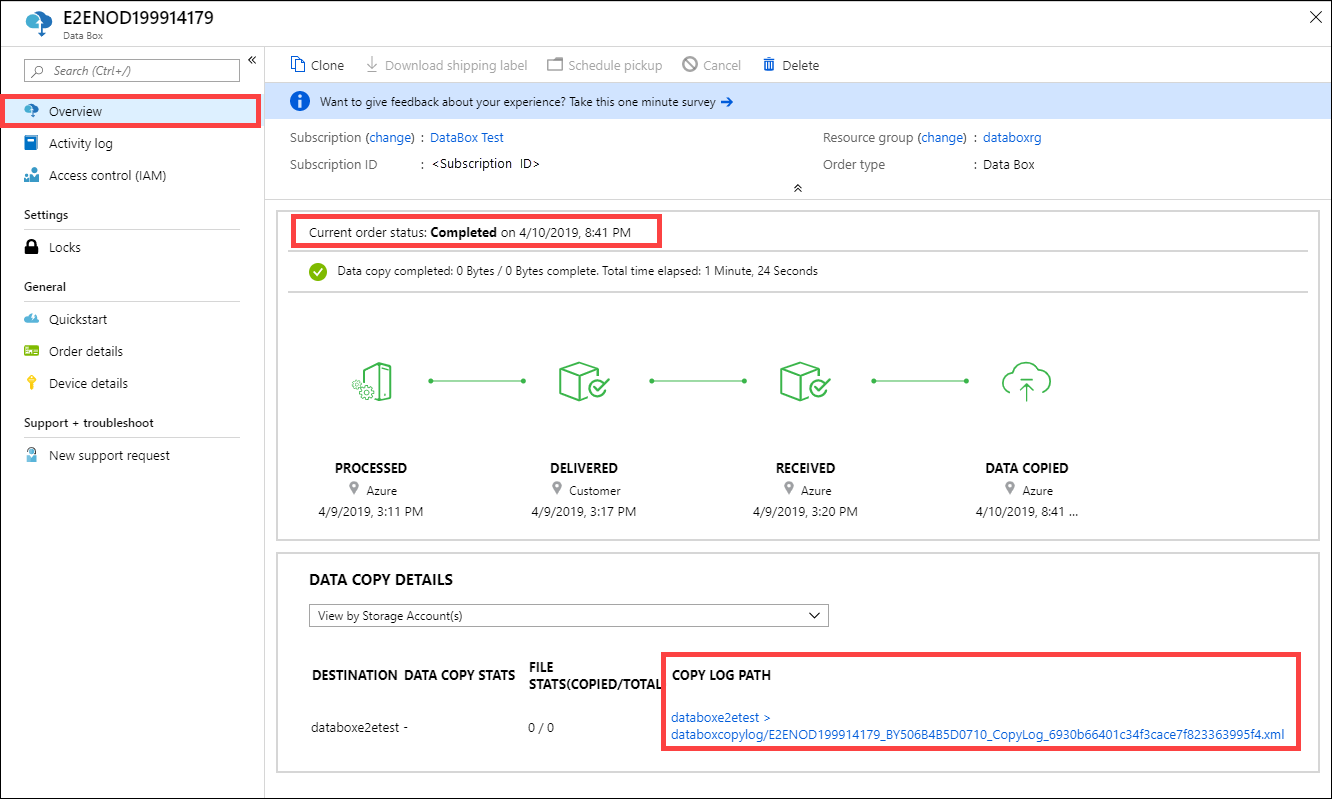

Tijdens het uploaden van gegevens naar Azure wordt een kopielogboek gemaakt.

Logboek kopiëren

Voor elke bestelling die wordt verwerkt, maakt de Data Box-service een kopielogboek in het bijbehorende opslagaccount. Het kopieerlogboek bevat het totale aantal bestanden dat is geüpload en het aantal bestanden dat is opgetreden tijdens het kopiëren van gegevens van Data Box naar uw Azure-opslagaccount.

Notitie

Een CRC-berekening (Cyclic Redundanty Check) wordt voltooid tijdens het uploaden naar Azure. De CPC's van de gegevenskopieer en gegevensupload worden vergeleken. Een niet-overeenkomende CRC geeft aan dat de bijbehorende bestanden niet konden worden geüpload.

U kunt het CRC-controlesomprogrammascript gebruiken om de controlesommen van de on-premises brongegevens te vergelijken met de gegevens die zijn geüpload naar Azure. Het script kan worden gedownload uit Azure Samples. Zie het README-bestand voor meer informatie.

Logboeken worden standaard geschreven naar een container met de naam copylog. De logboeken worden opgeslagen met de volgende naamconventie:

storage-account-name/databoxcopylog/ordername_device-serial-number_CopyLog_guid.xml.

Het pad naar het kopieerlogboek wordt ook weergegeven op de blade Overzicht voor de portal.

Notitie

Als firewallregels zijn ingesteld voor het opslagaccount voor uw Data Box, hebt u mogelijk geen toegang tot kopieerlogboeken vanuit Azure Portal met behulp van COPY LOG PATH in het deelvenster Overzicht . Als u toegang wilt krijgen tot de logboeken, wijzigt u de instellingen van de opslagfirewall om het huidige systeem toe te staan of gebruikt u een systeem dat zich in het firewallnetwerk bevindt.

Uploaden is voltooid

In het volgende voorbeeld wordt de algemene indeling van een kopielogboek voor een Data Box-upload beschreven die is voltooid:

<?xml version="1.0"?>

-<CopyLog Summary="Summary">

<Status>Succeeded</Status>

<TotalFiles>45</TotalFiles>

<FilesErrored>0</FilesErrored>

</CopyLog>

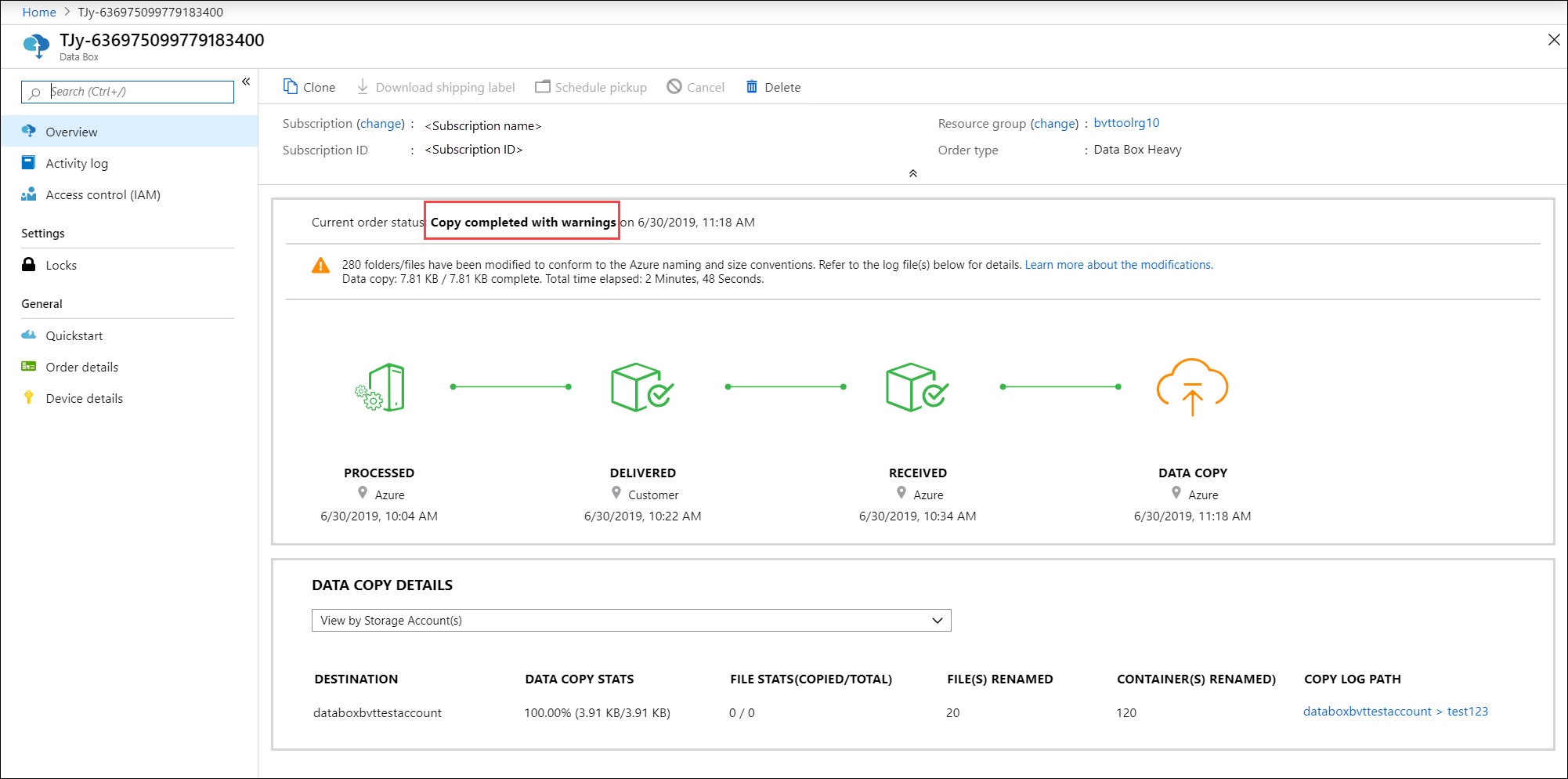

Upload voltooid met waarschuwingen

Uploaden naar Azure is voltooid met waarschuwingen als uw gegevens container-, blob- of bestandsnamen bevatten die niet voldoen aan azure-naamconventies en de namen zijn gewijzigd om de gegevens te uploaden naar Azure.

Hier volgt een voorbeeld van een kopielogboek waarin de containers die niet aan de Naamconventie van Azure voldoen, zijn hernoemd tijdens het uploaden van gegevens naar Azure.

De unieke namen voor de nieuwe containers hebben de indeling DataBox-GUID. De gegevens van de oorspronkelijke containers worden in de nieuwe, hernoemde containers geplaatst. In het kopieerlogboek worden de oude en nieuwe containernamen opgegeven.

<ErroredEntity Path="New Folder">

<Category>ContainerRenamed</Category>

<ErrorCode>1</ErrorCode>

<ErrorMessage>The original container/share/blob has been renamed to: DataBox-3fcd02de-bee6-471e-ac62-33d60317c576 :from: New Folder :because either the name has invalid character(s) or length is not supported</ErrorMessage>

<Type>Container</Type>

</ErroredEntity>

Hier volgt een voorbeeld van een kopielogboek waarin blobs of bestanden die niet aan de Naamconventies van Azure voldoen, zijn hernoemd tijdens het uploaden van gegevens naar Azure. De nieuwe blob- of bestandsnamen worden geconverteerd naar de SHA256-samenvatting van het relatieve pad naar de container en worden geüpload naar het pad op basis van het doeltype. Het doel kan blok-blobs, pagina-blobs of Azure Files zijn.

Hiermee copylog geeft u het oude en de nieuwe blob of bestandsnaam en het pad in Azure op.

<ErroredEntity Path="TesDir028b4ba9-2426-4e50-9ed1-8e89bf30d285\Ã">

<Category>BlobRenamed</Category>

<ErrorCode>1</ErrorCode>

<ErrorMessage>The original container/share/blob has been renamed to: PageBlob/DataBox-0xcdc5c61692e5d63af53a3cb5473e5200915e17b294683968a286c0228054f10e :from: Ã :because either name has invalid character(s) or length is not supported</ErrorMessage>

<Type>File</Type>

</ErroredEntity><ErroredEntity Path="TesDir9856b9ab-6acb-4bc3-8717-9a898bdb1f8c\Ã">

<Category>BlobRenamed</Category>

<ErrorCode>1</ErrorCode>

<ErrorMessage>The original container/share/blob has been renamed to: AzureFile/DataBox-0xcdc5c61692e5d63af53a3cb5473e5200915e17b294683968a286c0228054f10e :from: Ã :because either name has invalid character(s) or length is not supported</ErrorMessage>

<Type>File</Type>

</ErroredEntity><ErroredEntity Path="TesDirf92f6ca4-3828-4338-840b-398b967d810b\Ã">

<Category>BlobRenamed</Category>

<ErrorCode>1</ErrorCode>

<ErrorMessage>The original container/share/blob has been renamed to: BlockBlob/DataBox-0xcdc5c61692e5d63af53a3cb5473e5200915e17b294683968a286c0228054f10e :from: Ã :because either name has invalid character(s) or length is not supported</ErrorMessage>

<Type>File</Type>

</ErroredEntity>

Upload voltooid met fouten

Uploaden naar Azure kan ook worden voltooid met fouten.

Soms krijgt u mogelijk een fout die niet opnieuw kan worden geprobeerd, waardoor een bestand niet kan worden geüpload. In dat geval ontvangt u een melding. Zie Kopieerfouten in gegevensuploads van Azure Data Box- en Azure Data Box Heavy-apparaten controleren voor informatie over het opvolgen van de melding.

Hier volgt een voorbeeld van een kopielogboek waarin het uploaden is voltooid met fouten:

<ErroredEntity Path="iso\samsungssd.iso">

<Category>UploadErrorCloudHttp</Category>

<ErrorCode>409</ErrorCode>

<ErrorMessage>The blob type is invalid for this operation.</ErrorMessage>

<Type>File</Type>

</ErroredEntity><ErroredEntity Path="iso\iSCSI_Software_Target_33.iso">

<Category>UploadErrorCloudHttp</Category>

<ErrorCode>409</ErrorCode>

<ErrorMessage>The blob type is invalid for this operation.</ErrorMessage>

<Type>File</Type>

</ErroredEntity><CopyLog Summary="Summary">

<Status>Failed</Status>

<TotalFiles_Blobs>72</TotalFiles_Blobs>

<FilesErrored>2</FilesErrored>

</CopyLog>

Bewakingslogboeken ophalen na gegevensverwijdering

Nadat de gegevens zijn gewist uit de Data Box-schijven volgens de richtlijnen voor NIST SP 800-88 Revisie 1, zijn de logboeken voor bewaring beschikbaar. Deze logboeken omvatten de auditlogboeken en de ordergeschiedenis. De BOM- of manifestbestanden worden ook gekopieerd met de auditlogboeken.

Auditlogboeken

Auditlogboeken bevatten informatie over het inschakelen en openen van shares in de Data Box of Data Box Heavy wanneer deze zich buiten het Azure-datacenter bevindt. Deze logboeken bevinden zich op: storage-account/azuredatabox-chainofcustodylogs

Hier volgt een voorbeeld van het auditlogboek van een Data Box:

9/10/2018 8:23:01 PM : The operating system started at system time 2018-09-10T20:23:01.497758400Z.

9/10/2018 8:23:42 PM : An account was successfully logged on.

Subject:

Security ID: S-1-5-18

Account Name: WIN-DATABOXADMIN

Account Domain: Workgroup

Logon ID: 0x3E7

Logon Information:

Logon Type: 3

Restricted Admin Mode: -

Virtual Account: No

Elevated Token: No

Impersonation Level: Impersonation

New Logon:

Security ID: S-1-5-7

Account Name: ANONYMOUS LOGON

Account Domain: NT AUTHORITY

Logon ID: 0x775D5

Linked Logon ID: 0x0

Network Account Name: -

Network Account Domain: -

Logon GUID: {00000000-0000-0000-0000-000000000000}

Process Information:

Process ID: 0x4

Process Name:

Network Information:

Workstation Name: -

Source Network Address: -

Source Port: -

Detailed Authentication Information:

Logon Process: NfsSvr

Authentication Package:MICROSOFT_AUTHENTICATION_PACKAGE_V1_0

Transited Services: -

Package Name (NTLM only): -

Key Length: 0

This event is generated when a logon session is created. It is generated on the computer that was accessed.

The subject fields indicate the account on the local system which requested the logon. This is most commonly a service such as the Server service, or a local process such as Winlogon.exe or Services.exe.

The logon type field indicates the kind of logon that occurred. The most common types are 2 (interactive) and 3 (network).

The New Logon fields indicate the account for whom the new logon was created, i.e. the account that was logged on.

The network fields indicate where a remote logon request originated. Workstation name is not always available and may be left blank in some cases.

The impersonation level field indicates the extent to which a process in the logon session can impersonate.

The authentication information fields provide detailed information about this specific logon request.

- Logon GUID is a unique identifier that can be used to correlate this event with a KDC event.

- Transited services indicate which intermediate services have participated in this logon request.

- Package name indicates which sub-protocol was used among the NTLM protocols.

- Key length indicates the length of the generated session key. This will be 0 if no session key was requested.

9/10/2018 8:25:58 PM : An account was successfully logged on.

Ordergeschiedenis downloaden

Bestelgeschiedenis is beschikbaar in Azure Portal. Als de bestelling is voltooid en het opschonen van het apparaat (gegevensverwijdering van de schijven) is voltooid, gaat u naar uw apparaatorder en gaat u naar Ordergegevens. De optie Ordergeschiedenis downloaden is beschikbaar. Zie Bestelgeschiedenis downloaden voor meer informatie.

Als u door de bestelgeschiedenis bladert, ziet u:

- Traceringsgegevens van vervoerders voor uw apparaat.

- Gebeurtenissen met SecureErase-activiteit . Deze gebeurtenissen komen overeen met het verwijderen van de gegevens op de schijf.

- Data Box-logboekkoppelingen. De paden voor de auditlogboeken, kopieerlogboeken en BOM-bestanden worden weergegeven.

Hier volgt een voorbeeld van het bestelgeschiedenislogboek vanuit Azure Portal:

-------------------------------

Microsoft Data Box Order Report

-------------------------------

Name : gus-poland

StartTime(UTC) : 9/19/2018 8:49:23 AM +00:00

DeviceType : DataBox

-------------------

Data Box Activities

-------------------

Time(UTC) | Activity | Status | Description

9/19/2018 8:49:26 AM | OrderCreated | Completed |

10/2/2018 7:32:53 AM | DevicePrepared | Completed |

10/3/2018 1:36:43 PM | ShippingToCustomer | InProgress | Shipment picked up. Local Time : 10/3/2018 1:36:43 PM at AMSTERDAM-NLD

10/4/2018 8:23:30 PM | ShippingToCustomer | InProgress | Processed at AMSTERDAM-NLD. Local Time : 10/4/2018 8:23:30 PM at AMSTERDAM-NLD

10/4/2018 11:43:34 PM | ShippingToCustomer | InProgress | Departed Facility in AMSTERDAM-NLD. Local Time : 10/4/2018 11:43:34 PM at AMSTERDAM-NLD

10/5/2018 8:13:49 AM | ShippingToCustomer | InProgress | Arrived at Delivery Facility in BRIGHTON-GBR. Local Time : 10/5/2018 8:13:49 AM at LAMBETH-GBR

10/5/2018 9:13:24 AM | ShippingToCustomer | InProgress | With delivery courier. Local Time : 10/5/2018 9:13:24 AM at BRIGHTON-GBR

10/5/2018 12:03:04 PM | ShippingToCustomer | Completed | Delivered - Signed for by. Local Time : 10/5/2018 12:03:04 PM at BRIGHTON-GBR

1/25/2019 3:19:25 PM | ShippingToDataCenter | InProgress | Shipment picked up. Local Time : 1/25/2019 3:19:25 PM at BRIGHTON-GBR

1/25/2019 8:03:55 PM | ShippingToDataCenter | InProgress | Processed at BRIGHTON-GBR. Local Time : 1/25/2019 8:03:55 PM at LAMBETH-GBR

1/25/2019 8:04:58 PM | ShippingToDataCenter | InProgress | Departed Facility in BRIGHTON-GBR. Local Time : 1/25/2019 8:04:58 PM at BRIGHTON-GBR

1/25/2019 9:06:09 PM | ShippingToDataCenter | InProgress | Arrived at Sort Facility LONDON-HEATHROW-GBR. Local Time : 1/25/2019 9:06:09 PM at LONDON-HEATHROW-GBR

1/25/2019 9:48:54 PM | ShippingToDataCenter | InProgress | Processed at LONDON-HEATHROW-GBR. Local Time : 1/25/2019 9:48:54 PM at LONDON-HEATHROW-GBR

1/25/2019 10:30:20 PM | ShippingToDataCenter | InProgress | Departed Facility in LONDON-HEATHROW-GBR. Local Time : 1/25/2019 10:30:20 PM at LONDON-HEATHROW-GBR

1/28/2019 7:11:35 AM | ShippingToDataCenter | InProgress | Arrived at Delivery Facility in AMSTERDAM-NLD. Local Time : 1/28/2019 7:11:35 AM at AMSTERDAM-NLD

1/28/2019 9:07:57 AM | ShippingToDataCenter | InProgress | With delivery courier. Local Time : 1/28/2019 9:07:57 AM at AMSTERDAM-NLD

1/28/2019 1:35:56 PM | ShippingToDataCenter | InProgress | Scheduled for delivery. Local Time : 1/28/2019 1:35:56 PM at AMSTERDAM-NLD

1/28/2019 2:57:48 PM | ShippingToDataCenter | Completed | Delivered - Signed for by. Local Time : 1/28/2019 2:57:48 PM at AMSTERDAM-NLD

1/29/2019 2:18:43 PM | PhysicalVerification | Completed |

1/29/2019 3:49:50 PM | DeviceBoot | Completed | Appliance booted up successfully.

1/29/2019 3:49:51 PM | AnomalyDetection | Completed | No anomaly detected.

2/12/2019 10:37:03 PM | DataCopy | Resumed |

2/13/2019 12:05:15 AM | DataCopy | Resumed |

2/15/2019 7:07:34 PM | DataCopy | Completed | Copy Completed.

2/15/2019 7:47:32 PM | SecureErase | Started |

2/15/2019 8:01:10 PM | SecureErase | Completed | Azure Data Box:<Device-serial-no> has been sanitized according to NIST 800-88 Rev 1.

------------------

Data Box Log Links

------------------

Account Name : gusacct

Copy Logs Path : databoxcopylog/gus-poland_<Device-serial-no>_CopyLog_<GUID>.xml

Audit Logs Path : azuredatabox-chainofcustodylogs\<GUID>\<Device-serial-no>

BOM Files Path : azuredatabox-chainofcustodylogs\<GUID>\<Device-serial-no>

Volgende stappen

Feedback

Binnenkort beschikbaar: In de loop van 2024 zullen we GitHub-problemen geleidelijk uitfaseren als het feedbackmechanisme voor inhoud en deze vervangen door een nieuw feedbacksysteem. Zie voor meer informatie: https://aka.ms/ContentUserFeedback.

Feedback verzenden en weergeven voor