Een Apache Spark-taakdefinitie maken in Fabric

In deze zelfstudie leert u hoe u een Spark-taakdefinitie maakt in Microsoft Fabric.

Vereisten

Voordat u aan de slag gaat, hebt u het volgende nodig:

- Een Fabric-tenantaccount met een actief abonnement. Gratis een account maken

Tip

Als u het taakdefinitie-item van Spark wilt uitvoeren, moet u een hoofddefinitiebestand en de standaard lakehouse-context hebben. Als u geen lakehouse hebt, kunt u er een maken door de stappen in Een lakehouse maken.

Een Spark-taakdefinitie maken

Het proces voor het maken van de Spark-taakdefinitie is snel en eenvoudig; er zijn verschillende manieren om aan de slag te gaan.

Opties voor het maken van een Spark-taakdefinitie

Er zijn een aantal manieren waarop u aan de slag kunt met het aanmaakproces:

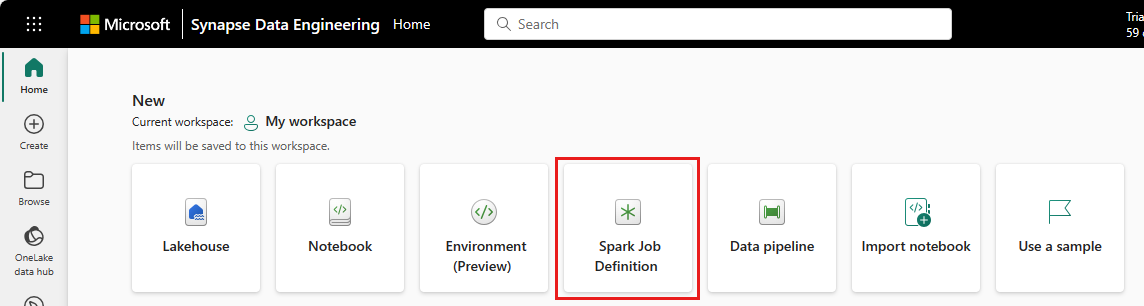

Startpagina van data engineering: u kunt eenvoudig een Spark-taakdefinitie maken via de Spark-taakdefinitiekaart onder de sectie Nieuw op de startpagina.

Werkruimteweergave: U kunt ook een Spark-taakdefinitie maken via de werkruimte in Data-engineer met behulp van het vervolgkeuzemenu Nieuw.

Weergave maken: Een ander toegangspunt voor het maken van een Spark-taakdefinitie is de pagina Maken onder Data-engineer ing.

U moet uw Spark-taakdefinitie een naam geven wanneer u deze maakt. De naam moet uniek zijn binnen de huidige werkruimte. De nieuwe Spark-taakdefinitie wordt gemaakt in uw huidige werkruimte.

Een Spark-taakdefinitie maken voor PySpark (Python)

Een Spark-taakdefinitie maken voor PySpark:

Download het Parquet-voorbeeldbestand yellow_tripdata_2022-01.parquet en upload het naar de bestandensectie van het lakehouse.

Maak een nieuwe Spark-taakdefinitie.

Selecteer PySpark (Python) in de vervolgkeuzelijst Taal .

Download het createTablefromParquet.py voorbeeld en upload het als het hoofddefinitiebestand. Het hoofddefinitiebestand (taak. Main) is het bestand dat de toepassingslogica bevat en verplicht is om een Spark-taak uit te voeren. Voor elke Spark-taakdefinitie kunt u slechts één hoofddefinitiebestand uploaden.

U kunt het hoofddefinitiebestand uploaden vanaf uw lokale bureaublad of u kunt uploaden vanuit een bestaande Azure Data Lake Storage (ADLS) Gen2 door het volledige ABFSS-pad van het bestand op te geven. Bijvoorbeeld:

abfss://your-storage-account-name.dfs.core.windows.net/your-file-path.Upload referentiebestanden als .py bestanden. De referentiebestanden zijn de Python-modules die worden geïmporteerd door het hoofddefinitiebestand. Net als het hoofddefinitiebestand kunt u uploaden vanaf uw bureaublad of een bestaande ADLS Gen2. Er worden meerdere referentiebestanden ondersteund.

Tip

Als u een ADLS Gen2-pad gebruikt om ervoor te zorgen dat het bestand toegankelijk is, moet u het gebruikersaccount waarmee de taak wordt uitgevoerd de juiste machtiging voor het opslagaccount geven. We raden twee verschillende manieren aan om dit te doen:

- Wijs het gebruikersaccount een rol Inzender toe voor het opslagaccount.

- Verken lees- en uitvoeringsmachtigingen voor het gebruikersaccount voor het bestand via de ACL (ADLS Gen2 Access Control List).

Voor een handmatige uitvoering wordt het account van de huidige aanmeldingsgebruiker gebruikt om de taak uit te voeren.

Geef indien nodig opdrachtregelargumenten op voor de taak. Gebruik een spatie als splitser om de argumenten te scheiden.

Voeg de lakehouse-verwijzing toe aan de taak. U moet ten minste één lakehouse-verwijzing aan de taak hebben toegevoegd. Dit lakehouse is de standaard lakehouse-context voor de taak.

Meerdere lakehouse-verwijzingen worden ondersteund. Zoek de niet-standaard lakehouse-naam en volledige OneLake-URL op de pagina Spark-instellingen .

Een Spark-taakdefinitie maken voor Scala/Java

Een Spark-taakdefinitie maken voor Scala/Java:

Maak een nieuwe Spark-taakdefinitie.

Selecteer Spark(Scala/Java) in de vervolgkeuzelijst Taal .

Upload het hoofddefinitiebestand als een .jar-bestand . Het hoofddefinitiebestand is het bestand dat de toepassingslogica van deze taak bevat en verplicht is om een Spark-taak uit te voeren. Voor elke Spark-taakdefinitie kunt u slechts één hoofddefinitiebestand uploaden. Geef de naam van de hoofdklasse op.

Upload referentiebestanden als .jar bestanden. De referentiebestanden zijn de bestanden waarnaar wordt verwezen/geïmporteerd door het hoofddefinitiebestand.

Geef indien nodig opdrachtregelargumenten op voor de taak.

Voeg de lakehouse-verwijzing toe aan de taak. U moet ten minste één lakehouse-verwijzing aan de taak hebben toegevoegd. Dit lakehouse is de standaard lakehouse-context voor de taak.

Een Spark-taakdefinitie maken voor R

Een Spark-taakdefinitie maken voor SparkR(R):

Maak een nieuwe Spark-taakdefinitie.

Selecteer SparkR(R) in de vervolgkeuzelijst Taal .

Upload het hoofddefinitiebestand als een . R-bestand . Het hoofddefinitiebestand is het bestand dat de toepassingslogica van deze taak bevat en verplicht is om een Spark-taak uit te voeren. Voor elke Spark-taakdefinitie kunt u slechts één hoofddefinitiebestand uploaden.

Upload referentiebestanden als . R-bestanden . De referentiebestanden zijn de bestanden waarnaar wordt verwezen/geïmporteerd door het hoofddefinitiebestand.

Geef indien nodig opdrachtregelargumenten op voor de taak.

Voeg de lakehouse-verwijzing toe aan de taak. U moet ten minste één lakehouse-verwijzing aan de taak hebben toegevoegd. Dit lakehouse is de standaard lakehouse-context voor de taak.

Notitie

De Spark-taakdefinitie wordt gemaakt in uw huidige werkruimte.

Opties voor het aanpassen van Spark-taakdefinities

Er zijn enkele opties om de uitvoering van Spark-taakdefinities verder aan te passen.

- Spark Compute: op het tabblad Spark Compute kunt u de runtimeversie zien die de versie van Spark is die wordt gebruikt om de taak uit te voeren. U kunt ook de Spark-configuratie-instellingen zien die worden gebruikt om de taak uit te voeren. U kunt de Spark-configuratie-instellingen aanpassen door op de knop Toevoegen te klikken.

Optimalisatie: Op het tabblad Optimalisatie kunt u het beleid voor opnieuw proberen voor de taak inschakelen en instellen. Wanneer deze optie is ingeschakeld, wordt de taak opnieuw geprobeerd als deze mislukt. U kunt ook het maximum aantal nieuwe pogingen en het interval tussen nieuwe pogingen instellen. Voor elke nieuwe poging wordt de taak opnieuw gestart. Zorg ervoor dat de taak idempotent is.