Inzicht in datawarehouses in Fabric

Fabric Lakehouse is een verzameling bestanden, mappen, tabellen en snelkoppelingen die fungeren als een database via een data lake. Het wordt gebruikt door de Spark-engine en DE SQL-engine voor verwerking van big data en heeft functies voor ACID-transacties bij het gebruik van de opensource-tabellen met delta-indeling.

Met de datawarehouse-ervaring van Fabric kunt u overstappen van de lake-weergave van Lakehouse (die data engineering en Apache Spark ondersteunt) naar de SQL-ervaringen die een traditioneel datawarehouse zou bieden. Het Lakehouse biedt u de mogelijkheid om tabellen te lezen en het SQL-analyse-eindpunt te gebruiken, terwijl u met het datawarehouse de gegevens kunt bewerken.

In de datawarehouse-ervaring gaat u gegevens modelleren met behulp van tabellen en weergaven, T-SQL uitvoeren om query's uit te voeren op gegevens in het datawarehouse en Lakehouse, T-SQL gebruiken om DML-bewerkingen uit te voeren op gegevens in het datawarehouse en rapportagelagen te leveren, zoals Power BI.

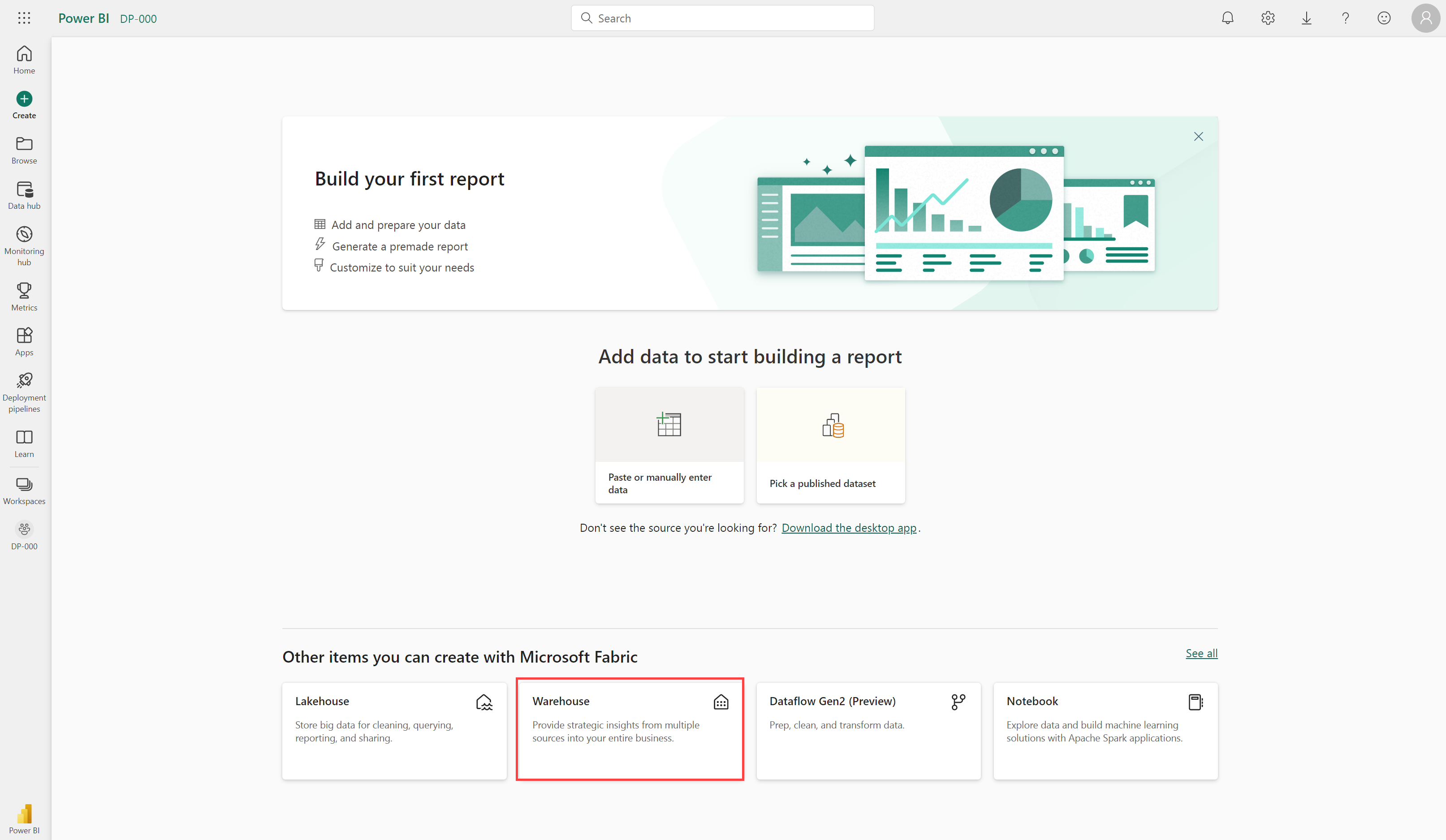

Nu u de basisprincipes voor architectuur voor een relationeel datawarehouseschema begrijpt, gaan we eens kijken hoe u een datawarehouse maakt.

Een datawarehouse in Fabric beschrijven

In de datawarehouse-ervaring in Fabric kunt u een relationele laag bouwen op fysieke gegevens in Lakehouse en deze beschikbaar maken voor analyse- en rapportagehulpprogramma's. U kunt uw datawarehouse rechtstreeks in Fabric maken vanuit de hub maken of in een werkruimte. Nadat u een leeg magazijn hebt gemaakt, kunt u er objecten aan toevoegen.

Zodra uw magazijn is gemaakt, kunt u tabellen maken met behulp van T-SQL rechtstreeks in de Fabric-interface.

Gegevens opnemen in uw datawarehouse

Er zijn een aantal manieren om gegevens op te nemen in een Fabric-datawarehouse, waaronder pijplijnen, gegevensstromen, query's op meerdere databases en de opdracht COPY INTO. Na opname zijn de gegevens beschikbaar voor analyse door meerdere bedrijfsgroepen, die functies zoals query's op meerdere databases en delen kunnen gebruiken om deze te openen.

Tabellen maken

Als u een tabel in het datawarehouse wilt maken, kunt u SQL Server Management Studio (SSMS) of een andere SQL-client gebruiken om verbinding te maken met het datawarehouse en een CREATE TABLE-instructie uit te voeren. U kunt ook rechtstreeks tabellen maken in de gebruikersinterface van Fabric.

U kunt gegevens van een externe locatie naar een tabel in het datawarehouse kopiëren met behulp van de COPY INTO syntaxis. Voorbeeld:

COPY INTO dbo.Region

FROM 'https://mystorageaccountxxx.blob.core.windows.net/private/Region.csv' WITH (

FILE_TYPE = 'CSV'

,CREDENTIAL = (

IDENTITY = 'Shared Access Signature'

, SECRET = 'xxx'

)

,FIRSTROW = 2

)

GO

Met deze SQL-query worden gegevens uit een CSV-bestand geladen dat is opgeslagen in Azure Blob Storage in een tabel met de naam Regio in het datawarehouse Fabric.

Overwegingen voor tabellen

Nadat u tabellen in een datawarehouse hebt gemaakt, is het belangrijk om na te denken over het laden van gegevens in deze tabellen. Een algemene benadering is het gebruik van faseringstabellen. In Fabric kunt u T-SQL-opdrachten gebruiken om gegevens uit bestanden te laden in faseringstabellen in het datawarehouse.

Faseringstabellen zijn tijdelijke tabellen die kunnen worden gebruikt om gegevens op te schonen, gegevenstransformaties en gegevensvalidatie uit te voeren. U kunt faseringstabellen ook gebruiken om gegevens uit meerdere bronnen in één doeltabel te laden.

Normaal gesproken wordt het laden van gegevens uitgevoerd als een periodiek batchproces waarin invoegingen en updates voor het datawarehouse regelmatig worden uitgevoerd (bijvoorbeeld dagelijks, wekelijks of maandelijks).

Over het algemeen moet u een datawarehouse-laadproces implementeren waarmee taken in de volgende volgorde worden uitgevoerd:

- Opname van de nieuwe gegevens die moeten worden geladen in een data lake, waarbij vooraf opschoning of transformaties worden toegepast, indien nodig.

- Laad de gegevens uit bestanden in faseringstabellen in het relationele datawarehouse.

- Laad de dimensietabellen uit de dimensiegegevens in de faseringstabellen, werk bestaande rijen bij of voeg nieuwe rijen in en genereert indien nodig surrogaatsleutelwaarden.

- Laad de feitentabellen van de feitengegevens in de faseringstabellen en zoek de juiste surrogaatsleutels op voor gerelateerde dimensies.

- Voer optimalisatie na belasting uit door indexen en tabeldistributiestatistieken bij te werken.

Als u tabellen in lakehouse hebt en u er query's op wilt kunnen uitvoeren in uw magazijn, maar geen wijzigingen aanbrengt, hoeft u geen gegevens van het lakehouse naar het datawarehouse te kopiëren. U kunt rechtstreeks vanuit het datawarehouse query's uitvoeren op gegevens in lakehouse met behulp van query's op meerdere databases.

Belangrijk

Het werken met tabellen in het Fabric-datawarehouse heeft momenteel enkele beperkingen. Zie Tabellen in datawarehousing in Microsoft Fabric voor meer informatie.