Szybki start: Azure AI Content Safety Studio

W tym przewodniku Szybki start rozpocznij pracę z usługą Azure AI Content Safety Service przy użyciu narzędzia Content Safety Studio w przeglądarce.

Uwaga

Niektóre przykładowe treści udostępniane przez program Content Safety Studio mogą być obraźliwe. Przykładowe obrazy są domyślnie rozmyte. Zaleca się, aby użytkownik był dyskrecjonalne.

Wymagania wstępne

- Aktywne konto platformy Azure. Jeśli nie masz konta, możesz je utworzyć teraz za darmo.

- Zasób platformy Azure bezpieczeństwo zawartości.

- Przypisz

Cognitive Services Userrolę do swojego konta, aby zapewnić środowisko studio. Przejdź do witryny Azure Portal, przejdź do zasobu Bezpieczeństwo zawartości lub zasób usług Azure AI Services i wybierz pozycję Kontrola dostępu na pasku nawigacyjnym po lewej stronie, a następnie kliknij pozycję + Dodaj przypisanie roli, wybierzCognitive Services Userrolę i wybierz członka swojego konta, do którego chcesz przypisać tę rolę, a następnie przejrzyj i przypisz. Wykonanie przypisania może potrwać kilka minut. - Zaloguj się do programu Content Safety Studio przy użyciu subskrypcji platformy Azure i zasobu Bezpieczeństwo zawartości.

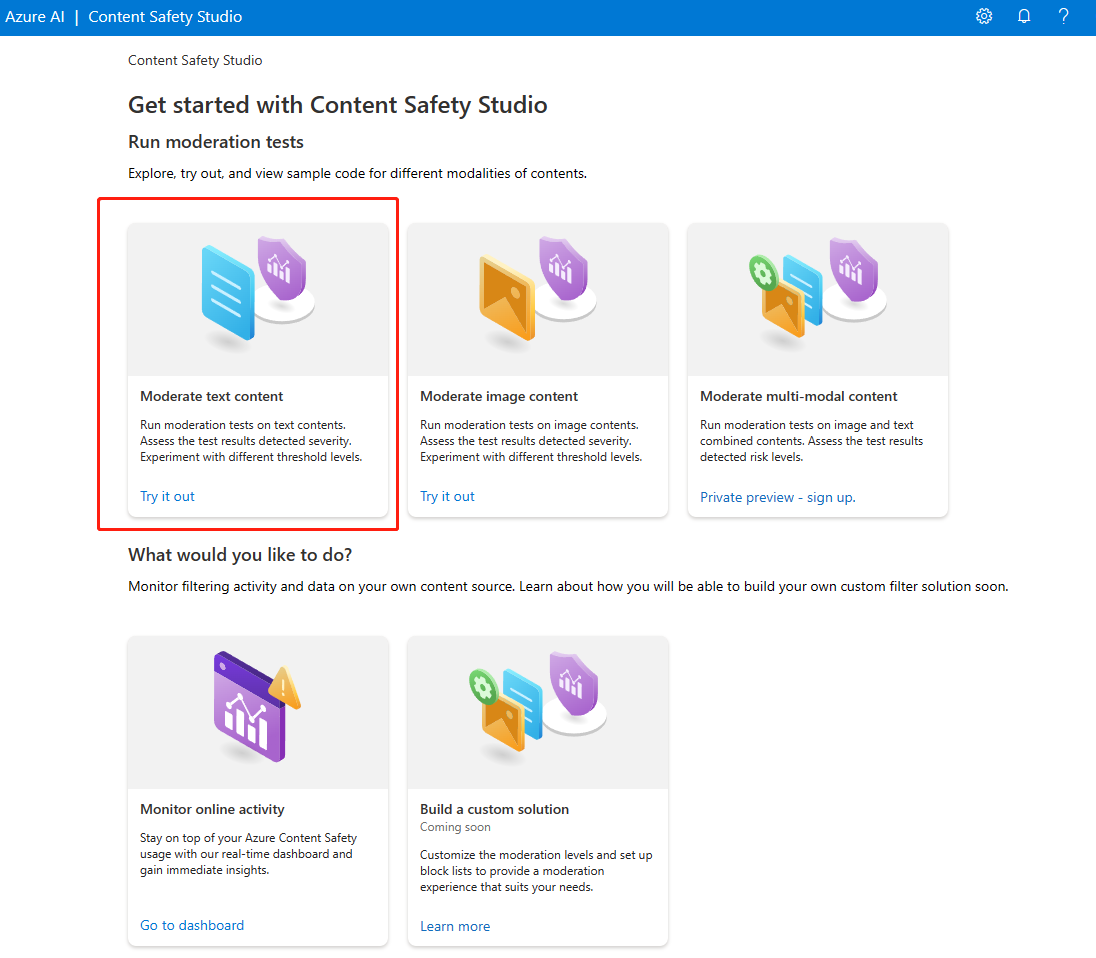

Analizowanie zawartości tekstowej

Strona Moderowanie zawartości tekstowej umożliwia szybkie wypróbowanie moderowania tekstu.

- Wybierz panel Moderowanie zawartości tekstowej.

- Dodaj tekst do pola wejściowego lub wybierz przykładowy tekst z paneli na stronie.

Napiwek

Rozmiar tekstu i stopień szczegółowości

Zobacz Wymagania dotyczące danych wejściowych, aby uzyskać informacje o maksymalnych ograniczeniach długości tekstu.

- Wybierz Uruchamianie przypadków testowych.

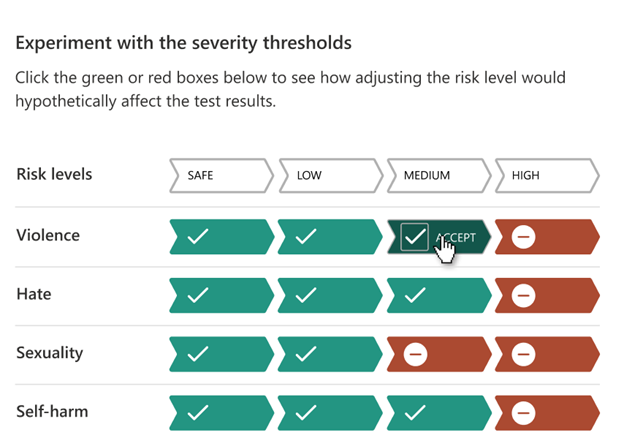

Usługa zwraca wszystkie wykryte kategorie z poziomem ważności dla każdego (0-Safe, 2-Low, 4-Medium, 6-High). Zwraca również binarny wynik Zaakceptowane/odrzucone na podstawie skonfigurowanych filtrów. Użyj macierzy na karcie Konfigurowanie filtrów po prawej stronie, aby ustawić dozwolone/zabronione poziomy ważności dla każdej kategorii. Następnie możesz ponownie uruchomić tekst, aby zobaczyć, jak działa filtr.

Karta Użyj listy zablokowanych po prawej stronie umożliwia tworzenie, edytowanie i dodawanie listy bloków do przepływu pracy moderowania. Jeśli podczas uruchamiania testu jest włączona lista zablokowanych, w obszarze Wyniki zostanie wyświetlony panel wykrywania listy bloków. Raportuje wszystkie dopasowania z listą zablokowanych.

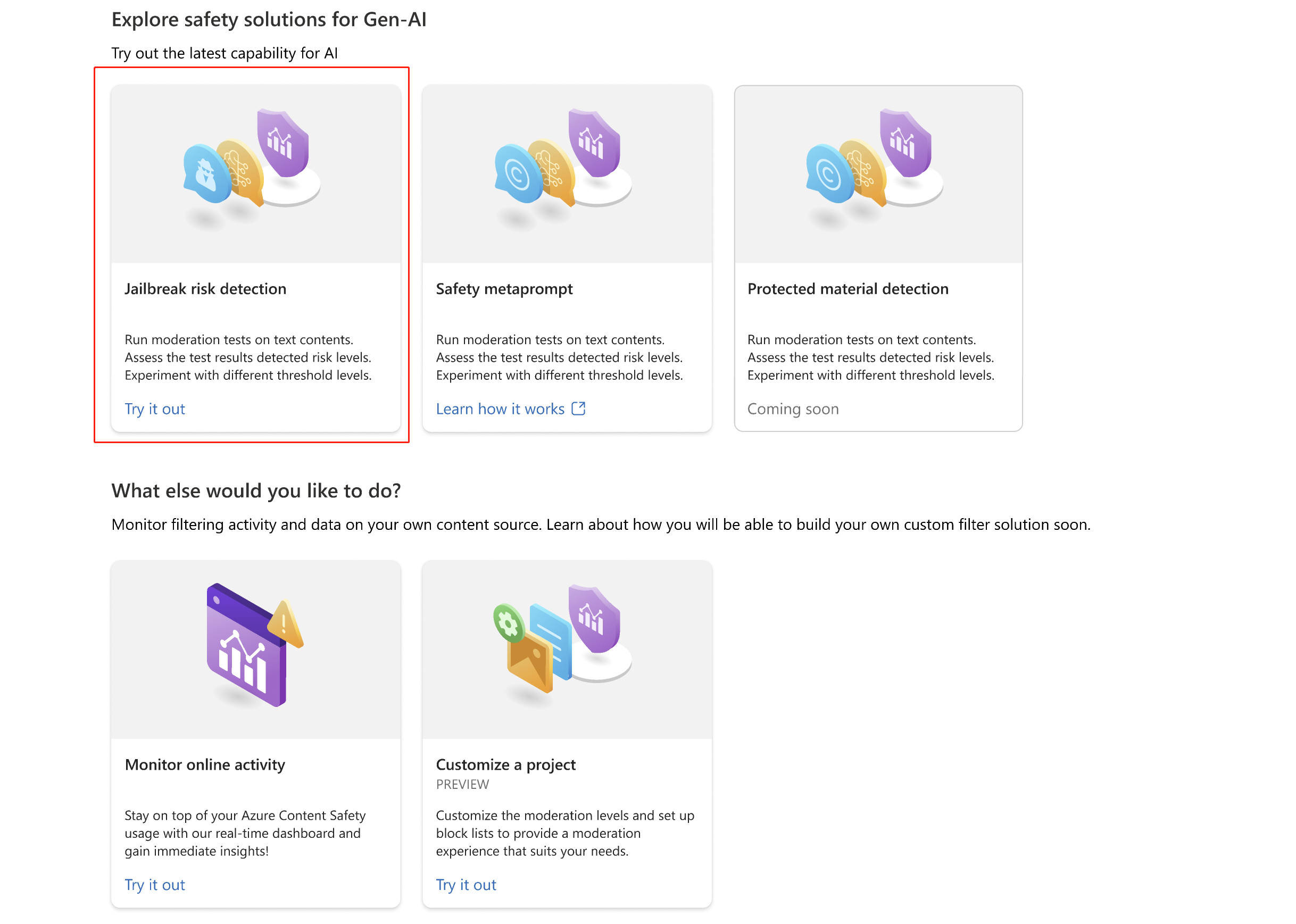

Wykrywanie ataków wejściowych użytkowników

Panel Monituj osłony umożliwia wypróbowanie wykrywania ryzyka związanego z danymi wejściowymi użytkownika. Wykrywanie monitów użytkownika zaprojektowanych w celu wywołania modelu generowania sztucznej inteligencji do wyświetlania zachowań, które zostały wytrenowane w celu uniknięcia lub przerwania reguł ustawionych w komunikacie systemowym. Te ataki mogą się różnić od skomplikowanych ról do subtelnego podwersji celu bezpieczeństwa.

- Wybierz panel Monituj osłony .

- Wybierz przykładowy tekst na stronie lub wprowadź własną zawartość do testowania. Możesz również przekazać plik CSV, aby przeprowadzić test wsadowy.

- Wybierz Uruchamianie przypadków testowych.

Usługa zwraca flagę ryzyka i typ dla każdej próbki.

Aby uzyskać więcej informacji, zobacz przewodnik koncepcyjny Prompt Shields.

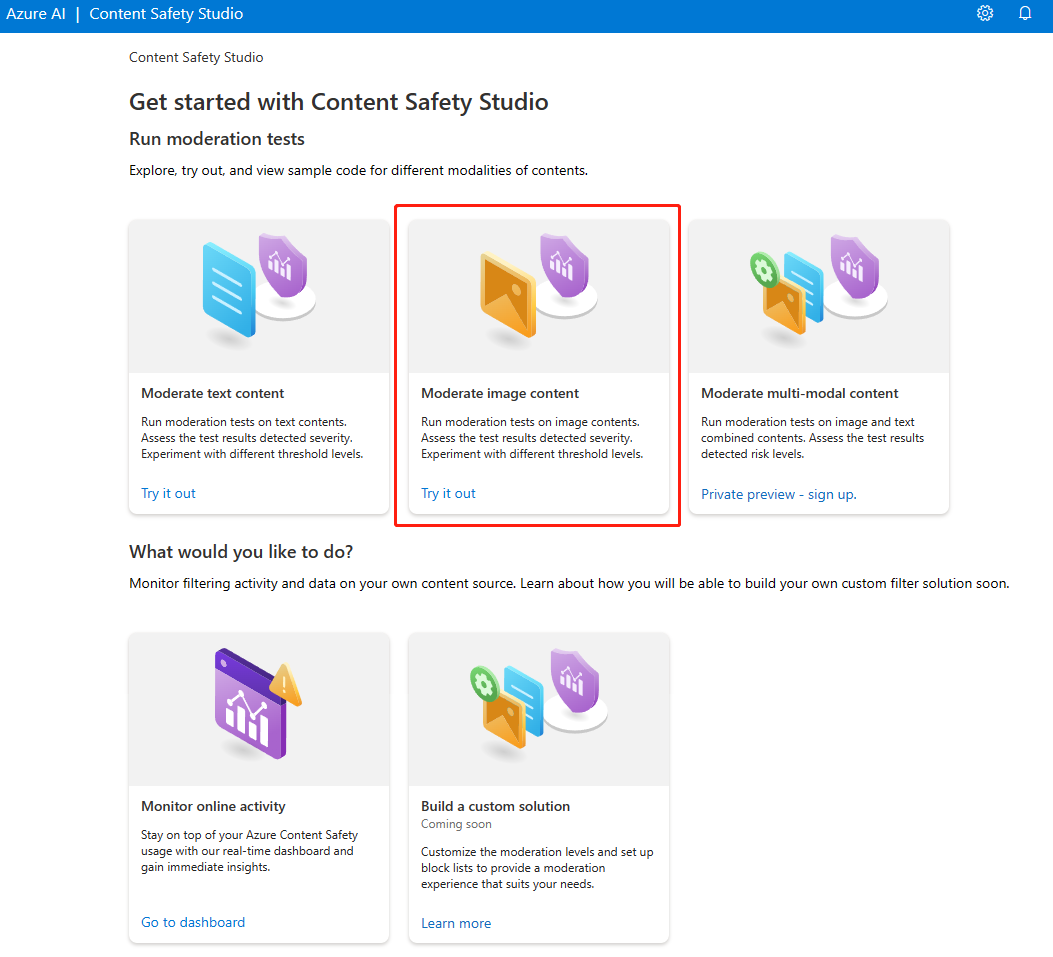

Analizowanie zawartości obrazów

Strona Moderowanie zawartości obrazu umożliwia szybkie wypróbowanie moderowania obrazów.

- Wybierz panel Moderowanie zawartości obrazu.

- Wybierz przykładowy obraz z paneli na stronie lub przekaż własny obraz. Maksymalny rozmiar przesyłania obrazów wynosi 4 MB, a wymiary obrazu muszą zawierać się między 50 x 50 pikseli a 2048 x 2048 pikseli. Obrazy mogą być w formatach JPEG, PNG, GIF, BMP, TIFF lub WEBP.

- Wybierz Uruchamianie przypadków testowych.

Usługa zwraca wszystkie wykryte kategorie z poziomem ważności dla każdego (0-Safe, 2-Low, 4-Medium, 6-High). Zwraca również binarny wynik Zaakceptowane/odrzucone na podstawie skonfigurowanych filtrów. Użyj macierzy na karcie Konfigurowanie filtrów po prawej stronie, aby ustawić dozwolone/zabronione poziomy ważności dla każdej kategorii. Następnie możesz ponownie uruchomić tekst, aby zobaczyć, jak działa filtr.

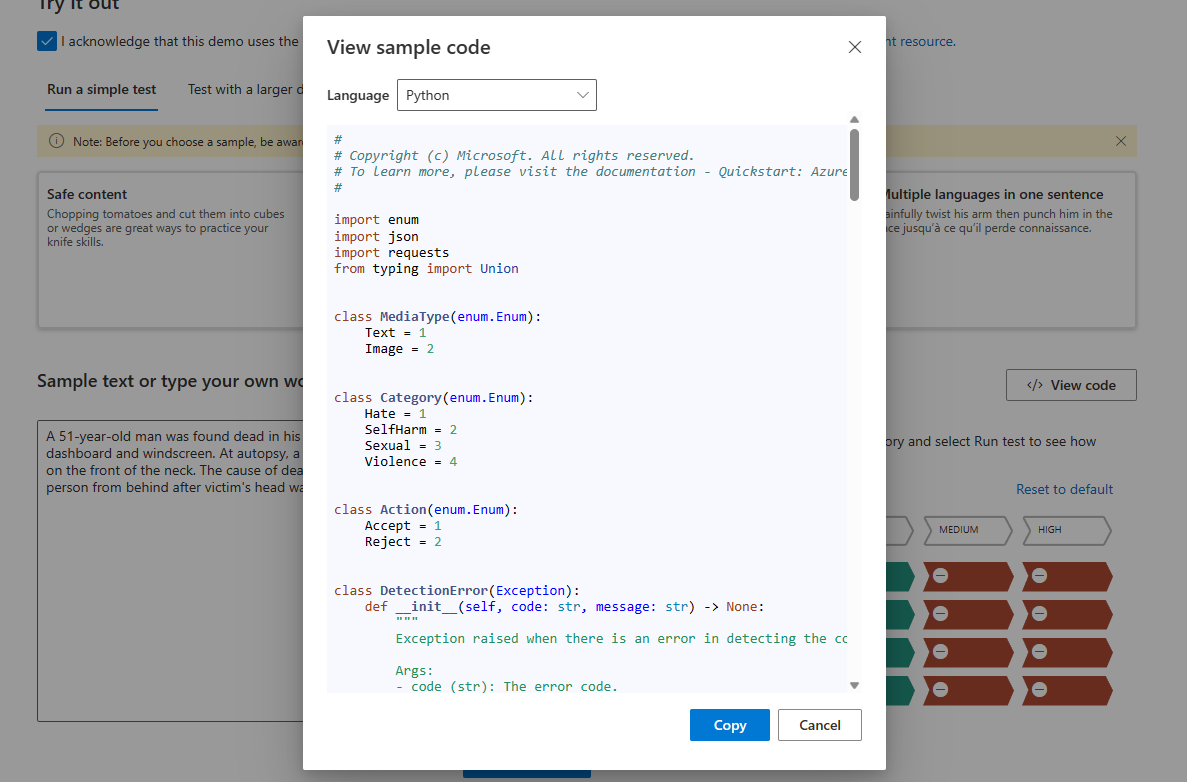

Wyświetlanie i eksportowanie kodu

Możesz użyć funkcji Wyświetl kod na stronie Analizowanie zawartości tekstowej lub Analizowanie zawartości obrazu, aby wyświetlić i skopiować przykładowy kod, który obejmuje konfigurację filtrowania ważności, listy zablokowanych i funkcji moderowania. Następnie możesz wdrożyć kod na końcu.

Monitorowanie aktywności online

Strona Monitorowanie aktywności online umożliwia wyświetlanie użycia i trendów interfejsu API.

Możesz wybrać typ nośnika do monitorowania. Możesz również określić zakres czasu, który chcesz sprawdzić, wybierając pozycję Pokaż dane dla ostatniego __.

Na wykresie Współczynnik odrzucenia na kategorię można również dostosować progi ważności dla każdej kategorii.

Możesz również edytować listy zablokowanych, jeśli chcesz zmienić niektóre terminy na podstawie wykresu Pierwszych 10 zablokowanych terminów .

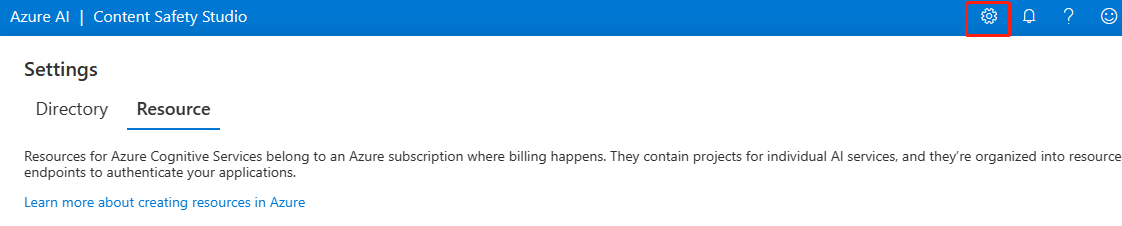

Zarządzanie zasobem

Aby wyświetlić szczegóły zasobów, takie jak nazwa i warstwa cenowa, wybierz ikonę Ustawienia w prawym górnym rogu strony głównej narzędzia Content Safety Studio i wybierz kartę Zasób . Jeśli masz inne zasoby, możesz również przełączać zasoby tutaj.

Czyszczenie zasobów

Jeśli chcesz wyczyścić i usunąć zasób usług Azure AI, możesz usunąć zasób lub grupę zasobów. Usunięcie grupy zasobów powoduje również usunięcie wszelkich innych skojarzonych z nią zasobów.

Następne kroki

Następnie rozpocznij korzystanie z bezpieczeństwa zawartości usługi Azure AI za pośrednictwem interfejsów API REST lub zestawu SDK klienta, aby bezproblemowo zintegrować usługę z aplikacją.

Opinia

Dostępne już wkrótce: W 2024 r. będziemy stopniowo wycofywać zgłoszenia z serwisu GitHub jako mechanizm przesyłania opinii na temat zawartości i zastępować go nowym systemem opinii. Aby uzyskać więcej informacji, sprawdź: https://aka.ms/ContentUserFeedback.

Prześlij i wyświetl opinię dla