Wybór aparatu dla sztucznej inteligencji usługi Azure IoT Edge

Jednym z najważniejszych składników w systemie przetwarzania obrazów jest aparat fotograficzny. Aparat musi przechwytywać i prezentować obrazy, które modele sztucznej inteligencji (AI) lub uczenia maszynowego (ML) mogą oceniać i identyfikować prawidłowo. Ten artykuł zawiera szczegółowe informacje na temat różnych typów aparatów, możliwości i zagadnień.

Typy kamer

Typy aparatów obejmują skanowanie obszaru, skanowanie linii i osadzone inteligentne aparaty fotograficzne. Istnieje wiele różnych producentów dla tych aparatów. Wybierz dostawcę, który odpowiada twoim potrzebom.

Kamery skanujące obszary

Kamery skanujące obszary generują tradycyjny obraz aparatu. Ten aparat zwykle ma macierz czujników pikseli. Aparat przechwytuje obraz 2D i wysyła go do sprzętu usługi Azure IoT Edge do oceny.

Kamery skanujące obszary patrzą na duży obszar i są dobre do wykrywania zmian. Przykłady obciążeń, które mogą używać kamer skanowania obszaru, to bezpieczeństwo miejsca pracy lub wykrywanie lub liczenie obiektów w środowisku.

Kamery skanujące linie

Aparat skanów liniowych ma jeden wiersz czujników pikseli liniowych. Aparat pobiera obrazy o szerokości 1 pikseli w krótkim odstępie czasu, łączy je ze sobą w strumień wideo i wysyła strumień do urządzenia usługi IoT Edge do przetwarzania.

Kamery skanowania liniowego są dobre w przypadku obciążeń przetwarzania obrazów, w których elementy są przenoszone obok aparatu lub muszą być obracane w celu wykrywania wad. Następnie aparat skanowania linii tworzy strumień obrazu ciągłego do oceny. Przykłady obciążeń, które najlepiej sprawdzają się w przypadku kamer skanowania liniowego, to:

- Wykrywanie wad elementów w częściach przenoszonych na przenośnik taśmowy

- Obciążenia wymagające wirowania w celu wyświetlenia obiektu walcowego

- Obciążenia wymagające rotacji

Osadzone inteligentne aparaty fotograficzne

Osadzony inteligentny aparat jest samodzielnym, autonomicznym systemem, który może przetwarzać, a także uzyskiwać obrazy. Osadzone inteligentne aparaty fotograficzne mogą używać skanowania obszaru lub aparatu skanowania linii do przechwytywania obrazów, chociaż inteligentny aparat skanowania linii jest rzadki. Kamery te zwykle mają port wyjściowy RS232 lub Ethernet, dzięki czemu mogą integrować się bezpośrednio z programowalnym kontrolerem logiki (PLC) lub innym przemysłowym kontrolerem IoT (IIoT).

Funkcje aparatu

Istnieje kilka funkcji, które należy wziąć pod uwagę podczas wybierania aparatu dla obciążenia przetwarzania obrazów. W poniższych sekcjach omówiono rozmiar, rozdzielczość i szybkość czujnika. Inne funkcje aparatu, które należy wziąć pod uwagę, obejmują:

- Wybór obiektywu

- Ogniskowa

- Głębokość monochromatyczna lub kolorowa

- Głębokość stereo

- Wyzwalacze

- Rozmiar fizyczny

- Pomoc techniczna

Producenci aparatów mogą pomóc zrozumieć, jakie funkcje wymaga aplikacja.

Rozmiar czujnika

Rozmiar czujnika jest jednym z najważniejszych czynników do oceny w aparacie. Czujnik jest sprzętem w aparacie, który przechwytuje obiekt docelowy i konwertuje go na sygnały, które następnie tworzą obraz. Czujnik zawiera miliony półkonduktorów fotodetektorów nazywanych fototektorami.

Większa liczba megapikseli nie zawsze skutkuje lepszym obrazem. Na przykład aparat z 12 milionami zdjęć i 1-calowym czujnikiem tworzy jaśniejszy, ostrzejszy obraz niż aparat z 12 milionami zdjęć i czujnik 1/2 cala. Kamery dla obciążeń przetwarzania obrazów zwykle mają rozmiary czujników z zakresu od 1/4 cala do 1 cala. Niektóre przypadki mogą wymagać znacznie większych czujników.

Wybierz większe czujniki, jeśli obciążenie przetwarzania obrazów ma:

- Potrzeba pomiarów dokładności

- Niższe warunki oświetlenia

- Krótszy czas ekspozycji lub szybkie przenoszenie elementów

Rozwiązanie

Rozdzielczość jest kolejnym ważnym czynnikiem wyboru aparatu. Jeśli obciążenie wymaga kamer o wyższej rozdzielczości:

- Musi identyfikować drobne funkcje, takie jak zapis na chipie obwodu zintegrowanego

- Próbuje wykryć twarze

- Musi identyfikować pojazdy z dystansu

Na poniższych obrazach przedstawiono problem z użyciem nieprawidłowego rozwiązania dla danego przypadku użycia. Oba zdjęcia zostały zrobione 20 metrów od samochodu. Małe czerwone pola reprezentują jeden piksel.

Na poniższej ilustracji przedstawiono 480 pikseli poziomych:

Poniższa ilustracja została wykonana z 5184 pikseli poziomych:

Szybkość

Jeśli obciążenie przetwarzania obrazów wymaga przechwytywania wielu obrazów na sekundę, ważne są dwa czynniki. Pierwszym czynnikiem jest szybkość połączenia interfejsu aparatu. Drugim czynnikiem jest typ czujnika. Czujniki są dostępne w dwóch typach, urządzeniach połączonych z opłatami (CCD) i czujnikach aktywnych pikseli (CMOS). Czujniki CMOS mają bezpośredni odczyt z sesji zdjęciowych, więc zwykle oferują wyższą szybkość klatek.

Umieszczanie kamery

Elementy, które należy przechwycić w obciążeniu przetwarzania obrazów, określają lokalizacje i kąty umieszczania kamery. Lokalizacja aparatu może również wchodzić w interakcje z typem czujnika, typem obiektywu i typem ciała aparatu. Dwa z najbardziej krytycznych czynników do określania położenia kamery to oświetlenie i pole widzenia.

Oświetlenie kamery

W obciążeniu przetwarzania obrazów oświetlenie ma kluczowe znaczenie dla umieszczania kamery. Można zastosować kilka różnych warunków oświetlenia. Warunki oświetlenia, które są przydatne w przypadku jednego obciążenia obrazowego, mogą powodować niepożądane skutki w innym obciążeniu.

Istnieje kilka typowych typów oświetlenia dla obciążeń przetwarzania obrazów:

- Oświetlenie bezpośrednie jest najczęstszym warunkiem oświetlenia. Źródło światła jest przewidywane w obiekcie do przechwycenia.

- Oświetlenie liniowe to pojedyncza tablica świateł najczęściej używanych z aparatami skanów liniowych. Oświetlenie liniowe tworzy pojedynczą linię światła w centrum uwagi aparatu.

- Rozproszone oświetlenie oświetla obiekt, ale zapobiega ostrym cieniom. Rozproszone oświetlenie jest najczęściej stosowane wokół obiektów widmowych lub odbijanych.

- Rozproszone oświetlenie osiowe jest często używane z obiektami o wysokiej refleksji lub zapobiega cieniom części do przechwytywania.

- Oświetlenie tylne jest używane za obiektem, tworząc sylwetkę obiektu. Oświetlenie tylne jest najbardziej przydatne w przypadku pomiarów, wykrywania krawędzi lub orientacji obiektu.

- Niestandardowe oświetlenie siatki to ustrukturyzowany warunek oświetlenia, który określa siatkę światła na obiekcie. Znane projekcje siatki zapewniają dokładniejsze pomiary składników elementów, części i umieszczania.

- Oświetlenie Strobe jest używane w przypadku części poruszających się z dużą prędkością. Strob musi być zsynchronizowany z kamerą , aby wykonać zamrożenie obiektu do oceny. Oświetlenie strobowe pomaga zapobiegać rozmywaniu ruchu.

- Ciemne oświetlenie pola używa kilku świateł z różnymi kątami do części do przechwycenia. Na przykład jeśli część leży płasko na przenośniku taśmowym, światła są pod kątem 45 stopni do pasa. Oświetlenie ciemnego pola jest najbardziej przydatne w przypadku obiektów o wysokim odbiciu odbicia i jest często używane do wykrywania zadrapania obiektywu.

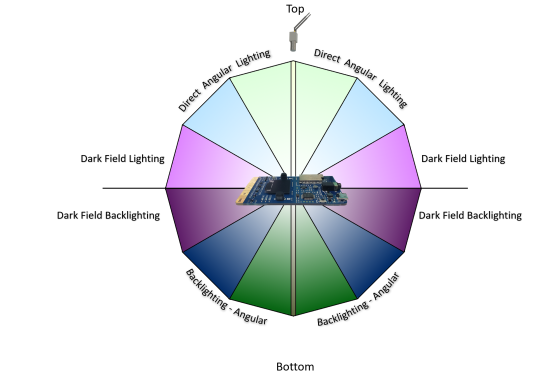

Na poniższej ilustracji przedstawiono położenie kątowe źródeł światła:

Pole widoku

W planowaniu obciążenia przetwarzania obrazów musisz wiedzieć o polu widoku (FOV) obiektów, które oceniasz. FOV odgrywa rolę w wyborze kamery, zaznaczenia czujnika i konfiguracji obiektywu. Składniki FOV obejmują:

- Odległość do obiektów. Czy na przykład obiekt monitorowany na przenośniku taśmowym z kamerą dwie stopy nad nim, czy na parkingu? Czujniki kamery i konfiguracje obiektywów różnią się w różnych odległościach.

- Obszar pokrycia. Czy obszar przetwarzania obrazów próbuje monitorować małe lub duże? Ten czynnik jest bezpośrednio skorelowany z rozdzielczością, obiektywem i typem czujnika aparatu.

- Kierunek słońca. Jeśli obciążenie przetwarzania obrazów jest na zewnątrz, należy wziąć pod uwagę kierunek słońca przez cały dzień. Kąt słońca, który porusza się, może mieć wpływ na model przetwarzania obrazów. Jeśli aparat dostaje bezpośrednie światło słoneczne w obiektywie, może być ślepy, aż kąt słońca się zmieni. Jeśli słońce rzuca cień na monitorowany obiekt, obiekt może być zasłonięty.

- Kąt aparatu do obiektów. Jeśli aparat jest zbyt wysoki lub zbyt niski, może przegapić szczegóły, które obciążenie próbuje przechwycić.

Interfejs komunikacyjny

W planowaniu obciążenia przetwarzania obrazów ważne jest, aby zrozumieć, jak dane wyjściowe aparatu współdziałają z resztą systemu. Istnieje kilka standardowych sposobów komunikowania się kamer z urządzeniami usługi IoT Edge:

Protokół RTSP (Real Time Streaming Protocol) to protokół sieciowy na poziomie aplikacji, który kontroluje serwery przesyłania strumieniowego wideo. Protokół RTSP przesyła dane wideo w czasie rzeczywistym z aparatu do punktu końcowego obliczeniowego usługi IoT Edge za pośrednictwem połączenia TCP/IP.

Open Network Video Interface Forum (ONVIF) to globalne, otwarte forum branżowe, które opracowuje otwarte standardy dla kamer opartych na protokole IP. Te standardy opisują komunikację między kamerami IP a systemami podrzędnym, współdziałaniem i oprogramowaniem open source.

Kamery połączone z uniwersalną magistralą szeregową (USB) łączą się za pośrednictwem portu USB bezpośrednio z urządzeniem obliczeniowym usługi IoT Edge. To połączenie jest mniej złożone, ale ogranicza odległość, z poziomu urządzenia usługi IoT Edge.

Interfejs seryjny aparatu (CSI) zawiera kilka standardów z Mobile Industry Processor Interface (MIPI) Alliance. CSI opisuje sposób komunikowania się między aparatem a procesorem hosta. CSI-2, wydany w 2005 r., ma kilka warstw:

- Warstwa fizyczna (C-PHY lub D-PHY)

- Warstwa połączenia pasa ruchu

- Warstwa protokołu niskiego poziomu

- Warstwa konwersji pikseli na bajt

- Warstwa aplikacji

CsI-2 v3.0 dodano obsługę głębokości kolorów RAW-24, Unified Serial Link i Smart Region of Interest.

Współautorzy

Ten artykuł jest obsługiwany przez firmę Microsoft. Pierwotnie został napisany przez następujących współautorów.

Główny autor:

- Keith Hill | Starszy menedżer pm

Aby wyświetlić niepubalne profile serwisu LinkedIn, zaloguj się do serwisu LinkedIn.

Następne kroki

Opinia

Dostępne już wkrótce: W 2024 r. będziemy stopniowo wycofywać zgłoszenia z serwisu GitHub jako mechanizm przesyłania opinii na temat zawartości i zastępować go nowym systemem opinii. Aby uzyskać więcej informacji, sprawdź: https://aka.ms/ContentUserFeedback.

Prześlij i wyświetl opinię dla