Metryki oceny dla modeli Niestandardowa analiza tekstu dla zdrowia

Zestaw danych jest podzielony na dwie części: zestaw do trenowania i zestaw do testowania. Zestaw szkoleniowy służy do trenowania modelu, podczas gdy zestaw testowy jest używany jako test dla modelu po trenowaniu w celu obliczenia wydajności i oceny modelu. Zestaw testów nie jest wprowadzany do modelu za pośrednictwem procesu trenowania, aby upewnić się, że model jest testowany na nowych danych.

Ocena modelu jest wyzwalana automatycznie po pomyślnym zakończeniu trenowania. Proces oceny rozpoczyna się od użycia wytrenowanego modelu do przewidywania jednostek zdefiniowanych przez użytkownika dla dokumentów w zestawie testowym i porównuje je z podanymi etykietami danych (co ustanawia punkt odniesienia prawdy). Wyniki są zwracane, aby można było przejrzeć wydajność modelu. Jednostki zdefiniowane przez użytkownika są uwzględniane w składnikach oceny poznanych i list; analiza tekstu dla wstępnie utworzonych jednostek kondycji nie są uwzględniane w ocenie modelu. Do oceny Niestandardowa analiza tekstu dla zdrowia są używane następujące metryki:

Precyzja: mierzy dokładność/dokładność modelu. Jest to stosunek między poprawnie zidentyfikowanych alarmów (prawdziwie dodatnich) i wszystkich zidentyfikowanych alarmów. Metryka precyzji pokazuje, ile przewidywanych jednostek jest poprawnie oznaczonych etykietami.

Precision = #True_Positive / (#True_Positive + #False_Positive)Kompletność: Mierzy zdolność modelu do przewidywania rzeczywistych dodatnich klas. Jest to stosunek między przewidywanymi wartościami prawdziwie dodatnimi a tym, co zostało rzeczywiście oznaczone. Metryka wycofywania pokazuje, ile przewidywanych jednostek jest poprawnych.

Recall = #True_Positive / (#True_Positive + #False_Negatives)Wynik F1: Wynik F1 jest funkcją precyzji i kompletności. Jest to potrzebne, gdy szukasz równowagi między precyzją a kompletnością.

F1 Score = 2 * Precision * Recall / (Precision + Recall)

Uwaga

Precyzja, kompletność i ocena F1 są obliczane osobno dla każdej jednostki (ocena na poziomie jednostki ) i dla modelu zbiorczo (ocena na poziomie modelu ).

Metryki oceny na poziomie modelu i na poziomie jednostki

Precyzja, kompletność i wynik F1 są obliczane osobno dla każdej jednostki (ocena na poziomie jednostki) i dla modelu zbiorczo (ocena na poziomie modelu).

Definicje precyzji, kompletności i oceny są takie same zarówno dla ocen na poziomie jednostki, jak i na poziomie modelu. Jednak liczba wyników prawdziwie dodatnich, wyników fałszywie dodatnich i wyników fałszywie ujemnych może się różnić. Rozważmy na przykład następujący tekst.

Przykład

Pierwszą stroną tego kontraktu jest John Smith, mieszkaniec 5678 Main Rd., miasto Frederick, stan Nebraska. Druga partia to Forrest Ray, mieszkaniec 123-345 Integer Rd., Miasto Corona, stan Nowy Meksyk. Istnieje również mieszkaniec Fannie Thomas 7890 River Road, miasto Colorado Springs, stan Kolorado.

Model wyodrębniania jednostek z tego tekstu może mieć następujące przewidywania:

| Jednostka | Przewidywane jako | Typ rzeczywisty |

|---|---|---|

| Jan Kowalski | Person (Osoba) | Person (Osoba) |

| Fryderyk | Person (Osoba) | City (Miasto) |

| Forrest | City (Miasto) | Person (Osoba) |

| Fannie Thomas | Person (Osoba) | Person (Osoba) |

| Colorado Springs | City (Miasto) | City (Miasto) |

Ocena na poziomie jednostki dla jednostki osoby

Model będzie miał następującą ocenę na poziomie jednostki dla jednostki osoby :

| Klucz | Liczba | Wyjaśnienie |

|---|---|---|

| Wynik prawdziwie dodatni | 2 | John Smith i Fannie Thomas zostali prawidłowo przewidzieni jako osoba. |

| Wynik fałszywie dodatni | 1 | Frederick został niepoprawnie przewidział jako osobę , chociaż powinien być miastem. |

| Wynik fałszywie ujemny | 1 | Forrest został niepoprawnie przewidział jako miasto , podczas gdy powinien być osobą. |

- Precyzja:

#True_Positive / (#True_Positive + #False_Positive)=2 / (2 + 1) = 0.67 - Przypomnij sobie:

#True_Positive / (#True_Positive + #False_Negatives)=2 / (2 + 1) = 0.67 - Wynik F1:

2 * Precision * Recall / (Precision + Recall)=(2 * 0.67 * 0.67) / (0.67 + 0.67) = 0.67

Ocena na poziomie jednostki dla jednostki miejskiej

Model będzie miał następującą ocenę na poziomie jednostki dla jednostki miejskiej :

| Klucz | Liczba | Wyjaśnienie |

|---|---|---|

| Wynik prawdziwie dodatni | 1 | Colorado Springs został prawidłowo przewidział jako miasto. |

| Wynik fałszywie dodatni | 1 | Forrest został niepoprawnie przewidział jako miasto , podczas gdy powinien być osobą. |

| Wynik fałszywie ujemny | 1 | Frederick został niepoprawnie przewidział jako osobę , chociaż powinien być miastem. |

- Precyzji =

#True_Positive / (#True_Positive + #False_Positive)=1 / (1 + 1) = 0.5 - Przypomnieć =

#True_Positive / (#True_Positive + #False_Negatives)=1 / (1 + 1) = 0.5 - Wynik F1 =

2 * Precision * Recall / (Precision + Recall)=(2 * 0.5 * 0.5) / (0.5 + 0.5) = 0.5

Ocena na poziomie modelu dla modelu zbiorowego

Model będzie miał następującą ocenę modelu w całości:

| Klucz | Liczba | Wyjaśnienie |

|---|---|---|

| Wynik prawdziwie dodatni | 3 | John Smith i Fannie Thomas zostali prawidłowo przewidzieni jako osoba. Colorado Springs został prawidłowo przewidział jako miasto. Jest to suma wyników prawdziwie dodatnich dla wszystkich jednostek. |

| Wynik fałszywie dodatni | 2 | Forrest został niepoprawnie przewidział jako miasto , podczas gdy powinien być osobą. Frederick został niepoprawnie przewidział jako osobę , chociaż powinien być miastem. Jest to suma wyników fałszywie dodatnich dla wszystkich jednostek. |

| Wynik fałszywie ujemny | 2 | Forrest był niepoprawnie przewidywany jako miasto , podczas gdy powinien być osobą. Frederick był niepoprawnie przewidywany jako osoba , podczas gdy powinien być miastem. Jest to suma fałszywie ujemnych dla wszystkich jednostek. |

- Precyzji =

#True_Positive / (#True_Positive + #False_Positive)=3 / (3 + 2) = 0.6 - Przypomnieć =

#True_Positive / (#True_Positive + #False_Negatives)=3 / (3 + 2) = 0.6 - Wynik F1 =

2 * Precision * Recall / (Precision + Recall)=(2 * 0.6 * 0.6) / (0.6 + 0.6) = 0.6

Interpretowanie metryk oceny na poziomie jednostki

Więc co to znaczy mieć wysoką precyzję lub wysoką kompletność dla określonej jednostki?

| Recall | Dokładność | Interpretacja |

|---|---|---|

| Wys. | Wys. | Ta jednostka jest dobrze obsługiwana przez model. |

| Nis. | Wys. | Model nie może zawsze wyodrębniać tej jednostki, ale gdy jest z dużą pewnością. |

| Wys. | Nis. | Model wyodrębnia tę jednostkę, jednak jest ona o niskiej pewności, ponieważ czasami jest wyodrębniona jako inny typ. |

| Niski | Niski | Ten typ jednostki jest słabo obsługiwany przez model, ponieważ zwykle nie jest wyodrębniany. Kiedy tak jest, nie jest to z dużym zaufaniem. |

Wskazówki

Po wytrenowanym modelu zobaczysz wskazówki i zalecenia dotyczące sposobu ulepszania modelu. Zaleca się posiadanie modelu obejmującego wszystkie punkty w sekcji wskazówek.

Zestaw trenowania ma wystarczającą ilość danych: jeśli typ jednostki ma mniej niż 15 wystąpień oznaczonych etykietami w danych treningowych, może to prowadzić do obniżenia dokładności z powodu braku odpowiedniego trenowania modelu w tych przypadkach. W takim przypadku rozważ dodanie większej liczby oznaczonych etykietami danych w zestawie treningowym. Aby uzyskać więcej wskazówek, możesz sprawdzić kartę rozkładu danych .

Wszystkie typy jednostek są obecne w zestawie testów: gdy dane testowe nie mają oznaczonych etykietami wystąpień dla typu jednostki, wydajność testu modelu może stać się mniej kompleksowa ze względu na nietestowane scenariusze. Aby uzyskać więcej wskazówek, możesz sprawdzić kartę dystrybucji danych zestawu testów .

Typy jednostek są zrównoważone w zestawach trenowania i testów: gdy próbkowanie stronniczości powoduje niedokładną reprezentację częstotliwości typu jednostki, może prowadzić do obniżenia dokładności ze względu na model spodziewający się, że typ jednostki występuje zbyt często lub zbyt mało. Aby uzyskać więcej wskazówek, możesz sprawdzić kartę rozkładu danych .

Typy jednostek są równomiernie dystrybuowane między zestawami trenowania i testowania: gdy kombinacja typów jednostek nie jest zgodna między zestawami treningowych i testowych, może to prowadzić do obniżenia dokładności testowania ze względu na sposób trenowania modelu inaczej niż testowany. Aby uzyskać więcej wskazówek, możesz sprawdzić kartę rozkładu danych .

Niejasne rozróżnienie między typami jednostek w zestawie trenowania: gdy dane trenowania są podobne dla wielu typów jednostek, może to prowadzić do mniejszej dokładności, ponieważ typy jednostek mogą być często błędnie sklasyfikowane jako siebie. Przejrzyj następujące typy jednostek i rozważ ich scalenie, jeśli są one podobne. W przeciwnym razie dodaj więcej przykładów, aby lepiej je odróżnić od siebie. Aby uzyskać więcej wskazówek, możesz sprawdzić kartę macierzy pomyłek .

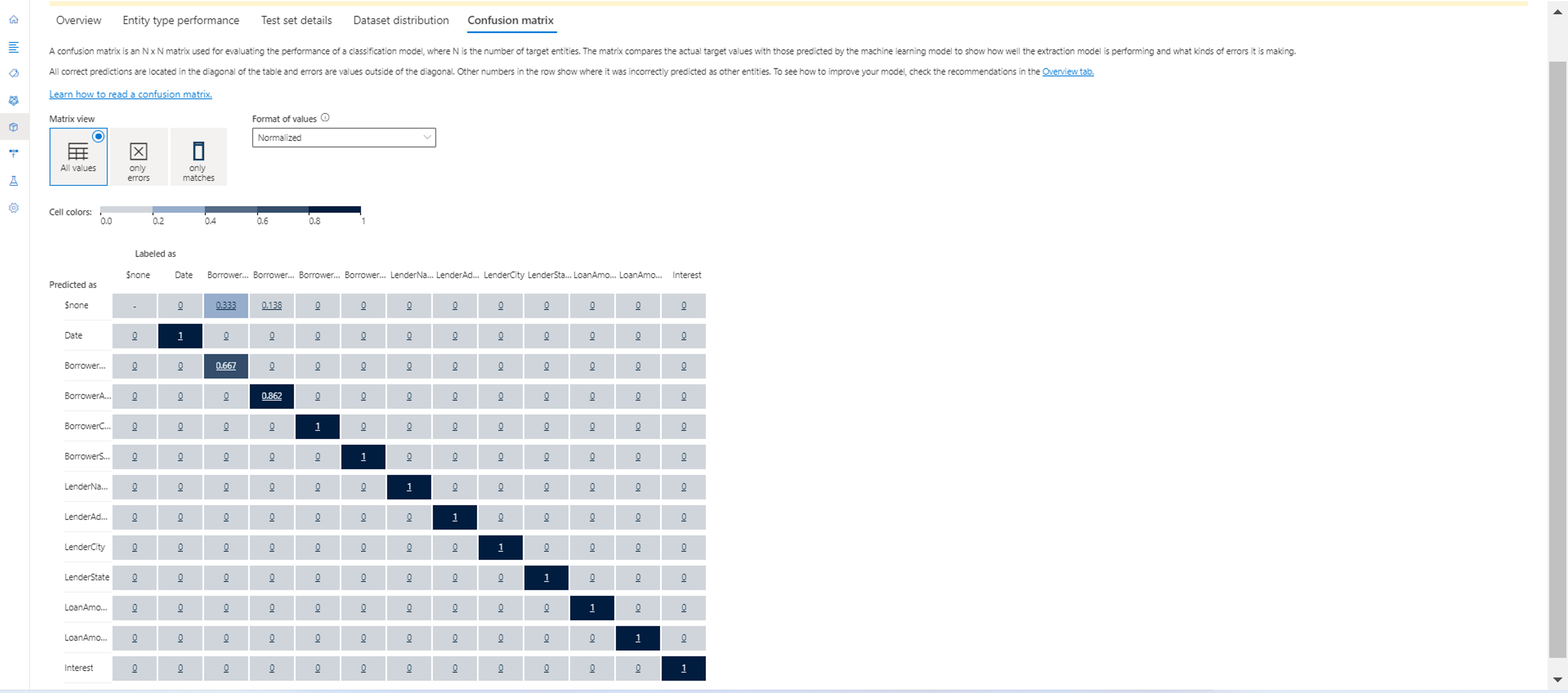

Macierz pomyłek

Macierz pomyłek to macierz N x N używana do oceny wydajności modelu, gdzie N jest liczbą jednostek. Macierz porównuje oczekiwane etykiety z etykietami przewidywanymi przez model. Zapewnia to całościowy pogląd na to, jak dobrze działa model i jakie rodzaje błędów wykonuje.

Za pomocą macierzy pomyłek można zidentyfikować jednostki, które są zbyt blisko siebie i często mylą się (niejednoznaczność). W takim przypadku należy rozważyć scalenie tych typów jednostek razem. Jeśli nie jest to możliwe, rozważ dodanie kolejnych otagowanych przykładów obu jednostek, aby ułatwić modelowi rozróżnienie między nimi.

Wyróżniona przekątna na poniższej ilustracji to poprawnie przewidywane jednostki, gdzie przewidywany tag jest taki sam jak rzeczywisty tag.

Metryki oceny na poziomie jednostki i na poziomie modelu można obliczyć na podstawie macierzy pomyłek:

- Wartości po przekątnej są wartościami prawdziwie dodatnimi każdej jednostki.

- Suma wartości w wierszach jednostki (z wyłączeniem przekątnej) jest wynikiem fałszywie dodatnim modelu.

- Suma wartości w kolumnach jednostki (z wyłączeniem przekątnej) jest fałszywą ujemną wartością modelu.

Podobnie

- Prawdziwie dodatnie wyniki modelu to suma wartości prawdziwie dodatnich dla wszystkich jednostek.

- Wynik fałszywie dodatni modelu jest sumą wyników fałszywie dodatnich dla wszystkich jednostek.

- Fałszywa ujemna wartość modelu jest sumą fałszywie ujemnych wartości ujemnych dla wszystkich jednostek.