Wdrażanie niestandardowego modelu mowy

Z tego artykułu dowiesz się, jak wdrożyć punkt końcowy dla niestandardowego modelu mowy. Z wyjątkiem transkrypcji wsadowej należy wdrożyć niestandardowy punkt końcowy, aby użyć niestandardowego modelu mowy.

Napiwek

Hostowany punkt końcowy wdrożenia nie jest wymagany do używania mowy niestandardowej z interfejsem API transkrypcji usługi Batch. Zasoby można oszczędzać, jeśli niestandardowy model mowy jest używany tylko do transkrypcji wsadowej. Aby uzyskać więcej informacji, zobacz Cennik usługi Mowa.

Punkt końcowy można wdrożyć dla modelu podstawowego lub niestandardowego, a następnie zaktualizować punkt końcowy później, aby użyć lepiej wytrenowanego modelu.

Uwaga

Punkty końcowe używane przez F0 zasoby usługi Mowa są usuwane po siedmiu dniach.

Dodawanie punktu końcowego wdrożenia

Aby utworzyć niestandardowy punkt końcowy, wykonaj następujące kroki:

Zaloguj się do programu Speech Studio.

Wybierz pozycję Mowa> niestandardowa Nazwa >projektu Wdróż modele.

Jeśli jest to pierwszy punkt końcowy, zauważysz, że w tabeli nie ma punktów końcowych. Po utworzeniu punktu końcowego użyj tej strony do śledzenia poszczególnych wdrożonych punktów końcowych.

Wybierz pozycję Wdróż model , aby uruchomić kreatora nowego punktu końcowego.

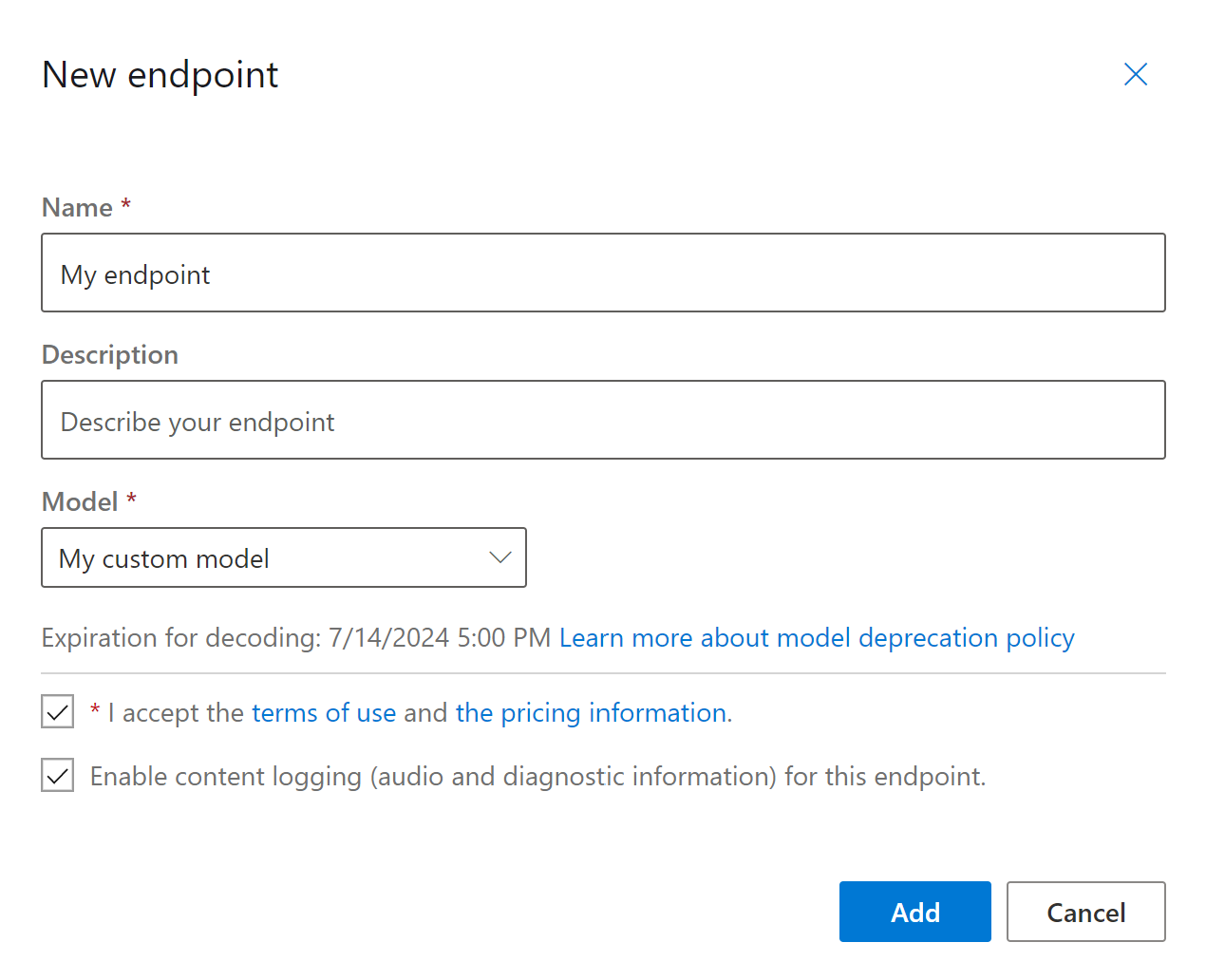

Na stronie Nowy punkt końcowy wprowadź nazwę i opis niestandardowego punktu końcowego.

Wybierz model niestandardowy, który chcesz skojarzyć z tym punktem końcowym.

Opcjonalnie możesz zaznaczyć to pole wyboru, aby włączyć rejestrowanie audio i diagnostyczne ruchu punktu końcowego.

Wybierz pozycję Dodaj , aby zapisać i wdrożyć punkt końcowy.

Na stronie głównej Wdrażanie modeli szczegółowe informacje o nowym punkcie końcowym są wyświetlane w tabeli, takie jak nazwa, opis, stan i data wygaśnięcia. Utworzenie wystąpienia nowego punktu końcowego korzystającego z modeli niestandardowych może potrwać do 30 minut. Gdy stan wdrożenia zmieni się na Powodzenie, punkt końcowy jest gotowy do użycia.

Ważne

Zanotuj datę wygaśnięcia modelu. Jest to ostatnia data, w której można użyć modelu niestandardowego do rozpoznawania mowy. Aby uzyskać więcej informacji, zobacz Cykl życia modelu i punktu końcowego.

Wybierz link punktu końcowego, aby wyświetlić informacje specyficzne dla niego, takie jak klucz punktu końcowego, adres URL punktu końcowego i przykładowy kod.

Aby utworzyć punkt końcowy i wdrożyć model, użyj spx csr endpoint create polecenia . Skonstruuj parametry żądania zgodnie z następującymi instrukcjami:

projectUstaw parametr na identyfikator istniejącego projektu. Jest to zalecane, aby można było również wyświetlać punkt końcowy i zarządzać nim w programie Speech Studio. Możesz uruchomić polecenie ,spx csr project listaby uzyskać dostępne projekty.- Ustaw wymagany

modelparametr na identyfikator modelu, który ma zostać wdrożony w punkcie końcowym. - Ustaw wymagany

languageparametr. Ustawienia regionalne punktu końcowego muszą być zgodne z ustawieniami regionalnymi modelu. Nie można później zmienić ustawień regionalnych. Parametr interfejsulocalewiersza polecenialanguageusługi Mowa odpowiada właściwości w żądaniu i odpowiedzi w formacie JSON. - Ustaw wymagany

nameparametr. Jest to nazwa wyświetlana w programie Speech Studio. Parametr interfejsudisplayNamewiersza polecenianameusługi Mowa odpowiada właściwości w żądaniu i odpowiedzi w formacie JSON. - Opcjonalnie można ustawić

loggingparametr . Ustaw tę opcję, abyenabledwłączyć rejestrowanie audio i diagnostyczne ruchu punktu końcowego. Wartość domyślna tofalse.

Oto przykładowe polecenie interfejsu wiersza polecenia usługi Mowa służące do tworzenia punktu końcowego i wdrażania modelu:

spx csr endpoint create --api-version v3.1 --project YourProjectId --model YourModelId --name "My Endpoint" --description "My Endpoint Description" --language "en-US"

Treść odpowiedzi powinna zostać wyświetlona w następującym formacie:

{

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/endpoints/98375aaa-40c2-42c4-b65c-f76734fc7790",

"model": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/models/base/ae8d1643-53e4-4554-be4c-221dcfb471c5"

},

"links": {

"logs": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/endpoints/98375aaa-40c2-42c4-b65c-f76734fc7790/files/logs",

"restInteractive": "https://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"restConversation": "https://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"restDictation": "https://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"webSocketInteractive": "wss://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"webSocketConversation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"webSocketDictation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790"

},

"project": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/projects/d40f2eb8-1abf-4f72-9008-a5ae8add82a4"

},

"properties": {

"loggingEnabled": true

},

"lastActionDateTime": "2022-05-19T15:27:51Z",

"status": "NotStarted",

"createdDateTime": "2022-05-19T15:27:51Z",

"locale": "en-US",

"displayName": "My Endpoint",

"description": "My Endpoint Description"

}

Właściwość najwyższego poziomu self w treści odpowiedzi to identyfikator URI punktu końcowego. Użyj tego identyfikatora URI, aby uzyskać szczegółowe informacje o projekcie, modelu i dziennikach punktu końcowego. Ten identyfikator URI służy również do aktualizowania punktu końcowego.

Aby uzyskać pomoc dotyczącą interfejsu wiersza polecenia usługi Mowa w punktach końcowych, uruchom następujące polecenie:

spx help csr endpoint

Aby utworzyć punkt końcowy i wdrożyć model, użyj operacji Endpoints_Create interfejsu API REST zamiany mowy na tekst. Skonstruuj treść żądania zgodnie z następującymi instrukcjami:

projectUstaw właściwość na identyfikator URI istniejącego projektu. Jest to zalecane, aby można było również wyświetlać punkt końcowy i zarządzać nim w programie Speech Studio. Możesz wysłać żądanie Projects_List , aby uzyskać dostępne projekty.- Ustaw właściwość wymaganą

modelna identyfikator URI modelu, który ma zostać wdrożony w punkcie końcowym. - Ustaw wymaganą

localewłaściwość. Ustawienia regionalne punktu końcowego muszą być zgodne z ustawieniami regionalnymi modelu. Nie można później zmienić ustawień regionalnych. - Ustaw wymaganą

displayNamewłaściwość. Jest to nazwa wyświetlana w programie Speech Studio. - Opcjonalnie można ustawić

loggingEnabledwłaściwość w obiekcieproperties. Ustaw tę opcję, abytruewłączyć rejestrowanie audio i diagnostyczne ruchu punktu końcowego. Wartość domyślna tofalse.

Utwórz żądanie HTTP POST przy użyciu identyfikatora URI, jak pokazano w poniższym przykładzie Endpoints_Create . Zastąp YourSubscriptionKey ciąg kluczem zasobu usługi Mowa, zastąp YourServiceRegion element regionem zasobu usługi Mowa i ustaw właściwości treści żądania zgodnie z wcześniejszym opisem.

curl -v -X POST -H "Ocp-Apim-Subscription-Key: YourSubscriptionKey" -H "Content-Type: application/json" -d '{

"project": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/projects/d40f2eb8-1abf-4f72-9008-a5ae8add82a4"

},

"properties": {

"loggingEnabled": true

},

"displayName": "My Endpoint",

"description": "My Endpoint Description",

"model": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/models/base/ae8d1643-53e4-4554-be4c-221dcfb471c5"

},

"locale": "en-US",

}' "https://YourServiceRegion.api.cognitive.microsoft.com/speechtotext/v3.1/endpoints"

Treść odpowiedzi powinna zostać wyświetlona w następującym formacie:

{

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/endpoints/98375aaa-40c2-42c4-b65c-f76734fc7790",

"model": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/models/base/ae8d1643-53e4-4554-be4c-221dcfb471c5"

},

"links": {

"logs": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/endpoints/98375aaa-40c2-42c4-b65c-f76734fc7790/files/logs",

"restInteractive": "https://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"restConversation": "https://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"restDictation": "https://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"webSocketInteractive": "wss://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"webSocketConversation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"webSocketDictation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790"

},

"project": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/projects/d40f2eb8-1abf-4f72-9008-a5ae8add82a4"

},

"properties": {

"loggingEnabled": true

},

"lastActionDateTime": "2022-05-19T15:27:51Z",

"status": "NotStarted",

"createdDateTime": "2022-05-19T15:27:51Z",

"locale": "en-US",

"displayName": "My Endpoint",

"description": "My Endpoint Description"

}

Właściwość najwyższego poziomu self w treści odpowiedzi to identyfikator URI punktu końcowego. Użyj tego identyfikatora URI, aby uzyskać szczegółowe informacje o projekcie, modelu i dziennikach punktu końcowego. Ten identyfikator URI służy również do aktualizowania lub usuwania punktu końcowego.

Zmienianie modelu i ponowne wdrażanie punktu końcowego

Punkt końcowy można zaktualizować tak, aby używał innego modelu utworzonego przez ten sam zasób usługi Mowa. Jak wspomniano wcześniej, należy zaktualizować model punktu końcowego przed wygaśnięciem modelu.

Aby użyć nowego modelu i ponownie wdrożyć niestandardowy punkt końcowy:

- Zaloguj się do programu Speech Studio.

- Wybierz pozycję Mowa> niestandardowa Nazwa >projektu Wdróż modele.

- Wybierz link do punktu końcowego według nazwy, a następnie wybierz pozycję Zmień model.

- Wybierz nowy model, którego chcesz użyć punktu końcowego.

- Wybierz pozycję Gotowe , aby zapisać i ponownie wdrożyć punkt końcowy.

Aby ponownie wdrożyć niestandardowy punkt końcowy przy użyciu nowego modelu, użyj spx csr model update polecenia . Skonstruuj parametry żądania zgodnie z następującymi instrukcjami:

- Ustaw wymagany

endpointparametr na identyfikator punktu końcowego, który chcesz wdrożyć. - Ustaw wymagany

modelparametr na identyfikator modelu, który ma zostać wdrożony w punkcie końcowym.

Oto przykładowe polecenie interfejsu wiersza polecenia usługi Mowa, które ponownie wdraża niestandardowy punkt końcowy przy użyciu nowego modelu:

spx csr endpoint update --api-version v3.1 --endpoint YourEndpointId --model YourModelId

Treść odpowiedzi powinna zostać wyświetlona w następującym formacie:

{

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/endpoints/98375aaa-40c2-42c4-b65c-f76734fc7790",

"model": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/models/1e47c19d-12ca-4ba5-b177-9e04bd72cf98"

},

"links": {

"logs": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/endpoints/98375aaa-40c2-42c4-b65c-f76734fc7790/files/logs",

"restInteractive": "https://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"restConversation": "https://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"restDictation": "https://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"webSocketInteractive": "wss://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"webSocketConversation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"webSocketDictation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790"

},

"project": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/projects/639d5280-8995-40cc-9329-051fd0fddd46"

},

"properties": {

"loggingEnabled": true

},

"lastActionDateTime": "2022-05-19T23:01:34Z",

"status": "NotStarted",

"createdDateTime": "2022-05-19T15:41:27Z",

"locale": "en-US",

"displayName": "My Endpoint",

"description": "My Updated Endpoint Description"

}

Aby uzyskać pomoc dotyczącą interfejsu wiersza polecenia usługi Mowa w punktach końcowych, uruchom następujące polecenie:

spx help csr endpoint

Aby ponownie wdrożyć niestandardowy punkt końcowy przy użyciu nowego modelu, użyj Endpoints_Update operacji zamiany mowy na tekst interfejsu API REST. Skonstruuj treść żądania zgodnie z następującymi instrukcjami:

modelUstaw właściwość na identyfikator URI modelu, który ma zostać wdrożony w punkcie końcowym.

Utwórz żądanie HTTP PATCH przy użyciu identyfikatora URI, jak pokazano w poniższym przykładzie. Zastąp YourSubscriptionKey ciąg kluczem zasobu usługi Mowa, zastąp element regionem zasobu usługi Mowa, zastąp YourServiceRegionYourEndpointId element identyfikatorem punktu końcowego i ustaw właściwości treści żądania zgodnie z wcześniejszym opisem.

curl -v -X PATCH -H "Ocp-Apim-Subscription-Key: YourSubscriptionKey" -H "Content-Type: application/json" -d '{

"model": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/models/1e47c19d-12ca-4ba5-b177-9e04bd72cf98"

}

}' "https://YourServiceRegion.api.cognitive.microsoft.com/speechtotext/v3.1/endpoints/YourEndpointId"

Treść odpowiedzi powinna zostać wyświetlona w następującym formacie:

{

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/endpoints/98375aaa-40c2-42c4-b65c-f76734fc7790",

"model": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/models/1e47c19d-12ca-4ba5-b177-9e04bd72cf98"

},

"links": {

"logs": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/endpoints/98375aaa-40c2-42c4-b65c-f76734fc7790/files/logs",

"restInteractive": "https://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"restConversation": "https://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"restDictation": "https://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"webSocketInteractive": "wss://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"webSocketConversation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"webSocketDictation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790"

},

"project": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/projects/639d5280-8995-40cc-9329-051fd0fddd46"

},

"properties": {

"loggingEnabled": true

},

"lastActionDateTime": "2022-05-19T23:01:34Z",

"status": "NotStarted",

"createdDateTime": "2022-05-19T15:41:27Z",

"locale": "en-US",

"displayName": "My Endpoint",

"description": "My Updated Endpoint Description"

}

Ponowne wdrożenie trwa kilka minut. W międzyczasie punkt końcowy używa poprzedniego modelu bez przerwy w działaniu usługi.

Wyświetlanie danych rejestrowania

Dane rejestrowania są dostępne do eksportowania, jeśli zostały skonfigurowane podczas tworzenia punktu końcowego.

Aby pobrać dzienniki punktu końcowego:

- Zaloguj się do programu Speech Studio.

- Wybierz pozycję Mowa> niestandardowa Nazwa >projektu Wdróż modele.

- Wybierz link według nazwy punktu końcowego.

- W obszarze Rejestrowanie zawartości wybierz pozycję Pobierz dziennik.

Aby uzyskać dzienniki dla punktu końcowego, użyj spx csr endpoint list polecenia . Skonstruuj parametry żądania zgodnie z następującymi instrukcjami:

- Ustaw wymagany

endpointparametr na identyfikator punktu końcowego, który chcesz pobrać dzienniki.

Oto przykładowe polecenie interfejsu wiersza polecenia usługi Mowa, które pobiera dzienniki dla punktu końcowego:

spx csr endpoint list --api-version v3.1 --endpoint YourEndpointId

Lokalizacje każdego pliku dziennika zawierające więcej szczegółów są zwracane w treści odpowiedzi.

Aby uzyskać dzienniki dla punktu końcowego, zacznij od użycia Endpoints_Get operacji interfejsu API REST zamiany mowy na tekst.

Utwórz żądanie HTTP GET przy użyciu identyfikatora URI, jak pokazano w poniższym przykładzie. Zastąp YourEndpointId ciąg swoim identyfikatorem punktu końcowego, zastąp YourSubscriptionKey ciąg kluczem zasobu usługi Mowa i zastąp YourServiceRegion element regionem zasobu usługi Mowa.

curl -v -X GET "https://YourServiceRegion.api.cognitive.microsoft.com/speechtotext/v3.1/endpoints/YourEndpointId" -H "Ocp-Apim-Subscription-Key: YourSubscriptionKey"

Treść odpowiedzi powinna zostać wyświetlona w następującym formacie:

{

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/endpoints/98375aaa-40c2-42c4-b65c-f76734fc7790",

"model": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/models/1e47c19d-12ca-4ba5-b177-9e04bd72cf98"

},

"links": {

"logs": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/endpoints/98375aaa-40c2-42c4-b65c-f76734fc7790/files/logs",

"restInteractive": "https://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"restConversation": "https://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"restDictation": "https://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"webSocketInteractive": "wss://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"webSocketConversation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"webSocketDictation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790"

},

"project": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/projects/2f78cdb7-58ac-4bd9-9bc6-170e31483b26"

},

"properties": {

"loggingEnabled": true

},

"lastActionDateTime": "2022-05-19T23:41:05Z",

"status": "Succeeded",

"createdDateTime": "2022-05-19T23:41:05Z",

"locale": "en-US",

"displayName": "My Endpoint",

"description": "My Updated Endpoint Description"

}

Utwórz żądanie HTTP GET przy użyciu identyfikatora URI "logs" z poprzedniej treści odpowiedzi. Zastąp YourEndpointId ciąg swoim identyfikatorem punktu końcowego, zastąp YourSubscriptionKey ciąg kluczem zasobu usługi Mowa i zastąp YourServiceRegion element regionem zasobu usługi Mowa.

curl -v -X GET "https://YourServiceRegion.api.cognitive.microsoft.com/speechtotext/v3.1/endpoints/YourEndpointId/files/logs" -H "Ocp-Apim-Subscription-Key: YourSubscriptionKey"

Lokalizacje każdego pliku dziennika zawierające więcej szczegółów są zwracane w treści odpowiedzi.

Dane rejestrowania są dostępne w magazynie należącym do firmy Microsoft przez 30 dni, a następnie są usuwane. Jeśli twoje własne konto magazynu jest połączone z subskrypcją usług Azure AI, dane rejestrowania nie zostaną automatycznie usunięte.