Monitorowanie środowiska Integration Runtime w zarządzanej sieci wirtualnej

DOTYCZY:  Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Napiwek

Wypróbuj usługę Data Factory w usłudze Microsoft Fabric — rozwiązanie analityczne typu all-in-one dla przedsiębiorstw. Usługa Microsoft Fabric obejmuje wszystko, od przenoszenia danych do nauki o danych, analizy w czasie rzeczywistym, analizy biznesowej i raportowania. Dowiedz się, jak bezpłatnie rozpocząć nową wersję próbną !

Zarządzaną siecią wirtualną usługi Azure Data Factory można bezpiecznie połączyć źródła danych z siecią wirtualną zarządzaną przez usługę Data Factory. Dzięki tej funkcji można ustanowić prywatne i izolowane środowisko dla procesów integracji i aranżacji danych.

W przypadku korzystania z zarządzanej sieci wirtualnej łączysz możliwości integracji i aranżacji danych w usłudze Data Factory z zabezpieczeniami i elastycznością sieci wirtualnych platformy Azure. Umożliwia tworzenie niezawodnych, skalowalnych i bezpiecznych potoków integracji danych, które bezproblemowo łączą się z zasobami sieciowymi, zarówno lokalnie, jak i w chmurze.

Jednym z typowych problemów z zarządzanymi obliczeniami jest brak wglądu w wydajność i kondycję, zwłaszcza w zarządzanym środowisku sieci wirtualnej. Bez odpowiedniego monitorowania identyfikowanie i rozwiązywanie problemów staje się trudne i może prowadzić do potencjalnych opóźnień, błędów i obniżenia wydajności.

Korzystając z rozszerzonego monitorowania w usłudze Data Factory, możesz uzyskać cenny wgląd w procesy integracji danych. Te szczegółowe informacje mogą prowadzić do zwiększenia wydajności, lepszego wykorzystania zasobów i zwiększenia ogólnej wydajności. Dzięki proaktywnemu monitorowaniu i odpowiednim alertom można rozwiązać problemy, zoptymalizować przepływy pracy i zapewnić bezproblemowe wykonywanie potoków integracji danych w zarządzanym środowisku sieci wirtualnej.

Nowe metryki

Wprowadzenie nowych metryk zwiększa widoczność i możliwości monitorowania w zarządzanych środowiskach sieci wirtualnej.

Usługa Azure Data Factory udostępnia trzy różne typy pul obliczeniowych:

- Obliczanie dla działania kopiowania

- Obliczanie dla działania potoku, takiego jak wyszukiwanie

- Obliczenia dla działania zewnętrznego, takiego jak notes usługi Azure Databricks

Te pule obliczeniowe zapewniają elastyczność i skalowalność, aby obsłużyć różne obciążenia i optymalnie przydzielić zasoby. Każdy z nich jest dostosowany do obsługi określonych wymagań dotyczących wykonywania działań.

Aby zapewnić spójne i kompleksowe monitorowanie we wszystkich pulach obliczeniowych, zaimplementowaliśmy te same zestawy metryk monitorowania:

- Wykorzystanie pojemności

- Procent dostępnej pojemności

- Długość kolejki oczekiwania

Niezależnie od typu puli obliczeniowej, której używasz, możesz uzyskać dostęp do ustandaryzowanego zestawu metryk i przeanalizować go, aby uzyskać wgląd w wydajność i kondycję działań integracji danych.

Uwaga

Te metryki są prawidłowe tylko wtedy, gdy włączasz czas wygaśnięcia (TTL) w środowisku Integration Runtime w zarządzanej sieci wirtualnej.

| Metric | Jednostka | opis |

|---|---|---|

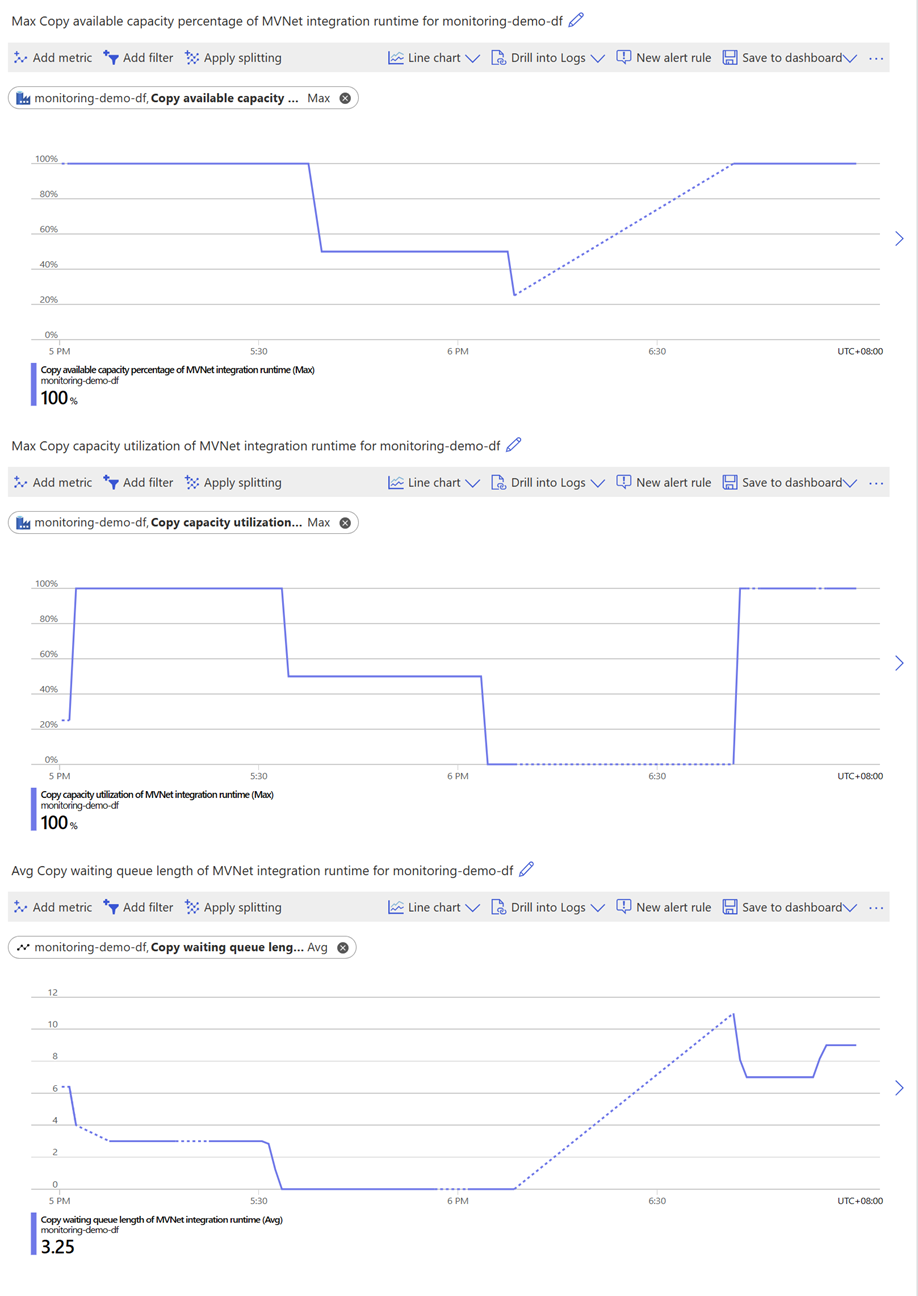

| Wykorzystanie pojemności kopiowania środowiska MVNet Integration Runtime | Procent | Maksymalny procent wykorzystania jednostek Integracja danych (DIU) dla działań kopiowania czasu wygaśnięcia w środowisku Integration Runtime zarządzanej sieci wirtualnej w ciągu 1-minutowego okna. |

| Procent dostępnej pojemności środowiska MVNet Integration Runtime | Procent | Maksymalny procent dostępnych jednostek DIU dla działań kopiowania czasu wygaśnięcia w środowisku Integration Runtime zarządzanej sieci wirtualnej w ciągu 1-minutowego okna. |

| Długość kolejki oczekiwania kopiowania środowiska MVNet Integration Runtime | Count | Długość kolejki oczekiwania działań kopiowania czasu wygaśnięcia w środowisku Integration Runtime zarządzanej sieci wirtualnej w ciągu 1-minutowego okna. |

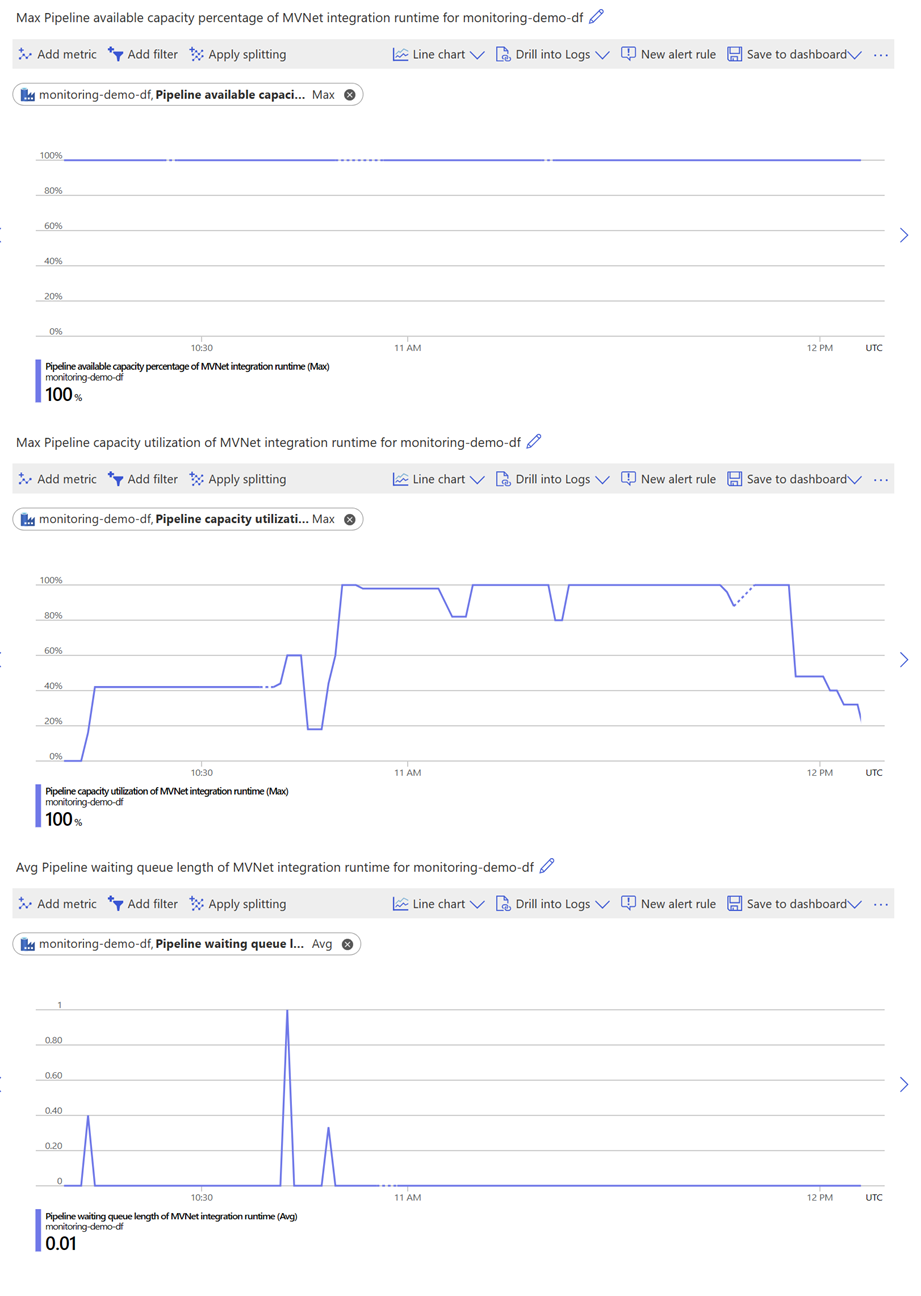

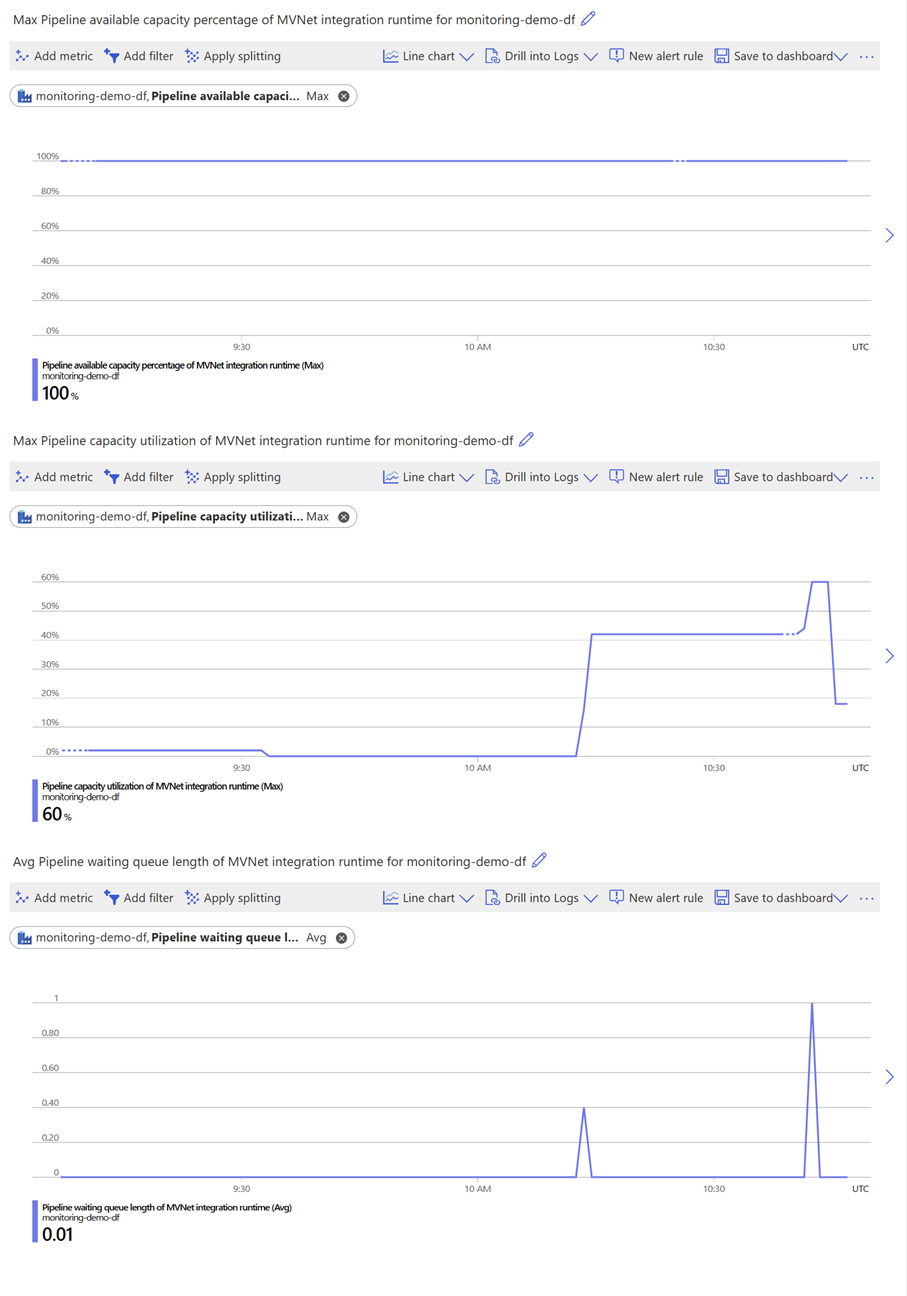

| Wykorzystanie pojemności potoku środowiska MVNet Integration Runtime | Procent | Maksymalny procent wykorzystania jednostek DIU dla działań potoku w środowisku Integration Runtime zarządzanej sieci wirtualnej w ciągu 1-minutowego okna. |

| Procent dostępnej pojemności potoku środowiska MVNet Integration Runtime | Procent | Maksymalny procent dostępnych jednostek DIU dla działań potoku w środowisku Integration Runtime zarządzanej sieci wirtualnej w ciągu 1-minutowego okna. |

| Długość kolejki oczekiwania potoku środowiska MVNet Integration Runtime | Count | Długość kolejki oczekujących działań potoku w środowisku Integration Runtime zarządzanej sieci wirtualnej w ciągu 1-minutowego okna. |

| Wykorzystanie pojemności zewnętrznej środowiska MVNet Integration Runtime | Procent | Maksymalny procent wykorzystania jednostek DIU dla działań zewnętrznych w środowisku Integration Runtime zarządzanej sieci wirtualnej w ciągu 1-minutowego okna. |

| Procent dostępnej pojemności zewnętrznej środowiska MVNet Integration Runtime | Procent | Maksymalny procent dostępnych jednostek DIU dla działań zewnętrznych w środowisku Integration Runtime zarządzanej sieci wirtualnej w ciągu 1-minutowego okna. |

| Zewnętrzna długość kolejki oczekiwania środowiska MVNet Integration Runtime | Count | Długość kolejki oczekujących działań zewnętrznych w środowisku Integration Runtime zarządzanej sieci wirtualnej w ciągu 1-minutowego okna. |

Aby uzyskać więcej informacji na temat tych metryk, zobacz Obsługiwane metryki dla microsoft.DataFactory/fabryk.

Używanie metryk na potrzeby optymalizacji wydajności

Korzystając z metryk, można bezproblemowo śledzić i oceniać wydajność i niezawodność środowiska Integration Runtime w zarządzanej sieci wirtualnej. Możesz również odkryć potencjalne obszary ciągłego ulepszania, optymalizując ustawienia obliczeniowe i przepływ pracy w celu zmaksymalizowania wydajności.

Aby zapewnić większą przejrzystość praktycznego stosowania tych metryk, poniżej przedstawiono kilka przykładowych scenariuszy.

Zrównoważone

Jeśli zauważysz, że wykorzystanie pojemności jest niższe niż 100 procent, a procent dostępnej pojemności jest wysoki, zasoby obliczeniowe zarezerwowane są efektywnie wykorzystywane.

Jeśli długość kolejki oczekiwania pozostaje stale niska lub występuje sporadyczne krótkie skoki, zalecamy kolejkowanie innych działań, dopóki wykorzystanie pojemności nie osiągnie 100 procent. Takie podejście pomaga zapewnić optymalne wykorzystanie zasobów i pomaga zachować płynny przepływ pracy z minimalnymi opóźnieniami.

Zorientowany na wydajność

Jeśli zauważysz, że wykorzystanie pojemności jest stale niskie, a długość kolejki oczekiwania pozostaje stale niska lub czasami występują krótkie skoki, zarezerwowane zasoby obliczeniowe są wyższe niż zapotrzebowanie na działania.

W takich przypadkach, niezależnie od tego, czy dostępna wartość procentowa pojemności jest wysoka, czy niska, zalecamy zmniejszenie przydzielonych zasobów obliczeniowych w celu obniżenia kosztów. Dzięki prawu do zasobów obliczeniowych, aby odpowiadały wymaganiom dotyczącym obciążenia, możesz zoptymalizować wykorzystanie zasobów i obniżyć koszty bez naruszania wydajności operacji.

Zorientowany na koszty

Jeśli zauważysz, że wszystkie metryki (w tym wykorzystanie pojemności, procent dostępnej pojemności i długość kolejki oczekiwania) są wysokie, zarezerwowane zasoby obliczeniowe prawdopodobnie nie będą wystarczające dla Twoich działań.

W tym scenariuszu zalecamy zwiększenie przydzielonych zasobów obliczeniowych w celu skrócenia czasu kolejki. Dodanie większej pojemności obliczeniowej pomaga zapewnić, że działania mają wystarczające zasoby do wydajnego działania, co minimalizuje opóźnienia, które powoduje zatłoczone kolejki.

Sporadyczne wykonywanie działań

Jeśli zauważysz, że wartość Procent dostępnej pojemności waha się między niskim i wysokim w określonym przedziale czasu, prawdopodobnie jest to spowodowane sporadycznym wykonywaniem działań, w którym skonfigurowany okres czasu wygaśnięcia (TTL) jest krótszy niż interwał między działaniami. Może to mieć znaczący wpływ na wydajność przepływu pracy. Aby rozwiązać ten problem, istnieją dwa możliwe rozwiązania. Najpierw można kolejkować więcej działań, aby utrzymać spójne obciążenie i efektywniej wykorzystać dostępne zasoby obliczeniowe. Utrzymując ciągłe zaangażowanie zasobów obliczeniowych, można uniknąć czasu rozgrzewki i uzyskać lepszą wydajność. Alternatywnie możesz rozważyć rozszerzenie okresu wygaśnięcia, aby dopasować go do interwału między działaniami. Gwarantuje to, że zasoby obliczeniowe pozostaną dostępne przez dłuższy czas, zmniejszając częstotliwość okresów rozgrzewania i optymalizując efektywność kosztową.

Implementując jedną z tych rozwiązań, można zwiększyć wydajność przepływu pracy, zminimalizować konsekwencje związane z kosztami i zapewnić bezproblemowe wykonywanie sporadycznie wykonywanych działań.

Powiązana zawartość

Przejdź do następującego artykułu, aby dowiedzieć się więcej o zarządzanych sieciach wirtualnych i zarządzanych prywatnych punktach końcowych: zarządzana sieć wirtualna usługi Azure Data Factory.