Migrowanie zoptymalizowanych punktów końcowych usługi LLM do aprowizowanej przepływności

W tym artykule opisano sposób migrowania istniejących punktów końcowych usługi LLM do aprowizowanego środowiska przepływności dostępnego przy użyciu interfejsów API modelu foundation.

Co zostanie zmienione?

Aprowizowana przepływność zapewnia prostsze środowisko uruchamiania zoptymalizowanych punktów końcowych obsługujących usługę LLM. Usługa Databricks zmodyfikowała system obsługi modelu LLM, tak aby:

- Zakresy skalowania w poziomie można skonfigurować w terminach natywnych dla języka LLM, takich jak tokeny na sekundę zamiast współbieżności.

- Klienci nie muszą już wybierać samych typów obciążeń procesora GPU.

Nowe punkty końcowe obsługujące usługę LLM są domyślnie tworzone z aprowizowaną przepływnością. Jeśli chcesz kontynuować wybieranie typu obciążenia procesora GPU, to środowisko jest obsługiwane tylko przy użyciu interfejsu API.

Migrowanie punktów końcowych usługi LLM do aprowizowanej przepływności

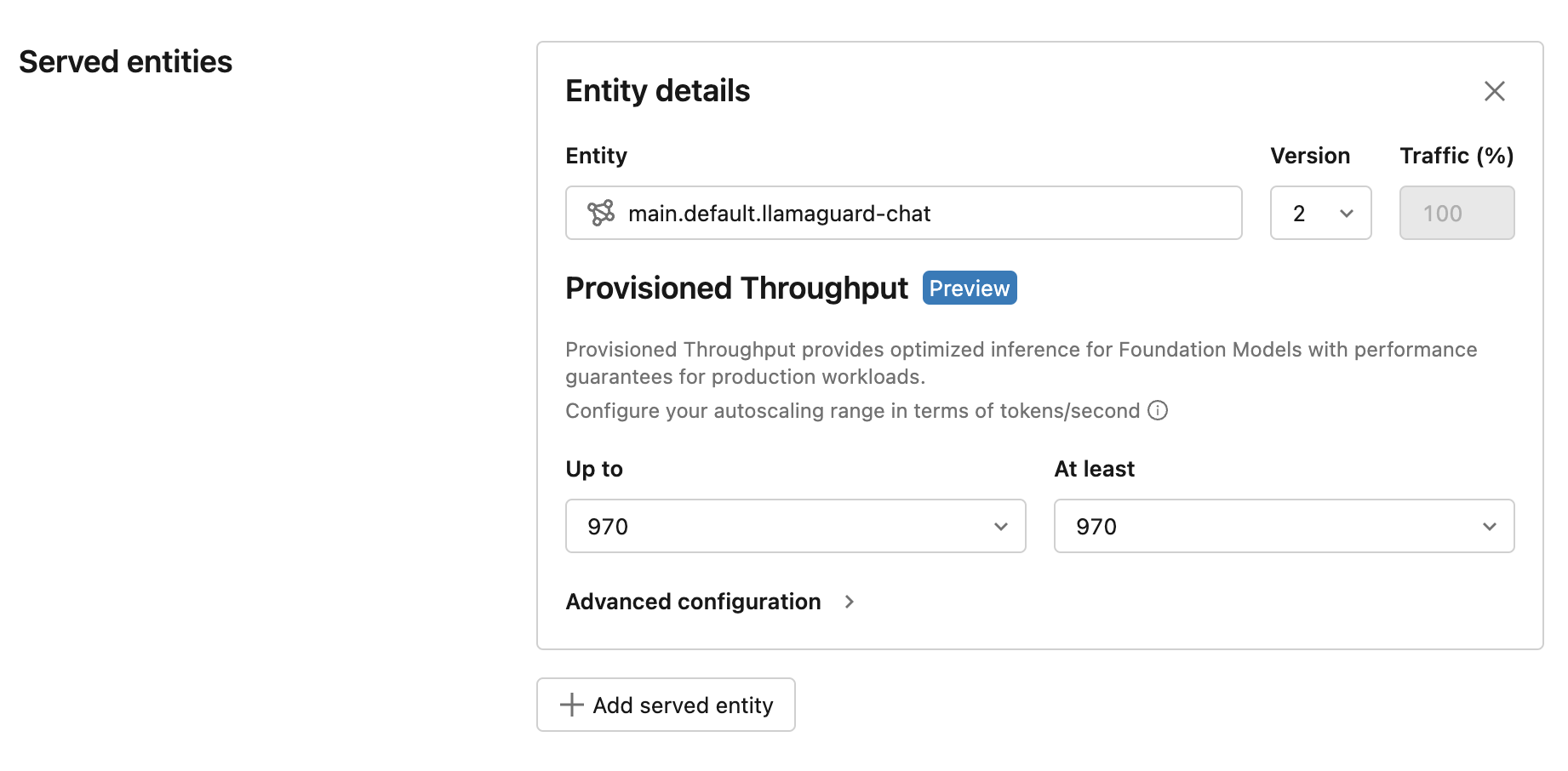

Najprostszym sposobem migracji istniejącego punktu końcowego do aprowizowanej przepływności jest zaktualizowanie punktu końcowego przy użyciu nowej wersji modelu. Po wybraniu nowej wersji modelu interfejs użytkownika wyświetla środowisko aprowizacji przepływności. Interfejs użytkownika przedstawia tokeny na sekundę na podstawie testów porównawczych usługi Databricks dla typowych przypadków użycia.

Wydajność dzięki tej zaktualizowanej ofercie jest ściśle lepsza z powodu ulepszeń optymalizacji, a cena punktu końcowego pozostaje niezmieniona. Skontaktuj się z nami, aby model-serving-feedback@databricks.com uzyskać opinie lub obawy dotyczące produktu.