Nuta

Dostęp do tej strony wymaga autoryzacji. Możesz spróbować się zalogować lub zmienić katalog.

Dostęp do tej strony wymaga autoryzacji. Możesz spróbować zmienić katalogi.

Na tej stronie opisano sposób przesyłania strumieniowego zmian z tabeli Delta. Delta Lake jest głęboko zintegrowana z Spark Structured Streaming za pośrednictwem i readStream. Usługa Delta Lake pokonuje wiele ograniczeń zwykle związanych z systemami przesyłania strumieniowego i plikami, w tym:

- Łączenie małych plików generowanych przez ładowanie z niskim opóźnieniem.

- Obsługa przetwarzania "dokładnie raz" przy użyciu więcej niż jednego strumienia (lub współbieżnych zadań wsadowych).

- Efektywne wykrywanie nowych plików przy używaniu plików jako źródła strumienia.

Note

W tym artykule opisano używanie tabel Delta Lake jako źródeł i odbiorników przesyłania strumieniowego. Aby dowiedzieć się, jak ładować dane przy użyciu tabel przesyłania strumieniowego w usłudze Databricks SQL, zobacz Używanie tabel przesyłania strumieniowego w usłudze Databricks SQL.

Aby uzyskać informacje na temat połączeń strumieniowo-statycznych z Delta Lake, zobacz Stream-static joins.

Zmiany strumienia

Jeśli chodzi o przesyłanie strumieniowe zmian z tabeli Delta na potrzeby przetwarzania przyrostowego, należy wziąć pod uwagę dwie opcje:

- Przesyłanie strumieniowe ze źródła danych przechwytywania zmian (CDC) tabeli delty.

- Przesyłaj strumieniowo z tabeli Delta.

Opcja 1 jest bardziej niezawodnym rozwiązaniem, a kod definiuje sposób przetwarzania różnych typów zdarzeń zmian, w tym wstawiania, aktualizacji i usuwania. Opcja 2 jest prostsza, ponieważ nie trzeba pisać kodu w celu przetwarzania zdarzeń zmiany. Jednak opcja 2 jest zalecana tylko wtedy, gdy źródłowa tabela delty jest dołączana. W przypadku zmian (na przykład aktualizacji i usuwania) w źródłowej tabeli Delta silnik strumieniowy Structured Streaming zgłasza wyjątek. Ten wyjątek można obsłużyć, przetwarzając ponownie wszystkie dane z tabeli źródłowej lub konfigurując je tak, aby ignorowały zmiany w tabeli źródłowej. Aby uzyskać więcej informacji, zobacz Ignorowanie aktualizacji i usuwania.

Databricks zaleca przesyłanie strumieniowe z kanału CDC tabeli Delta (opcja 1) zamiast samej tabeli Delta (opcja 2), jeśli to możliwe.

Opcja 1. Przesyłanie strumieniowe ze źródła danych przechwytywania zmian (CDC)

Delta Lake kanał danych o zmianach rejestruje zmiany w tabeli Delta, w tym aktualizacje i usuwanie. Po włączeniu można przesyłać strumieniowo ze źródła danych zmian i zapisywać logikę do przetwarzania wstawień, aktualizacji i usuwania do tabel podrzędnych. Mimo że dane wyjściowe strumienia danych zmian różnią się nieco od tabeli Delta, które opisuje, nadal pozwala na propagowanie przyrostowych zmian do dalszych tabel w architekturze medalonu.

Important

W środowisku Databricks Runtime 12.2 LTS i poniżej nie można przesyłać strumieniowo ze źródła danych zmian dla tabeli delty z włączonym mapowaniem kolumn, które przeszły ewolucję schematu nie addytywnego, na przykład zmiany nazw lub upuszczania kolumn. Zobacz Przesyłanie strumieniowe za pomocą mapowania kolumn i zmian schematu.

Opcja 2: Przesyłanie strumieniowe z tabeli Delta

Przesyłanie strumieniowe Structured Streaming przyrostowo odczytuje tabele Delta. Podczas gdy zapytanie przesyłane strumieniowo jest aktywne względem tabeli delty, nowe rekordy są przetwarzane idempotentnie, gdy nowe wersje tabeli są zatwierdzane w tabeli źródłowej.

Poniższe przykłady kodu pokazują, jak skonfigurować odczyt strumieniowy przy użyciu nazwy tabeli lub ścieżki pliku.

Python

spark.readStream.table("table_name")

spark.readStream.load("/path/to/table")

Scala

spark.readStream.table("table_name")

spark.readStream.load("/path/to/table")

Important

Jeśli zmieni się schemat tabeli Delta po rozpoczęciu odczytu strumieniowego z tabeli, zapytanie zakończy się niepowodzeniem. W przypadku większości zmian schematu można ponownie uruchomić strumień, aby rozwiązać niezgodność schematu i kontynuować przetwarzanie.

W środowisku Databricks Runtime 12.2 LTS i poniżej nie można przesyłać strumieniowo z tabeli Delta z włączonym mapowaniem kolumn, które przeszły ewolucję schematu, która nie jest dodatnia, na przykład zmianę nazwy lub usuwanie kolumn. Aby uzyskać szczegółowe informacje, zobacz Przesyłanie strumieniowe za pomocą mapowania kolumn i zmian schematu.

Ogranicz szybkość wprowadzania

Dostępne są następujące opcje do zarządzania mikropartiami.

-

maxFilesPerTrigger: ile nowych plików uwzględnić w każdej mikropartii. Wartość domyślna to 1000. -

maxBytesPerTrigger: ile danych jest przetwarzanych w każdej mikrosadowej partii. Ta opcja ustawia tak zwane "maksimum intencjonalne", co oznacza, że wsad przetwarza przybliżoną ilość danych i może przekroczyć ten limit, aby zapytanie w trybie strumieniowym mogło się przesunąć do przodu w sytuacjach, gdy najmniejsza jednostka wejściowa przekracza ten limit. Ta opcja nie jest domyślnie ustawiona.

Jeśli używasz maxBytesPerTrigger w połączeniu z maxFilesPerTrigger, mikrosadowe przetwarzanie danych trwa do momentu osiągnięcia limitu maxFilesPerTrigger lub maxBytesPerTrigger.

Note

W przypadkach, gdy transakcje tabeli źródłowej są czyszczone z powodu logRetentionDurationkonfiguracji, a zapytanie przesyłane strumieniowo próbuje przetworzyć te wersje, domyślnie zapytanie nie może uniknąć utraty danych. Możesz ustawić opcję z failOnDataLoss na false, aby ignorować utracone dane i kontynuować przetwarzanie.

Ignorowanie aktualizacji i usuwania

Podczas przesyłania strumieniowego z tabeli delty funkcja Structured Streaming nie obsługuje danych wejściowych, które nie są dodawane, i zgłasza wyjątek, jeśli na tabeli używanej jako źródło wystąpią jakiekolwiek modyfikacje. Istnieją dwie główne strategie radzenia sobie ze zmianami, których nie można automatycznie propagować podrzędnie:

- Możesz usunąć dane wyjściowe i punkt kontrolny oraz ponownie uruchomić strumień od początku.

- Możesz ustawić jedną z następujących opcji:

-

skipChangeCommits(zalecane): Ignoruje transakcje, które usuwają lub modyfikują istniejące rekordy. Ta opcja obejmujeignoreDeletes. -

ignoreDeletes(starsza wersja): ignoruje transakcje, które usuwają dane na granicach partycji. Ta opcja obsługuje tylko usunięcie pełnej partycji.

-

Note

Databricks zaleca użycie skipChangeCommits.

W środowisku Databricks Runtime 12.2 LTS i nowszym skipChangeCommits oznacza wycofanie poprzedniego ustawienia ignoreChanges. W środowisku Databricks Runtime 11.3 LTS i niższym jest ignoreChanges jedyną obsługiwaną opcją.

Semantyka ignoreChanges różni się znacznie od skipChangeCommits. Z włączoną opcją ignoreChanges przepisane pliki danych w tabeli źródłowej zostają ponownie wysyłane po operacji zmiany danych, takiej jak UPDATE, MERGE INTO, DELETE (w ramach partycji) lub OVERWRITE. Niezmienione wiersze są często emitowane obok nowych wierszy, więc odbiorcy podrzędni muszą mieć możliwość obsługi duplikatów. Usunięcia nie są propagowane w dół.

ignoreChanges obejmuje ignoreDeletes.

skipChangeCommits całkowicie ignoruje operacje zmiany plików. Pliki danych, które zostały przepisane w tabeli źródłowej z powodu operacji zmiany danych, takiej jak UPDATE, MERGE INTO, DELETEi OVERWRITE , są całkowicie ignorowane. Aby odzwierciedlić zmiany w nadrzędnych tabelach źródłowych, należy zaimplementować oddzielną logikę, aby propagować te zmiany.

Obciążenia skonfigurowane z ignoreChanges nadal działają przy użyciu znanych semantyki, ale usługa Databricks zaleca korzystanie z skipChangeCommits dla wszystkich nowych obciążeń. Migrowanie obciążeń przy użyciu polecenia ignoreChanges w celu skipChangeCommits wymaga logiki refaktoryzacji.

Example

Załóżmy na przykład, że masz tabelę user_events z kolumnami date, user_emaili action, które są partycjonowane przez date. Przesyłasz dane z tabeli user_events i musisz usunąć z niej dane ze względu na RODO.

Po usunięciu na granicach partycji (czyli WHERE znajduje się w kolumnie partycji), pliki są już podzielone według wartości, więc usunięcie po prostu usuwa te pliki z metadanych. Po usunięciu całej partycji danych można użyć następujących elementów:

spark.readStream

.option("ignoreDeletes", "true")

.table("user_events")

Jeśli usuniesz dane w wielu partycjach (w tym przykładzie filtrowanie według user_email), użyj następującej składni:

spark.readStream

.option("skipChangeCommits", "true")

.table("user_events")

Jeśli zaktualizujesz user_email za pomocą instrukcji UPDATE, plik zawierający dany user_email zostanie przepisany. Użyj polecenia skipChangeCommits , aby zignorować zmienione pliki danych.

Usługa Databricks zaleca użycie skipChangeCommits zamiast ignoreDeletes, chyba że masz pewność, że usunięcia są zawsze pełne usunięcia partycji.

Określanie pozycji początkowej

Poniższe opcje umożliwiają określenie punktu początkowego źródła przesyłania strumieniowego usługi Delta Lake bez przetwarzania całej tabeli.

startingVersion: wersja Delta Lake począwszy od. Usługa Databricks zaleca pominięcie tej opcji w przypadku większości obciążeń. Gdy nie jest określone, strumień rozpoczyna się od najnowszej dostępnej wersji, obejmującej pełną migawkę tabeli w tamtym momencie oraz przyszłe zmiany jako zmienne dane.Jeśli zostanie określony, strumień odczytuje wszystkie zmiany w tabeli delta, począwszy od określonej wersji (włącznie). Jeśli określona wersja nie jest już dostępna, uruchomienie strumienia nie powiedzie się. Wersje zatwierdzeń można uzyskać z kolumny

versiondanych wyjściowych polecenia DESCRIBE HISTORY.Aby zwrócić tylko najnowsze zmiany, określ wartość

latest.startingTimestamp: znacznik czasu do rozpoczęcia. Wszystkie zmiany tabeli zatwierdzone w momencie znacznika czasu lub później (włącznie) są odczytywane przez czytnik przesyłania strumieniowego. Jeśli podany znacznik czasu poprzedza wszystkie zatwierdzenia w tabeli, odczyt przesyłania strumieniowego rozpoczyna się od najwcześniejszego dostępnego znacznika czasu. Jeden z:- Łańcuch znacznika czasu. Na przykład

"2019-01-01T00:00:00.000Z". - Ciąg daty. Na przykład

"2019-01-01".

- Łańcuch znacznika czasu. Na przykład

Nie można jednocześnie ustawić obu opcji. Zaczynają obowiązywać tylko podczas uruchamiania nowego zapytania przesyłania strumieniowego. Jeśli zapytanie przesyłania strumieniowego zostało uruchomione i postęp został zarejestrowany w punkcie kontrolnym, te opcje są ignorowane.

Important

Chociaż źródło przesyłania strumieniowego można uruchomić z określonej wersji lub znacznika czasu, schemat źródła przesyłania strumieniowego jest zawsze najnowszym schematem tabeli Delta. Musisz upewnić się, że w tabeli Delta nie zaszła niezgodna zmiana schematu po określonej wersji lub znaczniku czasu. W przeciwnym razie źródło przesyłania strumieniowego może zwracać nieprawidłowe wyniki podczas odczytywania danych z nieprawidłowym schematem.

Example

Załóżmy na przykład, że masz tabelę user_events. Jeśli chcesz odczytać zmiany od wersji 5, użyj:

spark.readStream

.option("startingVersion", "5")

.table("user_events")

Jeśli chcesz odczytać zmiany od 2018-10-18, użyj:

spark.readStream

.option("startingTimestamp", "2018-10-18")

.table("user_events")

Przetwórz początkową migawkę bez utraty danych

Ta funkcja jest dostępna w środowisku Databricks Runtime 11.3 LTS lub nowszym.

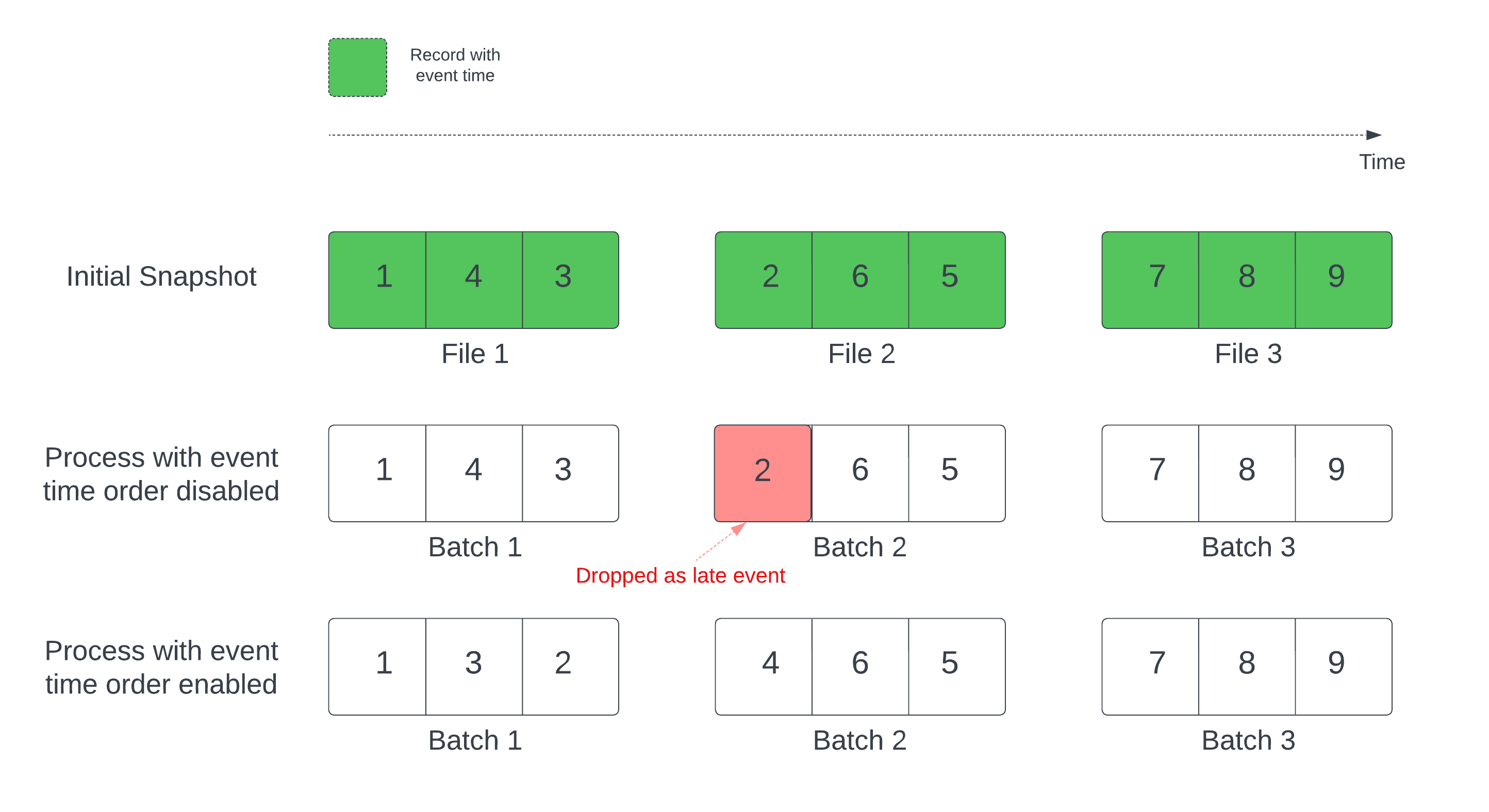

W przypadku używania tabeli delty jako źródła strumienia zapytanie najpierw przetwarza wszystkie dane obecne w tabeli. Tabela delta w tej wersji jest nazywana początkową migawką. Domyślnie pliki danych tabeli delty są przetwarzane na podstawie tego, który plik został ostatnio zmodyfikowany. Jednak czas ostatniej modyfikacji nie musi reprezentować kolejności czasu zdarzenia rekordu.

W zapytaniu strumieniowym stanowego ze zdefiniowanym znakiem wodnym przetwarzanie plików według czasu modyfikacji może spowodować przetworzenie rekordów w niewłaściwej kolejności. Może to prowadzić do upuszczania rekordów jako opóźnionych zdarzeń przez znak wodny.

Możesz uniknąć problemu z usuwaniem danych, włączając następującą opcję:

- withEventTimeOrder: czy początkowa migawka powinna być przetwarzana z kolejnością czasu zdarzenia.

Po włączeniu kolejności czasu zdarzenia zakres czasu początkowych danych migawki jest podzielony na przedziały czasu. Każda mikropartia przetwarza zbiornik, filtrując dane w określonym zakresie czasowym. Opcje konfiguracji maxFilesPerTrigger i maxBytesPerTrigger nadal mają zastosowanie do kontrolowania rozmiaru mikrobajta, ale tylko w przybliżony sposób ze względu na charakter przetwarzania.

Na poniższej ilustracji przedstawiono ten proces:

Istotne informacje o tej funkcji:

- Problem z usuwaniem danych pojawia się tylko wtedy, gdy początkowa migawka Delta z zapytania strumieniowego o stan jest przetwarzana w domyślnej kolejności.

- Nie można zmienić

withEventTimeOrderpo uruchomieniu zapytania strumieniowego, podczas gdy nadal przetwarzana jest początkowa migawka. Aby ponownie uruchomić zwithEventTimeOrderzmienionym, należy usunąć punkt kontrolny. - Jeśli uruchamiasz zapytanie strumienia z włączoną funkcjąEventTimeOrder, nie można zmienić jej na wersję środowiska Uruchomieniowego usługi Databricks, która nie obsługuje tej funkcji do momentu ukończenia początkowego przetwarzania migawki. Jeśli musisz obniżyć wersję, możesz poczekać na zakończenie początkowej migawki lub usunąć checkpoint i ponownie uruchomić zapytanie.

- Ta funkcja nie jest obsługiwana w następujących nietypowych scenariuszach:

- Kolumna czasu zdarzenia jest kolumną generowaną, a między źródłem Delta a znakiem wodnym istnieją przekształcenia niezwiązane z projekcją.

- Istnieje znak wodny, który ma więcej niż jedno źródło Delta w zapytaniu strumieniowym.

- Po włączeniu kolejności czasu zdarzenia wydajność początkowego przetwarzania migawek różnicowych może być niższa.

- Każda mikrosadowa skanuje początkową migawkę w celu filtrowania danych w odpowiednim zakresie czasu zdarzenia. Aby przyspieszyć działanie filtrowania, zaleca się użycie kolumny źródłowej Delta jako czasu zdarzenia, aby można było zastosować pomijanie danych (sprawdź Pomijanie danych dla Delta Lake, aby dowiedzieć się, kiedy jest ono możliwe). Ponadto partycjonowanie tabeli wzdłuż kolumny czasu zdarzenia może przyspieszyć przetwarzanie. Możesz sprawdzić interfejs użytkownika platformy Spark, aby zobaczyć, ile plików różnicowych jest skanowanych pod kątem określonej mikrosadowej partii.

Example

Załóżmy, że masz tabelę user_events z kolumną event_time. Zapytanie przesyłane strumieniowo jest zapytaniem agregacji. Jeśli chcesz mieć pewność, że podczas początkowego przetwarzania migawek nie ma żadnych danych, możesz użyć następujących funkcji:

spark.readStream

.option("withEventTimeOrder", "true")

.table("user_events")

.withWatermark("event_time", "10 seconds")

Note

Można również włączyć tę funkcję za pomocą konfiguracji platformy Spark w klastrze, która będzie stosowana do wszystkich zapytań przesyłania strumieniowego: spark.databricks.delta.withEventTimeOrder.enabled true

tabela Delta jako odbiornik

Dane można również zapisywać w tabeli Delta przy użyciu Structured Streaming. Dziennik transakcji umożliwia usłudze Delta Lake zagwarantowanie dokładnie jednokrotnego przetwarzania, nawet jeśli istnieją inne strumienie lub zapytania wsadowe uruchomione współbieżnie względem tabeli.

Podczas zapisywania w tabeli Delta przy użyciu ujścia strukturalnego przesyłania strumieniowego, można zaobserwować puste zatwierdzenia z epochId = -1. Są one oczekiwane i zwykle występują:

- W pierwszej partii każdego uruchomienia zapytania przesyłania strumieniowego (dzieje się to w każdej partii dla elementu

Trigger.AvailableNow). - Gdy schemat zostanie zmieniony (na przykład dodanie kolumny).

Te puste zatwierdzenia nie wpływają na poprawność ani wydajność zapytania w żaden istotny sposób. Są one zamierzone i nie wskazują błędu.

Note

Funkcja Delta Lake VACUUM usuwa wszystkie pliki, które nie są zarządzane przez usługę Delta Lake, ale pomija wszystkie katalogi rozpoczynające się od _. Punkty kontrolne można bezpiecznie przechowywać wraz z innymi danymi i metadanymi dla tabeli delty przy użyciu struktury katalogów, takiej jak <table-name>/_checkpoints.

Metrics

Liczbę bajtów i liczbę plików, które jeszcze nie zostały przetworzone, można znaleźć w procesie zapytań przesyłanych strumieniowo jako metryki i numBytesOutstanding. Dodatkowe metryki obejmują:

-

numNewListedFiles: liczba plików usługi Delta Lake wymienionych w celu obliczenia listy prac dla tej partii.-

backlogEndOffset: wersja tabeli używana do obliczania listy prac.

-

Jeśli używasz strumienia w notesie, możesz zobaczyć te metryki na karcie Nieprzetworzone dane na pulpicie nawigacyjnym postępu zapytania przesyłania strumieniowego:

{

"sources": [

{

"description": "DeltaSource[file:/path/to/source]",

"metrics": {

"numBytesOutstanding": "3456",

"numFilesOutstanding": "8"

}

}

]

}

Tryb dołączania

Domyślnie strumienie są uruchamiane w trybie dołączania, który dodaje nowe rekordy do tabeli.

Użyj metody toTable podczas przesyłania strumieniowego do tabel, co pokazano w poniższym przykładzie.

Python

(events.writeStream

.outputMode("append")

.option("checkpointLocation", "/tmp/delta/events/_checkpoints/")

.toTable("events")

)

Scala

events.writeStream

.outputMode("append")

.option("checkpointLocation", "/tmp/delta/events/_checkpoints/")

.toTable("events")

Tryb ukończenia

Możesz również użyć Structured Streaming, aby zastąpić całą tabelę przy każdym przetwarzaniu partii. Przykładem przypadku użycia jest obliczenie podsumowania przy użyciu agregacji:

Python

(spark.readStream

.table("events")

.groupBy("customerId")

.count()

.writeStream

.outputMode("complete")

.option("checkpointLocation", "/tmp/delta/eventsByCustomer/_checkpoints/")

.toTable("events_by_customer")

)

Scala

spark.readStream

.table("events")

.groupBy("customerId")

.count()

.writeStream

.outputMode("complete")

.option("checkpointLocation", "/tmp/delta/eventsByCustomer/_checkpoints/")

.toTable("events_by_customer")

Powyższy przykład stale aktualizuje tabelę zawierającą zagregowaną liczbę zdarzeń według klienta.

W przypadku aplikacji z bardziej łagodnymi wymaganiami dotyczącymi opóźnienia można zaoszczędzić zasoby obliczeniowe za pomocą wyzwalaczy jednorazowych. Służą do aktualizowania tabel podsumowujących agregację według ustalonego harmonogramu, przetwarzając tylko nowe dane, które dotarły od ostatniej aktualizacji.

Upsert z zapytań przesyłanych strumieniowo przy użyciu polecenia foreachBatch

Możesz użyć kombinacji merge i foreachBatch do zapisywania złożonych operacji upsert z zapytania przesyłania strumieniowego do Tabeli Delta. Zobacz Używanie polecenia foreachBatch do zapisu w dowolnych odbiornikach danych.

Ten wzorzec zawiera wiele aplikacji, w tym następujące:

- Zapisuj agregacje przesyłania strumieniowego w trybie aktualizacji: Jest to znacznie bardziej wydajne niż tryb końcowy.

-

Zapisywanie strumienia zmian bazy danych w tabeli Delta: zapytanie scalania do zapisywania danych o zmianach może być używane w

foreachBatchw celu ciągłego stosowania strumienia zmian do tabeli Delta. -

Zapisywanie strumienia danych w Tabeli Delta z deduplikacją: Zapytanie scalające wyłącznie do wstawiania do deduplikacji może być stosowane w

foreachBatchdo ciągłego zapisywania danych (z duplikatami) do Tabeli Delta z automatyczną deduplikacją.

Note

- Upewnij się, że instrukcja

mergewewnątrzforeachBatchjest idempotentna, ponieważ ponowne uruchomienia zapytania strumieniowego mogą wielokrotnie zastosować operację na tej samej partii danych. - W przypadku użycia

mergewforeachBatch, szybkość danych wejściowych zapytania przesyłania strumieniowego (zgłaszana przezStreamingQueryProgressi widoczna na wykresie szybkości w notesie) może być zgłaszana jako wielokrotność rzeczywistej szybkości generowania danych w źródle. Dzieje się tak, ponieważmergeodczytuje dane wejściowe wiele razy, co powoduje pomnożenie metryk wejściowych. Jeśli jest to wąskie gardło, możesz buforować partię DataFrame przedmerge, a następnie cofnąć jej buforowanie pomerge.

W poniższym przykładzie pokazano, jak można użyć programu SQL w programie foreachBatch , aby wykonać to zadanie:

Scala

// Function to upsert microBatchOutputDF into Delta table using merge

def upsertToDelta(microBatchOutputDF: DataFrame, batchId: Long) {

// Set the dataframe to view name

microBatchOutputDF.createOrReplaceTempView("updates")

// Use the view name to apply MERGE

// NOTE: You have to use the SparkSession that has been used to define the `updates` dataframe

microBatchOutputDF.sparkSession.sql(s"""

MERGE INTO aggregates t

USING updates s

ON s.key = t.key

WHEN MATCHED THEN UPDATE SET *

WHEN NOT MATCHED THEN INSERT *

""")

}

// Write the output of a streaming aggregation query into Delta table

streamingAggregatesDF.writeStream

.foreachBatch(upsertToDelta _)

.outputMode("update")

.start()

Python

# Function to upsert microBatchOutputDF into Delta table using merge

def upsertToDelta(microBatchOutputDF, batchId):

# Set the dataframe to view name

microBatchOutputDF.createOrReplaceTempView("updates")

# Use the view name to apply MERGE

# NOTE: You have to use the SparkSession that has been used to define the `updates` dataframe

# In Databricks Runtime 10.5 and below, you must use the following:

# microBatchOutputDF._jdf.sparkSession().sql("""

microBatchOutputDF.sparkSession.sql("""

MERGE INTO aggregates t

USING updates s

ON s.key = t.key

WHEN MATCHED THEN UPDATE SET *

WHEN NOT MATCHED THEN INSERT *

""")

# Write the output of a streaming aggregation query into Delta table

(streamingAggregatesDF.writeStream

.foreachBatch(upsertToDelta)

.outputMode("update")

.start()

)

Możesz również użyć interfejsów API Delta Lake do wykonania przesyłania strumieniowego operacji upsert, jak w poniższym przykładzie:

Scala

import io.delta.tables.*

val deltaTable = DeltaTable.forName(spark, "table_name")

// Function to upsert microBatchOutputDF into Delta table using merge

def upsertToDelta(microBatchOutputDF: DataFrame, batchId: Long) {

deltaTable.as("t")

.merge(

microBatchOutputDF.as("s"),

"s.key = t.key")

.whenMatched().updateAll()

.whenNotMatched().insertAll()

.execute()

}

// Write the output of a streaming aggregation query into Delta table

streamingAggregatesDF.writeStream

.foreachBatch(upsertToDelta _)

.outputMode("update")

.start()

Python

from delta.tables import *

deltaTable = DeltaTable.forName(spark, "table_name")

# Function to upsert microBatchOutputDF into Delta table using merge

def upsertToDelta(microBatchOutputDF, batchId):

(deltaTable.alias("t").merge(

microBatchOutputDF.alias("s"),

"s.key = t.key")

.whenMatchedUpdateAll()

.whenNotMatchedInsertAll()

.execute()

)

# Write the output of a streaming aggregation query into Delta table

(streamingAggregatesDF.writeStream

.foreachBatch(upsertToDelta)

.outputMode("update")

.start()

)

Idempotentne zapisy tabeli w foreachBatch

Note

Usługa Databricks zaleca skonfigurowanie oddzielnego zapisu strumieniowego dla każdego ujścia, które chcesz zaktualizować, zamiast używania foreachBatch. Dzieje się tak, ponieważ zapisy w wielu tabelach są serializowane podczas korzystania z polecenia "foreachBatch", co zmniejsza równoległość i zwiększa ogólne opóźnienie.

Tabele różnicowe obsługują następujące opcje DataFrameWriter, aby uczynić zapisy do wielu tabel w foreachBatch idempotentnymi:

-

txnAppId: unikatowy ciąg, który można zastosować przy każdym zapisie DataFrame. Na przykład możesz użyć identyfikatora StreamingQuery jakotxnAppId. -

txnVersion: monotonicznie rosnąca liczba, która działa jako wersja transakcji.

Delta Lake używa kombinacji txnAppId i txnVersion do identyfikowania zduplikowanych zapisów i ich ignorowania.

Jeśli zapis wsadowy zostanie przerwany z powodu awarii, ponowne uruchomienie partii używa tej samej aplikacji i identyfikatora partii, aby ułatwić środowisku uruchomieniowemu poprawne zidentyfikowanie zduplikowanych zapisów i zignorowanie ich. Identyfikator aplikacji (txnAppId) może być dowolnym unikatowym ciągiem generowanym przez użytkownika i nie musi być powiązany z identyfikatorem strumienia. Zobacz Używanie polecenia foreachBatch do zapisu w dowolnych odbiornikach danych.

Warning

Jeśli usuniesz punkt kontrolny przesyłania strumieniowego i ponownie uruchomisz zapytanie przy użyciu nowego punktu kontrolnego, musisz podać inny txnAppId. Nowe punkty kontrolne zaczynają się od identyfikatora partii 0. Usługa Delta Lake używa identyfikatora partii i txnAppId jako unikatowego klucza i pomija partie z już widocznymi wartościami.

W poniższym przykładzie kodu pokazano ten wzorzec:

Python

app_id = ... # A unique string that is used as an application ID.

def writeToDeltaLakeTableIdempotent(batch_df, batch_id):

batch_df.write.format(...).option("txnVersion", batch_id).option("txnAppId", app_id).save(...) # location 1

batch_df.write.format(...).option("txnVersion", batch_id).option("txnAppId", app_id).save(...) # location 2

streamingDF.writeStream.foreachBatch(writeToDeltaLakeTableIdempotent).start()

Scala

val appId = ... // A unique string that is used as an application ID.

streamingDF.writeStream.foreachBatch { (batchDF: DataFrame, batchId: Long) =>

batchDF.write.format(...).option("txnVersion", batchId).option("txnAppId", appId).save(...) // location 1

batchDF.write.format(...).option("txnVersion", batchId).option("txnAppId", appId).save(...) // location 2

}