Otwórz narzędzie LLM modelu

Narzędzie Open Model LLM umożliwia wykorzystanie różnych modeli Open Model i Foundational Models, takich jak Falcon i Llama 2, na potrzeby przetwarzania języka naturalnego w przepływie monitów usługi Azure Machine Learning.

Uwaga

Powiadomienie o wycofaniu: Narzędzie Open Model LLM zostało wycofane na rzecz narzędzia LLM, które zapewnia obsługę wszystkich modeli obsługiwanych przez interfejs API wnioskowania modelu azure AI, a tym samym zapewnia większą elastyczność.

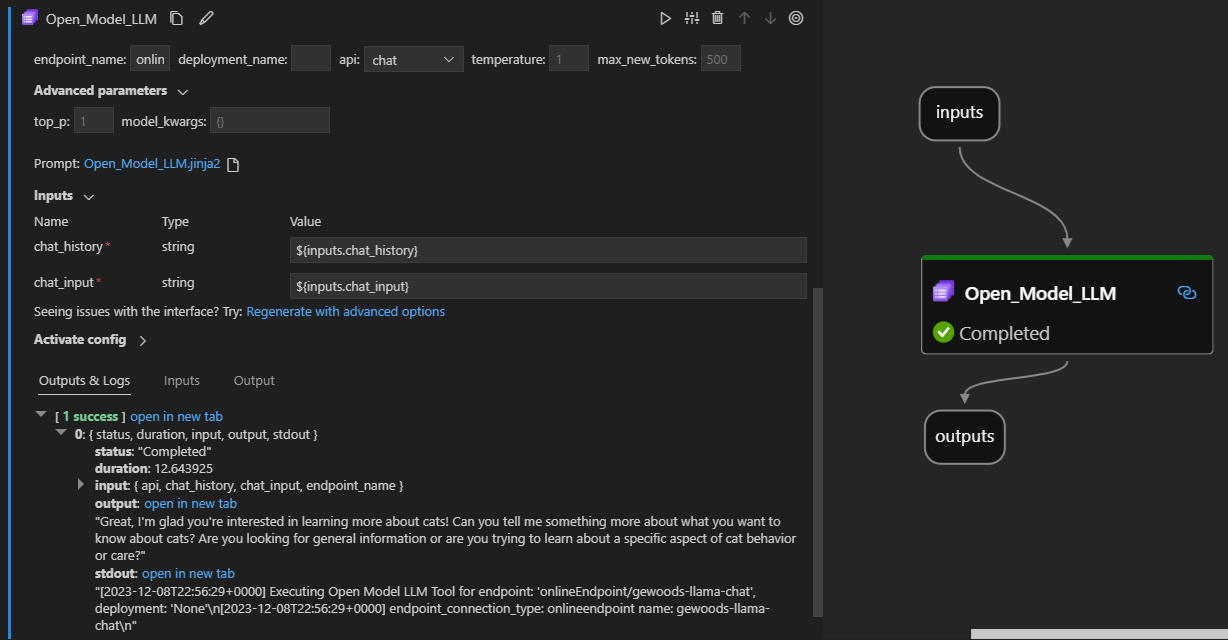

Oto jak wygląda ona w akcji w rozszerzeniu przepływu monitu programu Visual Studio Code. W tym przykładzie narzędzie jest używane do wywoływania punktu końcowego czatu LlaMa-2 i pytania "Co to jest ciągła integracja?".

To narzędzie przepływu monitów obsługuje dwa różne typy interfejsów API LLM:

- Czat: pokazany w poprzednim przykładzie. Typ interfejsu API czatu ułatwia interaktywne konwersacje z danymi wejściowymi i odpowiedziami opartymi na tekście.

- Uzupełnianie: typ interfejsu API uzupełniania służy do generowania uzupełniania tekstu pojedynczej odpowiedzi na podstawie podanych danych wejściowych monitu.

Krótkie omówienie: Jak mogę użyć narzędzia Open Model LLM?

- Wybierz model z katalogu modeli usługi Azure Machine Learning i uzyskaj go wdrożony.

- Nawiąż połączenie z wdrożeniem modelu.

- Skonfiguruj ustawienia narzędzi open model llm.

- Przygotuj monit.

- Uruchamianie przepływu.

Wymagania wstępne: wdrażanie modelu

- Wybierz model pasujący do scenariusza z katalogu modeli usługi Azure Machine Learning.

- Użyj przycisku Wdróż, aby wdrożyć model w punkcie końcowym wnioskowania online usługi Azure Machine Learning.

- Użyj jednej z opcji wdrażania z płatnością zgodnie z rzeczywistym użyciem.

Aby dowiedzieć się więcej, zobacz Wdrażanie modeli podstawowych w punktach końcowych na potrzeby wnioskowania.

Wymagania wstępne: nawiązywanie połączenia z modelem

Aby przepływ monitował o użycie wdrożonego modelu, musisz nawiązać z nim połączenie. Istnieją dwa sposoby nawiązywania połączenia.

Połączenia punktów końcowych

Po skojarzeniu przepływu z obszarem roboczym usługi Azure Machine Learning lub Azure AI Studio narzędzie Open Model LLM może używać punktów końcowych w tym obszarze roboczym.

Korzystanie z obszarów roboczych usługi Azure Machine Learning lub Azure AI Studio: jeśli używasz przepływu monitu w jednym z obszarów roboczych przeglądarek opartych na stronie internetowej, punkty końcowe online dostępne w tym obszarze roboczym automatycznie.

Najpierw przy użyciu programu VS Code lub kodu: jeśli używasz przepływu monitów w programie VS Code lub jednej z ofert Code First, musisz nawiązać połączenie z obszarem roboczym. Narzędzie Open Model LLM używa klienta azure.identity DefaultAzureCredential do autoryzacji. Jednym ze sposobów jest ustawienie wartości poświadczeń środowiska.

Połączenia niestandardowe

Narzędzie Open Model LLM używa polecenia CustomConnection. Przepływ monitów obsługuje dwa typy połączeń:

Połączenia obszaru roboczego — połączenia przechowywane jako wpisy tajne w obszarze roboczym usługi Azure Machine Learning. Chociaż te połączenia mogą być używane, w wielu miejscach są one często tworzone i utrzymywane w interfejsie użytkownika programu Studio. Aby dowiedzieć się, jak utworzyć połączenie niestandardowe w interfejsie użytkownika programu Studio, zobacz jak utworzyć połączenie niestandardowe.

Połączenia lokalne — połączenia przechowywane lokalnie na maszynie. Te połączenia nie są dostępne w środowisku użytkownika programu Studio, ale mogą być używane z rozszerzeniem programu VS Code. Aby dowiedzieć się, jak utworzyć lokalne połączenie niestandardowe, zobacz jak utworzyć połączenie lokalne.

Wymagane klucze do ustawienia to:

- endpoint_url

- Tę wartość można znaleźć w utworzonym wcześniej punkcie końcowym wnioskowania.

- endpoint_api_key

- Upewnij się, że ustawiono ją jako wartość wpisu tajnego.

- Tę wartość można znaleźć w utworzonym wcześniej punkcie końcowym wnioskowania.

- model_family

- Obsługiwane wartości: LLAMA, DOLLY, GPT2 lub FALCON

- Ta wartość zależy od typu docelowego wdrożenia.

Uruchamianie narzędzia: dane wejściowe

Narzędzie Open Model LLM ma wiele parametrów, z których niektóre są wymagane. Aby uzyskać szczegółowe informacje, zobacz poniższą tabelę, aby uzyskać szczegółowe informacje, możesz dopasować te parametry do powyższego zrzutu ekranu, aby uzyskać czytelność wizualną.

| Nazwisko | Pisz | Opis | Wymagania |

|---|---|---|---|

| api | string | Tryb interfejsu API, który zależy od używanego modelu i wybranego scenariusza. Obsługiwane wartości: (Ukończenie | Czat) | Tak |

| endpoint_name | string | Nazwa punktu końcowego wnioskowania online z wdrożonym modelem. Przejmuje priorytet nad połączeniem. | Tak |

| temperature | liczba zmiennoprzecinkowa | Losowość wygenerowanego tekstu. Wartość domyślna to 1. | Nie. |

| max_new_tokens | integer | Maksymalna liczba tokenów do wygenerowania w zakończeniu. Wartość domyślna to 500. | Nie. |

| top_p | liczba zmiennoprzecinkowa | Prawdopodobieństwo użycia najlepszego wyboru z wygenerowanych tokenów. Wartość domyślna to 1. | Nie. |

| model_kwargs | słownik | Te dane wejściowe są używane do zapewnienia konfiguracji specyficznej dla używanego modelu. Na przykład model Llama-02 może używać elementu {"temperature":0.4}. Domyślny: {} | Nie. |

| deployment_name | string | Nazwa wdrożenia docelowego w punkcie końcowym wnioskowania online. Jeśli żadna wartość nie zostanie przekazana, zostaną użyte ustawienia ruchu modułu równoważenia obciążenia wnioskowania. | Nie. |

| monit | string | Monit tekstowy używany przez model językowy do wygenerowania odpowiedzi. | Tak |

Dane wyjściowe

| interfejs API | Zwracany typ | opis |

|---|---|---|

| Zakończenie | string | Tekst jednego przewidywanego ukończenia |

| Czat | string | Tekst jednej odpowiedzi int konwersacji |

Wdrażanie w punkcie końcowym online

Podczas wdrażania przepływu zawierającego narzędzie Open Model LLM do punktu końcowego online istnieje dodatkowy krok konfigurowania uprawnień. Podczas wdrażania za pośrednictwem stron internetowych istnieje wybór typów tożsamości przypisanych przez system i tożsamości przypisanych przez użytkownika. Tak czy inaczej, korzystając z witryny Azure Portal (lub podobnej funkcjonalności), dodaj rolę funkcji "Czytelnik" zadania do tożsamości w obszarze roboczym usługi Azure Machine Learning lub w projekcie Ai Studio, który hostuje punkt końcowy. Może być konieczne odświeżenie wdrożenia przepływu monitu.