Przechwytywanie danych z usługi Event Hubs w formacie Parquet

W tym artykule wyjaśniono, jak używać edytora kodu do automatycznego przechwytywania danych przesyłanych strumieniowo w usłudze Event Hubs na koncie usługi Azure Data Lake Storage Gen2 w formacie Parquet.

Wymagania wstępne

Przestrzeń nazw usługi Azure Event Hubs z centrum zdarzeń i kontem usługi Azure Data Lake Storage Gen2 z kontenerem do przechowywania przechwyconych danych. Te zasoby muszą być publicznie dostępne i nie mogą znajdować się za zaporą ani zabezpieczone w sieci wirtualnej platformy Azure.

Jeśli nie masz centrum zdarzeń, utwórz je, postępując zgodnie z instrukcjami z przewodnika Szybki start: tworzenie centrum zdarzeń.

Jeśli nie masz konta usługi Data Lake Storage Gen2, utwórz je, postępując zgodnie z instrukcjami z sekcji Tworzenie konta magazynu

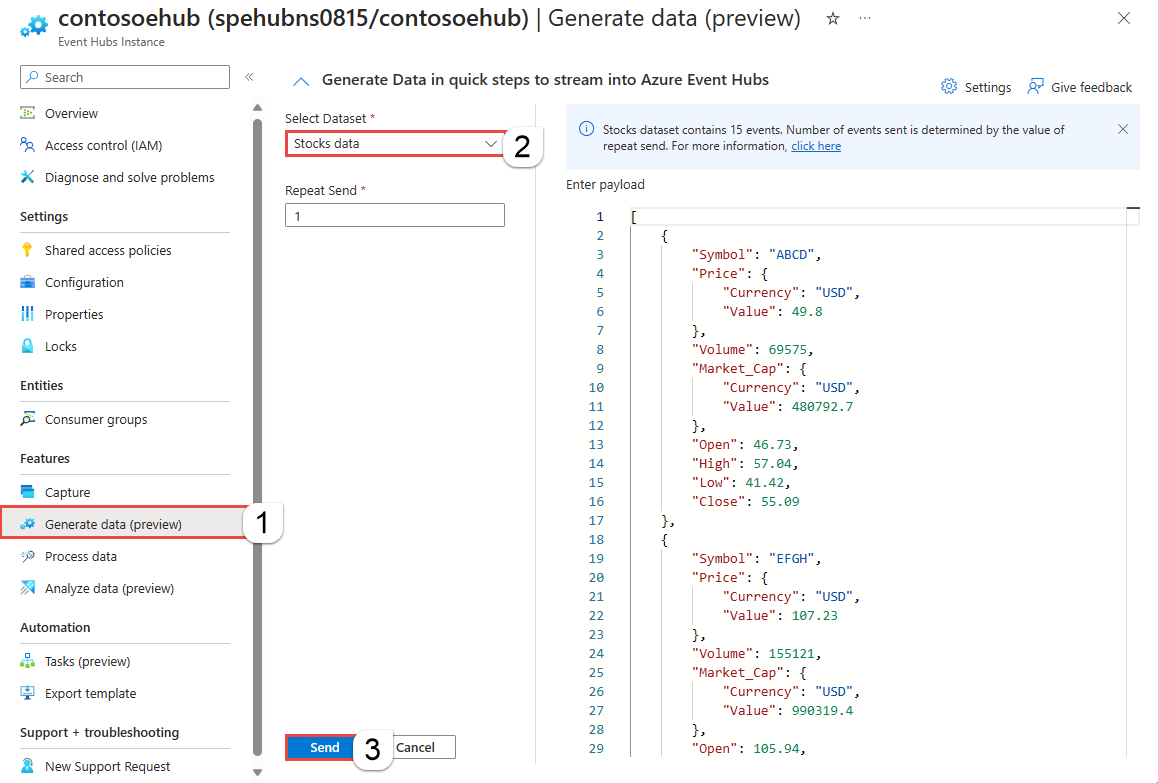

Dane w usłudze Event Hubs muszą być serializowane w formacie JSON, CSV lub Avro. Na potrzeby testowania wybierz pozycję Generuj dane (wersja zapoznawcza) w menu po lewej stronie, wybierz pozycję Zapasy danych dla zestawu danych, a następnie wybierz pozycję Wyślij.

Konfigurowanie zadania przechwytywania danych

Wykonaj poniższe kroki, aby skonfigurować zadanie usługi Stream Analytics do przechwytywania danych w usłudze Azure Data Lake Storage Gen2.

W witrynie Azure Portal przejdź do centrum zdarzeń.

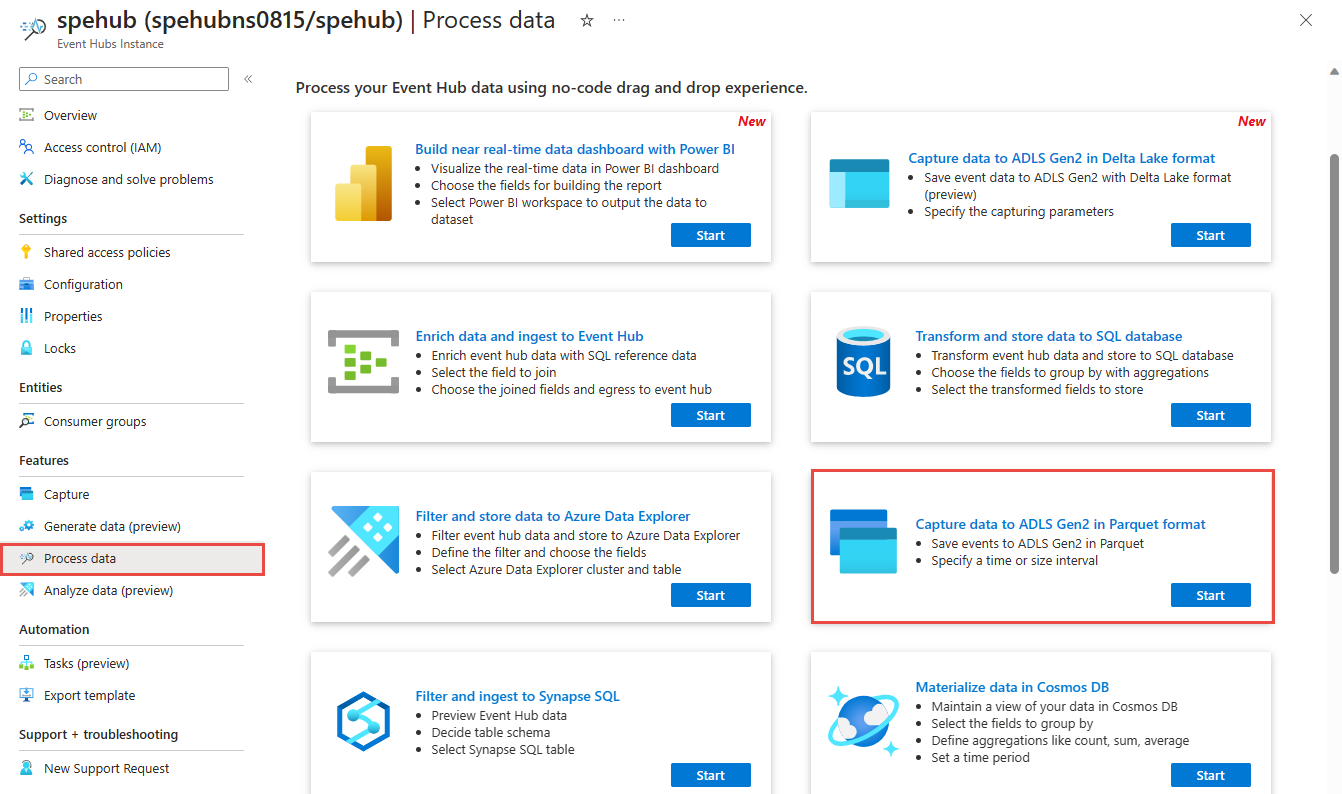

W menu po lewej stronie wybierz pozycję Przetwarzanie danych w obszarze Funkcje. Następnie wybierz pozycję Rozpocznij na karcie Przechwytywanie danych do usługi ADLS Gen2 na karcie formatu Parquet.

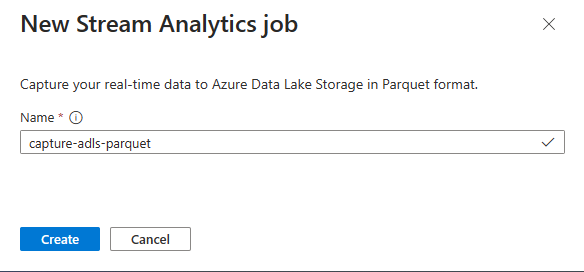

Wprowadź nazwę zadania usługi Stream Analytics, a następnie wybierz pozycję Utwórz.

Określ typ serializacji danych w usłudze Event Hubs i metodę uwierzytelniania używaną przez zadanie do nawiązywania połączenia z usługą Event Hubs. Następnie wybierz pozycję Połącz.

Po pomyślnym nawiązaniu połączenia zobaczysz:

Pola, które znajdują się w danych wejściowych. Możesz wybrać pozycję Dodaj pole lub wybrać trzy symbol kropki obok pola, aby opcjonalnie usunąć, zmienić nazwę lub zmienić jego nazwę.

Przykład na żywo danych przychodzących w tabeli Podgląd danych w widoku diagramu. Okresowo jest odświeżane. Możesz wybrać pozycję Wstrzymaj podgląd przesyłania strumieniowego, aby wyświetlić statyczny widok przykładowych danych wejściowych.

Wybierz kafelek Azure Data Lake Storage Gen2, aby edytować konfigurację.

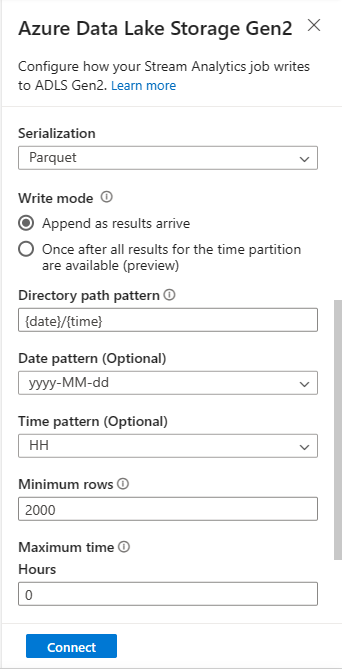

Na stronie konfiguracji usługi Azure Data Lake Storage Gen2 wykonaj następujące kroki:

Wybierz subskrypcję, nazwę konta magazynu i kontener z menu rozwijanego.

Po wybraniu subskrypcji należy automatycznie wypełnić metodę uwierzytelniania i klucz konta magazynu.

Wybierz pozycję Parquet w polu Format serializacji .

W przypadku przesyłania strumieniowego obiektów blob wzorzec ścieżki katalogu powinien być wartością dynamiczną. Data musi być częścią ścieżki pliku dla obiektu blob , do których odwołuje się

{date}element . Aby dowiedzieć się więcej o niestandardowych wzorcach ścieżek, zobacz Partycjonowanie niestandardowych danych wyjściowych obiektów blob w usłudze Azure Stream Analytics.Wybierz pozycję Połącz

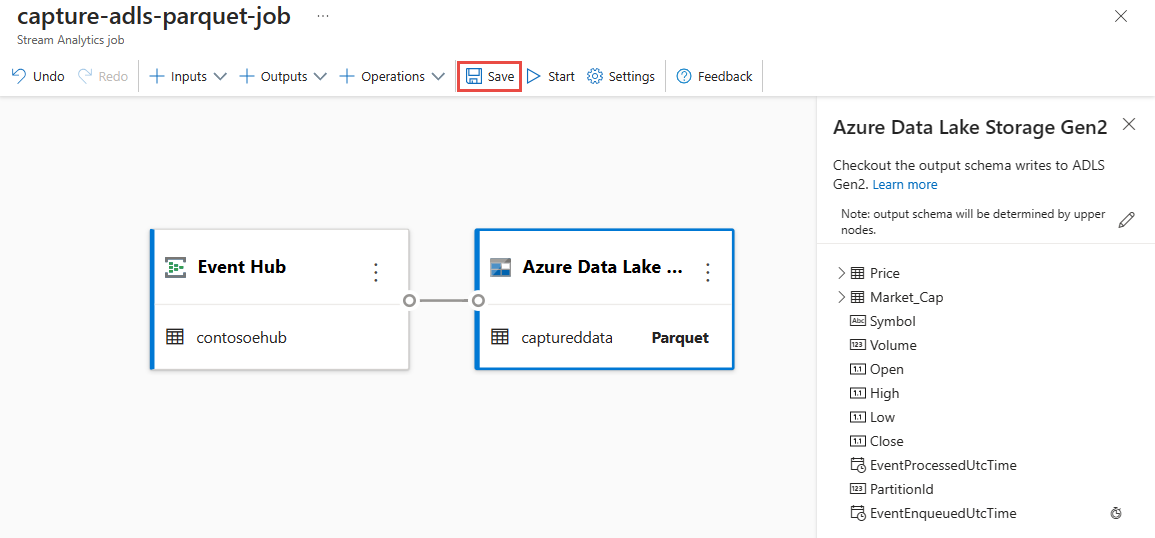

Po nawiązaniu połączenia zostaną wyświetlone pola, które znajdują się w danych wyjściowych.

Wybierz pozycję Zapisz na pasku poleceń, aby zapisać konfigurację.

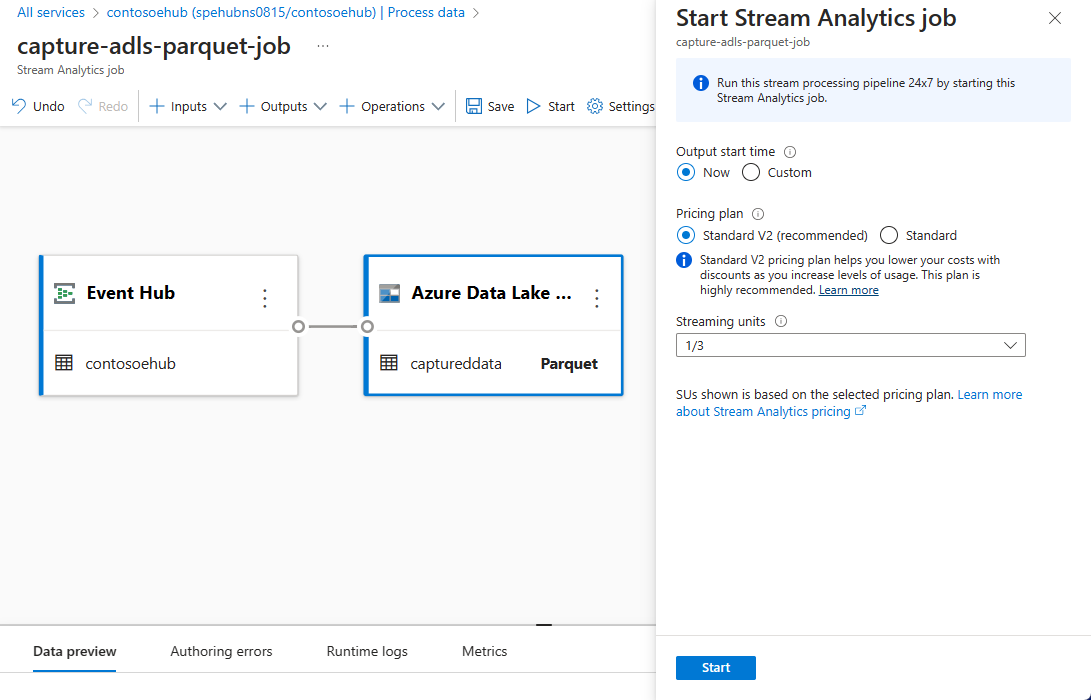

Wybierz pozycję Start na pasku poleceń, aby uruchomić przepływ przesyłania strumieniowego w celu przechwycenia danych. Następnie w oknie Uruchamianie zadania usługi Stream Analytics:

Wybierz godzinę rozpoczęcia danych wyjściowych.

Wybierz plan cenowy.

Wybierz liczbę jednostek przesyłania strumieniowego (SU), z którymi jest uruchamiane zadanie. Funkcja SU reprezentuje zasoby obliczeniowe przydzielone do wykonywania zadania usługi Stream Analytics. Aby uzyskać więcej informacji, zobacz Jednostki przesyłania strumieniowego w usłudze Azure Stream Analytics.

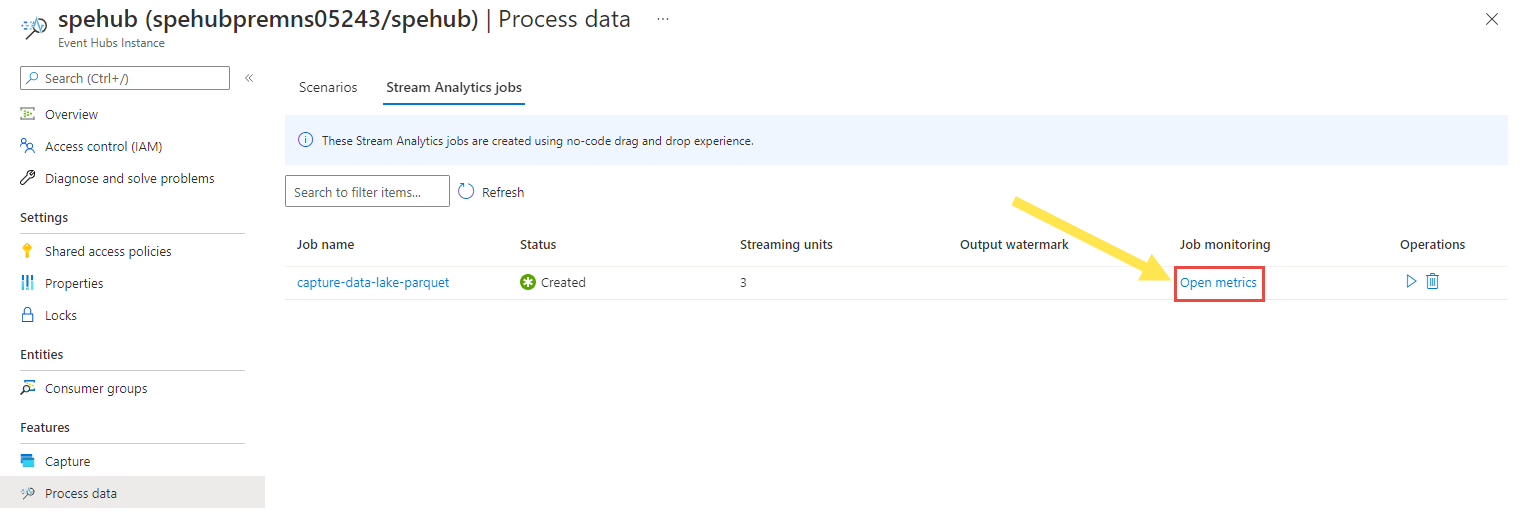

Zadanie analityczne usługi Stream powinno zostać wyświetlone na karcie Zadanie usługi Stream Analytics na stronie Przetwarzanie danych dla centrum zdarzeń.

Weryfikacja danych wyjściowych

Na stronie wystąpienia usługi Event Hubs dla centrum zdarzeń wybierz pozycję Generuj dane, wybierz pozycję Zapasy danych dla zestawu danych, a następnie wybierz pozycję Wyślij, aby wysłać przykładowe dane do centrum zdarzeń.

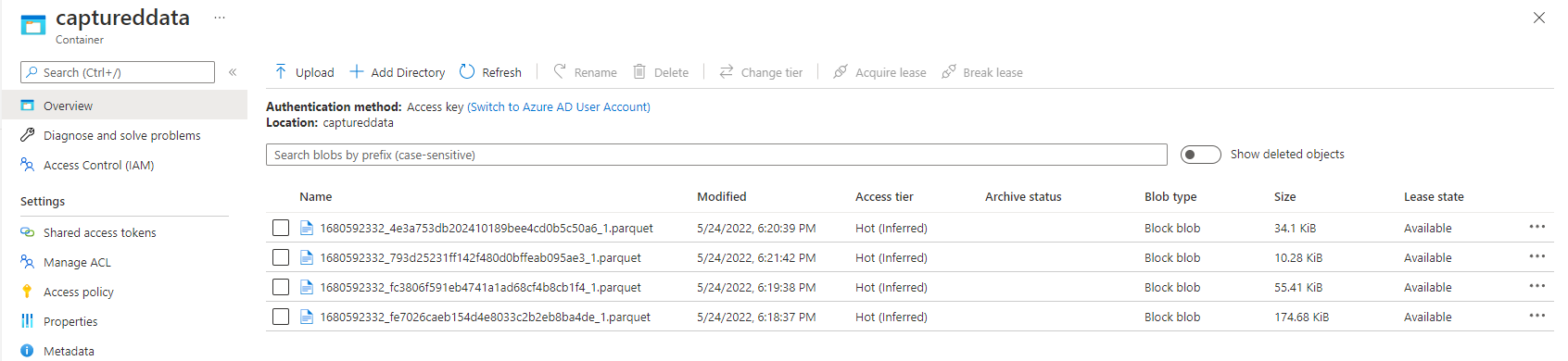

Sprawdź, czy pliki Parquet są generowane w kontenerze usługi Azure Data Lake Storage.

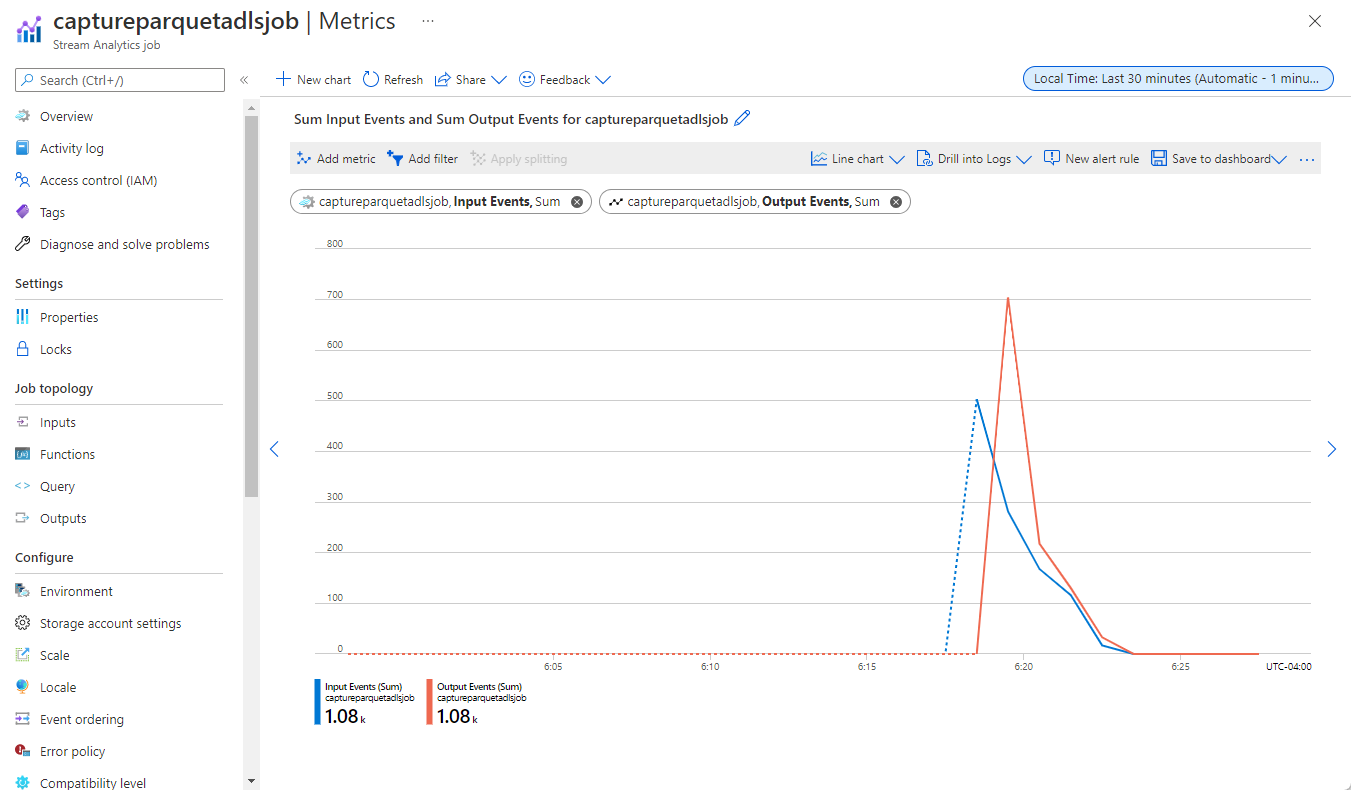

Wybierz pozycję Przetwarzanie danych w menu po lewej stronie. Przejdź do karty Zadania usługi Stream Analytics. Wybierz pozycję Otwórz metryki , aby je monitorować.

Oto przykładowy zrzut ekranu przedstawiający metryki przedstawiające zdarzenia wejściowe i wyjściowe.

Zagadnienia dotyczące korzystania z funkcji replikacji geograficznej usługi Event Hubs

Usługa Azure Event Hubs niedawno uruchomiła funkcję replikacji geograficznej w publicznej wersji zapoznawczej. Ta funkcja różni się od funkcji odzyskiwania po awarii geograficznej w usłudze Azure Event Hubs.

Gdy typ trybu failover jest wymuszony , a spójność replikacji jest asynchroniczna, zadanie usługi Stream Analytics nie gwarantuje dokładnie raz danych wyjściowych danych wyjściowych usługi Azure Event Hubs.

Usługa Azure Stream Analytics, jako producent z centrum zdarzeń, może obserwować opóźnienie limitu w zadaniu w czasie trwania pracy w trybie failover i podczas ograniczania przepustowości przez usługę Event Hubs w przypadku opóźnienia replikacji między główną i pomocniczą osiąga maksymalne skonfigurowane opóźnienie.

Usługa Azure Stream Analytics, jako użytkownik z usługą Event Hubs jako dane wejściowe, może obserwować opóźnienie limitu w zadaniu podczas trwania trybu failover i może pominąć dane lub znaleźć zduplikowane dane po zakończeniu pracy w trybie failover.

Ze względu na te zastrzeżenia zalecamy ponowne uruchomienie zadania usługi Stream Analytics z odpowiednim czasem rozpoczęcia bezpośrednio po zakończeniu pracy w trybie failover usługi Event Hubs. Ponadto, ponieważ funkcja replikacji geograficznej usługi Event Hubs jest dostępna w publicznej wersji zapoznawczej, nie zalecamy używania tego wzorca dla produkcyjnych zadań usługi Stream Analytics. Bieżące zachowanie usługi Stream Analytics poprawi się, zanim funkcja replikacji geograficznej usługi Event Hubs będzie ogólnie dostępna i może być używana w zadaniach produkcyjnych usługi Stream Analytics.

Następne kroki

Teraz wiesz, jak używać edytora kodu usługi Stream Analytics do utworzenia zadania, które przechwytuje dane usługi Event Hubs w usłudze Azure Data Lake Storage Gen2 w formacie Parquet. Następnie możesz dowiedzieć się więcej o usłudze Azure Stream Analytics i sposobie monitorowania utworzonego zadania.