Samouczek: przechwytywanie danych usługi Event Hubs w formacie parquet i analizowanie za pomocą usługi Azure Synapse Analytics

W tym samouczku pokazano, jak za pomocą edytora kodu usługi Stream Analytics utworzyć zadanie przechwytujące dane usługi Event Hubs w celu Azure Data Lake Storage Gen2 w formacie parquet.

Ten samouczek zawiera informacje na temat wykonywania następujących czynności:

- Wdrażanie generatora zdarzeń wysyłającego przykładowe zdarzenia do centrum zdarzeń

- Tworzenie zadania usługi Stream Analytics przy użyciu edytora kodu

- Przeglądanie danych wejściowych i schematu

- Konfigurowanie Azure Data Lake Storage Gen2, do którego będą przechwytywane dane centrum zdarzeń

- Uruchamianie zadania usługi Stream Analytics

- Wykonywanie zapytań dotyczących plików parquet za pomocą usługi Azure Synapse Analytics

Wymagania wstępne

Przed rozpoczęciem upewnij się, że zostały wykonane następujące kroki:

- Jeśli nie masz subskrypcji platformy Azure, utwórz bezpłatne konto.

- Wdróż aplikację generatora zdarzeń usługi TollApp na platformie Azure. Ustaw parametr "interval" na wartość 1 i użyj nowej grupy zasobów dla tego kroku.

- Utwórz obszar roboczy usługi Azure Synapse Analytics przy użyciu konta Data Lake Storage Gen2.

Tworzenie zadania usługi Stream Analytics za pomocą edytora kodu

Znajdź grupę zasobów, w której wdrożono generator zdarzeń usługi TollApp.

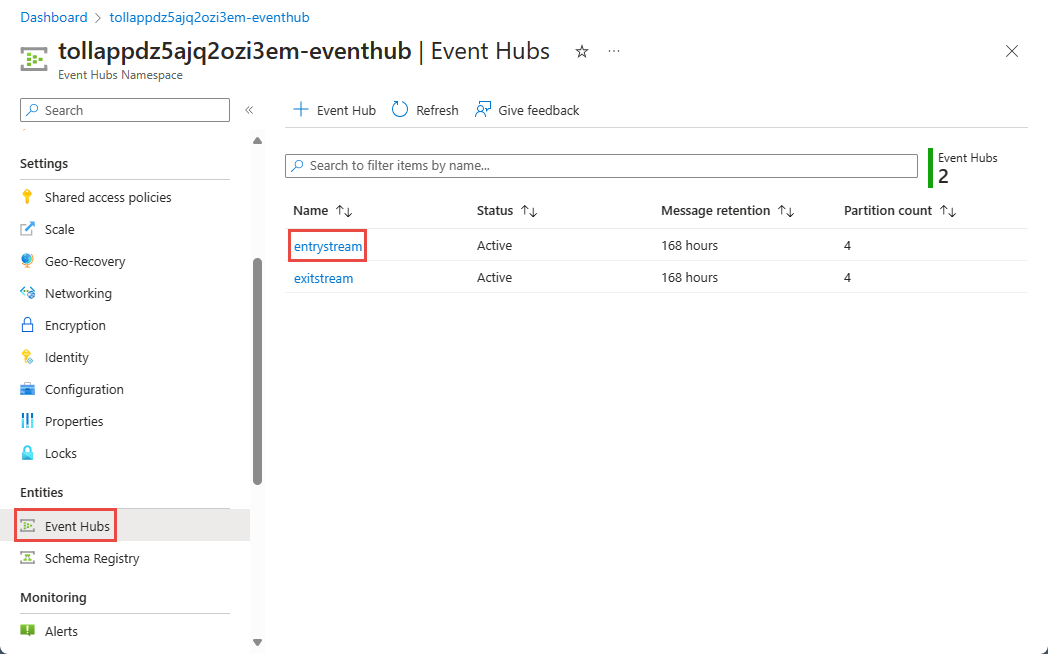

Wybierz Azure Event Hubs przestrzeni nazw.

Na stronie Przestrzeń nazw usługi Event Hubs wybierz pozycję Event Hubs w obszarze Jednostki w menu po lewej stronie.

Wybierz

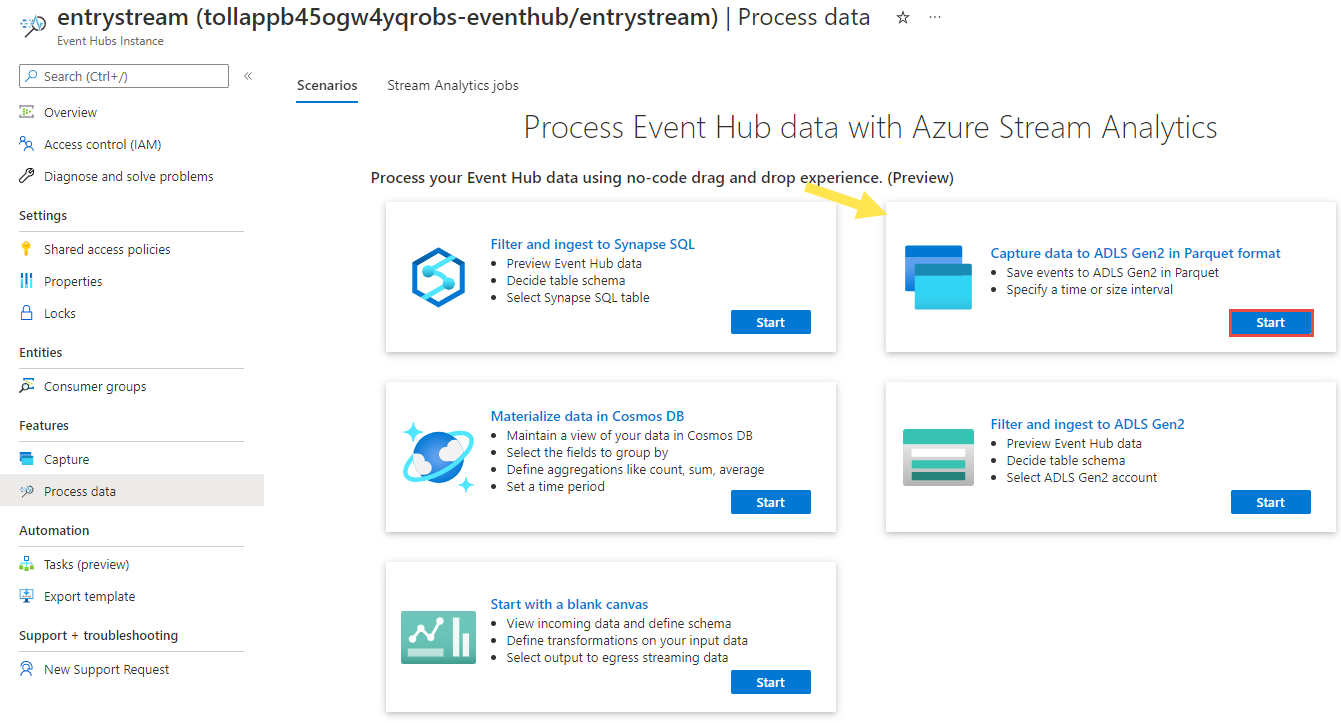

entrystreamwystąpienie.Na stronie wystąpienia usługi Event Hubs wybierz pozycję Przetwarzanie danych w sekcji Funkcje w menu po lewej stronie.

Wybierz pozycję Start na kafelku Przechwytywanie danych do usługi ADLS Gen2 w formacie Parquet .

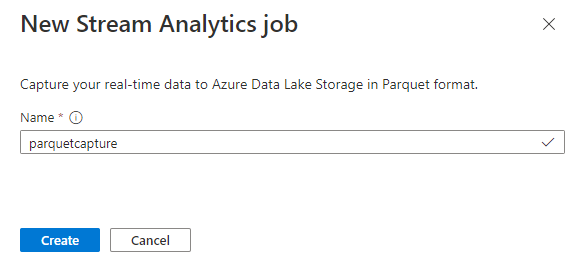

Nadaj zadanie nazwę

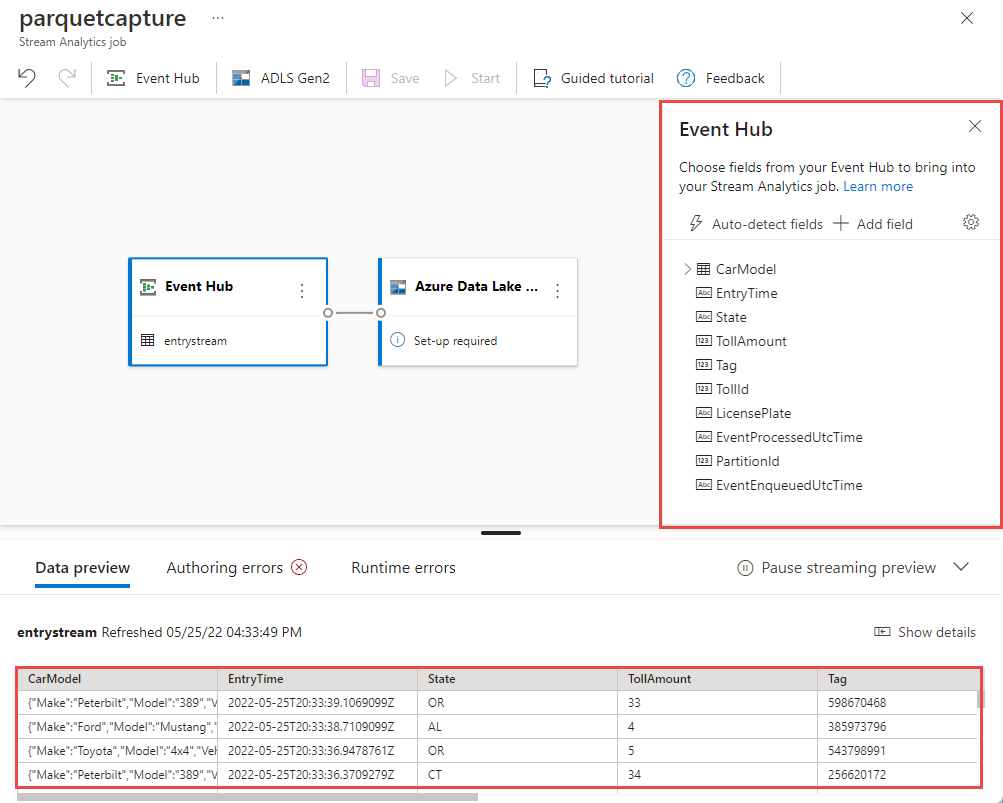

parquetcapturei wybierz pozycję Utwórz.Na stronie konfiguracji centrum zdarzeń potwierdź następujące ustawienia, a następnie wybierz pozycję Połącz.

W ciągu kilku sekund zobaczysz przykładowe dane wejściowe i schemat. Możesz usunąć pola, zmienić nazwę pól lub zmienić typ danych.

Wybierz kafelek Azure Data Lake Storage Gen2 na kanwie i skonfiguruj go, określając

- Subskrypcja, w której znajduje się konto usługi Azure Data Lake Gen2

- Nazwa konta magazynu, które powinno być tym samym kontem usługi ADLS Gen2 używanym z obszarem roboczym usługi Azure Synapse Analytics w sekcji Wymagania wstępne.

- Kontener, w którym zostaną utworzone pliki Parquet.

- Wzorzec ścieżki ustawiony na {date}/{time}

- Wzorzec daty i godziny jako domyślny rrrr-mm-dd i HH.

- Wybierz pozycję Połącz

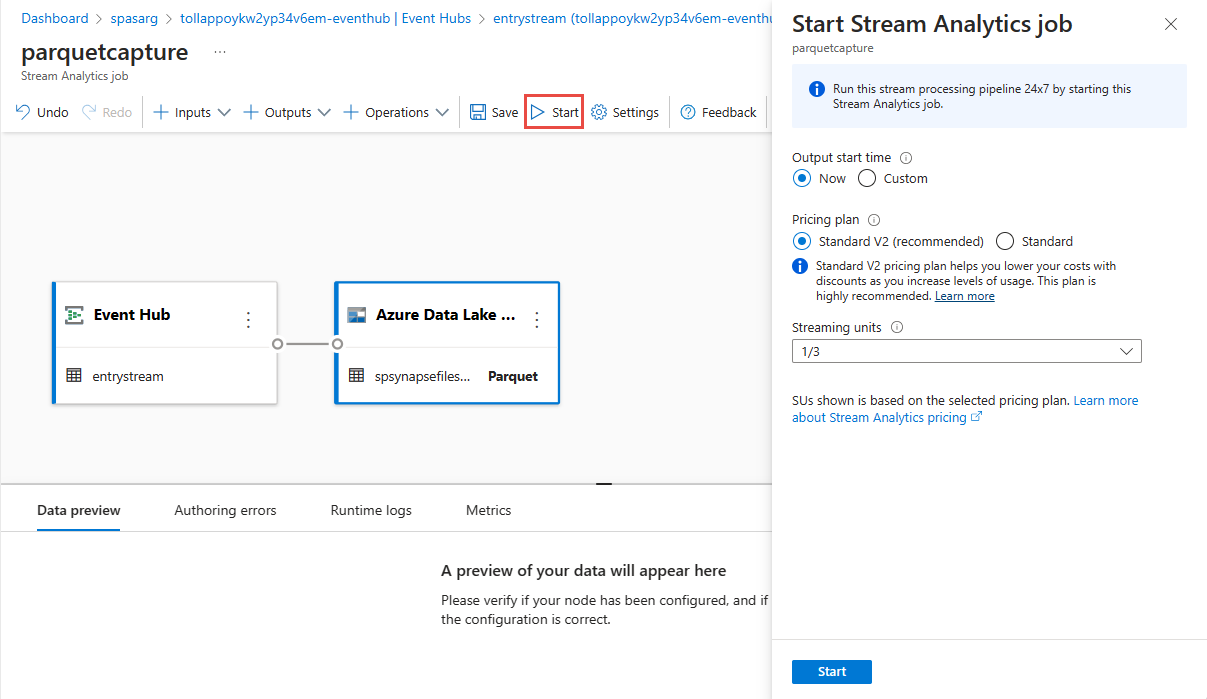

Wybierz pozycję Zapisz na górnej wstążce, aby zapisać zadanie, a następnie wybierz pozycję Uruchom , aby uruchomić zadanie. Po uruchomieniu zadania wybierz pozycję X w prawym rogu, aby zamknąć stronę zadania usługi Stream Analytics .

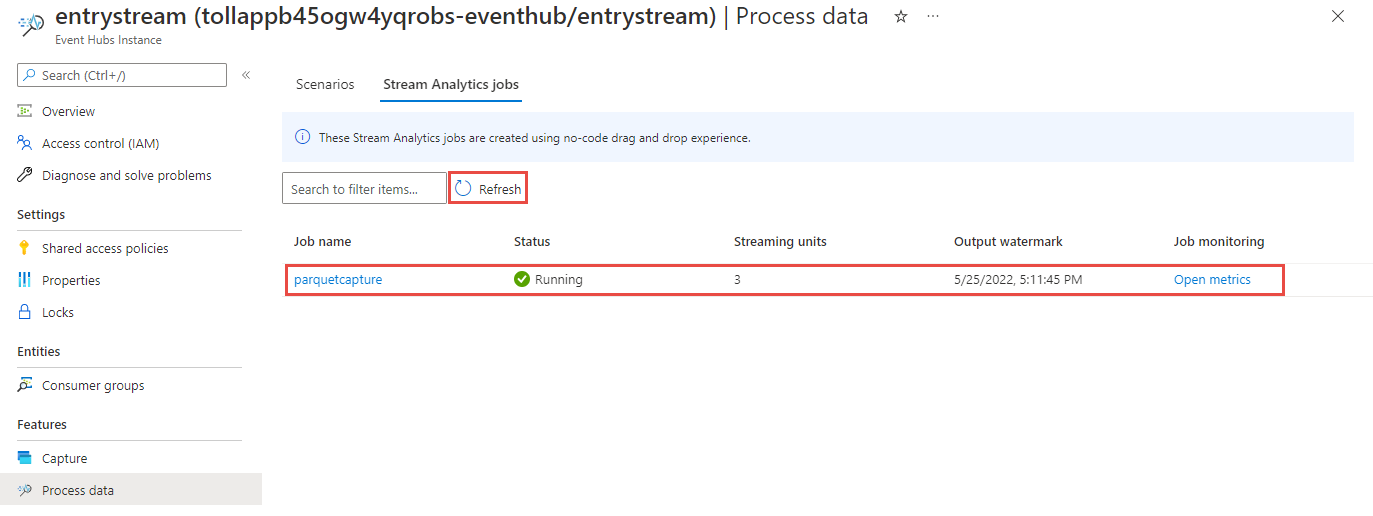

Następnie zostanie wyświetlona lista wszystkich zadań usługi Stream Analytics utworzonych przy użyciu edytora kodu bez. W ciągu dwóch minut zadanie przejdzie do stanu Uruchomiono . Wybierz przycisk Odśwież na stronie, aby zobaczyć zmianę stanu z Utworzone —> uruchamianie —> uruchamianie.

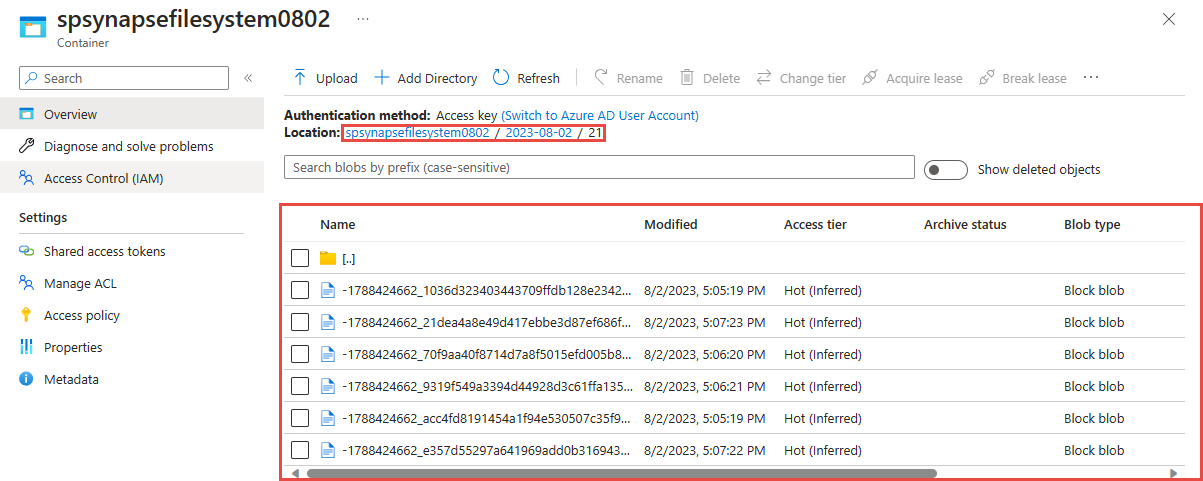

Wyświetlanie danych wyjściowych na koncie usługi Azure Data Lake Storage Gen 2

Znajdź konto Azure Data Lake Storage Gen2 użyte w poprzednim kroku.

Wybierz kontener, który został użyty w poprzednim kroku. Zobaczysz pliki parquet utworzone na podstawie wzorca ścieżki {date}/{time} użytego w poprzednim kroku.

Wykonywanie zapytań dotyczących przechwyconych danych w formacie Parquet za pomocą usługi Azure Synapse Analytics

Wykonywanie zapytań przy użyciu platformy Azure Synapse Spark

Znajdź obszar roboczy usługi Azure Synapse Analytics i otwórz Synapse Studio.

Utwórz bezserwerową pulę platformy Apache Spark w obszarze roboczym, jeśli jeszcze nie istnieje.

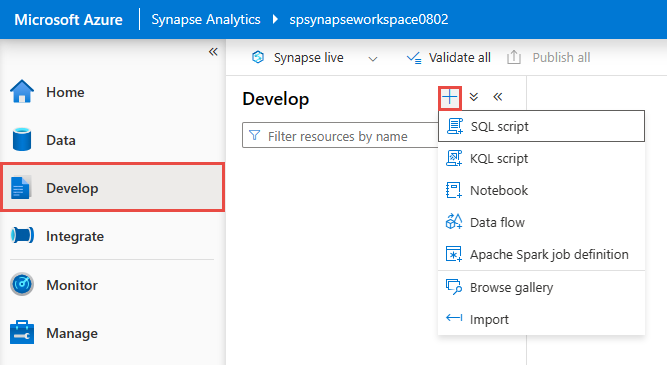

W Synapse Studio przejdź do centrum Programowanie i utwórz nowy notes.

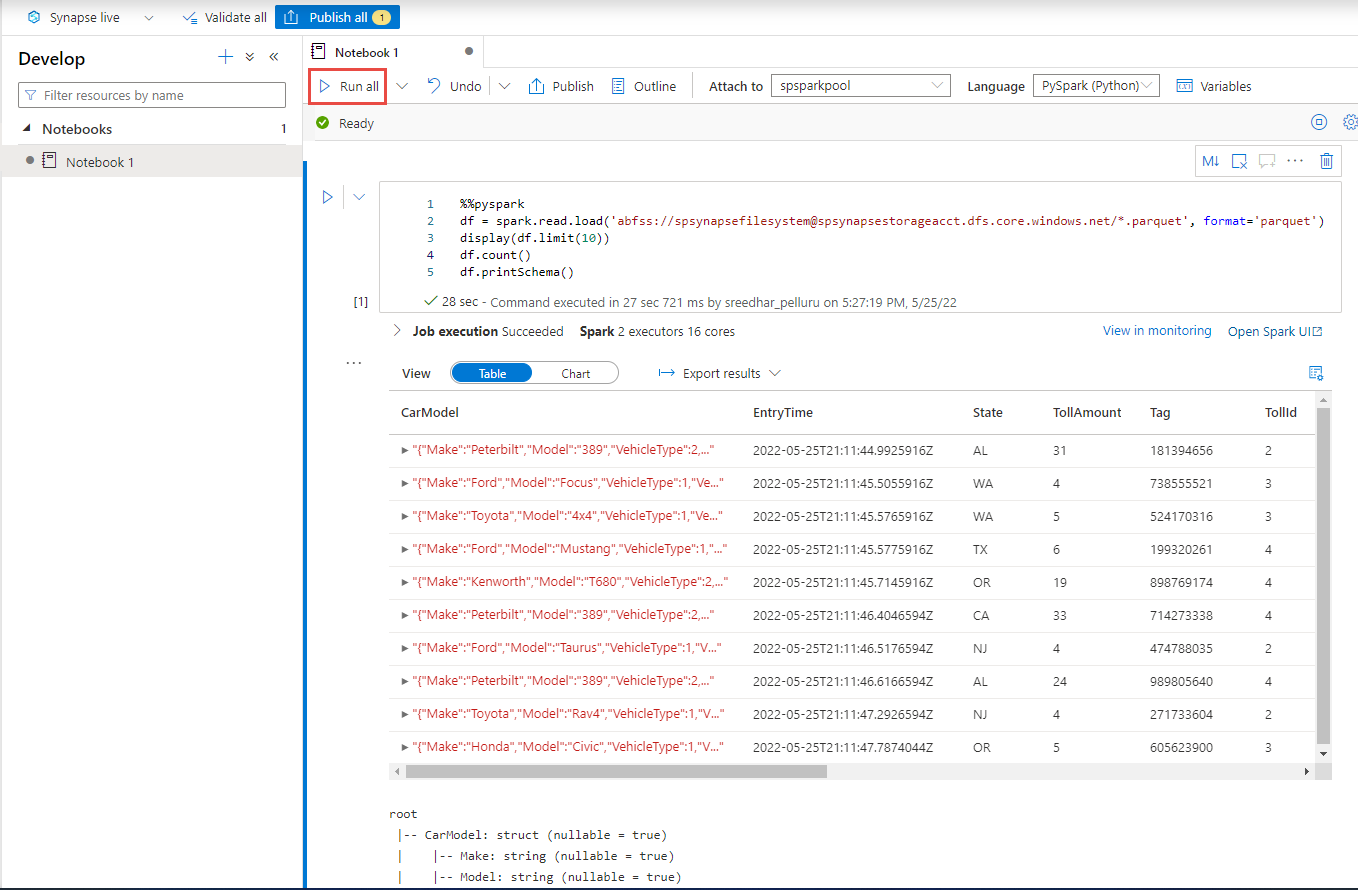

Utwórz nową komórkę kodu i wklej następujący kod w tej komórce. Zastąp kontener i adlsname nazwą kontenera oraz kontem usługi ADLS Gen2 użytym w poprzednim kroku.

%%pyspark df = spark.read.load('abfss://container@adlsname.dfs.core.windows.net/*/*/*.parquet', format='parquet') display(df.limit(10)) df.count() df.printSchema()W obszarze Dołącz do na pasku narzędzi wybierz pulę platformy Spark z listy rozwijanej.

Wybierz pozycję Uruchom wszystko , aby wyświetlić wyniki

Wykonywanie zapytań przy użyciu Azure Synapse bezserwerowej bazy danych SQL

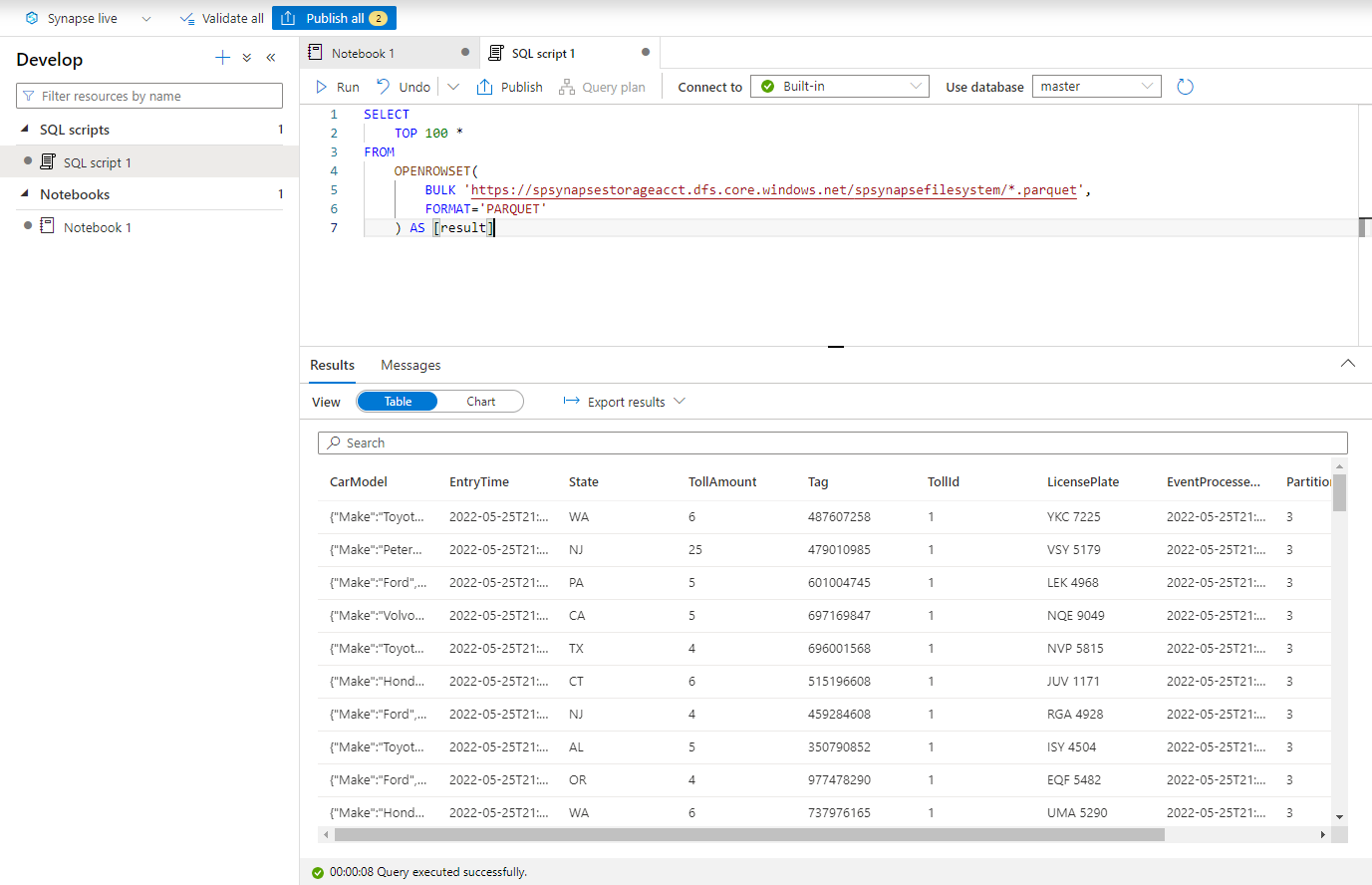

W centrum Programowanie utwórz nowy skrypt SQL.

Wklej następujący skrypt i uruchom go przy użyciu wbudowanego bezserwerowego punktu końcowego SQL. Zastąp kontener i adlsname nazwą kontenera oraz kontem usługi ADLS Gen2 użytym w poprzednim kroku.

SELECT TOP 100 * FROM OPENROWSET( BULK 'https://adlsname.dfs.core.windows.net/container/*/*/*.parquet', FORMAT='PARQUET' ) AS [result]

Czyszczenie zasobów

- Znajdź wystąpienie usługi Event Hubs i zapoznaj się z listą zadań usługi Stream Analytics w sekcji Przetwarzanie danych . Zatrzymaj wszystkie uruchomione zadania.

- Przejdź do grupy zasobów użytej podczas wdrażania generatora zdarzeń TollApp.

- Wybierz pozycję Usuń grupę zasobów. Wpisz nazwę grupy zasobów, aby potwierdzić usunięcie.

Następne kroki

W tym samouczku przedstawiono sposób tworzenia zadania usługi Stream Analytics przy użyciu edytora kodu bez do przechwytywania strumieni danych usługi Event Hubs w formacie Parquet. Następnie użyto usługi Azure Synapse Analytics do wykonywania zapytań względem plików parquet przy użyciu platformy Synapse Spark i usługi Synapse SQL.