Jak tworzyć niestandardowe pule platformy Spark w usłudze Microsoft Fabric

W tym dokumencie wyjaśniono, jak tworzyć niestandardowe pule platformy Apache Spark w usłudze Microsoft Fabric na potrzeby obciążeń analitycznych. Pule platformy Apache Spark umożliwiają użytkownikom tworzenie dostosowanych środowisk obliczeniowych na podstawie ich konkretnych wymagań, zapewniając optymalną wydajność i wykorzystanie zasobów.

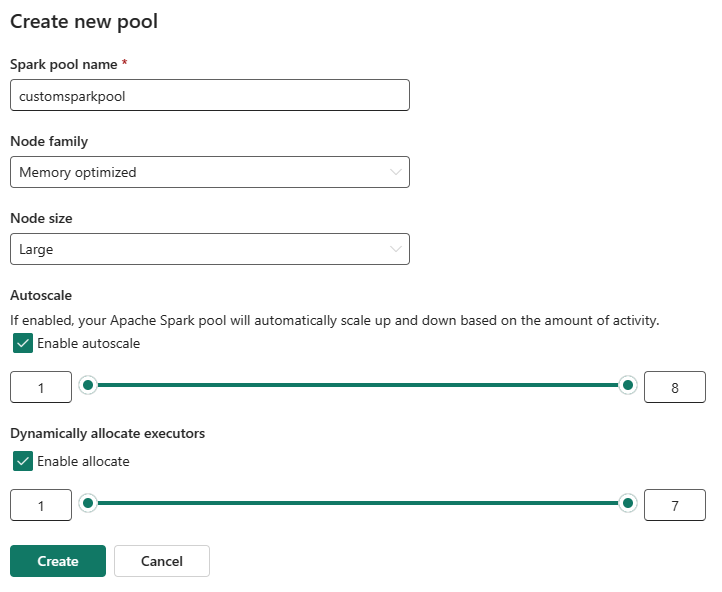

Należy określić minimalną i maksymalną liczbę węzłów do skalowania automatycznego. Na podstawie tych wartości system dynamicznie uzyskuje i cofnie węzły w miarę zmiany wymagań obliczeniowych zadania, co skutkuje wydajnym skalowaniem i lepszą wydajnością. Dynamiczna alokacja funkcji wykonawczych w pulach platformy Spark pozwala również złagodzić potrzebę ręcznej konfiguracji funkcji wykonawczej. Zamiast tego system dostosowuje liczbę funkcji wykonawczych w zależności od woluminu danych i potrzeb obliczeniowych na poziomie zadania. Ten proces umożliwia skoncentrowanie się na obciążeniach bez obaw o optymalizację wydajności i zarządzanie zasobami.

Uwaga

Aby utworzyć niestandardową pulę platformy Spark, musisz mieć dostęp administratora do obszaru roboczego. Administrator pojemności musi włączyć opcję Dostosowane pule obszarów roboczych w sekcji Obliczenia platformy Spark w ustawieniach Administracja pojemności. Aby dowiedzieć się więcej, zobacz Spark Compute Ustawienia for Fabric Pojemności.

Tworzenie niestandardowych pul platformy Spark

Aby utworzyć pulę platformy Spark skojarzona z obszarem roboczym lub zarządzać nią:

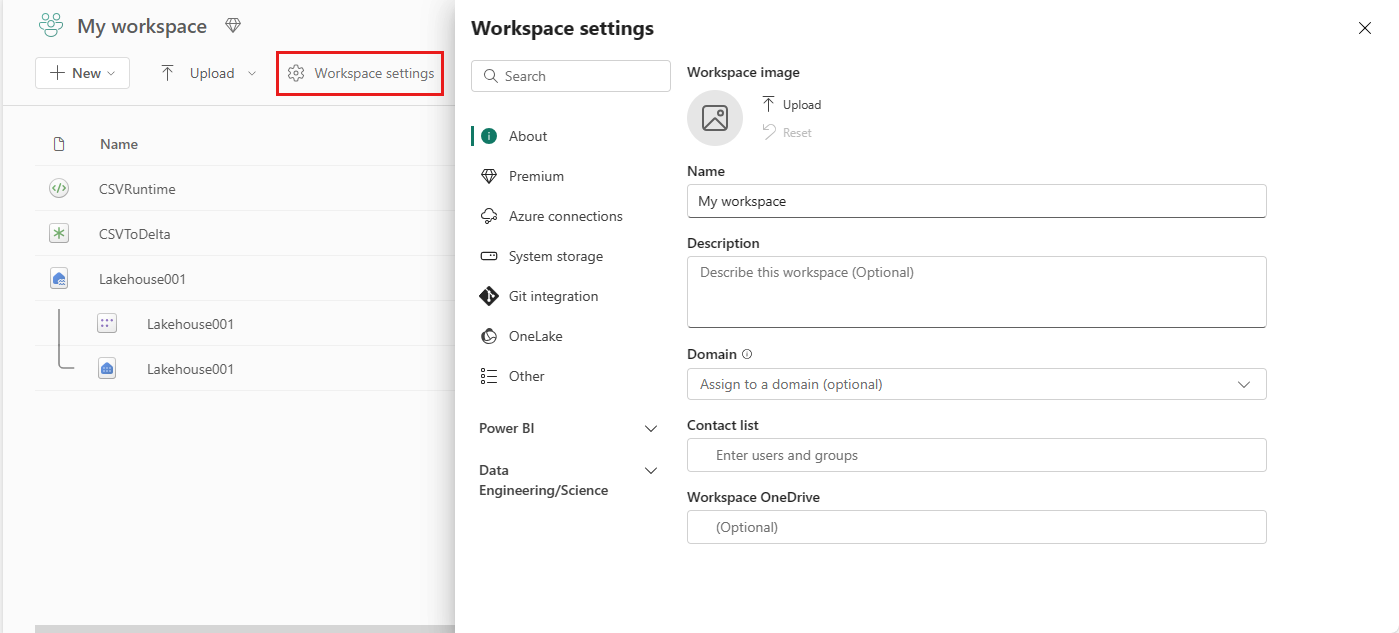

Przejdź do obszaru roboczego i wybierz pozycję Ustawienia obszaru roboczego.

Wybierz opcję inżynierowie danych ing/Science, aby rozwinąć menu, a następnie wybierz pozycję Spark Compute.

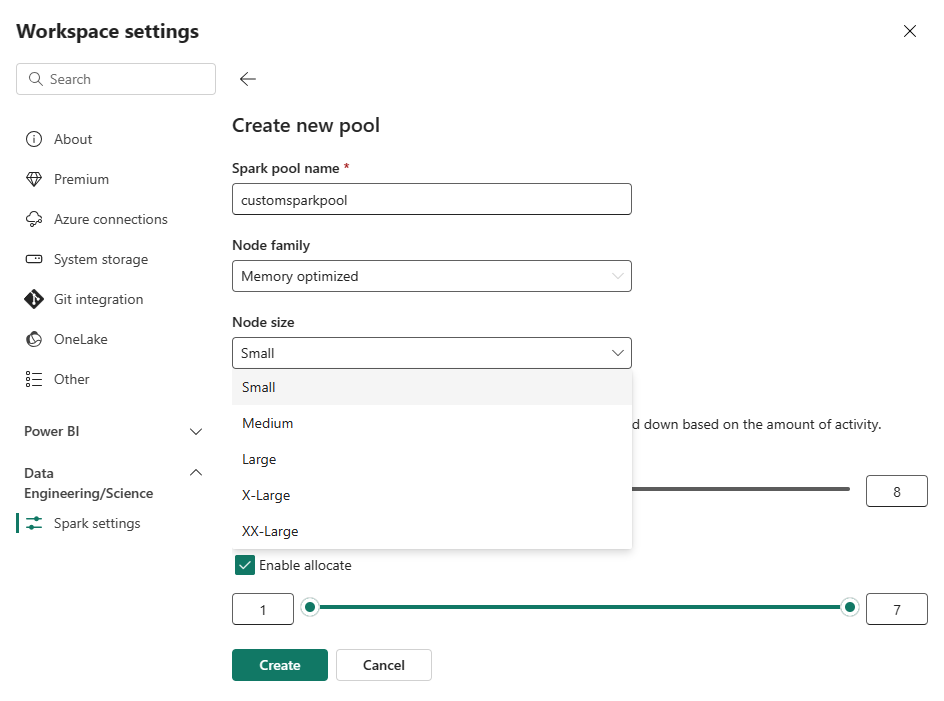

Wybierz opcję Nowa pula. Na ekranie Tworzenie puli nazwij pulę platformy Spark. Wybierz również rodzinę węzłów i wybierz rozmiar węzła z dostępnych rozmiarów (Small, Medium, Large, X-Large i XX-Large) na podstawie wymagań obliczeniowych dla obciążeń.

Możesz ustawić minimalną konfigurację węzła dla pul niestandardowych na 1. Ponieważ platforma Spark sieci szkieletowej zapewnia dostępność możliwych do przywrócenia dla klastrów z jednym węzłem, nie musisz martwić się o błędy zadań, utratę sesji podczas awarii ani płacić za zasoby obliczeniowe dla mniejszych zadań platformy Spark.

Możesz włączyć lub wyłączyć skalowanie automatyczne dla niestandardowych pul platformy Spark. Po włączeniu skalowania automatycznego pula będzie dynamicznie uzyskiwać nowe węzły do maksymalnego limitu węzłów określonego przez użytkownika, a następnie wycofać je po wykonaniu zadania. Ta funkcja zapewnia lepszą wydajność dzięki dostosowaniu zasobów na podstawie wymagań dotyczących zadania. Możesz rozmieścić węzły, które mieszczą się w jednostkach pojemności zakupionych w ramach jednostki SKU pojemności sieci szkieletowej.

Możesz również włączyć dynamiczną alokację funkcji wykonawczej dla puli Spark, która automatycznie określa optymalną liczbę funkcji wykonawczych w ramach maksymalnej granicy określonej przez użytkownika. Ta funkcja dostosowuje liczbę funkcji wykonawczych na podstawie woluminu danych, co zwiększa wydajność i wykorzystanie zasobów.

Te pule niestandardowe mają domyślny czas trwania automatycznego trwania 2 minut. Po osiągnięciu czasu trwania autopauży sesja wygaśnie, a klastry są nieprzydzielone. Opłaty są naliczane na podstawie liczby węzłów i czasu trwania, przez który są używane niestandardowe pule platformy Spark.

Powiązana zawartość

- Dowiedz się więcej z publicznej dokumentacji platformy Apache Spark.

- Rozpocznij pracę z ustawieniami administrowania obszarem roboczym platformy Spark w usłudze Microsoft Fabric.