Eksplorowanie wykazu modeli

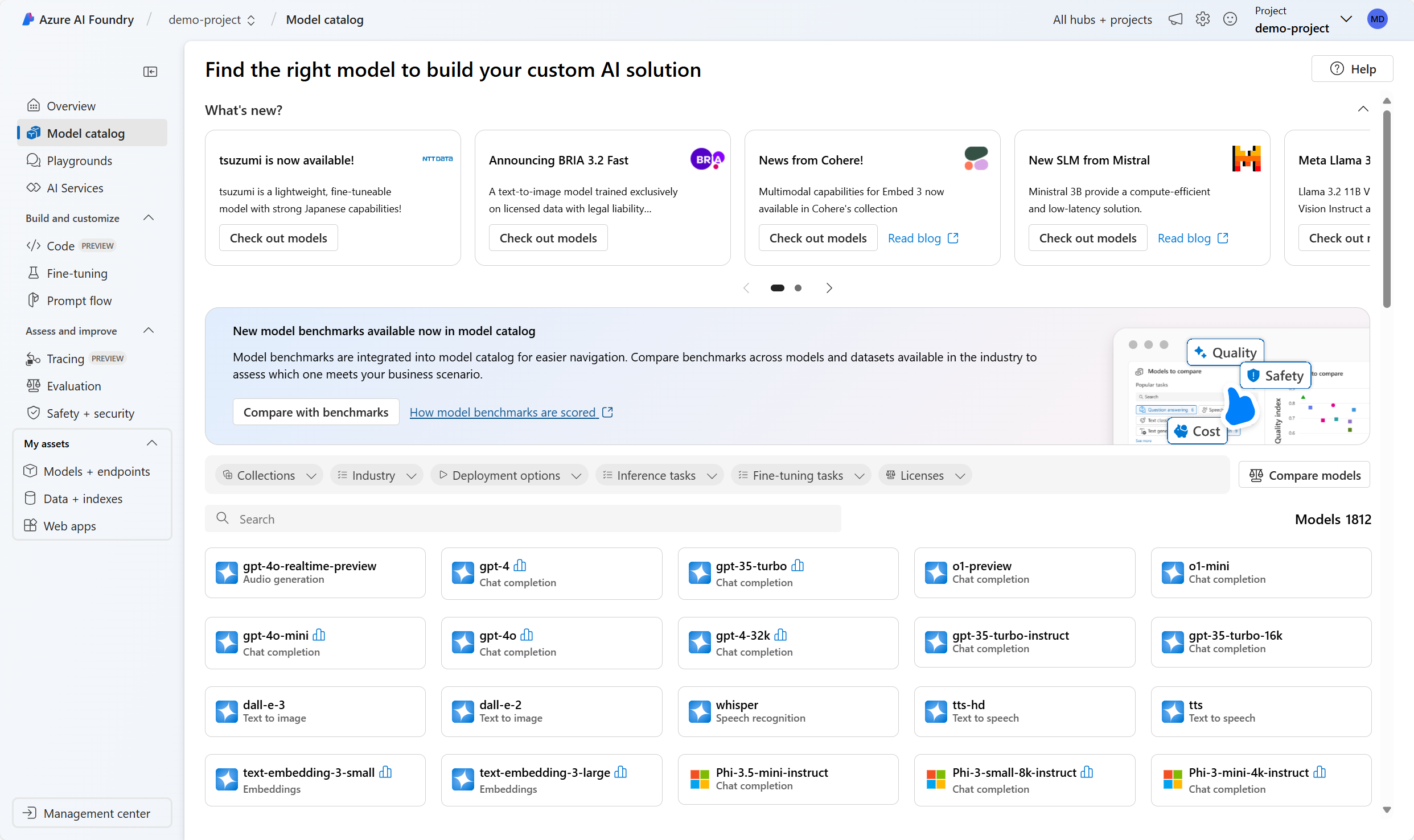

Katalog modeli w witrynie Microsoft Foundry udostępnia centralne repozytorium modeli, które można przeglądać, aby znaleźć odpowiedni model językowy dla konkretnego przypadku użycia generatywnej sztucznej inteligencji.

Wybór modelu podstawowego dla generowanej aplikacji sztucznej inteligencji jest ważny, ponieważ wpływa na to, jak dobrze działa aplikacja. Aby znaleźć najlepszy model dla aplikacji, możesz użyć podejścia ustrukturyzowanego, zadając sobie następujące pytania:

- Czy sztuczna inteligencja może rozwiązać mój przypadek użycia?

- Jak wybrać najlepszy model dla mojego przypadku użycia?

- Czy mogę skalować obciążenia w świecie rzeczywistym?

Przyjrzyjmy się każdemu z tych pytań.

Czy sztuczna inteligencja może rozwiązać mój przypadek użycia?

Obecnie mamy tysiące modeli językowych do wyboru. Głównym wyzwaniem jest zrozumienie, czy istnieje model spełniający Twoje potrzeby i aby odpowiedzieć na pytanie: Czy sztuczna inteligencja może rozwiązać mój przypadek użycia?

Aby rozpocząć odpowiadanie na to pytanie, musisz odnaleźć, filtrować i wdrożyć model. Dostępne modele językowe można eksplorować za pomocą trzech różnych katalogów:

- Hugging Face: rozległy wykaz modeli typu open source w różnych domenach.

- GitHub: dostęp do różnych modeli za pośrednictwem witryny GitHub Marketplace i narzędzia GitHub Copilot.

- Microsoft Foundry: kompleksowy wykaz z niezawodnymi narzędziami do wdrażania.

Chociaż można użyć każdego z tych katalogów do eksplorowania modeli, katalog modeli w firmie Microsoft Foundry ułatwia eksplorowanie i wdrażanie modelu w celu utworzenia prototypu, oferując jednocześnie najlepszy wybór modeli.

Przyjrzyjmy się niektórym opcjom, które należy wziąć pod uwagę podczas wyszukiwania odpowiednich modeli.

Wybieranie między dużymi i małymi modelami językowymi

Po pierwsze, masz wybór między dużymi modelami językowymi (LLMs) i małymi modelami językowymi (SLMs).

LlMs, takie jak GPT-4, Mistral Large, Llama3 70B, Llama 405B i Command R+ to zaawansowane modele sztucznej inteligencji przeznaczone do zadań wymagających głębokiego rozumowania, złożonego generowania zawartości i obszernego zrozumienia kontekstu.

Modele SLM, takie jak Phi3, Mistral OSS, i Llama3 8B są wydajne i ekonomiczne, a jednocześnie obsługują wiele typowych zadań przetwarzania języka naturalnego (NLP). Doskonale nadają się do pracy na sprzęcie niższej klasy lub urządzeniach brzegowych, gdzie koszt i szybkość są ważniejsze niż złożoność modelu.

Skupienie się na modalności, zadaniu lub narzędziu

Modele językowe, takie jak GPT-4 i Mistral Large, są również znane jako modele uzupełniania czatów , przeznaczone do generowania spójnych i kontekstowo odpowiednich odpowiedzi opartych na tekście. Jeśli potrzebujesz wyższego poziomu wydajności w złożonych zadaniach, takich jak matematyka, kodowanie, nauka, strategia i logistyka, możesz również użyć modeli rozumowania , takich jak DeepSeek-R1 i o1.

Poza sztuczną inteligencją opartą na tekście niektóre modele są wielomodalne, co oznacza, że mogą przetwarzać obrazy, dźwięk i inne typy danych wraz z tekstem. Modele takie jak GPT-4o i Phi3-vision są w stanie analizować i generować zarówno tekst, jak i obrazy. Modele wielomodalne są przydatne, gdy aplikacja musi przetwarzać i interpretować obrazy, takie jak przetwarzanie obrazów lub analiza dokumentów. Możesz też utworzyć aplikację sztucznej inteligencji, która współdziała z zawartością wizualną, taką jak cyfrowy nauczyciel wyjaśniający obrazy lub wykresy.

Jeśli przypadek użycia obejmuje generowanie obrazów, narzędzia takie jak DALL·E 3 i Stability AI mogą tworzyć realistyczne wizualizacje na podstawie tekstowych poleceń. Modele generowania obrazów doskonale nadają się do projektowania materiałów marketingowych, ilustracji lub sztuki cyfrowej.

Kolejną grupą modeli specyficznych dla zadań jest osadzanie modeli , takich jak Ada i Cohere. Osadzanie modeli konwertuje tekst na reprezentacje liczbowe i służy do poprawy istotności wyszukiwania przez zrozumienie znaczenia semantycznego. Te modele są często stosowane w scenariuszach Retrieval Augmented Generation (RAG) w celu ulepszenia systemów rekomendacji poprzez łączenie podobnych treści.

Jeśli chcesz dynamicznie utworzyć aplikację, która współdziała z innymi narzędziami programowymi, możesz dodać obsługę wywołań funkcji i formatu JSON. Dzięki tym funkcjom modele sztucznej inteligencji mogą wydajnie pracować z danymi ustrukturyzowanymi, co ułatwia automatyzację wywołań interfejsu API, zapytań bazy danych i przetwarzania danych strukturalnych.

Specjalizuj się w modelach specyficznych dla regionów i domen

Niektóre modele są przeznaczone dla określonych języków, regionów lub branż. Te modele mogą przewyższać generowanie sztucznej inteligencji ogólnego przeznaczenia w odpowiednich domenach. Na przykład:

- Core42 JAIS to język arabski LLM, co czyni go najlepszym wyborem dla aplikacji przeznaczonych dla użytkowników języka arabskiego.

- Mistral Large koncentruje się na językach europejskich, zapewniając lepszą dokładność językową dla aplikacji wielojęzycznych.

- Nixtla TimeGEN-1 specjalizuje się w prognozowaniu szeregów czasowych, co czyni go idealnym rozwiązaniem dla prognoz finansowych, optymalizacji łańcucha dostaw i prognozowania popytu.

Jeśli projekt ma potrzeby regionalne, językowe lub branżowe, te modele mogą zapewnić bardziej istotne wyniki niż sztuczna inteligencja ogólnego przeznaczenia.

Równoważenie elastyczności i wydajności dzięki otwartym i zastrzeżonym modelom

Musisz również zdecydować, czy używać modeli typu open source, czy zastrzeżonych modeli, z których każda ma własne zalety.

Zastrzeżone modele najlepiej nadają się do najnowocześniejszej wydajności i użycia w przedsiębiorstwie. Platforma Azure oferuje modele, takie jak GPT-4 openAI, Mistral Large i Cohere Command R+, które zapewniają wiodące w branży możliwości sztucznej inteligencji. Te modele są idealne dla firm wymagających zabezpieczeń, obsługi i wysokiej dokładności na poziomie przedsiębiorstwa.

Modele typu open source najlepiej nadają się do elastyczności i wydajności kosztowej. W katalogu modeli Foundry Microsoft dostępne są setki modeli typu open-source z Hugging Face, a także modele z Meta, Databricks, Snowflake i Nvidia. Otwarte modele zapewniają deweloperom większą kontrolę, umożliwiając dostrajanie, dostosowywanie i wdrażanie lokalne.

Niezależnie od wybranego modelu, możesz użyć katalogu modeli Microsoft Foundry. Używanie modeli za pośrednictwem wykazu modeli spełnia kluczowe wymagania przedsiębiorstwa dotyczące użycia:

- Dane i prywatność: możesz zdecydować, co się stanie z danymi.

- Zabezpieczenia i zgodność: wbudowane zabezpieczenia.

- Odpowiedzialne używanie sztucznej inteligencji i bezpieczeństwa zawartości: oceny i bezpieczeństwo zawartości.

Teraz znasz dostępne modele językowe, musisz wiedzieć, czy sztuczna inteligencja może rzeczywiście rozwiązać twój przypadek użycia. Jeśli uważasz, że model językowy wzbogaci aplikację, musisz wybrać konkretny model, który chcesz wdrożyć i zintegrować.

Jak wybrać najlepszy model dla mojego przypadku użycia?

Aby wybrać najlepszy model językowy dla danego przypadku użycia, musisz zdecydować, jakie kryteria są używane do filtrowania modeli. Kryteria są niezbędnymi cechami, które można zidentyfikować dla modelu. Cztery cechy, które można wziąć pod uwagę, to:

- Typ zadania: Jakiego typu zadania potrzebujesz do wykonania w modelu? Czy obejmuje to zrozumienie tylko tekstu, a także dźwięku, wideo lub wielu modalności?

- Precyzja: Czy model podstawowy jest wystarczająco dobry, czy potrzebujesz dostosowanego modelu, który jest trenowany na podstawie konkretnej umiejętności lub zestawu danych?

- Otwartość: Czy chcesz mieć możliwość samodzielnego dostosowania modelu?

- Wdrożenie: Czy chcesz wdrożyć model lokalnie, w punkcie końcowym bezserwerowym, czy chcesz zarządzać infrastrukturą wdrażania?

Znasz już różne typy modeli dostępnych w poprzedniej sekcji. Teraz przyjrzyjmy się dokładniej, jak precyzja i wydajność mogą być ważnymi filtrami podczas wybierania modelu.

Filtrowanie modeli pod kątem precyzji

W przypadku generowania sztucznej inteligencji precyzja odnosi się do dokładności modelu w generowaniu prawidłowych i odpowiednich danych wyjściowych. Mierzy proporcję wyników prawdziwie dodatnich (poprawnych danych wyjściowych) wśród wszystkich wygenerowanych danych wyjściowych. Wysoka precyzja oznacza mniej nieistotnych lub niepoprawnych wyników, co sprawia, że model jest bardziej niezawodny.

Podczas integrowania modelu językowego z aplikacją można wybrać model podstawowy lub dostosowany model. Model podstawowy, taki jak GPT-4, jest wstępnie wytrenowany na dużym zestawie danych i może obsługiwać różne zadania, ale może nie mieć precyzji dla określonych domen. Techniki, takie jak inżynieria monitu, mogą to poprawić, ale czasami konieczne jest dostrajanie.

Dostosowany model jest dodatkowo trenowany na mniejszym, specyficznym dla zadania zestawie danych, aby zwiększyć jego precyzję i możliwość generowania odpowiednich danych wyjściowych dla określonych aplikacji. Możesz użyć dostosowanego modelu lub dostosować model samodzielnie.

Filtrowanie modeli pod kątem wydajności

Wydajność modelu można ocenić na różnych etapach przy użyciu różnych metod oceny.

Podczas eksplorowania modeli za pośrednictwem wykazu modeli firmy Microsoft Foundry możesz użyć testów porównawczych modelu , aby porównać publicznie dostępne metryki, takie jak spójność i dokładność modeli i zestawów danych. Te testy porównawcze mogą pomóc w początkowej fazie eksploracji, ale zawierają niewiele informacji na temat tego, jak model będzie działał w konkretnym przypadku użycia.

| Wzorzec | opis |

|---|---|

| Dokładność | Porównuje tekst wygenerowany przez model z prawidłową odpowiedzią zgodnie z zestawem danych. Wynik jest taki, jeśli wygenerowany tekst pasuje dokładnie do odpowiedzi i zero w przeciwnym razie. |

| spójności | Mierzy, czy dane wyjściowe modelu przepływa płynnie, odczytuje naturalnie i przypomina język podobny do ludzkiego. |

| Płynność | Ocenia, jak dobrze wygenerowany tekst jest zgodny z regułami gramatycznymi, strukturami składniowymi i odpowiednim użyciem słownictwa, co skutkuje odpowiedziami językowymi i naturalnie brzmiącymi. |

| Stabilność | Mierzy wyrównanie między wygenerowanymi odpowiedziami modelu a danymi wejściowymi. |

| Podobieństwo GPT | Kwantyfikuje semantyczną podobieństwo między zdaniem podstawy (lub dokumentem) a wyrokiem przewidywania wygenerowanym przez model sztucznej inteligencji. |

| Indeks jakości | Zagregowany wynik porównawczy w zakresie od 0 do 1, przy czym modele o lepszych wynikach uzyskują wyższą wartość. |

| Koszt | Koszt użycia modelu na podstawie ceny za token. Koszt to przydatna metryka, z którą można porównać jakość, umożliwiając określenie odpowiedniego kompromisu dla Twoich potrzeb. |

Aby ocenić, w jaki sposób wybrany model jest wykonywany w odniesieniu do określonych wymagań, możesz rozważyć ocenę ręczną lub zautomatyzowaną . Oceny ręczne umożliwiają ocenianie odpowiedzi modelu. Zautomatyzowane oceny obejmują tradycyjne metryki uczenia maszynowego i metryki wspomagane przez sztuczną inteligencję, które są obliczane i generowane dla Ciebie.

Podczas oceniania wydajności modelu często zaczyna się od ręcznych ocen, ponieważ szybko oceniają jakość odpowiedzi modelu. Aby uzyskać bardziej systematyczne porównania, zautomatyzowane oceny przy użyciu metryk, takich jak precyzja, kompletność i wynik F1 na podstawie własnej prawdy podstawowej, oferują szybsze, skalowalne i bardziej obiektywne podejście.

Czy mogę skalować obciążenia w świecie rzeczywistym?

Wybrano model dla przypadku użycia i pomyślnie utworzono prototyp. Teraz musisz zrozumieć, jak skalować obciążenia w świecie rzeczywistym.

Zagadnienia dotyczące skalowania rozwiązania do generowania sztucznej inteligencji obejmują:

- Wdrożenie modelu: Gdzie wdrożysz model w celu uzyskania najlepszej równowagi między wydajnością i kosztami?

- Monitorowanie i optymalizacja modelu: Jak będziesz monitorować, oceniać i optymalizować wydajność modelu?

- Zarządzanie monitami: W jaki sposób będziesz organizować i optymalizować monity w celu zmaksymalizowania dokładności i istotności wygenerowanych odpowiedzi?

- Cykl życia modelu: w jaki sposób będziesz zarządzać aktualizacjami modelu, danych i kodu w ramach trwającego cyklu życia operacji sztucznej inteligencji (GenAIOps)?

Rozwiązanie Microsoft Foundry udostępnia wizualne i oparte na kodzie narzędzia, które mogą pomóc w tworzeniu i utrzymywaniu skalowalnego rozwiązania do generowania sztucznej inteligencji.