Przygotowanie do korzystania z platformy Apache Spark

Apache Spark to rozproszona struktura przetwarzania danych, która umożliwia analizę danych na dużą skalę, koordynując pracę między wieloma węzłami przetwarzania w klastrze. Mówiąc bardziej prosto, platforma Spark wykorzystuje podejście "dzielenia i podbijania" do szybkiego przetwarzania dużych ilości danych przez dystrybucję pracy na wielu komputerach. Proces dystrybucji zadań i sortowania wyników jest obsługiwany przez platformę Spark. Zadanie przetwarzania danych jest przesyłane w postaci kodu, który inicjuje program sterowników, który używa obiektu zarządzania klastrem o nazwie SparkContext do zarządzania dystrybucją przetwarzania w klastrze Spark. W większości przypadków te szczegóły są abstrakcyjne — wystarczy napisać kod wymagany do wykonania potrzebnych operacji na danych.

Platforma Spark może uruchamiać kod napisany w wielu różnych językach, w tym Java, Scala (język skryptowy oparty na języku Java), Spark R, Spark SQL i PySpark (wariant specyficzny dla platformy Spark języka Python). Większość obciążeń inżynieryjnych i analitycznych danych jest realizowana przy użyciu kombinacji narzędzi PySpark i Spark SQL.

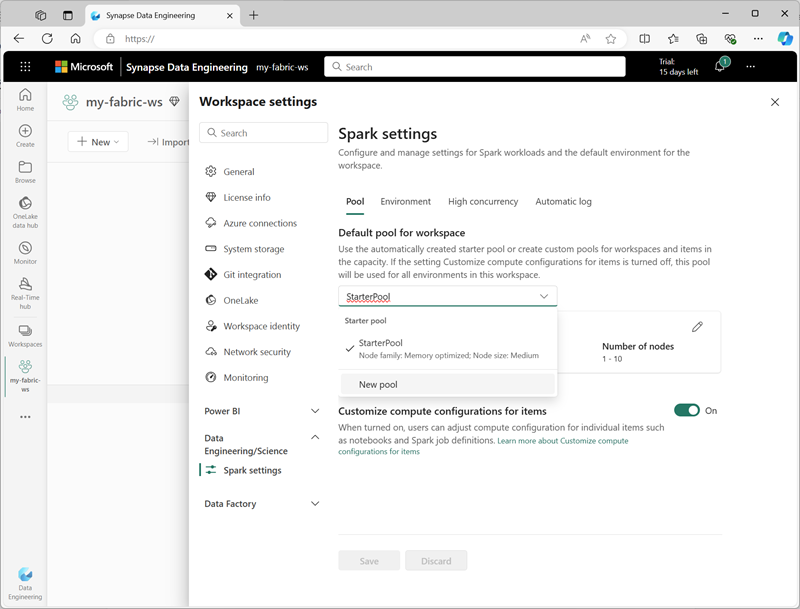

Ustawienia platformy Spark

W usłudze Microsoft Fabric każdy obszar roboczy jest przypisany do klastra Spark. Administrator może zarządzać ustawieniami klastra Spark w sekcji inżynierowie danych ing/Science w ustawieniach obszaru roboczego.

Określone ustawienia konfiguracji obejmują:

- Rodzina węzłów: typ maszyn wirtualnych używanych dla węzłów klastra Spark. W większości przypadków węzły zoptymalizowane pod kątem pamięci zapewniają optymalną wydajność.

- Wersja środowiska uruchomieniowego: wersja platformy Spark (i zależne podskładniki) do uruchomienia w klastrze.

- Właściwości platformy Spark: ustawienia specyficzne dla platformy Spark, które chcesz włączyć lub zastąpić w klastrze. Listę właściwości można wyświetlić w dokumentacji platformy Apache Spark.

Uwaga

W większości scenariuszy ustawienia domyślne zapewniają optymalną konfigurację platformy Spark w usłudze Microsoft Fabric.

Biblioteki

Ekosystem open source platformy Spark obejmuje szeroki wybór bibliotek kodu do typowych (a czasami bardzo wyspecjalizowanych) zadań. Ponieważ wiele operacji przetwarzania platformy Spark jest wykonywane przy użyciu narzędzia PySpark, ogromny zakres bibliotek języka Python gwarantuje, że niezależnie od tego, co należy wykonać, prawdopodobnie istnieje biblioteka, która pomoże.

Domyślnie klastry Spark w usłudze Microsoft Fabric obejmują wiele najczęściej używanych bibliotek. Aby ustawić dodatkowe biblioteki domyślne lub zachować specyfikacje bibliotek dla elementów kodu, musisz mieć uprawnienia administratora obszaru roboczego do tworzenia środowiska i ustawiania domyślnego środowiska dla obszaru roboczego.

Napiwek

Aby uzyskać więcej informacji na temat zarządzania bibliotekami, zobacz Zarządzanie bibliotekami platformy Apache Spark w usłudze Microsoft Fabric w dokumentacji usługi Microsoft Fabric.