Omówienie przykładów śledzenia oczu — MRTK2

W tym temacie opisano, jak szybko rozpocząć pracę ze śledzeniem oczu w zestawie narzędzi MRTK, tworząc przykłady śledzenia oczu mrTK (Assets/MRTK/Examples/Demos/EyeTracking). Te przykłady pozwalają doświadczyć jednej z naszych nowych magicznych możliwości wejściowych: śledzenie oczu! Pokaz zawiera różne przypadki użycia, począwszy od niejawnych aktywacji opartych na oczach, aby bezproblemowo łączyć informacje o tym, co patrzysz za pomocą głosu i rąk . Dzięki temu użytkownicy mogą szybko i bez wysiłku wybierać i przenosić zawartość holograficzną w całym widoku, patrząc na cel i mówiąc "Wybierz" lub wykonując gest dłoni. Pokazy zawierają również przykład przewijania, przesuwania i powiększania tekstu oraz obrazów na łupkach. Na koniec przedstawiono przykład rejestrowania i wizualizowania uwagi wizualnej użytkownika na łupek 2D. W poniższej sekcji znajdziesz więcej szczegółów na temat tego, co zawiera każdy z różnych przykładów w przykładowym pakiecie śledzenia oczu zestawu narzędzi MRTK (Assets/MRTK/Examples/Demos/EyeTracking):

![]()

Poniższa sekcja zawiera krótkie omówienie poszczególnych scen demonstracyjnych śledzenia oczu. Sceny pokazowe śledzenia oczu MRTK są ładowane addycznie, co wyjaśnimy poniżej, jak skonfigurować.

Omówienie przykładów pokazowych śledzenia oczu

Wybór obiektu docelowego obsługiwanego przez oko

W tym samouczku przedstawiono łatwość uzyskiwania dostępu do danych wzroku w celu wybrania obiektów docelowych. Zawiera przykład subtelnych, ale zaawansowanych opinii, aby zapewnić użytkownikowi pewność, że cel jest skoncentrowany bez przeciążenia. Ponadto istnieje prosty przykład powiadomień inteligentnych, które automatycznie znikają po odczytaniu.

Podsumowanie: Szybkie i bez wysiłku opcje docelowe przy użyciu kombinacji oczu, głosu i rąk wejściowych.

Nawigacja obsługiwana przez oko

Wyobraź sobie, że czytasz niektóre informacje o odległym wyświetlaczu lub czytniku e-mail, a gdy dotrzesz do końca wyświetlanego tekstu, tekst automatycznie przewija się w górę, aby wyświetlić więcej zawartości. A jak o magicznym powiększaniu bezpośrednio w kierunku miejsca, w którym patrzyłeś? Oto niektóre przykłady zaprezentowane w tym samouczku dotyczące nawigacji obsługiwanej przez oko. Ponadto istnieje przykład obrotu hologramów 3D bez rąk, dzięki czemu są one automatycznie obracane na podstawie bieżącego fokusu.

Podsumowanie: Przewijanie, przesuwanie, powiększanie, obracanie 3D przy użyciu kombinacji oczu, głosu i rąk wejściowych.

Pozycjonowanie obsługiwane przez oko

W tym samouczku przedstawiono scenariusz wejściowy o nazwie Put-That-There , który sięga badań z MIT Media Lab na początku 1980 roku z danymi wejściowymi wzrokowymi, ręcznymi i głosowymi. Pomysł jest prosty: Skorzystaj z oczu w celu szybkiego wyboru docelowego i pozycjonowania. Po prostu spójrz na hologram i powiedz "put this", spójrz na to, gdzie chcesz go umieścić i powiedzieć "tam!". Aby dokładniej ustawić hologram, możesz użyć dodatkowych danych wejściowych z rąk, głosu lub kontrolerów.

Podsumowanie: Pozycjonowanie hologramów przy użyciu oczu, głosu i rąk (przeciąganie i upuszczanie). Suwaki obsługiwane przez wzrok przy użyciu oczu + dłoni.

Wizualizacja uwagi wizualizacji

Dane oparte na tym, gdzie użytkownicy wyglądają, sprawia, że niezwykle zaawansowane narzędzie do oceny użyteczności projektu i identyfikowania problemów w wydajnych strumieniach pracy. W tym samouczku omówiono różne wizualizacje śledzenia oczu i sposób ich dopasowania do różnych potrzeb. Udostępniamy podstawowe przykłady rejestrowania i ładowania danych śledzenia oczu oraz przykłady ich wizualizowania.

Podsumowanie: Mapa uwagi dwuwymiarowa (mapa cieplna) na slates. Rejestrowanie & odtworzenie danych śledzenia oczu.

Konfigurowanie przykładów śledzenia oczu zestawu NARZĘDZI MRTK

Wymagania wstępne

Należy pamiętać, że korzystanie z przykładów śledzenia oczu na urządzeniu wymaga HoloLens 2 i przykładowego pakietu aplikacji utworzonego z funkcją "Gaze Input" w pakiecie AppXManifest.

Aby użyć tych przykładów śledzenia oczu na urządzeniu, przed utworzeniem aplikacji w programie Visual Studio należy wykonać następujące kroki .

1. Załaduj eyetrackingDemo-00-RootScene.unity

EyeTrackingDemo-00-RootScene jest podstawową (główną) sceną zawierającą wszystkie podstawowe składniki MRTK. Jest to scena, którą należy najpierw załadować i z której uruchomisz pokazy śledzenia oczu. Zawiera on menu sceny graficznej, które umożliwia łatwe przełączanie się między różnymi próbkami śledzenia oczu, które zostaną załadowane addycznie.

![]()

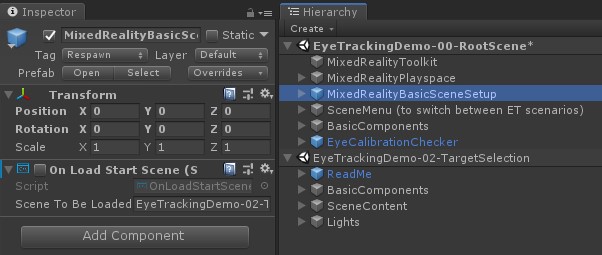

Scena główna zawiera kilka podstawowych składników, które będą utrwalane w scenach ładowanych do dodatków, takich jak skonfigurowane profile mrTK i aparat sceny. MixedRealityBasicSceneSetup (zobacz zrzut ekranu poniżej) zawiera skrypt, który automatycznie załaduje przywołyną scenę podczas uruchamiania. Domyślnie jest to EyeTrackingDemo-02-TargetSelection.

![]()

2. Dodawanie scen do menu kompilacji

Aby załadować sceny addytywne podczas wykonywania, należy najpierw dodać te sceny do ustawień kompilacji —> sceny w menu Kompilacja . Ważne jest, aby scena główna była wyświetlana jako pierwsza scena na liście:

![]()

3. Odtwarzanie przykładów śledzenia oczu w edytorze aparatu Unity

Po dodaniu scen śledzenia oczu do ustawień kompilacji i załadowaniu eyeTrackingDemo-00-RootScene istnieje jedna ostatnia rzecz, którą możesz sprawdzić: Czy jest włączony skrypt "OnLoadStartScene" dołączony do obiektu GameObject MixedRealityBasicSceneSetup ? Dzięki temu scena główna będzie wiedzieć, która scena demonstracyjna ma być ładowana jako pierwsza.

![]()

Przerzućmy! Hit "Play"! Powinny pojawić się kilka klejnotów i menu sceny u góry.

![]()

Należy również zauważyć mały półprzezroczysty okrąg w środku widoku gry. Działa to jako wskaźnik (kursor) symulowanego spojrzenia oka: wystarczy nacisnąć prawy przycisk myszy i przesunąć mysz, aby zmienić jego położenie. Gdy kursor znajduje się na klejnotach, zauważysz, że będzie przyciągać do środka aktualnie oglądanego klejnotu. Jest to doskonały sposób testowania, czy zdarzenia są wyzwalane zgodnie z oczekiwaniami podczas "patrzenia" na cel. Należy pamiętać, że symulowane spojrzenie oka za pośrednictwem kontrolki myszy jest raczej słabym uzupełnieniem naszych szybkich i niezamierzonych ruchów oczu. Jednak jest to doskonałe rozwiązanie do testowania podstawowych funkcji przed iterowaniem projektu przez wdrożenie go na urządzeniu HoloLens 2. Wracając do naszej sceny śledzenia oczu: Klejnot obraca się tak długo, jak patrzy na i może być zniszczony przez "patrząc" na to i ...

- Naciśnięcie klawisza Enter (które symuluje powiedzenie "select")

- Powiedzenie "select" do mikrofonu

- Naciskając klawisz Spacja , aby wyświetlić symulowane dane wejściowe ręki, kliknij lewy przycisk myszy, aby wykonać symulowaną szczyptę

Bardziej szczegółowo opisano, jak można osiągnąć te interakcje w naszym samouczku wyboru docelowego obsługiwanego przez oko .

Podczas przenoszenia kursora w górę do górnego paska menu w scenie zauważysz, że aktualnie zatrzymany element zostanie wyróżniony subtly. Możesz wybrać aktualnie wyróżniony element, używając jednej z powyższych opisanych metod zatwierdzania (np. naciśnięcia klawisza Enter). W ten sposób można przełączać się między różnymi scenami przykładowymi śledzenia oczu.

4. Jak przetestować określone podsieci

Podczas pracy nad konkretnym scenariuszem możesz nie chcieć za każdym razem przechodzić przez menu sceny. Zamiast tego możesz zacząć bezpośrednio od sceny, nad którą pracujesz podczas naciskania przycisku Odtwórz . Żaden problem. Oto co można zrobić:

Ładowanie sceny głównej

W scenie głównej wyłącz skrypt "OnLoadStartScene"

Przeciągnij i upuść jedną ze scen testowych śledzenia oczu, które zostały opisane poniżej (lub innej sceny) w widoku Hierarchy , jak pokazano na poniższym zrzucie ekranu.

Naciśnij klawisz Play

Pamiętaj, że ładowanie sceny podrzędnej w następujący sposób nie jest trwałe: oznacza to, że jeśli wdrożysz aplikację na urządzeniu HoloLens 2, zostanie załadowana tylko scena główna (przy założeniu, że pojawi się ona w górnej części ustawień kompilacji). Ponadto po udostępnieniu projektu innym osobom sceny podrzędne nie są ładowane automatycznie.

Teraz, gdy wiesz, jak uzyskać przykładowe sceny śledzenia oczu MRTK do pracy, kontynuujmy zagłębienie się w sposób wybierania hologramów z oczami: wybór celu obsługiwanego przez oko.