Observação

O acesso a essa página exige autorização. Você pode tentar entrar ou alterar diretórios.

O acesso a essa página exige autorização. Você pode tentar alterar os diretórios.

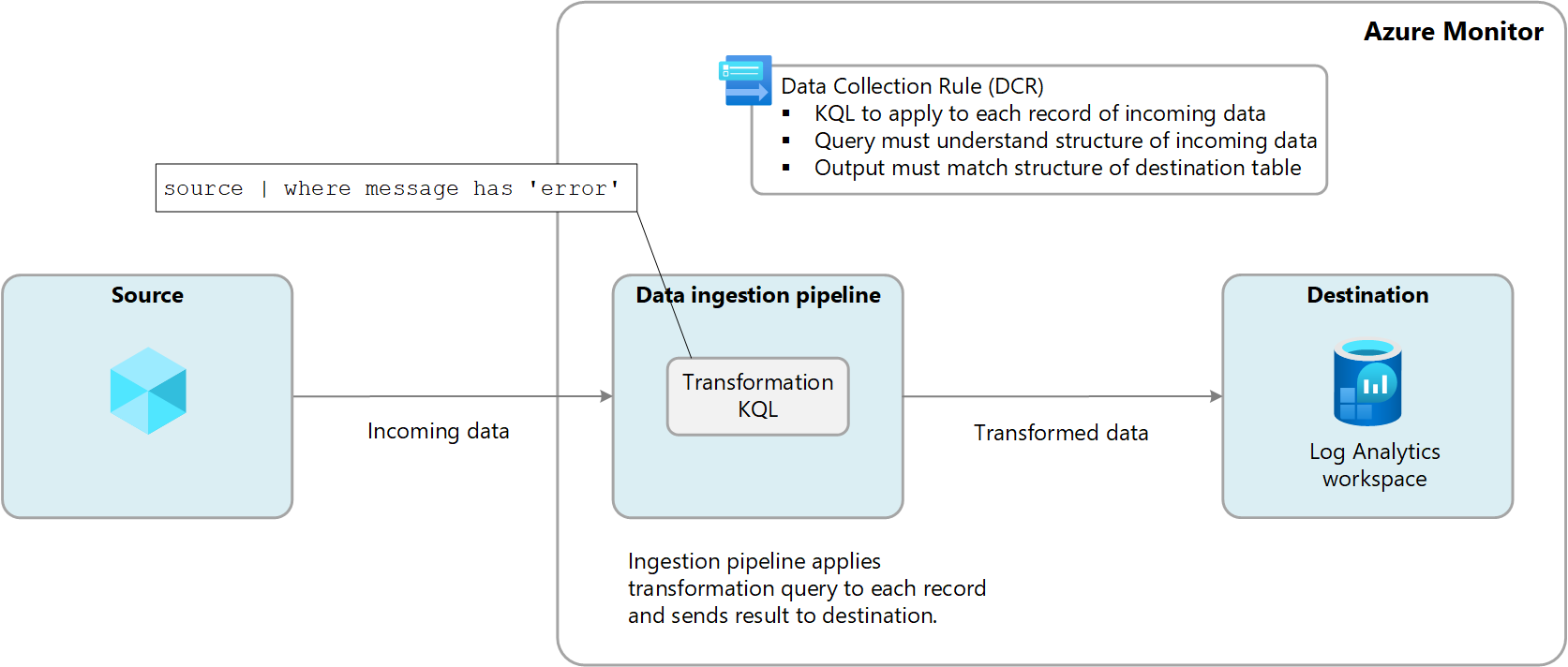

As transformações no Azure Monitor permitem que você filtre ou modifique os dados recebidos antes que eles sejam enviados para um espaço de trabalho do Log Analytics. As transformações são executadas no pipeline de nuvem depois que a fonte de dados fornece os dados e antes de serem enviados para o destino. Elas são definidas em uma DCR (regra de coleta de dados) e usam uma instrução KQL (Linguagem de Consulta Kusto) que é aplicada individualmente a cada entrada nos dados recebidos.

O diagrama a seguir ilustra o processo de transformação de dados de entrada e mostra uma consulta de exemplo que pode ser usada. Neste exemplo, apenas os registros em que a message coluna contém a palavra error são coletados.

Tabelas com suporte

As tabelas a seguir em um workspace do Log Analytics dão suporte a transformações.

- Todas as tabelas do Azure listadas em Tabelas que oferecem suporte a transformações nos Logs do Azure Monitor. Você também pode usar a Referência de dados do Azure Monitor que lista os atributos de cada tabela, incluindo se ela dá suporte a transformações.

- Qualquer tabela personalizada criada para o Agente do Azure Monitor.

Criar uma transformação

Há alguns cenários de coleta de dados que permitem adicionar uma transformação usando o portal do Azure, mas a maioria dos cenários exige que você crie um novo DCR usando sua definição JSON ou adicione uma transformação a um DCR existente. Consulte Criar uma transformação no Azure Monitor para diferentes opções e Práticas recomendadas e exemplos de transformações no Azure Monitor para consultas de transformação de exemplo para cenários comuns.

DCR de transformação do workspace

As transformações são definidas em uma DCR (regra de coleta de dados), mas ainda há coletas de dados no Azure Monitor que ainda não usam uma DCR. Os exemplos incluem logs de recursos coletados por configurações de diagnóstico e dados de aplicativos coletados pelo Application Insights.

A DCR (regra de coleta de dados) de transformação de workspace é uma DCR especial que é aplicada diretamente a um workspace do Log Analytics. A finalidade desse DCR é executar transformações em dados que ainda não usam um DCR para sua coleta de dados e, portanto, não tem meios para definir uma transformação.

Pode haver apenas uma DCR de workspace para cada workspace, mas pode incluir transformações para qualquer número de tabelas com suporte. Essas transformações são aplicadas a todos os dados enviados a essas tabelas, a menos que os dados sejam provenientes de outro DCR.

Por exemplo, a tabela Evento é usada para armazenar eventos de máquinas virtuais do Windows. Se você criar uma transformação na DCR de transformação do workspace para a tabela de eventos, ela será aplicada aos eventos coletados por máquinas virtuais que executam o agente do Log Analytics 1, pois esse agente não utiliza uma DCR. A transformação será ignorada por todos os dados enviados do AMA (Agente do Azure Monitor) porque ele usa uma DCR para definir sua coleta de dados.coleção de dados. Você ainda pode usar uma transformação com o agente do Azure Monitor, mas incluiria essa transformação na DCR associada ao agente e não na DCR de transformação do workspace.

1 O agente do Log Analytics foi preterido, mas alguns ambientes ainda podem usá-lo. É apenas um exemplo de uma fonte de dados que não usa uma DCR.

Custo para transformações

Embora as transformações em si não incorram em custos diretos, os seguintes cenários podem resultar em encargos adicionais:

- Se uma transformação aumentar o tamanho dos dados de entrada, como adicionar uma coluna calculada, você será cobrado pela taxa de ingestão padrão para os dados extras.

- Se uma transformação reduzir os dados de ingrestão em mais de 50%, você será cobrado pela quantidade de dados filtrados acima de 50%.

Para calcular a cobrança de processamento de dados resultante de transformações, use a seguinte fórmula:

[GB filtrado por transformações] – ([DADOS GB ingeridos por pipeline] / 2). A tabela a seguir mostra exemplos.

| Dados ingeridos por pipeline | Dados descartados por transformação | Dados ingeridos pelo workspace do Log Analytics | Encargo de processamento de dados | Encargo de ingestão |

|---|---|---|---|---|

| 20 GB | 12 GB | 8 GB | 2 GB 1 | 8 GB |

| 20 GB | 8 GB | 12 GB | 0 GB | 12 GB |

1 Essa cobrança exclui a cobrança pelos dados ingeridos pelo espaço de trabalho do Log Analytics.

Para evitar essa cobrança, você precisa filtrar dados ingeridos usando métodos alternativos antes de aplicar transformações. Ao fazer isso, você pode reduzir a quantidade de dados processados por transformações e, portanto, minimizar os custos adicionais.

ConsultePreços do Azure Monitor para cobranças atuais para ingestão e retenção de dados de log no Azure Monitor.

Importante

Se o Azure Sentinel estiver habilitado para o workspace do Log Analytics, não haverá cobrança de ingestão de filtragem, independentemente da quantidade de dados filtrada pela transformação.