Use o Azure Data Factory para migrar dados do data lake ou do data warehouse para o Azure

APLICA-SE A: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Dica

Experimente o Data Factory no Microsoft Fabric, uma solução de análise tudo-em-um para empresas. O Microsoft Fabric abrange desde movimentação de dados até ciência de dados, análise em tempo real, business intelligence e relatórios. Saiba como iniciar uma avaliação gratuita!

Se você quiser migrar o EDW (data lake ou data warehouse empresarial) para o Microsoft Azure, considere o uso do Azure Data Factory. O Azure Data Factory é adequado para os seguintes cenários:

- Migração de carga de trabalho de big data do Amazon S3 (Amazon Simple Storage Service) ou de um HDFS (Sistema de Arquivos Distribuído do Hadoop) local para o Azure

- Migração de EDW do Oracle Exadata, Netezza, Teradata ou Amazon Redshift para o Azure

O Azure Data Factory pode mover petabytes (PB) de dados para a migração do data lake e dezenas de terabytes (TB) de dados para a migração do data warehouse.

Por que o Azure Data Factory pode ser utilizado para a migração de dados

- O Azure Data Factory pode facilmente escalar verticalmente a quantidade de capacidade de processamento para mover dados de uma maneira sem servidor com alto desempenho, resiliência e escalabilidade. E você paga apenas pelo que usar. Também observe o seguinte:

- O Azure Data Factory não tem limitações no volume de dados ou no número de arquivos.

- O Azure Data Factory pode usar totalmente a largura de banda de rede e de armazenamento para obter o maior volume de taxa de transferência de movimentação de dados em seu ambiente.

- O Azure Data Factory usa um método pré-pago para que você pague apenas pelo tempo que realmente usar para executar a migração de dados para o Azure.

- O Azure Data Factory pode executar uma carga histórica única e cargas incrementais agendadas.

- O Azure Data Factory usa o IR (runtime de integração) do Azure para mover dados entre os pontos de extremidade do data lake e do warehouse acessíveis publicamente. Ele também pode usar o IR auto-hospedado para mover dados para os pontos de extremidade do data lake e do warehouse dentro da VNet (rede virtual) do Azure ou por trás de um firewall.

- O Azure Data Factory tem segurança de nível empresarial: você pode usar o Windows Installer (MSI) ou a identidade do serviço para integração segura de serviço a serviço ou usar o Azure Key Vault para o gerenciamento de credenciais.

- O Azure Data Factory oferece uma experiência de criação sem código e um painel de monitoramento interno e avançado.

Migração de dados online ou offline

O Azure Data Factory é uma ferramenta de migração de dados online padrão para transferir dados por uma rede (Internet, ER ou VPN). Já com a migração de dados offline, os usuários enviam fisicamente os dispositivos de transferência de dados da organização deles para um data center do Azure.

Há três considerações importantes quando você escolhe entre uma abordagem de migração online e offline:

- Tamanho dos dados a serem migrados

- Largura de banda da rede

- Janela de migração

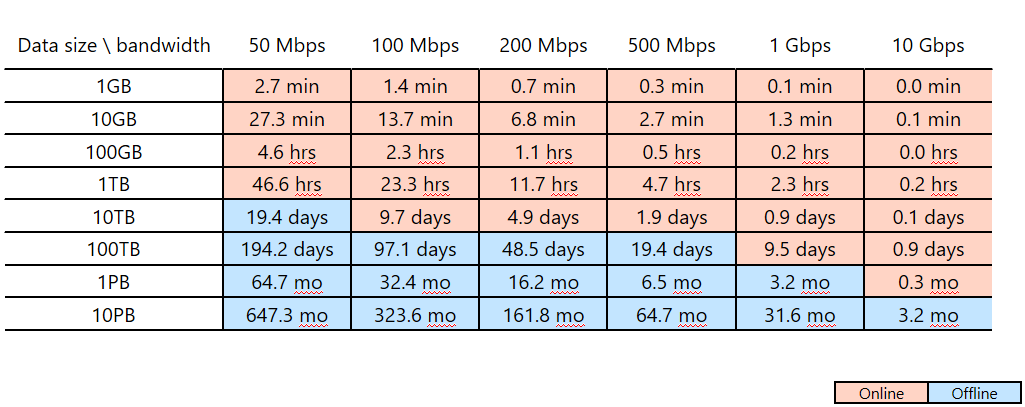

Por exemplo, suponha que você planeje usar o Azure Data Factory para concluir a migração de dados em duas semanas (a janela de migração). Observe a linha de corte rosa/azul na tabela a seguir. A célula rosa mais baixa para qualquer coluna especificada mostra o emparelhamento de tamanho de dados/largura de banda de rede cuja janela de migração está mais próxima de duas semanas, mas menor que esse período. (Qualquer emparelhamento de tamanho/largura de banda em uma célula azul tem uma janela de migração online de mais de duas semanas.)

Essa tabela ajuda a determinar se você pode atender à janela de migração pretendida por meio da migração online (Azure Data Factory) com base no tamanho dos dados e na largura de banda de rede disponível. Se a janela de migração online tiver mais de duas semanas, convém usar a migração offline.

Essa tabela ajuda a determinar se você pode atender à janela de migração pretendida por meio da migração online (Azure Data Factory) com base no tamanho dos dados e na largura de banda de rede disponível. Se a janela de migração online tiver mais de duas semanas, convém usar a migração offline.

Observação

Com o uso da migração online, você pode obter o carregamento de dados históricos e os feeds incrementais de ponta a ponta por meio de uma única ferramenta. Por meio dessa abordagem, os dados podem ser mantidos sincronizados entre o repositório existente e o novo durante toda a janela de migração. Isso significa que você pode recriar a lógica de ETL no repositório novo com dados atualizados.