Como funciona o gerenciador de orquestração de fluxo de trabalho do Azure Data Factory?

APLICA-SE A: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Dica

Experimente o Data Factory no Microsoft Fabric, uma solução de análise tudo-em-um para empresas. O Microsoft Fabric abrange desde movimentação de dados até ciência de dados, análise em tempo real, business intelligence e relatórios. Saiba como iniciar uma avaliação gratuita!

Observação

O gerenciador de orquestração de fluxo de trabalho é desenvolvido com Apache Airflow.

Observação

O gerenciador de orquestração de fluxo de trabalho para Azure Data Factory depende do aplicativo Apache Airflow de código aberto. Encontre a documentação e mais tutoriais do Airflow nas páginas Documentação ou Comunidade do Apache Airflow.

O gerenciador de orquestração de fluxo de trabalho no Azure Data Factory usa DAGs (grafos direcionados acíclicos) baseados em Python para executar seus fluxos de trabalho de orquestração. Para usar esse recurso, você precisa fornecer seus DAGs e plug-ins em Armazenamento de Blobs do Azure. Em seguida, execute e monitore os DAGs iniciando a interface do usuário do Airflow no ADF usando uma CLI (interface de linha de comando) ou um SDK (Software Development Kit).

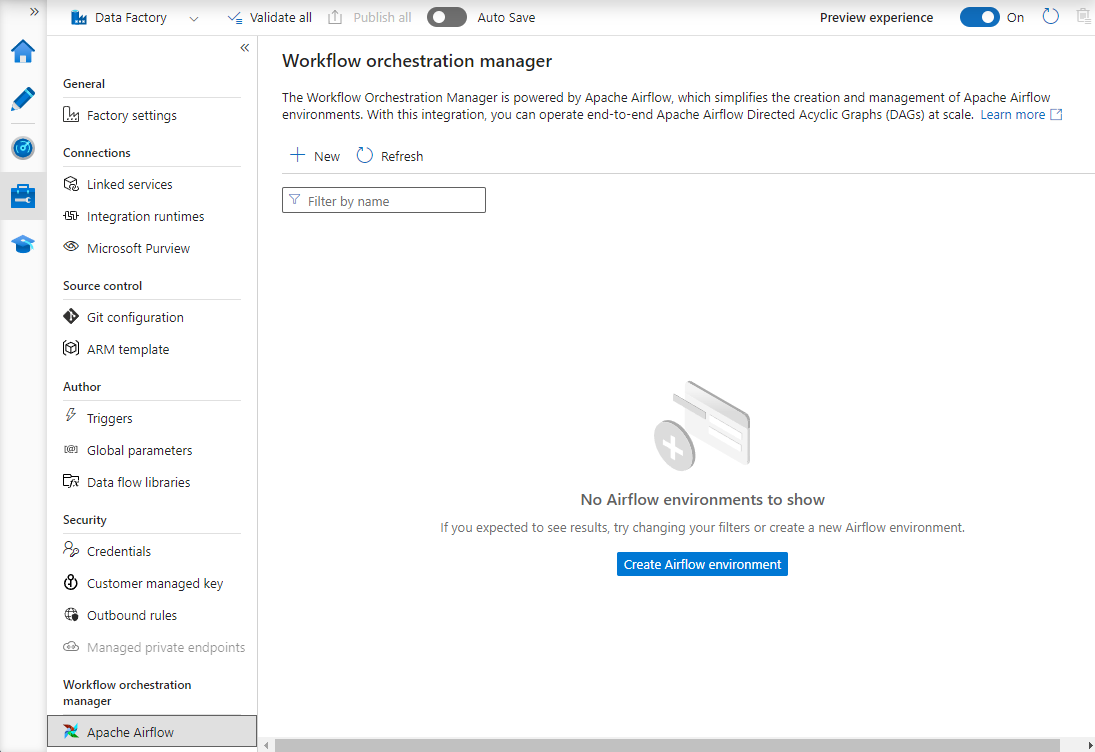

Criar um ambiente do gerenciador de orquestração de fluxo de trabalho

As etapas a seguir configuram seu ambiente do gerenciador de orquestração de fluxo de trabalho.

Pré-requisitos

Assinatura do Azure: caso você não tenha uma assinatura do Azure, crie uma conta gratuita antes de começar. Crie ou selecione um Data Factory existente na região em que há suporte para a versão prévia do gerenciador de orquestração de fluxo de trabalho.

Etapas para criar o ambiente

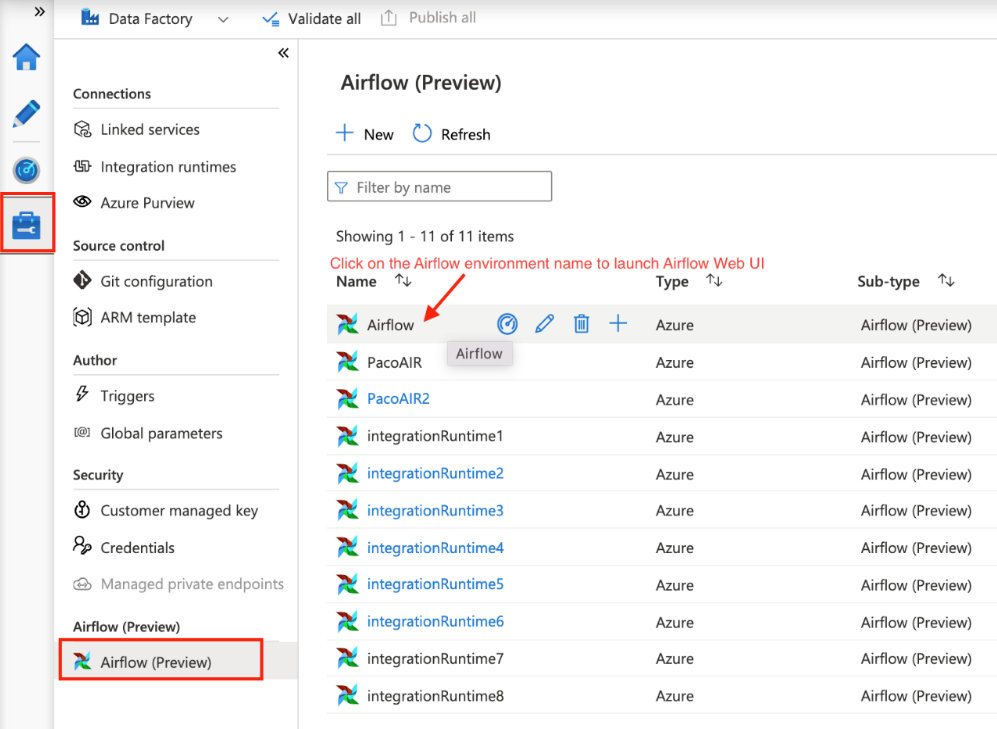

Crie um novo ambiente do gerenciador de orquestração de fluxo de trabalho. Acesse o hub Gerenciar ->Airflow (Versão prévia) ->+Novo para criar um ambiente do Airflow

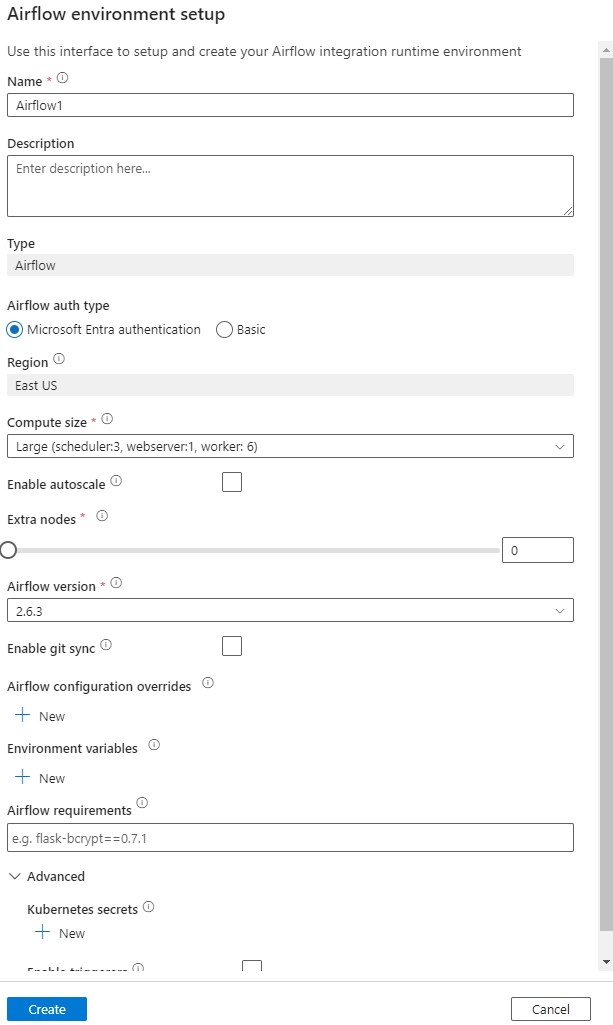

Forneça os detalhes (configuração do Airflow)

Importante

Ao usar a autenticação Básica, lembre-se do nome de usuário e da senha especificados nesta tela. Ele será necessário para fazer logon posteriormente na interface do usuário do gerenciador de orquestração de fluxo de trabalho. A opção padrão é Microsoft Entra ID e não exige a criação de nome de usuário/senha para seu ambiente do Airflow, mas usa a credencial do usuário conectado no Azure Data Factory para fazer logon/monitorar os DAGs.

Variáveis de ambiente – Um repositório de valores de chave simples no Airflow usado para armazenar e recuperar o conteúdo arbitrário ou as configurações.

Os requisitos podem ser usados para instalar as bibliotecas do Python previamente. Você também pode atualizá-las mais tarde.

Importar DAGs

As etapas a seguir descrevem como importar DAGs para o gerenciador de orquestração de fluxo de trabalho.

Pré-requisitos

Você precisará carregar um exemplo de DAG em uma conta de Armazenamento acessível (deve estar na pasta de dags).

Observação

Não há suporte para o Armazenamento de Blobs com a proteção de uma VNet durante a versão prévia.

A configuração do KeyVault nos storageLinkedServices não dá suporte à importação de dags.

Exemplo de DAG do Apache Airflow v2.x. Exemplo de DAG do Apache Airflow v1.10.

Etapas de importação

Copie e cole o conteúdo (v2.x ou v1.10 com base no ambiente do Airflow que você configurou) em um novo arquivo chamado tutorial.py.

Carregue o tutorial.py em um armazenamento de blobs. (Como carregar um arquivo no blob)

Observação

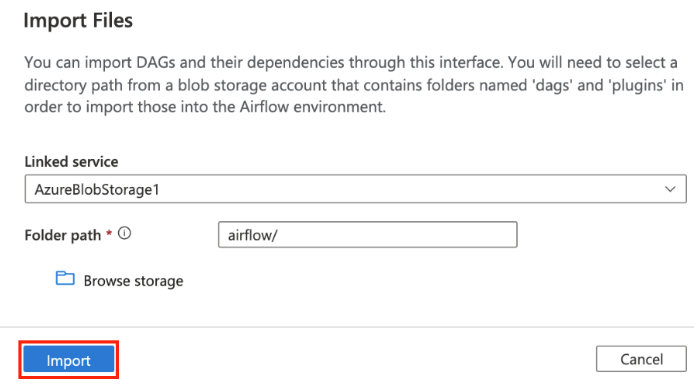

Você precisará selecionar um caminho de diretório de uma conta de armazenamento de blobs que contenha pastas chamadas dags e plugins para importá-las para o ambiente do Airflow. Os plug-ins não são obrigatórios. Você também pode ter um contêiner chamado dags e carregar todos os arquivos do Airflow nele.

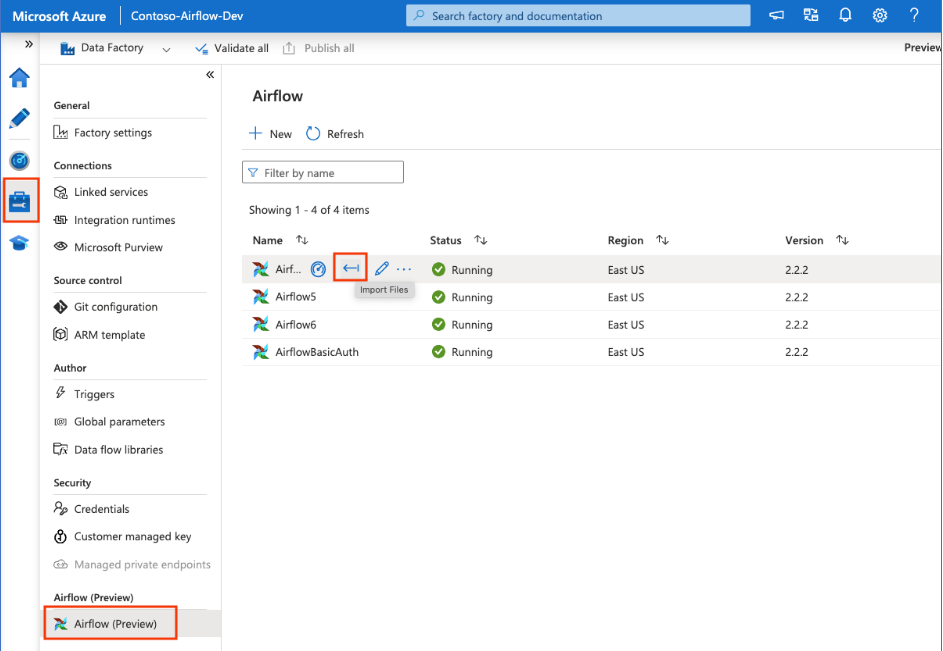

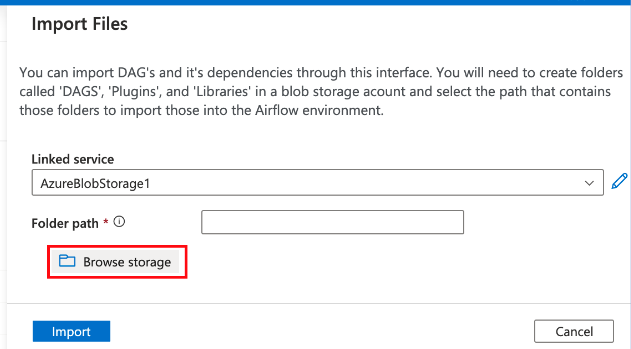

Selecione Airflow (Versão prévia) no hub Gerenciar. Em seguida, posicione o cursor sobre o ambiente do Airflow criado anteriormente e selecione Importar arquivos para importar todos os DAGs e as dependências para o ambiente do Airflow.

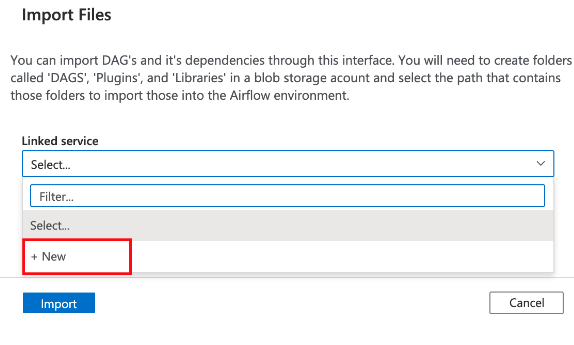

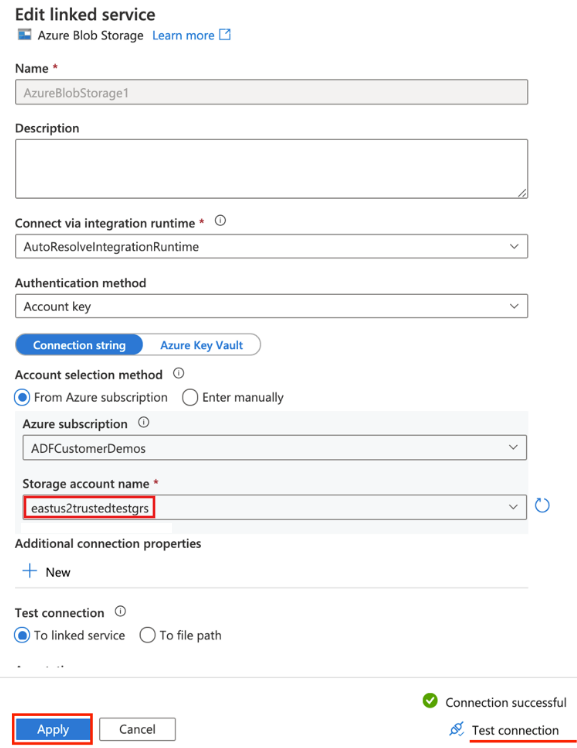

Crie um serviço vinculado para a conta de armazenamento acessível mencionada nos pré-requisitos (ou use um existente se você já tiver seus DAGs).

Use a conta de armazenamento na qual você carregou o DAG (confira os pré-requisitos). Teste a conexão e selecione Criar.

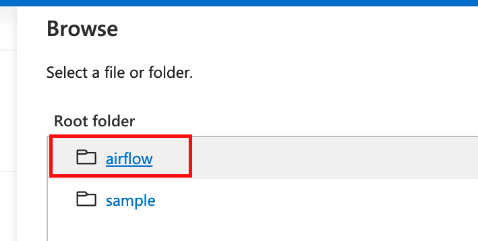

Procure e selecione Airflow se estiver usando a URL SAS de exemplo ou selecione a pasta que contém a pasta dags com os arquivos do DAG.

Observação

Você pode importar os DAGs e as respectivas dependências por meio dessa interface. Você precisará selecionar um caminho de diretório de uma conta de armazenamento de blobs que contenha pastas chamadas dags e plugins para importá-las para o ambiente do Airflow. Os plug-ins não são obrigatórios.

Observação

A importação dos DAGs pode levar alguns minutos durante a Versão prévia. O centro de notificações (ícone de sino na interface do usuário do ADF) pode ser usado para acompanhar as atualizações de status da importação.

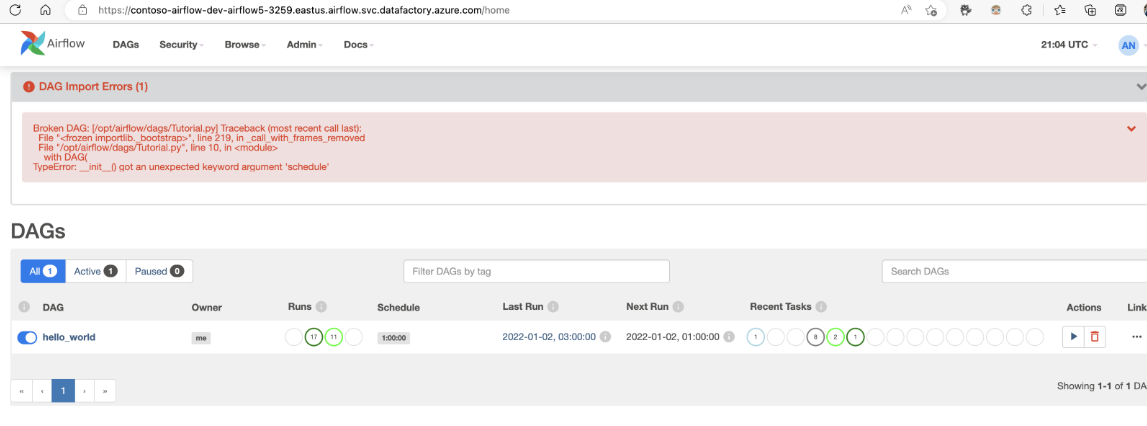

Solução de problemas de importação do DAG

Problema: A importação do DAG leva mais de cinco minutos Mitigação: Reduza o tamanho dos DAGs importados com uma só importação. Uma forma de fazer isso é criando várias pastas de DAGs com os DAGs menores em vários contêineres.

Problema: Os DAGs importados não são exibidos quando você entra na interface do usuário do Airflow. Mitigação: Entre na interface do usuário do Airflow e confira se há erros de análise de DAG. Isso poderá acontecer se os arquivos do DAG contiverem algum código incompatível. Você encontrará os números de linha exatos e os arquivos que têm o problema por meio da interface do usuário do Airflow.

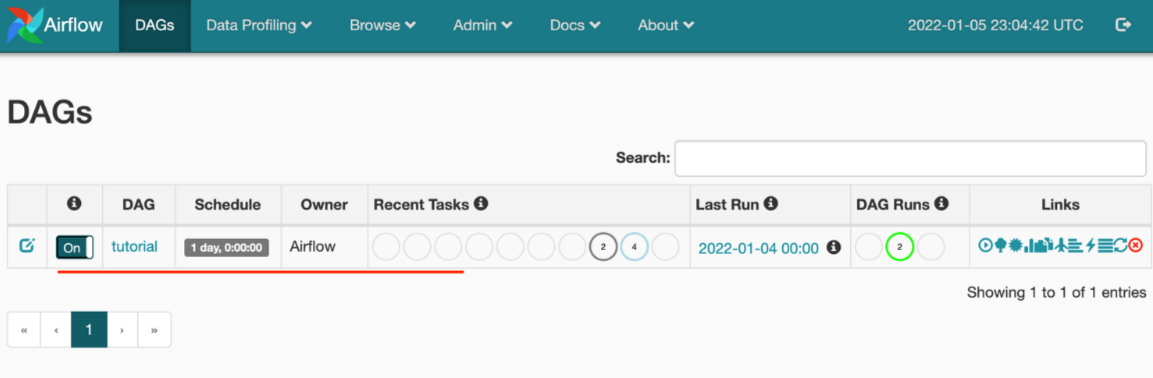

Monitorar as execuções de DAGs

Para monitorar os DAGs do Airflow, entre na interface do usuário do Airflow com o nome de usuário e a senha criados anteriormente.

Selecione o ambiente do Airflow criado.

Conecte-se usando o nome de usuário e a senha fornecidos durante a criação do runtime de integração do Airflow. (Você pode redefinir o nome de usuário ou a senha editando o runtime de integração do Airflow, se necessário)

Remover os DAGs do ambiente do Airflow

Se você estiver usando o Airflow versão 1.x, exclua os DAGs implantados em qualquer ambiente (IR) do Airflow. Será necessário excluir os DAGs em dois locais diferentes.

- Excluir o DAG na interface do usuário do Airflow

- Excluir o DAG na interface do usuário do ADF

Observação

Essa é a experiência atual durante a Versão prévia pública, e aprimoraremos essa experiência.