Observação

O acesso a essa página exige autorização. Você pode tentar entrar ou alterar diretórios.

O acesso a essa página exige autorização. Você pode tentar alterar os diretórios.

Neste artigo, você aprenderá quais opções estão disponíveis para escrever solicitações de consulta para modelos da fundação e como enviá-las para o seu ponto de extremidade de serviço de modelo. Você pode consultar modelos de base hospedados pelo Databricks e modelos de fundação hospedados fora do Databricks.

Para solicitações de consulta de modelos ML ou Python tradicionais, veja Consultar pontos de extremidade do serviço para modelos personalizados.

O Mosaic AI Model Serving dá suporte a APIs de Modelos de Fundação e modelos externos para acessar modelos de base. O Serviço de Modelos usa uma API e um SDK unificados e compatíveis com o OpenAI para consultá-los. Isso possibilita experimentar e personalizar modelos de base para produção em nuvens e provedores com suporte.

Opções de consulta

O Mosaic AI Model Serving fornece as seguintes opções para enviar solicitações de consulta para pontos de extremidade que atendem a modelos de base:

| Método | Detalhes |

|---|---|

| Cliente OpenAI | Consultar um modelo hospedado por um ponto de extremidade do Serviço de Modelo do Mosaic AI usando o cliente OpenAI. Especifique o nome do ponto de extremidade do Serviço de Modelo como a entrada model. Com suporte para modelos de chat, inserções e preenchimentos disponibilizados por APIs de modelos de base ou modelos externos. |

| Funções de IA | Invoque a inferência de modelo diretamente do SQL usando a função SQL ai_query.

Veja exemplo: consultar um modelo de base. |

| Interface do usuário de serviço | Selecione Ponto de extremidade de consulta na página Ponto de extremidade de atendimento. Insira os dados de entrada do modelo no formato JSON e clique em Enviar solicitação. Se o modelo tiver um exemplo de entrada registrado, use Mostrar Exemplo para carregá-lo. |

| API REST | Chame e consulte o modelo usando a API REST. Veja POST /serving-endpoints/{name}/invocations para obter detalhes. Para solicitações de pontuação para pontos de extremidade que atendem a vários modelos, veja Consultar modelos individuais em um ponto de extremidade. |

| SDK de Implantações do MLflow | Use a função predict() do SDK de Implantações do MLflow para consultar o modelo. |

| SDK do Databricks do Python | O SDK do Databricks Python é uma camada sobre a API REST. Ele lida com detalhes de baixo nível, como autenticação, facilitando a interação com os modelos. |

Requisitos

- Um ponto de extremidade do serviço de modelo.

- Um workspace do Databricks em uma região com suporte.

- Para enviar uma solicitação de pontuação através do cliente OpenAI, API REST ou SDK de implantação MLflow, deve ter um token API Databricks.

Importante

Como prática recomendada de segurança para cenários de produção, a Databricks recomenda que você use tokens OAuth máquina a máquina para autenticação durante a produção.

Para testes e desenvolvimento, o Databricks recomenda a utilização de um token de acesso pessoal pertencente a entidades de serviço em vez de usuários do workspace. Para criar tokens para entidades de serviço, consulte Gerenciar tokens para uma entidade de serviço.

Instalar pacotes

Depois de selecionar um método de consulta, primeiro você deve instalar o pacote apropriado no cluster.

Cliente OpenAI

Para usar o cliente OpenAI, o pacote databricks-sdk[openai] precisa ser instalado em seu cluster. O SDK do Databricks fornece um wrapper para construir o cliente OpenAI com autorização configurada automaticamente para consultar modelos de IA generativos. Execute o seguinte no bloco de anotações ou no terminal local:

!pip install databricks-sdk[openai]>=0.35.0

A seguir só é necessário ao instalar o pacote em um Databricks Notebook

dbutils.library.restartPython()

API REST

O acesso à API REST de serviço está disponível no Databricks Runtime para Machine Learning.

SDK de Implantações do MLflow

!pip install mlflow

A seguir só é necessário ao instalar o pacote em um Databricks Notebook

dbutils.library.restartPython()

SDK do Databricks do Python

O SDK do Databricks para Python já está instalado em todos os clusters do Azure Databricks que usam o Databricks Runtime 13.3 LTS ou superior. Para clusters do Azure Databricks que usam o Databricks Runtime 12.2 LTS e inferior, você precisa instalar primeiro o SDK do Databricks para Python. Consulte SDK do Databricks para Python.

Tipos de modelo de fundação

A tabela a seguir resume os modelos de base com suporte com base no tipo de tarefa.

Importante

Meta-Llama-3.1-405B-Instruct será desativado,

- A partir de 15 de fevereiro de 2026 para cargas de trabalho pagas por token.

- A partir de 15 de maio de 2026 para cargas de trabalho com taxa de transferência provisionada.

Consulte modelos desativados para obter o modelo de substituição recomendado e orientações sobre como migrar durante a depreciação.

| Tipo de tarefa | Descrição | Modelos com suporte | Quando usar? Casos de uso recomendados |

|---|---|---|---|

| Propósito geral | Modelos projetados para entender e se envolver em conversas com várias rodadas, de forma natural. Eles são ajustados em grandes conjuntos de dados do diálogo humano, o que permite que eles gerem respostas contextualmente relevantes, acompanhem o histórico de conversas e forneçam interações coerentes e semelhantes a humanos em vários tópicos. | A seguir estão os modelos suportados da fundação hospedada pelo Databricks:

Os seguintes modelos externos são suportados:

|

Recomendado para cenários onde o diálogo natural, em múltiplos turnos, e a compreensão contextual são necessários:

|

| Inserções | Os modelos de inserção são sistemas de machine learning que transformam dados complexos, como texto, imagens ou áudio, em vetores numéricos compactos chamados inserções. Esses vetores capturam os recursos e relações essenciais dentro dos dados, permitindo uma comparação eficiente, clustering e pesquisa semântica. | A seguir, há suporte para o modelo de fundação hospedado pelo Databricks: Os seguintes modelos externos são suportados:

|

Recomendado para aplicativos em que a compreensão semântica, a comparação de similaridade e a recuperação eficiente ou o clustering de dados complexos são essenciais:

|

| Visão | Modelos projetados para processar, interpretar e analisar dados visuais, como imagens e vídeos, para que os computadores possam "ver" e entender o mundo visual. | A seguir estão os modelos suportados da fundação hospedada pelo Databricks:

Os seguintes modelos externos são suportados:

|

Recomendado sempre que for necessária uma análise automatizada, precisa e escalonável das informações visuais:

|

| Raciocínio | Sistemas avançados de IA projetados para simular o pensamento lógico humano. Os modelos de raciocínio integram técnicas como lógica simbólica, raciocínio probabilístico e redes neurais para analisar o contexto, dividir tarefas e explicar sua tomada de decisão. | A seguir, há suporte para o modelo de fundação hospedado pelo Databricks:

Os seguintes modelos externos são suportados:

|

Recomendado sempre que for necessária uma análise automatizada, precisa e escalonável das informações visuais:

|

Chamada de função

A Chamada de Função do Databricks é compatível com o OpenAI e só está disponível durante a disponibilização do modelo como parte das APIs do Modelo de Base e nos pontos de extremidade que atendem aos modelos externos. Para mais detalhes, consulte chamada de função no Azure Databricks.

Saídas estruturadas

As saídas estruturadas são compatíveis com OpenAI e só estão disponíveis durante o serviço do modelo como parte das APIs de Modelos Fundamentais. Para obter detalhes, consulte Saídas estruturadas no Azure Databricks.

Cache de prompts

Há suporte para o cache de prompts para modelos Claude hospedados pelo Databricks como parte das APIs do Foundation Model.

Você pode especificar o cache_control parâmetro em suas solicitações de consulta para armazenar em cache o seguinte:

- Mensagens de conteúdo de texto na

messages.contentmatriz. - Conteúdo de mensagens de pensamento na

messages.contentmatriz. - Blocos de conteúdo de imagens na

messages.contentmatriz. - Uso de ferramentas, resultados e definições na

toolsmatriz.

Consulte Referência da API REST do modelo Foundation.

TextContent

{

"messages": [

{

"role": "user",

"content": [

{

"type": "text",

"text": "What's the date today?",

"cache_control": { "type": "ephemeral" }

}

]

}

]

}

ReasonContent

{

"messages": [

{

"role": "assistant",

"content": [

{

"type": "reasoning",

"summary": [

{

"type": "summary_text",

"text": "Thinking...",

"signature": "[optional]"

},

{

"type": "summary_encrypted_text",

"data": "[encrypted text]"

}

]

}

]

}

]

}

ImageContent

O conteúdo da mensagem de imagem deve usar os dados codificados como sua fonte. Não há suporte para URLs.

{

"messages": [

{

"role": "user",

"content": [

{

"type": "text",

"text": "What’s in this image?"

},

{

"type": "image_url",

"image_url": {

"url": "data:image/jpeg;base64,[content]"

},

"cache_control": { "type": "ephemeral" }

}

]

}

]

}

ToolCallContent

{

"messages": [

{

"role": "assistant",

"content": "Ok, let’s get the weather in New York.",

"tool_calls": [

{

"type": "function",

"id": "123",

"function": {

"name": "get_weather",

"arguments": "{\"location\":\"New York, NY\"}"

},

"cache_control": { "type": "ephemeral" }

}

]

}

]

}

Observação

A API REST do Databricks é compatível com OpenAI e difere da API Antropática. Essas diferenças também afetam objetos de resposta, como o seguinte:

- A saída é retornada no

choicescampo. - Formato de partes de streaming. Todas as partes aderem ao mesmo formato em que

choicescontém a respostadeltae o uso é retornado em cada parte. - O motivo da parada é retornado no

finish_reasoncampo.- O antropo usa:

end_turn, ,stop_sequenceemax_tokenstool_use - Respectivamente, o Databricks usa:

stop,stop,length, etool_calls

- O antropo usa:

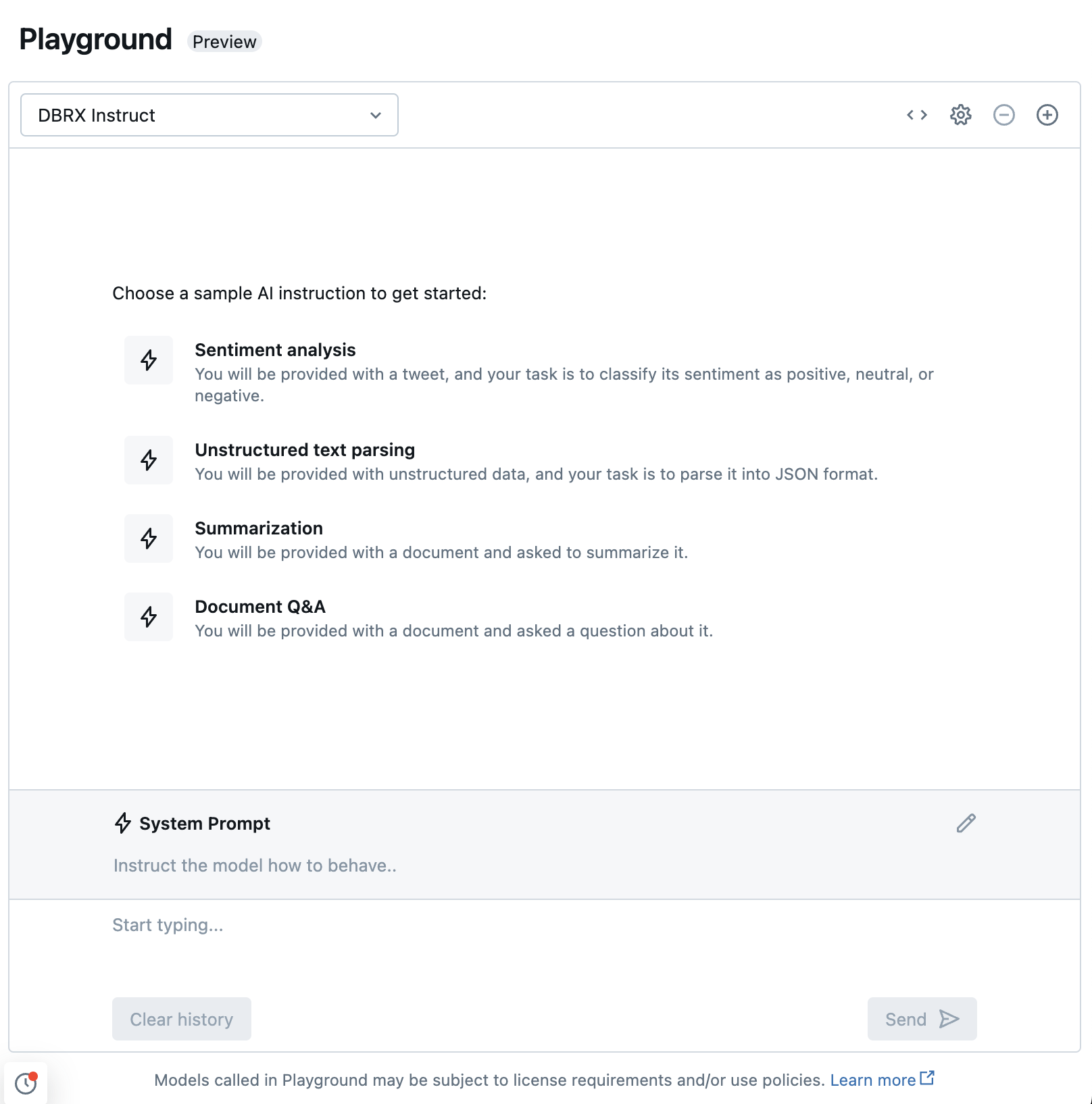

Conversar com LLMs com suporte usando o Playground de IA

Você pode interagir com modelos de linguagem grandes com suporte usando o Playground de IA. O Playground de IA é um ambiente semelhante a um chat onde você pode testar, enviar solicitações e comparar LLMs a partir do seu workspace do Azure Databricks.

Recursos adicionais

- Monitorar modelos atendidos usando tabelas de inferência habilitadas para Gateway de IA

- Implantar pipelines de inferência em lote

- APIs de foundation model do Databricks

- Modelos externos no Serviço de Modelo de IA do Mosaic.

- Tutorial: criar pontos de extremidade de modelo externo para consultar modelos do OpenAI.

- Modelos de base hospedados pelo Databricks disponíveis nas APIs do Foundation Model

- Referência da API REST do modelo do Foundation