Execute seu trabalho do Azure Databricks com computação sem servidor para fluxos de trabalho

Importante

Como a computação sem servidor para fluxos de trabalho não dá suporte ao controle do tráfego de saída, seus trabalhos têm acesso total à Internet.

A computação sem servidor para fluxos de trabalho permite executar o trabalho do Azure Databricks sem configurar e implantar infraestrutura. Com a computação sem servidor, você se concentra na implementação de pipelines de processamento de dados e análise, e o Azure Databricks gerencia com eficiência os recursos de computação, incluindo a otimização e o dimensionamento da computação para suas cargas de trabalho. O escalonamento automático e o Photon são habilitados automaticamente para os recursos de computação que executam seu trabalho.

A computação sem servidor para otimização automática de fluxos de trabalho otimiza automaticamente a computação selecionando recursos apropriados, como tipos de instância, memória e mecanismos de processamento com base na sua carga de trabalho. A otimização automática também tenta automaticamente trabalhos com falha.

O Databricks atualiza automaticamente a versão do Databricks Runtime para suportar melhorias e atualizações na plataforma, garantindo ao mesmo tempo a estabilidade dos seus trabalhos do Azure Databricks. Para ver a versão atual do Databricks Runtime usada pela computação sem servidor para fluxos de trabalho, veja Notas de versão da computação sem servidor.

Como a permissão de criação de cluster não é necessária, todos os usuários do workspace podem usar a computação sem servidor para executar seus fluxos de trabalho.

Esse artigo descreve a utilização da UI do Azure Databricks Jobs para criar e executar trabalhos que utilizam computação sem servidor. Você também pode automatizar a criação e execução de trabalhos que usam computação sem servidor com a API Jobs, Databricks Asset Bundles e o SDK do Databricks para Python.

- Para saber mais sobre como usar a API Jobs para criar e executar jobs que usam computação sem servidor, veja Jobs na referência da API REST.

- Para saber mais sobre como usar Databricks Asset Bundles para criar e executar trabalhos que usam computação sem servidor, veja Desenvolver um trabalho no Azure Databricks usando Databricks Asset Bundles.

- Para saber mais sobre como usar o SDK do Databricks para Python para criar e executar trabalhos que usam computação sem servidor, veja SDK do Databricks para Python.

Requisitos

O seu espaço de trabalho Azure Databricks deve ter o Catálogo Unity habilitado.

Como a computação sem servidor para fluxos de trabalho usa o modo de acesso compartilhado, suas cargas de trabalho devem oferecer suporte a esse modo de acesso.

O seu espaço de trabalho Azure Databricks deve estar numa região suportada. Consulte Disponibilidade de recursos.

Sua conta do Azure Databricks deve ter a computação sem servidor habilitada. Confira Habilitar a computação sem servidor.

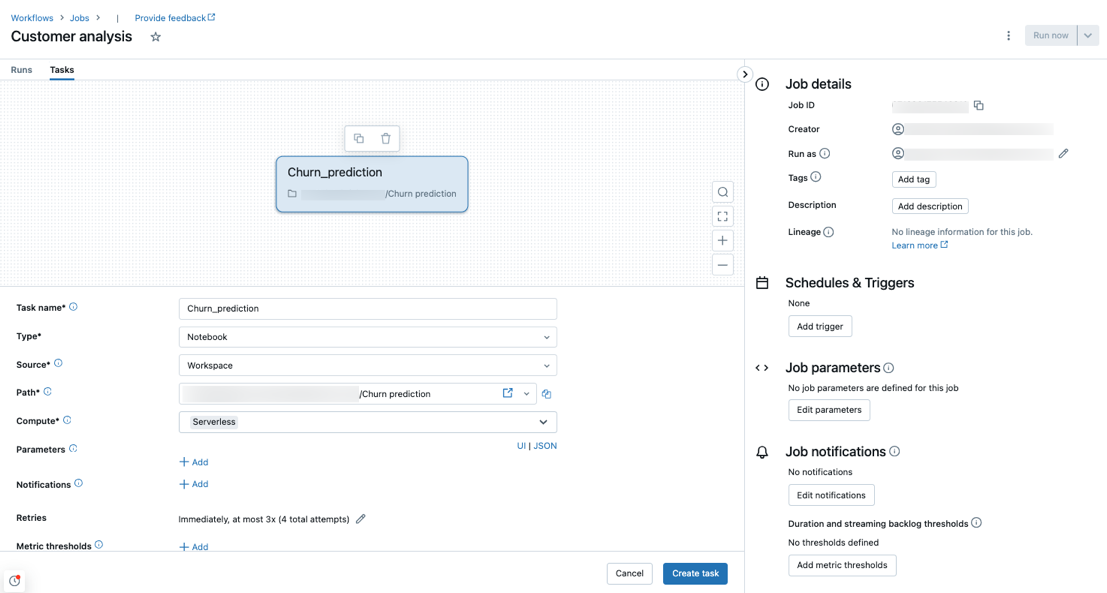

Crie um trabalho usando computação sem servidor

Observação

A computação sem servidor para fluxos de trabalho garante que recursos suficientes sejam provisionados para executar suas cargas de trabalho, por isso você pode experimentar tempos de inicialização maiores ao executar um trabalho do Azure Databricks que exija grandes quantidades de memória ou inclua muitas tarefas.

A computação sem servidor é compatível com notebook, script Python, dbt e roda Python tipos de tarefas. Por padrão, a computação sem servidor é selecionada como o tipo de computação quando você cria um novo trabalho e adiciona um desses tipos de tarefas compatíveis.

A Databricks recomenda a utilização de computação sem servidor para todas as tarefas de trabalho. Você também pode especificar diferentes tipos de computação para tarefas em um trabalho, o que poderá ser necessário se um tipo de tarefa não for compatível com a computação sem servidor para fluxos de trabalho.

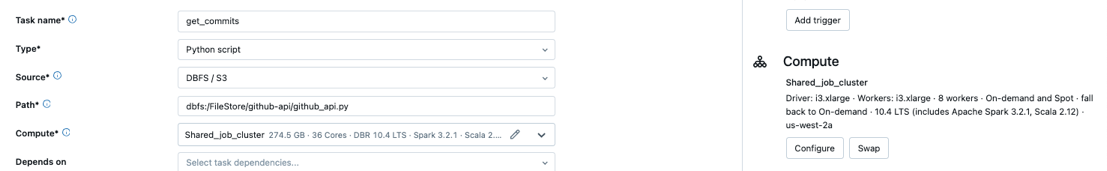

Configurar um trabalho existente para usar computação sem servidor

Você pode alternar um trabalho existente para usar computação sem servidor para tipos de tarefas compatíveis ao editar o trabalho. Para mudar para a computação sem servidor:

- No painel lateral Detalhes do trabalho, clique em Trocar em Calcular, clique em Novo, insira ou atualize quaisquer configurações e clique em Atualizar.

- Clique em

no menu suspensoComputação e selecione Sem servidor.

no menu suspensoComputação e selecione Sem servidor.

Agende um notebook usando computação sem servidor

Além de usar a UI Jobs para criar e agendar um trabalho usando computação sem servidor, você pode criar e executar um trabalho que usa computação sem servidor diretamente de um notebook do Databricks. Consulte Criar e gerenciar trabalhos agendados do notebook.

Definir parâmetros de configuração do Spark

Para automatizar a configuração do Spark na computação sem servidor, o Databricks permite definir apenas parâmetros específicos de configuração do Spark. Para obter a lista de parâmetros permitidos, consulte Parâmetros de configuração do Spark com suporte.

Você pode definir os parâmetros de configuração do Spark somente no nível da sessão. Para fazer isso, defina-os em um bloco de notas e adicione o bloco de notas a uma tarefa incluída no mesmo trabalho que usa os parâmetros. Veja Obtenha e defina propriedades de configuração do Apache Spark em um notebook.

Configurar ambientes e dependências

Para saber como instalar bibliotecas de dependências usando a computação sem servidor, consulte Instalar dependências do notebook.

Configure a otimização automática de computação sem servidor para proibir novas tentativas

A computação sem servidor para otimização automática de fluxos de trabalho otimiza automaticamente a computação usada para executar seus trabalhos e tenta executar novamente trabalhos com falha. A otimização automática é habilitada por padrão e a Databricks recomenda deixá-la habilitada para garantir que cargas de trabalho críticas sejam executadas com êxito pelo menos uma vez. No entanto, se você tiver cargas de trabalho que devem ser executadas no máximo uma vez, por exemplo, trabalhos que não são idempotentes, você poderá desativar a otimização automática ao adicionar ou editar uma tarefa:

- Ao lado de Repetições, clique em Adicionar (ou

se já existir uma política de novas tentativas).

se já existir uma política de novas tentativas). - Na caixa de diálogo Retry Policy, desmarque Habilitar otimização automática sem servidor (pode incluir novas tentativas).

- Clique em Confirmar.

- Se você estiver adicionando uma tarefa, clique em Criar tarefa. Se você estiver editando uma tarefa, clique em Salvar tarefa.

Monitore o custo de trabalhos que usam computação sem servidor para fluxos de trabalho

Você pode monitorar o custo de trabalhos que usam computação sem servidor para fluxos de trabalho consultando a tabela do sistema de uso faturável. Essa tabela é atualizada para incluir atributos de usuário e carga de trabalho sobre custos sem servidor. Confira Referência da tabela do sistema de uso faturável.

Exibir os detalhes das suas consultas do Spark

A computação sem servidor para fluxos de trabalho tem uma nova interface para visualizar informações detalhadas de tempo de execução para suas instruções Spark, como métricas e planos de consulta. Para exibir insights de consulta para instruções Spark incluídas em seus trabalhos executados na computação sem servidor:

- Clique em

Fluxos de trabalho na barra lateral.

Fluxos de trabalho na barra lateral. - Na coluna Nome, clique no nome do trabalho para o qual você deseja exibir insights.

- Clique na execução específica para a qual você deseja exibir insights.

- Na seção Computação do painel do lado de Execução da tarefa, clique no Histórico de consultas.

- Você é redirecionado para o Histórico de Consultas, pré-filtrado com base na ID de execução da tarefa em que você estava.

Para obter informações sobre o histórico de consultas, confira Histórico de consultas.

Limitações

Para obter uma lista de limitações de computação sem servidor para fluxos de trabalho, veja Limitações de computação sem servidor nas notas de versão da computação sem servidor.

Comentários

Em breve: Ao longo de 2024, eliminaremos os problemas do GitHub como o mecanismo de comentários para conteúdo e o substituiremos por um novo sistema de comentários. Para obter mais informações, consulte https://aka.ms/ContentUserFeedback.

Enviar e exibir comentários de