Enviar execução em lote e avaliar um fluxo

Para avaliar o desempenho do fluxo com um grande conjunto de dados, envie uma execução em lote e use os métodos de avaliação internos no prompt flow.

Neste artigo, você aprenderá a:

- Enviar uma Execução em lote e Usar um Método de Avaliação Interno

- Exibir o resultado e as métricas da avaliação

- Iniciar uma nova rodada de avaliação

- Verificar o Histórico de Execuções em Lote e Comparar as Métricas

- Entender as métricas de avaliação internas

- Maneiras de melhorar o desempenho do fluxo

- Leitura adicional: diretrizes para criar Conjuntos de Dados Golden usados para garantia de qualidade do Copilot

Você pode começar rapidamente a testar e avaliar seu fluxo seguindo este tutorial em vídeo Enviar execução em lote e avaliar um tutorial em vídeo do fluxo.

Pré-requisitos

Para executar uma execução em lote e utilizar um método de avaliação, você precisa ter o seguinte preparado:

- Um conjunto de dados de teste para execução em lote. O conjunto de dados deve estar em um destes formatos:

.csv,.tsvou.jsonl. Seus dados também devem incluir cabeçalhos que correspondam aos nomes de entrada do fluxo. Leitura adicional: se você estiver criando o seu próprio copiloto, recomendamos conferir Diretrizes para criar conjuntos de dados Golden usados para a garantia de qualidade do Copilot.

Enviar uma execução em lote e utilizar um método de avaliação interno

Uma execução em lote permite que você execute seu fluxo com um grande conjunto de dados e gere saídas para cada linha de dados. Você também pode escolher um método de avaliação para comparar a saída do fluxo com determinados critérios e metas. Um método de avaliação é um tipo especial de fluxo que calcula as métricas para a saída do fluxo com base em diferentes aspectos. Uma execução de avaliação será feita para calcular as métricas quando enviadas com a execução em lote.

Para iniciar uma execução em lote com avaliação, selecione o botão "Avaliar" no canto superior direito da página de fluxo.

Para enviar a execução em lote, você pode selecionar um conjunto de dados para testar o fluxo. Você também pode selecionar um método de avaliação para calcular as métricas para a saída do fluxo. Se você não deseja utilizar um método de avaliação, pode pular esta etapa e executar o lote sem calcular nenhuma métrica. Você também pode iniciar uma nova rodada de avaliação mais tarde.

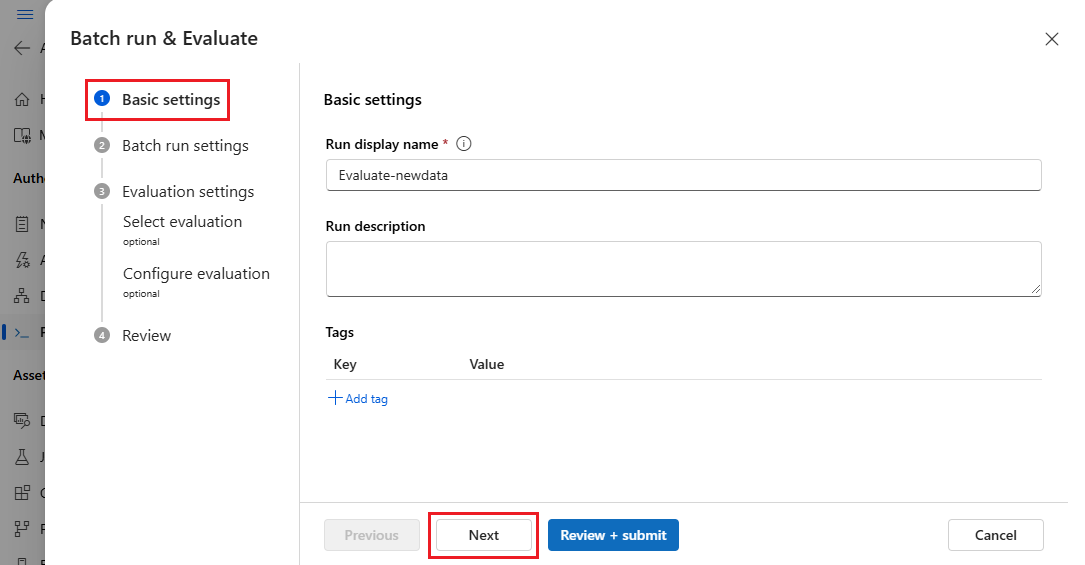

Primeiro, você será solicitado a fornecer um nome descritivo e reconhecível a sua execução em lote. Você também pode escrever uma descrição e adicionar marcas (pares de chave-valor) à sua execução em lote. Depois de concluir a configuração, selecione "Avançar" para continuar.

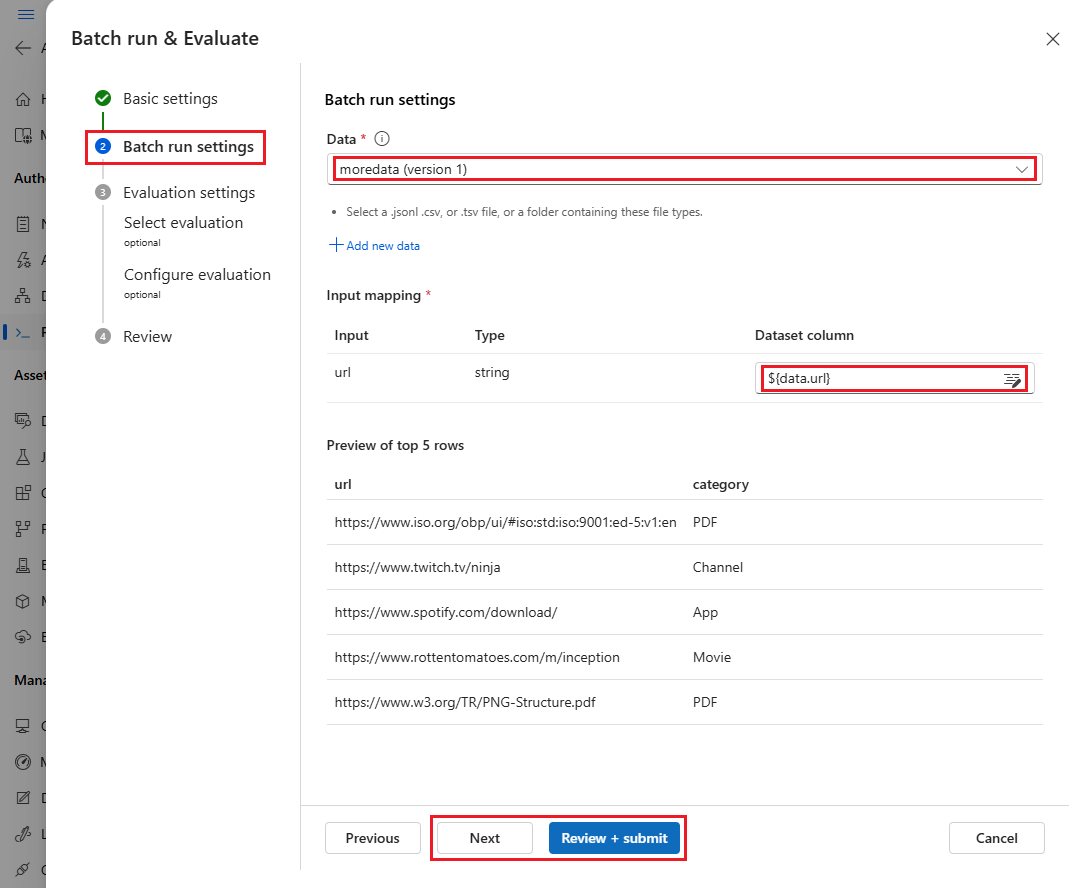

Em segundo lugar, você deve selecionar ou fazer upload de um conjunto de dados com o qual deseja testar seu fluxo.

O fluxo de prompts também dá suporte ao mapeamento da entrada do fluxo para uma coluna de dados específica no seu conjunto de dados. Isso significa que você pode atribuir uma coluna a uma determinada entrada. Você deve atribuir uma coluna a uma entrada fazendo referência ao formato ${data.XXX}. Se você deseja atribuir um valor constante a uma entrada, poderá digitar diretamente esse valor.

Em seguida, na próxima etapa, você pode decidir por utilizar um método de avaliação para validar o desempenho dessa execução imediata ou posteriormente. Para uma execução em lote concluída, uma nova rodada de avaliação ainda pode ser adicionada.

Você pode selecionar diretamente o botão "Avançar" para pular essa etapa e executar o lote sem utilizar nenhum método de avaliação para calcular as métricas. Dessa forma, essa execução em lote gerará apenas saídas para seu conjunto de dados. Você pode verificar as saídas manualmente ou exportá-las para análise posterior com outros métodos.

Caso contrário, se você quiser realizar a execução em lote com a avaliação agora, poderá selecionar um ou mais métodos de avaliação com base na descrição fornecida. Selecione o botão "Mais detalhes" para ver mais informações sobre o método de avaliação, como as métricas que ele gera e as conexões e entradas necessárias.

Vá para a próxima etapa e defina as configurações de avaliação. Na seção "Mapeamento de entrada da avaliação", você precisa especificar as fontes dos dados de entrada necessários para o método de avaliação. Por exemplo, a coluna ground truth pode vir de um conjunto de dados. Por padrão, a avaliação usa o mesmo conjunto de dados do conjunto de dados de teste fornecido para a execução testada. No entanto, se os rótulos correspondentes ou os valores de verdade de base de destino estiverem em um conjunto de dados diferente, você poderá alternar facilmente para esse.

Portanto, para executar uma avaliação, você precisa indicar as fontes desses inputs necessários. Para fazer isso, ao enviar uma avaliação, você verá uma seção "Mapeamento de entrada de avaliação".

- Se a fonte de dados for da sua saída de execução, a fonte será indicada como "${run.output.[OutputName]}"

- Se a fonte de dados for do seu conjunto de dados de teste, a fonte será indicada como "${data.[ColumnName]}"

Observação

Se sua avaliação não exigir dados do conjunto de dados, você não precisará fazer referência a nenhuma coluna de conjunto de dados na seção de mapeamento de entrada, indicando que a seleção do conjunto de dados é uma configuração opcional. A seleção do conjunto de dados não afetará o resultado da avaliação.

Se um método de avaliação utilizar Modelos de Linguagem Grande (LLMs) para medir o desempenho da resposta ao fluxo, você também deverá definir conexões para os nós LLM nos métodos de avaliação.

Observação

Alguns métodos de avaliação exigem o GPT-4 ou GPT-3 para funcionar. Você deve fornecer conexões válidas para esses métodos de avaliação antes de usá-los. Alguns processos de avaliação podem ocupar muitos tokens, portanto, é recomendável usar um modelo que possa dar suporte a tokens >=16k.

Após concluir o mapeamento de entrada, selecione "Avançar" para revisar suas configurações e selecione "Enviar" para iniciar a execução do lote com avaliação.

Observação

As execuções em lote têm uma duração máxima de 10 horas. Se uma execução em lote exceder esse limite, ela será encerrada e marcada como com falha. Aconselhamos monitorar sua capacidade de Modelo de Linguagem Grande (LLM) para evitar a limitação. Se necessário, considere reduzir o tamanho dos dados. Se você continuar enfrentando problemas ou precisar de assistência adicional, não hesite em entrar em contato com nossa equipe de produtos por meio do formulário de comentários ou da solicitação de suporte.

Exibir o resultado e as métricas da avaliação

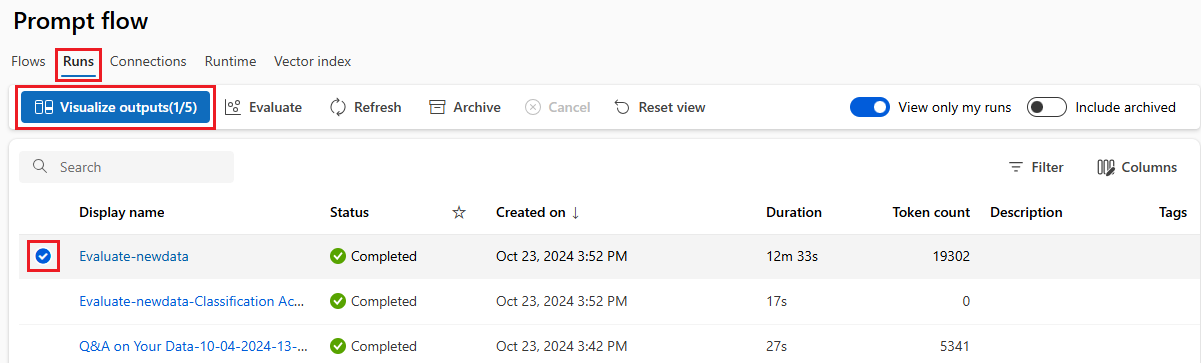

Após o envio, você poderá encontrar a execução em lote enviada na guia da lista de execuções na página de fluxo de prompts.

Selecione uma execução para navegar até a página Executar resultado, para verificar os resultados desta execução em lote.

Saída

Resultado básico e rastreamento

Em primeiro lugar, isso direcionará você para a guia Saída para exibir as entradas e saídas linha por linha. A página de guia de saída exibe uma lista de resultados da tabela, incluindo a ID da linha, a entrada, a saída, ostatus, as métricas do sistema e o tempo de criação.

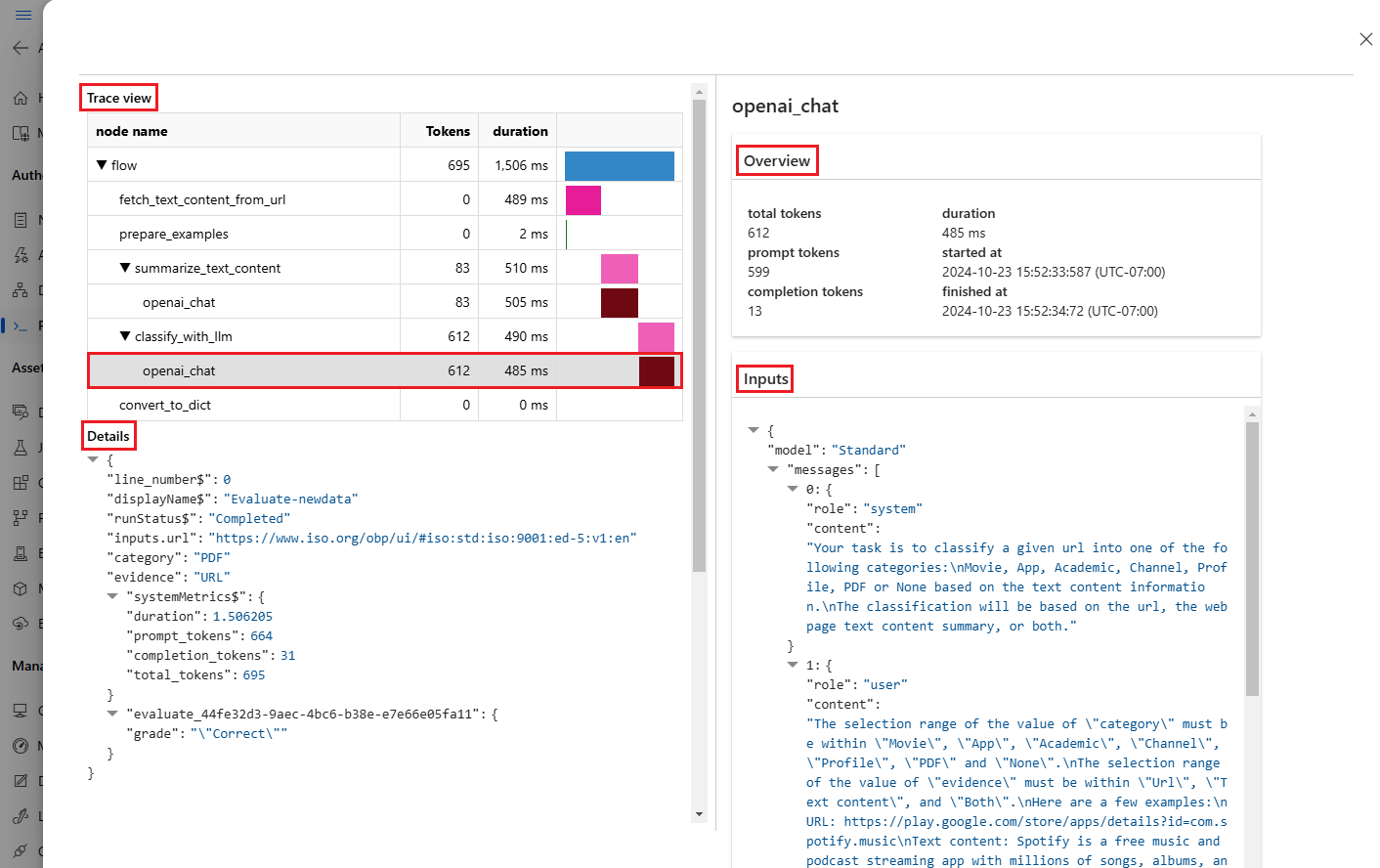

Para cada linha, selecionar Exibir rastreamento permite observar e depurar esse caso de teste específico em sua página detalhada de rastreamento.

Acrescentar resultado da avaliação e rastrear

Selecionar Acrescentar saída de avaliação permite selecionar execuções de avaliação relacionadas e você vê colunas acrescentadas no final da tabela mostrando o resultado da avaliação de cada linha de dados. Várias saídas de avaliação podem ser acrescentadas para comparação.

Você pode ver as métricas de avaliação mais recentes no painel de Visão geral à esquerda.

Visão geral essencial

No lado direito, a Visão Geral oferece informações gerais sobre a execução, como o número de execução por ponto de dados, o total de tokens e a duração da execução.

As métricas agregadas de execução de avaliação mais recentes são mostradas aqui por padrão, você pode selecionar Exibir a execução de avaliação para ir para exibir a própria execução de avaliação.

A visão geral pode ser expandida e recolhida aqui, e você pode selecionar Exibir informações completas, o que direcionará você para a guia Visão geral ao lado da guia Saída, onde estão contidas informações mais detalhadas da execução.

Iniciar uma nova rodada de avaliação

Se você já tiver concluído uma execução em lote, poderá iniciar outra rodada de avaliação para enviar uma nova execução de avaliação para calcular as métricas das saídas sem executar o fluxo novamente. Isso é útil e pode economizar seu custo para executar novamente o fluxo quando:

- você não selecionou um método de avaliação para calcular as métricas ao enviar a execução em lote e decidiu fazer isso agora.

- você já usou o método de avaliação para calcular uma métrica. Você pode iniciar outra rodada de avaliação para calcular outra métrica.

- sua execução de avaliação falhou, mas o fluxo gerou saídas com sucesso. Você pode enviar sua avaliação novamente.

Você pode selecionar Avaliar para iniciar outra rodada de avaliação.

Depois de definir a configuração, selecione "Enviar" para esta nova rodada de avaliação. Após o envio, você poderá ver um novo registro na lista de execução do fluxo de prompts solicitado. Após a conclusão da execução da avaliação, da mesma forma, você pode verificar o resultado da avaliação na guia "Saída" do painel de detalhes da execução em lote. Selecione a nova execução de avaliação para exibir seu resultado.

Para obter mais informações sobre as métricas calculadas pelos métodos de avaliação internos, navegue até Entendendo as métricas de avaliação internas.

Visão geral

Selecionar a guia Visão Geral mostra informações abrangentes sobre a execução, incluindo propriedades de execução, conjunto de dados de entrada, conjunto de dados de saída, marcas e descrição.

Logs

Selecionar a guia Logs permite exibir os logs de execução, o que pode ser útil para depuração detalhada de erros de execução. Você pode baixar os arquivos de log no computador local.

Instantâneo

Selecionar a guia Instantâneo mostra o instantâneo de execução. Você pode exibir o DAG do seu fluxo. Além disso, você tem a opção de Cloná-lo para criar um novo fluxo. Você também pode Implantá-lo como um ponto de extremidade online.

Verificar o histórico de execuções em lote e comparar as métricas

Em alguns cenários, você modificará seu fluxo para aprimorar o desempenho dele. Você pode enviar várias execuções de lotes para comparar o desempenho do fluxo com versões diferentes. Você também pode comparar as métricas calculadas por diferentes métodos de avaliação para ver qual delas é mais adequada para seu fluxo.

Para verificar o histórico de execuções em lote do fluxo, você pode selecionar o botão "Exibir execução em lote" no canto superior direito da página do fluxo. Você verá uma lista das execuções em lote enviadas a esse fluxo.

Você pode selecionar em cada execução em lote para verificar os detalhes. Você também pode selecionar várias execuções em lotes e selecionar "Visualizar saídas" para comparar as métricas e as saídas das execuções deste lote.

No painel "Visualizar saída", a tabela Execuções e métricas mostra as informações das execuções selecionadas com realce. Outras execuções que recebem as saídas das execuções selecionadas como entrada também são listadas.

Na tabela "Saídas", você pode comparar as execuções em lote selecionadas por cada linha de amostra. Ao selecionar o ícone "visualização ocular" na tabela "Execuções e métricas", as saídas dessa execução serão acrescentadas à execução base correspondente.

Entender as métricas de avaliação internas

No fluxo de prompts, fornecemos vários métodos de avaliação internos para ajudar você a medir o desempenho da saída do fluxo. Cada método de avaliação calcula métricas diferentes. Agora, fornecemos nove métodos de avaliação internos disponíveis. Você pode verificar a tabela a seguir para obter uma referência rápida:

| Método de avaliação | Métricas | Descrição | Conexão necessária | Entrada necessária | Valor da pontuação |

|---|---|---|---|---|---|

| Avaliação de precisão da classificação | Precisão | Mede o desempenho de um sistema de classificação comparando suas saídas com a verdade básica. | No | previsão, verdade básica | no intervalo [0, 1]. |

| Avaliação pareada de pontuação de relevância de perguntas e respostas | Pontuação, vitória/perda | Avalia a qualidade das respostas geradas por um sistema de respostas a perguntas. Envolve atribuir pontuações de relevância a cada resposta com base em quão bem ela corresponde à pergunta do usuário, comparando diferentes respostas a uma resposta de linha de base e agregando os resultados para produzir métricas como taxas médias de vitórias e pontuações de relevância. | Sim | pergunta, resposta (nenhuma verdade básica ou contexto) | Pontuação: 0-100, vitória/perda: 1/0 |

| Avaliação de fundamentação de perguntas e respostas | Fundamentação | Mede o grau de fundamentação das respostas previstas do modelo na fonte de entrada. Mesmo que as respostas do LLM sejam verdadeiras, se não forem verificáveis em relação à fonte, elas serão infundadas. | Yes | pergunta, resposta, contexto (nenhuma verdade básica) | 1 a 5, com 1 sendo o pior e 5 sendo o melhor. |

| Avaliação de Similaridade do QnA GPT | Similaridade com o GPT | Mede a similaridade entre as respostas verdadeiras básicas fornecidas pelo usuário e a resposta prevista pelo modelo utilizando o modelo GPT. | Sim | pergunta, resposta, verdade básica (contexto não necessário) | 1 a 5, com 1 sendo o pior e 5 sendo o melhor. |

| Avaliação de relevância de perguntas e respostas | Relevância | Mede a relevância das respostas previstas do modelo para as perguntas feitas. | Yes | pergunta, resposta, contexto (nenhuma verdade básica) | 1 a 5, com 1 sendo o pior e 5 sendo o melhor. |

| Avaliação de coerência de perguntas e respostas | Coerência | Mede a qualidade de todas as frases na resposta prevista de um modelo e como elas se adequam naturalmente. | Sim | pergunta, resposta (nenhuma verdade básica ou contexto) | 1 a 5, com 1 sendo o pior e 5 sendo o melhor. |

| Avaliação de fluência de perguntas e respostas | Fluência | Mede o quão correta gramaticalmente e linguisticamente é a resposta prevista do modelo. | Yes | pergunta, resposta (nenhuma verdade básica ou contexto) | 1 a 5, com 1 sendo o pior e 5 sendo o melhor |

| Avaliação de pontuações f1 de perguntas e respostas | Medida f | Mede a proporção do número de palavras compartilhadas entre a previsão do modelo e a verdade básica. | No | pergunta, resposta, verdade básica (contexto não necessário) | no intervalo [0, 1]. |

| Avaliação de similaridade do Ada de perguntas e respostas | Similaridade do Ada | Calcula incorporações de nível de frase (documento) usando a API de incorporações do Ada para previsão e verdade básica. Em seguida, calcula a similaridade de cosseno entre eles (um número de ponto flutuante) | Yes | pergunta, resposta, verdade básica (contexto não necessário) | no intervalo [0, 1]. |

Maneiras de melhorar o desempenho do fluxo

Depois de verificar as métricas internas da avaliação, tente melhorar o desempenho do fluxo seguindo estas etapas:

- Verifique os dados de saída para depurar qualquer falha potencial do fluxo.

- Modifique seu fluxo para melhorar o desempenho. Isso inclui, entre outros:

- Modificar o prompt

- Modificar a mensagem do sistema

- Modificar os parâmetros do fluxo

- Modificar a lógica do fluxo

A criação de prompt pode ser complexa. Fornecemos uma Introdução à engenharia de prompt para ajudá-lo a aprender sobre o conceito de criar um prompt que possa atingir sua meta. Confira as técnicas de engenharia de prompt para saber mais sobre como criar um prompt que possa atingir sua meta.

Mensagem do sistema, às vezes chamada de metaprompt ou prompt do sistema, que pode ser usada para orientar o comportamento de um sistema de IA e melhorar o desempenho do sistema. Leia este documento sobre a Estrutura de mensagens do sistema e as recomendações de modelo para LLMs (Modelos de Linguagem Grande) para saber mais sobre como melhorar o desempenho do fluxo com a mensagem do sistema.

Leitura adicional: diretrizes para criar Conjuntos de Dados Golden usados para garantia de qualidade do Copilot

A criação de um copiloto que usa modelos de linguagem grande (LLM) normalmente envolve aterrar o modelo na realidade usando conjuntos de dados de origem. No entanto, para garantir que os LLMs forneçam as respostas mais precisas e úteis às consultas do cliente, um "Conjunto de Dados Golden" é necessário.

Um Conjunto de Dados Golden é uma coleção de perguntas realistas do cliente e respostas habilmente elaboradas. Ele serve como uma ferramenta de Garantia de qualidade para LLMs usados pelo copilot. Os conjuntos de dados Golden não são usados para treinar um LLM ou injetar contexto em um prompt de LLM. Em vez disso, eles são utilizados para avaliar a qualidade das respostas geradas pelo LLM.

Se o seu cenário envolver um copilot ou se você estiver no processo de criar seu próprio copilot, recomendamos consultar este documento específico: Produzindo Conjuntos de Dados Golden: diretrizes para criar Conjuntos de Dados Golden usados para a garantia de qualidade do Copilot para obter diretrizes e melhores práticas mais detalhadas.

Próximas etapas

Neste documento, você aprendeu como enviar uma execução em lote e utilizar um método de avaliação interno para medir a qualidade da saída do fluxo. Você também aprendeu a exibir o resultado e as métricas de avaliação e como iniciar uma nova rodada de avaliação com um método ou subconjunto diferente de variantes. Esperamos que este documento ajude você a melhorar o desempenho do fluxo e atingir suas metas com o fluxo de prompt.