Ferramenta Open Model LLM

A ferramenta Open Model LLM permite a utilização de vários modelos abertos e básicos, como Falcon e Llama 2, para processamento de linguagem natural no fluxo de prompt do Aprendizado de Máquina do Azure.

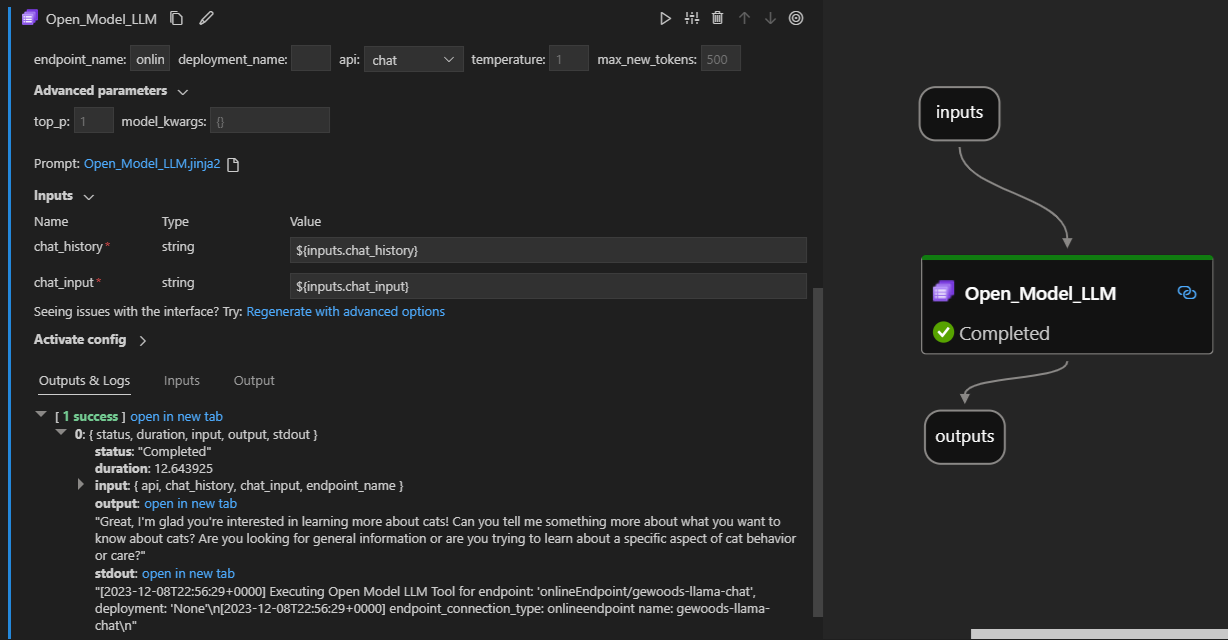

Veja abaixo ela em ação na extensão do prompt flow do Visual Studio Code. Neste exemplo, a ferramenta está sendo usada para chamar um ponto de extremidade do LlaMa-2 chat e perguntar "O que é CI?".

Essa ferramenta de fluxo de prompt oferece suporte a dois tipos diferentes de API LLM:

- Bate-papo: mostrado no exemplo anterior. O tipo de API de chat facilita conversas interativas com entradas e respostas baseadas em texto.

- Conclusão: o tipo de API de Conclusão é usado para gerar conclusões de texto de resposta única com base na entrada de prompt fornecida.

Visão geral rápida: Como usar a ferramenta Open Model LLM?

- Escolha um modelo no Catálogo de Modelos do Azure Machine Learning e implante-o.

- Conecte-se à implantação do modelo.

- Defina as configurações da ferramenta llm do modelo aberto.

- Prepare o prompt.

- Execute o fluxo.

Pré-requisitos: Implantação de modelo

- Escolha o modelo que correspondeu ao seu cenário no catálogo de modelos do Azure Machine Learning.

- Use o botão Implantar para implantar o modelo em um ponto de extremidade de inferência online do Aprendizado de Máquina do Azure.

- Use uma das opções de implantação Pay as you go.

Para saber mais, consulte Implantar modelos básicos em pontos de extremidade para inferência.

Pré-requisitos: Conectar-se ao modelo

Para que o fluxo de prompt use seu modelo implantado, você precisa se conectar a ele. Há duas maneiras de se conectar.

Conexões de ponto de extremidade

Depois que seu fluxo é associado a um espaço de trabalho do Azure Machine Learning ou do Azure AI Studio, a ferramenta Open Model LLM pode usar os pontos de extremidade nesse espaço de trabalho.

Usando o Azure Machine Learning ou os espaços de trabalho do Azure AI Studio: se você estiver usando o fluxo de prompt em um dos espaços de trabalho de navegadores baseados em página da Web, os pontos de extremidade online disponíveis nesse espaço de trabalho serão ativados automaticamente.

Usando o VS Code ou o código primeiro: se você estiver usando o fluxo de prompt no VS Code ou em uma das ofertas Code First, precisará se conectar ao espaço de trabalho. A ferramenta Open Model LLM usa o cliente azure.identity DefaultAzureCredential para autorização. Uma maneira é definir valores de credenciais de ambiente.

Conexões personalizadas

A ferramenta Open Model LLM usa o CustomConnection. O fluxo de prompt oferece suporte a dois tipos de conexões:

Conexões de espaço de trabalho - Conexões armazenadas como segredos em um espaço de trabalho do Aprendizado de Máquina do Azure. Embora essas conexões possam ser usadas, em muitos lugares, elas são comumente criadas e mantidas na interface do usuário do Studio. Para saber como criar uma conexão personalizada na interface do usuário do Studio, consulte como criar uma conexão personalizada.

Conexões locais - Conexões armazenadas localmente em sua máquina. Essas conexões não estão disponíveis no Studio UX, mas podem ser usadas com a extensão VS Code. Para saber como criar uma conexão personalizada local, consulte como criar uma conexão local.

As chaves necessárias para definir são:

- endpoint_url

- Esse valor pode ser encontrado no ponto de extremidade de inferência criado anteriormente.

- endpoint_api_key

- Certifique-se de defini-lo como um valor secreto.

- Esse valor pode ser encontrado no ponto de extremidade de inferência criado anteriormente.

- model_family

- Valores com suporte: LLAMA, DOLLY, GPT2 ou FALCON

- Esse valor depende do tipo de implantação que você está direcionando.

Executando a ferramenta: Entradas

A ferramenta Open Model LLM tem muitos parâmetros, alguns dos quais são necessários. Consulte a tabela a seguir para obter detalhes, você pode combinar esses parâmetros com a captura de tela anterior para clareza visual.

| Nome | Tipo | Descrição | Obrigatório |

|---|---|---|---|

| api | string | O modo de API que depende do modelo usado e do cenário selecionado. Valores com suporte: (Conclusão | Chat) | Sim |

| endpoint_name | string | Nome de um ponto de extremidade de inferência on-line com um modelo com suporte implantado nele. Tem prioridade sobre a conexão. | Sim |

| temperatura | FLOAT | A aleatoriedade do texto gerado. O padrão é UTF-1. | Não |

| max_new_tokens | Número inteiro | O número máximo de tokens a serem gerados na conclusão. O padrão é 500. | Não |

| top_p | FLOAT | A probabilidade de usar a escolha principal dos tokens gerados. O padrão é UTF-1. | Não |

| model_kwargs | dicionário | Essa entrada é usada para fornecer uma configuração específica ao modelo usado. Por exemplo, o modelo Llama-02 pode usar {"temperature":0.4}. Padrão: {} | Não |

| deployment_name | string | O nome da implantação a ser direcionada no ponto de extremidade de Inferência Online. Se nenhum valor for passado, as configurações de tráfego do balanceador de carga de inferência serão usadas. | Não |

| prompt | string | O prompt de texto que o modelo de linguagem usa para gerar sua resposta. | Sim |

Saídas

| API | Tipo de retorno | Descrição |

|---|---|---|

| Completion | string | O texto de uma conclusão prevista |

| Chat | string | O texto de uma resposta na conversa |

Implantando em um ponto de extremidade online

Quando você implanta um fluxo contendo a ferramenta Open Model LLM em um ponto de extremidade online, há uma etapa extra para configurar permissões. Durante a implantação por meio das páginas da Web, há uma escolha entre os tipos de Identidade atribuídos pelo Sistema e Atribuídos pelo Usuário. De qualquer forma, usando o portal do Azure (ou uma funcionalidade semelhante), adicione a função de função Trabalho "Leitor" à identidade no espaço de trabalho do Aprendizado de Máquina do Azure ou no projeto do Ai Studio, que está hospedando o ponto de extremidade. A implantação do fluxo de prompt pode precisar ser atualizada.

Comentários

Em breve: Ao longo de 2024, eliminaremos os problemas do GitHub como o mecanismo de comentários para conteúdo e o substituiremos por um novo sistema de comentários. Para obter mais informações, consulte https://aka.ms/ContentUserFeedback.

Enviar e exibir comentários de