Observação

O acesso a essa página exige autorização. Você pode tentar entrar ou alterar diretórios.

O acesso a essa página exige autorização. Você pode tentar alterar os diretórios.

O Microsoft Fabric é uma solução de análise multifuncional para empresas que abrange desde movimentação de dados até ciência de dados, análises em tempo real e business intelligence. Ele oferece um conjunto abrangente de serviços, incluindo data lake, engenharia de dados e integração de dados, tudo em um só lugar. Para obter mais informações, consulte O que é o Microsoft Fabric?

Esse tutorial guia você através de um cenário de ponta a ponta, desde a aquisição de dados até o consumo de dados. Ele ajuda você a ter uma compreensão básica do Fabric, incluindo as diferentes experiências e como elas se integram, bem como as experiências de desenvolvedor cidadão e profissional que vêm com o trabalho nesta plataforma. Esse tutorial não se destina a ser uma arquitetura de referência, uma lista exaustiva de recursos e funcionalidades ou uma recomendação de melhores práticas específicas.

Cenário de ponta a ponta do lakehouse

Tradicionalmente, as organizações vêm criando data warehouses modernos para suas necessidades de análise de dados transacionais e estruturados. E data lakehouses para necessidades de análise de dados de Big Data (semi/não estruturado). Esses dois sistemas foram executados em paralelo, criando silos, duplicação de dados e maior custo total de propriedade.

O Fabric com sua unificação de armazenamento de dados e padronização no formato Delta Lake permite eliminar silos, remover a duplicação de dados e reduzir drasticamente o custo total de propriedade.

Com a flexibilidade oferecida pelo Fabric, você pode implementar arquiteturas do lakehouse ou do data warehouse ou combiná-las para obter o melhor de ambas com uma implementação simples. Nesse tutorial, você usará um exemplo de uma organização de varejo e criará seu lakehouse do início ao fim. Ele usa a arquitetura medallion em que a camada bronze tem os dados brutos, a camada prata tem os dados validados e com exclusão de duplicação e a camada de ouro tem dados altamente refinados. Você pode adotar a mesma abordagem para implementar um lakehouse para qualquer organização de qualquer setor.

Este tutorial explica como um desenvolvedor da empresa fictícia Wide World Importers no campo de varejo conclui as seguintes etapas:

Entre em sua conta do Power BI e inscreva-se para a avaliação gratuita do Microsoft Fabric. Se você não tiver uma licença do Power BI, inscreva-se para uma licença gratuita do Fabric e, em seguida, poderá iniciar a avaliação do Fabric.

Crie e implemente um lakehouse de ponta a ponta para sua organização:

- Criar um workspace do Fabric.

- Criar um lakehouse.

- Ingerir dados, transformar dados e carregá-los no lakehouse. Você também pode explorar o OneLake, uma cópia de seus dados no modo lakehouse e no modo de ponto de extremidade de análise do SQL.

- Conecte-se ao lakehouse usando o ponto de extremidade de análise do SQL e Crie um relatório do Power BI usando o DirectLake para analisar dados de vendas em diferentes dimensões.

- Opcionalmente, você pode orquestrar e agendar a ingestão de dados e o fluxo de transformação com um pipeline.

Limpe os recursos excluindo o workspace e outros itens.

Arquitetura

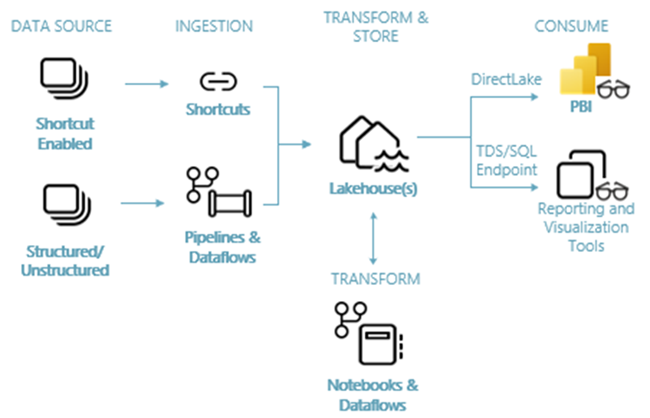

A imagem a seguir mostra a arquitetura de ponta a ponta do lakehouse. Os componentes envolvidos são descritos na lista a seguir.

Fontes de dados: o Fabric torna a conexão rápida e fácil aos Serviços de Dados do Azure, bem como a outras plataformas baseadas em nuvem e fontes de dados locais, para ingestão de dados simplicada.

Ingestão: você pode criar insights rapidamente para sua organização usando mais de 200 conectores nativos. Esses conectores são integrados ao pipeline do Fabric e utilizam a transformação de dados de arrastar e soltar simples com o fluxo de dados. Além disso, com o recurso de Atalho no Fabric, você pode se conectar aos dados existentes, sem precisar copiá-los ou movê-los.

Transformar e armazenar: o Fabric é padronizado no formato Delta Lake. Isso significa que todos os mecanismos do Fabric podem acessar e manipular o mesmo conjunto de dados armazenado no OneLake sem duplicar os dados. Esse sistema de armazenamento oferece a flexibilidade para criar lakehouses usando uma arquitetura medallion ou uma malha de dados, dependendo das suas necessidades organizacionais. Você pode escolher entre uma experiência de pouco código ou sem código para transformação de dados, utilizando pipelines/fluxos de dados ou notebook/Spark para uma experiência code-first.

Consumir: o Power BI pode consumir dados do Lakehouse para gerar relatórios e visualização. Cada Lakehouse tem um ponto de extremidade de TDS interno denominado ponto de extremidade de análise do SQL, para facilitar a conectividade e a consulta de dados nas tabelas do Lakehouse de outras ferramentas de relatório. O ponto de extremidade de análise do SQL fornece aos usuários a funcionalidade de conexão do SQL.

Amostra do conjunto de dados

Este tutorial usa o banco de dados de amostra WWI (Wide World Importers) que você importará no lakehouse no próximo tutorial. Para o cenário de ponta a ponta do Lakehouse, geramos dados suficientes para explorar os recursos de escala e desempenho da plataforma Fabric.

A WWI (Wide World Importers) é uma importadora e distribuidora atacadista de produtos inovadores que opera na área da baía de São Francisco. Como atacadista, a WWI tem clientes que são, em sua maioria, empresas que revendem os produtos para pessoas físicas. A WWI comercializa produtos para clientes de varejo em todos os Estados Unidos, incluindo lojas especializadas, supermercados, lojas de computação, lojas de atrações turísticas e algumas pessoas físicas. Também vendem mercadorias para outros fornecedores por meio de uma rede de agentes que promovem os produtos em nome da empresa. Para saber mais sobre o perfil e a operação da empresa, confira Bancos de dados de exemplo da Wide World Importers para Microsoft SQL.

Em geral, os dados são trazidos de sistemas transacionais ou aplicativos de linha de negócios para um lakehouse. No entanto, para facilitar esse tutorial, usamos o modelo dimensional fornecido pela WWI como nossa fonte de dados inicial. Usamos ele como fonte para ingerir os dados em um lakehouse e transformá-lo em diferentes estágios (Bronze, Prata e Ouro) de uma arquitetura medallion.

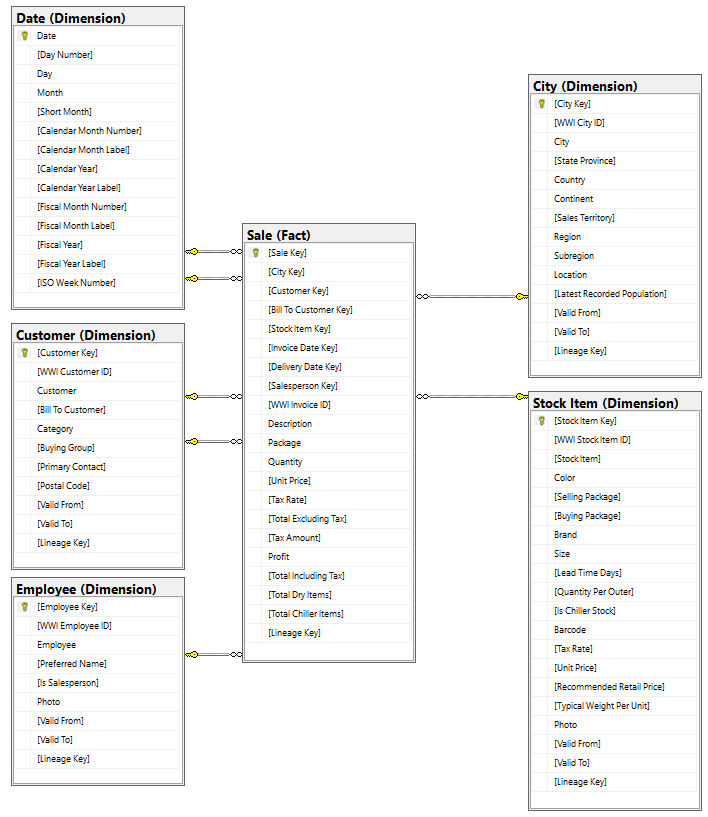

Modelo de dados

Embora o modelo dimensional da WWI contenha várias tabelas de fatos, neste tutorial, usamos a tabela de fatos Vendas e suas dimensões correlacionadas. O exemplo a seguir ilustra o modelo da WWI:

Fluxo de dados e de transformação

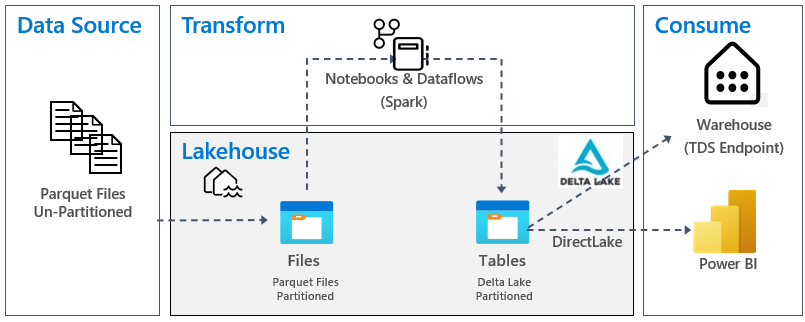

Conforme descrito anteriormente, estamos usando os dados de exemplo dos dados de exemplo da WWI (Wide World Importers) para criar esse lakehouse de ponta a ponta. Nessa implementação, os dados de exemplo são armazenados em uma conta de armazenamento de dados do Azure no formato de arquivo Parquet para todas as tabelas. No entanto, em cenários reais, os dados normalmente se originariam de várias fontes e em formatos diversos.

A imagem a seguir mostra a fonte, destino e transformação dados:

Fonte de dados: os dados de origem estão no formato de arquivo Parquet e em uma estrutura não particionada. Está armazenado em uma pasta para casa tabela. Neste tutorial, configuramos um pipeline para ingerir os dados históricos completos ou únicos no lakehouse.

Neste tutorial, usamos a tabela de fatos Venda, que tem uma pasta pai com dados históricos para 11 meses (com uma subpasta para cada mês) e outra pasta que contém dados incrementais para 3 meses (uma subpasta para cada mês). Durante a ingestão de dados inicial, 11 meses de dados são ingeridos na tabela do lakehouse. No entanto, quando os dados incrementais chegam, eles incluem dados atualizados de outubro e novembro, e novos dados de dezembro. Os dados de outubro e novembro são mesclados com os dados existentes e os novos dados de dezembro são gravados na tabela do lakehouse, conforme mostrado na imagem a seguir:

Lakehouse: neste tutorial, você cria um lakehouse, ingere dados na seção de arquivos do lakehouse e, em seguida, cria tabelas do Delta Lake na seção Tabelas do lakehouse.

Transformação: para preparação e transformação de dados, você vê duas abordagens diferentes. Demonstramos o uso de Notebooks/Spark para usuários que preferem uma experiência code-first e usam pipelines/fluxo de dados para usuários que preferem uma experiência com pouco código ou sem código.

Consumir: para demonstrar o consumo de dados, você verá como usar o recurso DirectLake do Power BI para criar relatórios, painéis e consultar dados diretamente no lakehouse. Além disso, mostramos como você poderá disponibilizar seus dados para ferramentas de geração de relatórios de terceiros usando o ponto de extremidade de análise do TDS/SQL. Esse ponto de extremidade permite que você se conecte ao warehouse e execute consultas SQL para análise.