Observação

O acesso a essa página exige autorização. Você pode tentar entrar ou alterar diretórios.

O acesso a essa página exige autorização. Você pode tentar alterar os diretórios.

Esses tutoriais apresentam um cenário completo de ponta a ponta na experiência de ciência de dados do Fabric. Eles cobrem cada etapa, desde

- Ingestão de dados

- Limpeza de dados

- Preparação de dados

para

- Treinamento de modelo de machine learning

- Geração de insights

e depois abrangem o consumo desses insights com ferramentas de visualização, como o Power BI.

As pessoas novas no Microsoft Fabric devem visitar o que é o Microsoft Fabric?.

Introdução

Um ciclo de vida de projeto de ciência de dados normalmente inclui estas etapas:

- Entender as regras de negócios

- Adquirir os dados

- Explorar, limpar, preparar e visualizar os dados

- Treinar o modelo e acompanhar o experimento

- Pontue o modelo e gere insights

As etapas geralmente prosseguem iterativamente. As metas e os critérios de êxito de cada estágio dependem da colaboração, do compartilhamento de dados e da documentação. A experiência de ciência de dados do Fabric envolve vários recursos nativos que permitem colaboração perfeita, aquisição de dados, compartilhamento e consumo.

Esses tutoriais colocam você na função de um cientista de dados que deve explorar, limpar e transformar um conjunto de dados que contém o status de rotatividade de 10.000 clientes bancários. Em seguida, você cria um modelo de aprendizado de máquina para prever quais clientes do banco provavelmente sairão.

Você executa as seguintes atividades nos tutoriais:

- Usar os blocos de anotações do Fabric para cenários de ciência de dados

- Usar o Apache Spark para ingerir dados em um lakehouse do Fabric

- Carregar dados existentes das tabelas delta do lakehouse

- Usar ferramentas baseadas em Apache Spark e Python para limpar e transformar dados

- Criar experimentos e execuções para treinar diferentes modelos de machine learning

- Usar o MLflow e a interface do usuário do Fabric para registrar e acompanhar modelos treinados

- Executar a pontuação em escala e salvar previsões e resultados de inferência no lakehouse

- Usar o DirectLake para visualizar previsões no Power BI

Arquitetura

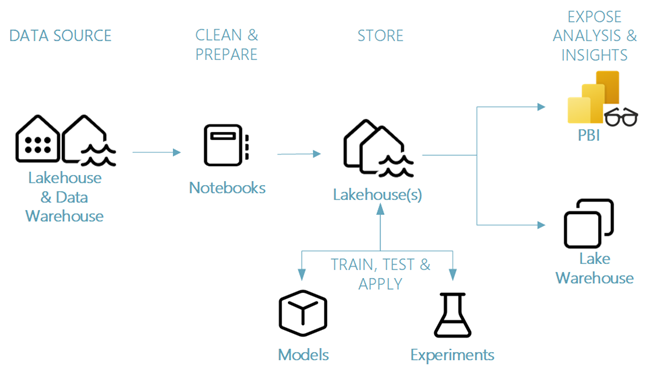

Esta série de tutoriais mostra um cenário simplificado de ciência de dados de ponta a ponta envolvendo:

- Ingestão de dados de uma fonte de dados externa.

- Exploração e limpeza de dados.

- Treinamento e registro de modelo de machine learning.

- Pontuação em lote e salvamento de previsões.

- Visualização de resultados de previsão no Power BI.

Componentes diferentes do cenário de ciência de dados

Fontes de dados – Para ingerir dados com o Fabric, você pode se conectar com facilidade e rapidez aos Serviços de Dados do Azure, outras plataformas de nuvem e recursos de dados locais. Com o Fabric Notebooks, você pode ingerir dados desses recursos:

- Lakehouses internos

- Data Warehouses

- Modelos semânticos

- Várias fontes de dados do Apache Spark

- Várias fontes de dados que dão suporte ao Python

Essa série de tutoriais se concentra na ingestão e carregamento de dados de um lakehouse.

Explorar, limpar e preparar – a experiência de ciência de dados do Fabric dá suporte à limpeza, transformação, exploração e apresentação de dados. Ele usa experiências internas do Spark e ferramentas baseadas em Python, por exemplo, Data Wrangler e SemPy Library. Este tutorial mostra a exploração de dados com a biblioteca python e a seaborn limpeza e preparação de dados com o Apache Spark.

Modelos e experimentos – Com o Fabric, você pode treinar, avaliar e pontuar modelos de machine learning com experimentos internos. Para registrar e implantar seus modelos e acompanhar experimentos, o MLflow oferece integração perfeita com o Fabric como uma maneira de modelar itens. Para criar e compartilhar insights de negócios, o Fabric oferece outros recursos para previsão de modelo em escala (PREDICT), para criar e compartilhar insights de negócios.

Armazenamento - o Fabric é padronizado no Delta Lake, o que significa que todos os mecanismos do Fabric podem interagir com o mesmo conjunto de dados armazenado em um lakehouse. Com essa camada de armazenamento, você pode armazenar dados estruturados e não estruturados que dão suporte ao armazenamento baseado em arquivo e ao formato tabular. Você pode acessar com facilidade os conjuntos de dados e arquivos armazenados por meio de todos os itens de experiência do Fabric, como notebooks e pipelines.

Expor análises e insights – o Power BI, uma ferramenta de business intelligence líder do setor, pode consumir dados do Lakehouse para geração de relatórios e visualização. Nas bibliotecas de visualização nativas de Python ou Spark em recursos de notebook

matplotlibseabornplotly- etcétera.

é possível visualizar dados persistidos em um lakehouse. A biblioteca SemPy também dá suporte à visualização de dados. Essa biblioteca oferece suporte a visualizações incorporadas, avançadas e específicas para tarefas

- O modelo de dados semânticos

- Dependências e suas violações

- Casos de uso de classificação e regressão