Integrar o OneLake ao Azure HDInsight

O Azure HDInsight é um serviço gerenciado baseado em nuvem para análise de Big Data que ajuda as organizações a processar dados de grandes quantidades. Este tutorial mostra como se conectar ao OneLake com um notebook do Jupyter de um cluster do Azure HDInsight.

Usando o Azure HDInsight

Para se conectar ao OneLake com um notebook do Jupyter de um cluster HDInsight:

Criar um cluster do Apache Spark no HDInsight (HDI). Siga estas instruções: Configurar clusters no HDInsight.

Ao fornecer informações do cluster, lembre-se de seu nome de usuário e senha de logon do cluster, pois você precisa deles para acessar o cluster mais tarde.

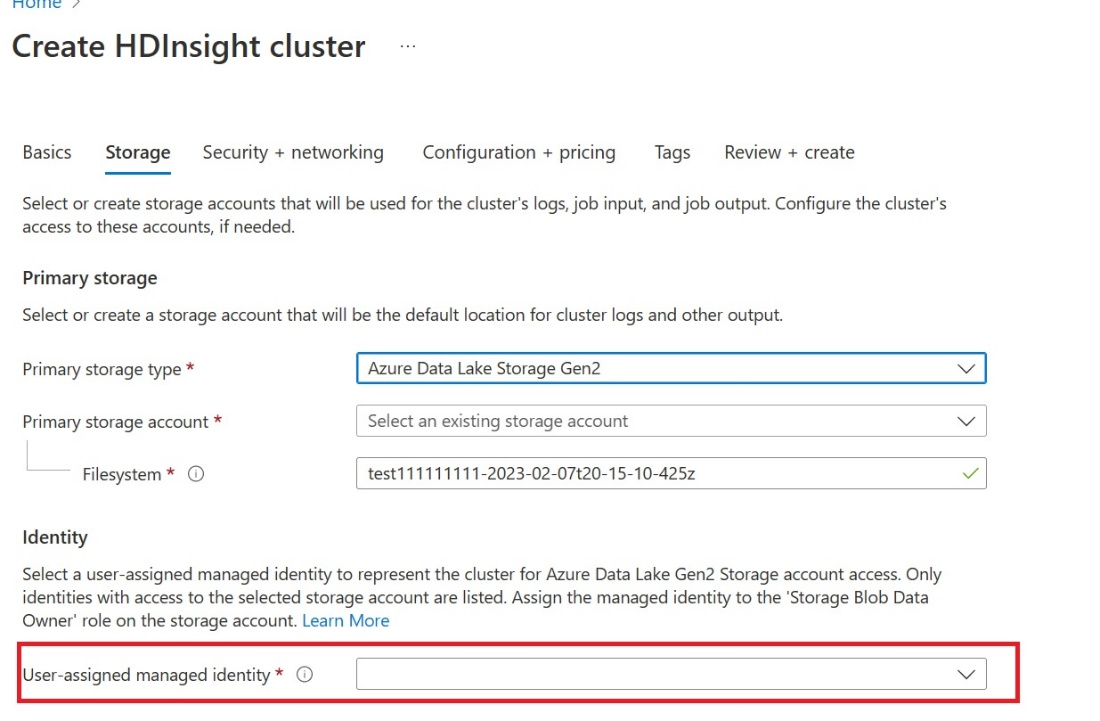

Criar uma UAMI (identidade gerenciada atribuída pelo usuário): Crie para o Azure HDInsight – UAMI e escolha-a como a identidade na tela Armazenamento.

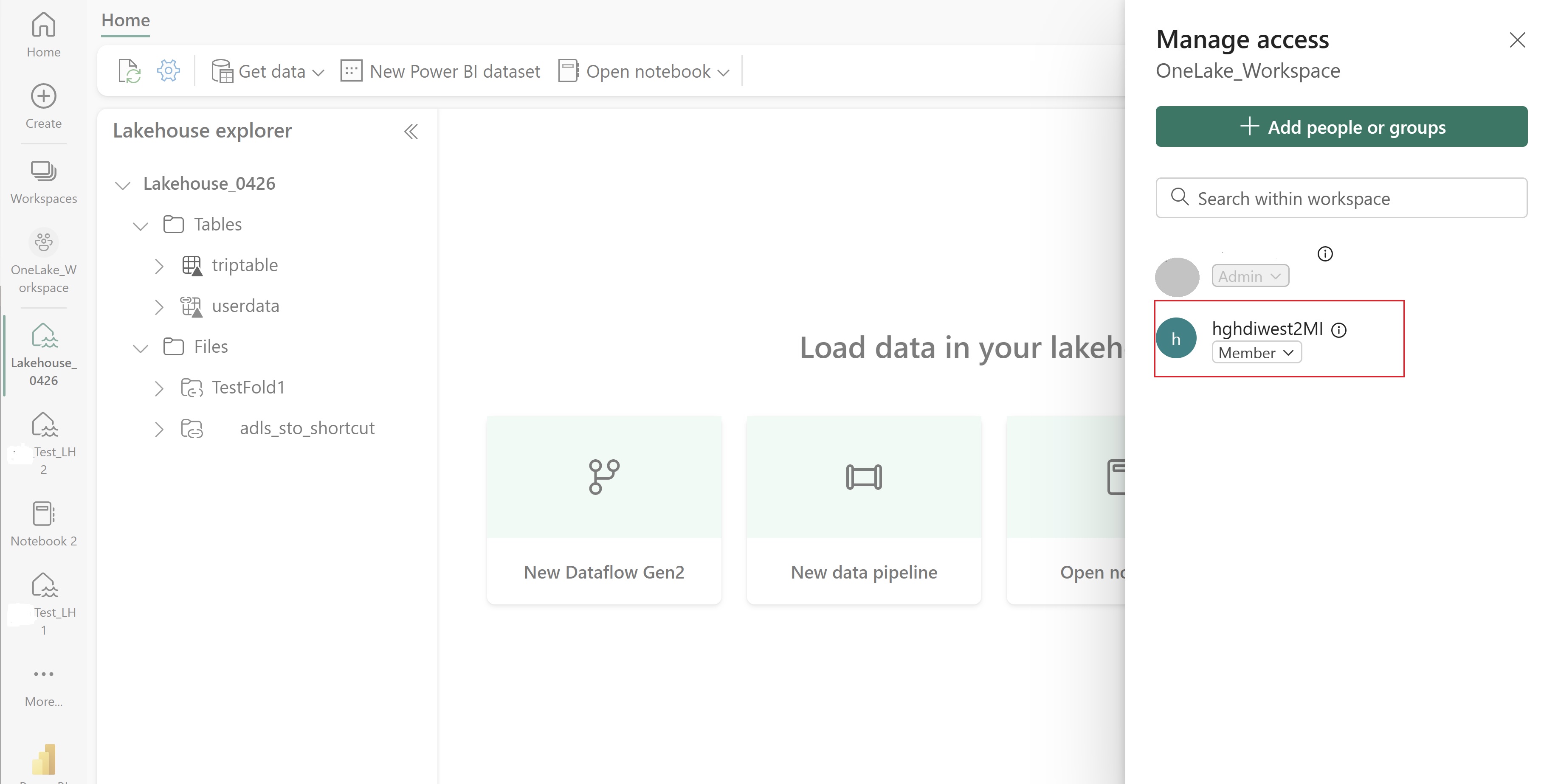

Dê a essa interface do usuário acesso ao workspace do Fabric que contém seus itens. Para obter ajuda para decidir qual função é melhor, confira as funções do Workspace.

Navegue até o lakehouse e localize o nome do seu workspace e lakehouse. Você pode encontrá-los na URL do seu lakehouse ou no painel Propriedades de um arquivo.

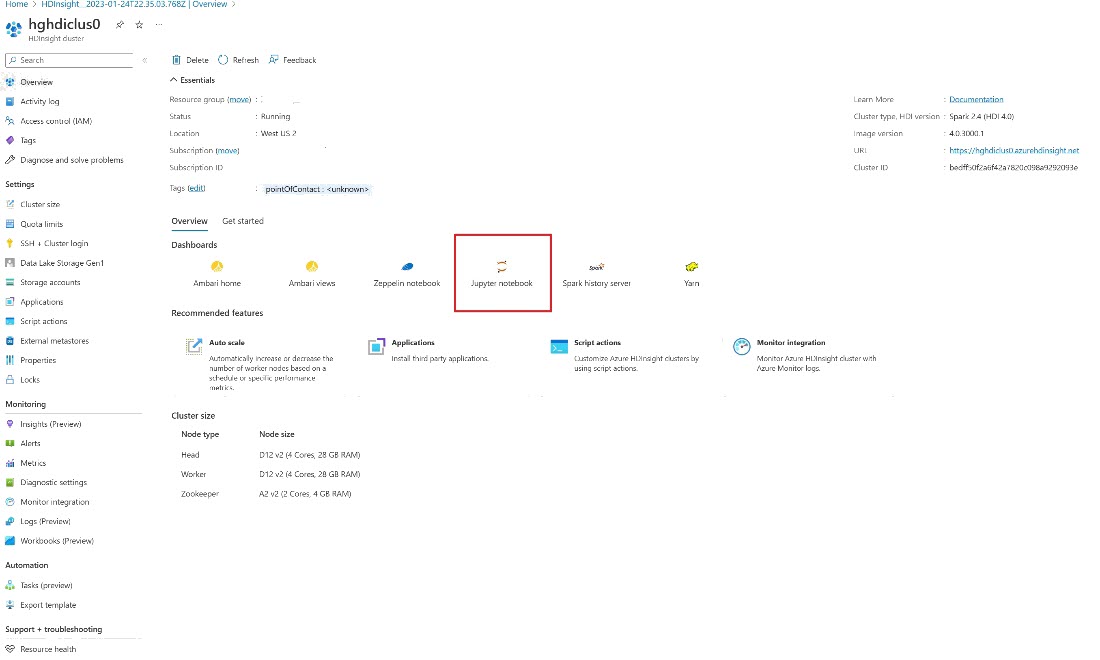

No portal do Azure, procure o cluster e selecione o notebook.

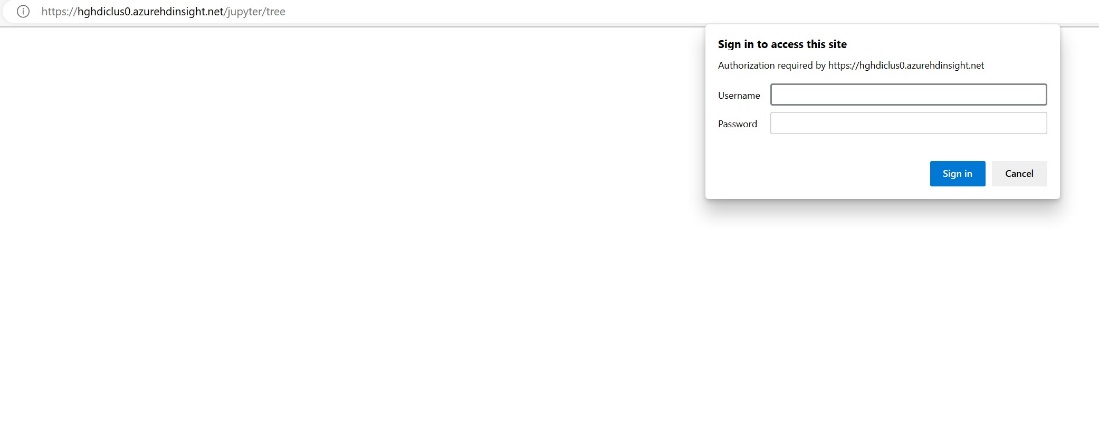

Insira as informações de credencial fornecidas durante a criação do cluster.

Crie um novo notebook do Apache Spark.

Copie os nomes de workspace e lakehouse em seu notebook e crie a URL do OneLake para o seu lakehouse. Agora você pode ler qualquer arquivo desse caminho de arquivo.

fp = 'abfss://' + 'Workspace Name' + '@onelake.dfs.fabric.microsoft.com/' + 'Lakehouse Name' + '/Files/' df = spark.read.format("csv").option("header", "true").load(fp + "test1.csv") df.show()Tente escrever alguns dados no lakehouse.

writecsvdf = df.write.format("csv").save(fp + "out.csv")Teste se seus dados foram gravados com êxito verificando seu lakehouse ou lendo seu arquivo recém-carregado.

Agora você pode ler e gravar dados no OneLake usando seu notebook do Jupyter em um cluster HDI Spark.

Conteúdo relacionado

Comentários

Em breve: Ao longo de 2024, eliminaremos os problemas do GitHub como o mecanismo de comentários para conteúdo e o substituiremos por um novo sistema de comentários. Para obter mais informações, consulte https://aka.ms/ContentUserFeedback.

Enviar e exibir comentários de