Usar o Azure Data Lake Storage Gen1 para exigências de big data

Observação

O Azure Data Lake Storage Gen1 foi desativado. Veja o edital de aposentadoria aqui. Os recursos do Data Lake Storage Gen1 não estão mais acessíveis.

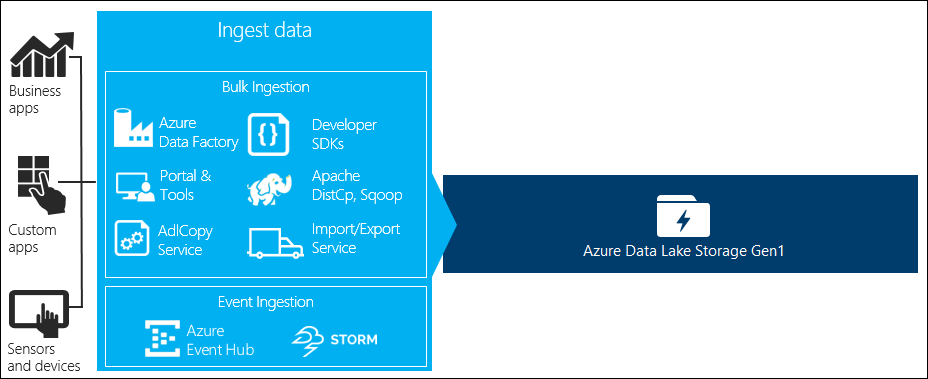

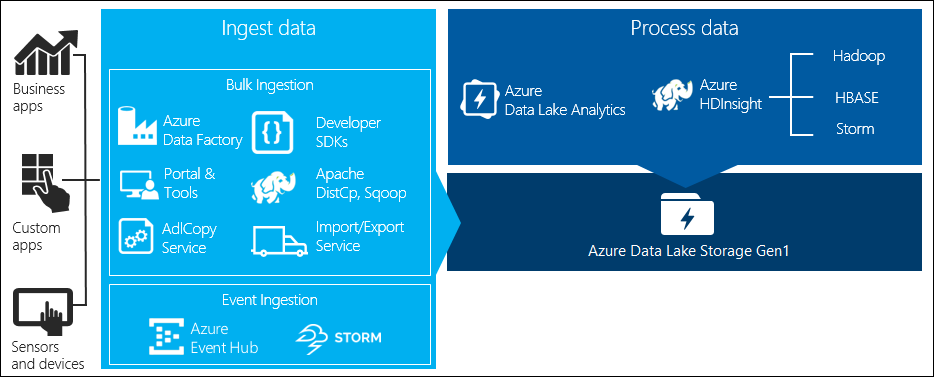

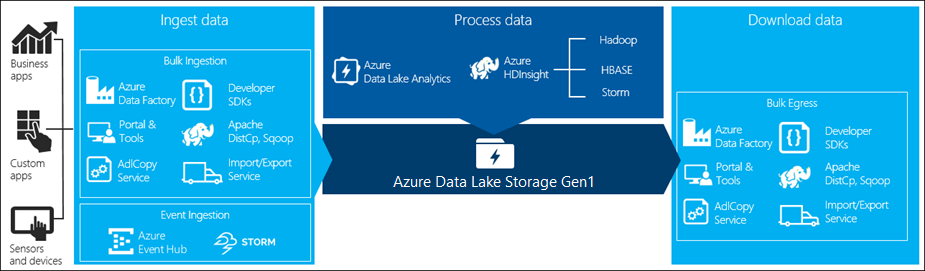

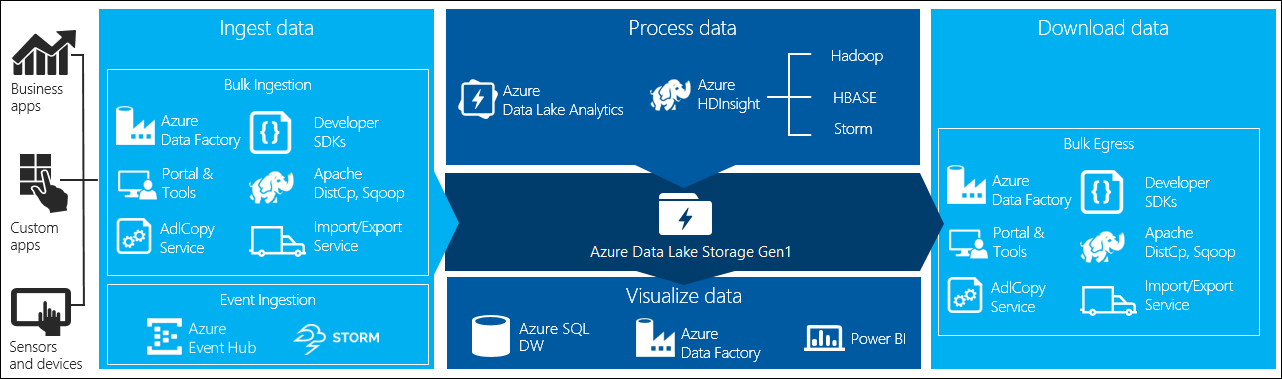

Há quatro estágios principais no processamento de big data:

- Ingestão de grandes quantidades de dados em um repositório de dados, em tempo real ou em lotes

- Processando os dados

- Download dos dados

- Visualização dos dados

Neste artigo, analisamos esses estágios com relação ao Azure Data Lake Storage Gen1 para entender as opções e as ferramentas disponíveis para atender às suas necessidades de Big Data.

Ingerir dados no Data Lake Storage Gen1

Esta seção destaca as diferentes fontes de dados e as diferentes maneiras que os dados podem ser ingeridos em uma conta do Data Lake Storage Gen1.

Dados ad hoc

Representam conjuntos de dados menores que são usados para criar protótipos de um aplicativo de big data. Há diferentes maneiras de ingerir dados ad hoc, dependendo da fonte dos dados.

| Fonte de dados | Ingeri-la usando |

|---|---|

| Computador local | |

| O Azure Storage Blob |

Dados transmitidos

Isso representa dados que podem ser gerados por várias fontes, como aplicativos, dispositivos, sensores etc. Esses dados podem ser ingeridos no Data Lake Storage Gen1 por uma variedade de ferramentas. Essas ferramentas geralmente capturam e processam os dados em um evento em tempo real e gravam os eventos em lotes no Data Lake Storage Gen1 para que depois eles possam ser processados.

Veja as ferramentas que você pode usar:

- Azure Stream Analytics – os eventos ingeridos nos Hubs de Eventos podem ser gravados no Azure Data Lake Storage Gen1 usando uma saída do Azure Data Lake Storage Gen1.

- EventProcessorHost – é possível receber eventos dos Hubs de Eventos e gravá-los no Data Lake Storage Gen1 usando o SDK para .NET do Data Lake Storage Gen1.

Dados relacionais

Você também pode originar dados nos bancos de dados relacionais. Durante um período, os bancos de dados relacionais coletam grandes volumes de dados que podem fornecer informações importantes se processados por meio de um pipeline de big data. É possível usar as ferramentas a seguir para mover tais dados para o Data Lake Storage Gen1.

Dados de log do servidor Web (carregar usando aplicativos personalizados)

Esse tipo de conjunto de dados é especificamente chamado porque a análise dos dados do log do servidor Web é um caso de uso comum para aplicativos de Big Data e requer que grandes volumes de arquivos de log sejam carregados no Data Lake Storage Gen1. Você pode usar qualquer uma das ferramentas a seguir para escrever seus próprios scripts ou aplicativos para carregar esses dados.

- CLI do Azure

- PowerShell do Azure

- SDK do .NET do Azure Data Lake Storage Gen1

- Fábrica de dados do Azure

Para carregar dados de log do servidor Web, e também para carregar outros tipos de dados (por exemplo, dados de sentimentos sociais), é uma boa abordagem escrever seus próprios scripts/aplicativos personalizados, pois eles proporcionam a flexibilidade para incluir seus dados carregando o componente como parte do aplicativo maior de big data. Em alguns casos, esse código pode assumir a forma de um script ou um utilitário simples de linha de comando. Em outros casos, o código pode ser usado para integrar o processamento de big data em um aplicativo ou uma solução de negócios.

Dados associados aos clusters Azure HDInsight

A maioria dos tipos de cluster HDInsight (Hadoop, HBase, Storm) é compatível com o Data Lake Storage Gen1 como um repositório de armazenamento de dados. Os clusters HDInsight acessam dados dos WASB (Blobs de Armazenamento do Azure). Para obter melhor desempenho, você pode copiar os dados do WASB em uma conta do Data Lake Storage Gen1 associada ao cluster. Você pode usar as ferramentas a seguir para copiar os dados.

Dados armazenados localmente ou em clusters Hadoop da IaaS

É possível armazenar grandes quantidades de dados em clusters de Hadoop existentes, localmente em computadores que usam o HDFS. Os clusters Hadoop podem estar em uma implantação local ou em um cluster da IaaS no Azure. Pode haver requisitos para copiar esses dados no Azure Data Lake Storage Gen1 para uma abordagem única ou de forma recorrente. Há várias opções que podem ser usadas para conseguir isso. Veja abaixo uma lista de alternativas e as compensações associadas.

| Abordagem | Detalhes | Vantagens | Considerações |

|---|---|---|---|

| Usar o ADF (Azure Data Factory) para copiar dados diretamente de clusters Hadoop para o Azure Data Lake Storage Gen1 | O ADF oferece suporte ao HDFS como uma fonte de dados | O ADF fornece suporte nativo para HDFS e gerenciamento e monitoramento de primeira classe completo | Ele exige que um gateway de gerenciamento de dados seja implantado localmente ou em um cluster da IaaS |

| Exporte os dados do Hadoop como arquivos. Em seguida, copie os arquivos no Azure Data Lake Storage Gen1 usando o mecanismo apropriado. | Você pode copiar arquivos para o Azure Data Lake Storage Gen1 usando:

|

Início rápido. Pode realizar carregamentos personalizados | Processo de várias etapas que envolve várias tecnologias. O monitoramento e o gerenciamento aumentarão a serão um desafio ao longo do tempo devido à natureza personalizada das ferramentas |

| Use Distcp para copiar dados do Hadoop para o Armazenamento do Azure. Em seguida, copie os dados no Armazenamento do Azure para o Data Lake Storage Gen1 usando o mecanismo apropriado. | Você pode copiar dados do Armazenamento do Azure para o Data Lake Storage Gen1 usando: | Você pode usar ferramentas de software livre. | Processo de várias etapas que envolve várias tecnologias |

Conjuntos de dados realmente grandes

Carregar conjuntos de dados que incluem vários terabytes usando os métodos descritos acima, às vezes, pode ser uma tarefa lenta e onerosa. Nesses casos, você pode usar as opções a seguir.

Usando o ExpressRoute do Azure. O Azure ExpressRoute permite criar conexões privadas entre os datacenters do Azure e a infraestrutura presente em seu local. Isso proporciona uma opção confiável para transferir grandes quantidades de dados. Para obter mais informações, confira a documentação do ExpressRoute do Azure.

Carregamento de dados "offline". Se o uso do ExpressRoute do Azure não for possível por qualquer motivo, você poderá usar o serviço de Importação/Exportação do Azure para enviar unidades de disco rígido com seus dados para um datacenter do Azure. Seus dados são carregados pela primeira vez nos Blobs de Armazenamento do Azure. Em seguida, é possível usar o Azure Data Factory ou a ferramenta AdlCopy para copiar dados dos Blobs de Armazenamento do Azure para o Data Lake Storage Gen1.

Observação

Ao usar o serviço Importação/Exportação, os tamanhos dos arquivos nos discos que você envia ao datacenter do Azure não devem ultrapassar 195 GB.

Processar dados armazenados no Data Lake Storage Gen1

Depois que os dados estiverem disponíveis no Data Lake Storage Gen1, você poderá executar uma análise nesses dados usando os aplicativos de Big Data compatíveis. Atualmente, é possível usar o Azure HDInsight e o Azure Data Lake Analytics para executar trabalhos de análise de dados nos dados armazenados no Data Lake Storage Gen1.

Você pode analisar os exemplos a seguir.

- Criar um cluster HDInsight com o Data Lake Storage Gen1 como armazenamento

- Usar o Azure Data Lake Analytics com o Data Lake Storage Gen1

Baixar dados do Data Lake Storage Gen1

Você também pode querer baixar ou mover dados do Azure Data Lake Storage Gen1 para cenários como:

- Mover dados para outros repositórios para fazer interface com os pipelines de processamento de dados existentes. Por exemplo, talvez você queira mover os dados do Data Lake Storage Gen1 para o Banco de Dados SQL do Azure ou SQL Server.

- Baixar dados no computador local para processamento em ambientes IDE durante a criação de protótipos de aplicativo.

Nesses casos, você pode usar qualquer uma das opções a seguir:

Você também pode usar os métodos a seguir para escrever seu próprio script/aplicativo e baixar dados do Data Lake Storage Gen1.

Visualizar dados no Data Lake Storage Gen1

Você pode usar uma combinação de serviços para criar representações visuais de dados armazenados no Data Lake Storage Gen1.

- Você pode começar usando o Azure Data Factory para mover dados do Data Lake Storage Gen1 para o Azure Synapse Analytics

- Depois disso, é possível integrar o Power BI com o Azure Synapse Analytics para criar a representação visual dos dados.