Exercício – Integrar e usar o reconhecimento de fala e a transcrição

Neste módulo, você criará um aplicativo de Realidade Misturada que explora o uso dos Serviços de Fala do Azure com o HoloLens 2. Ao concluir esta série, você poderá usar o microfone do dispositivo para transcrever fala em texto em tempo real, traduzir sua fala para outros idiomas e usar o recurso de reconhecimento de intenção para entender comandos de voz usando inteligência artificial.

Criar e preparar o projeto do Unity

Nesta seção, você vai criar um projeto do Unity e vai prepará-lo para o desenvolvimento do MRTK.

Como pré-requisito, você precisa ter concluído as etapas abaixo para inicializar seu projeto e aplicativo:

- Criar um projeto do Unity e dar a ele um nome adequado, por exemplo, Tutoriais do MRTK

- Como alternar a plataforma de build

- Como importar os Recursos Essenciais do TextMeshPro

- Como importar o Kit de Ferramentas de Realidade Misturada

- Como configurar o projeto do Unity

- Criando e configurando a cena e dando a ela um nome adequado; por exemplo, AzureSpeechServices

Observação

Para saber como configurar seu projeto de realidade misturada, acesse o módulo Introdução ao Kit de Ferramentas de Realidade Misturada.

Configurar as funcionalidades

No menu do Unity, selecione Editar>Configurações de projeto... para abrir a janela Configurações do Player, então localize a seção Player>Configurações de Publicação:

Nas Configurações de Publicação, role a tela até a seção Recursos e verifique se InternetClient, Microphone e SpatialPerception (que você habilitou ao criar o projeto no início do tutorial) ainda estão habilitados. Em seguida, habilite os recursos InternetClientServer e PrivateNetworkClientServer.

Importar os ativos do tutorial

Baixe e importe os seguintes pacotes personalizados do Unity na ordem em que estão listados:

Depois de importar os ativos do tutorial, a janela do projeto deverá ter esta aparência:

Preparar a cena

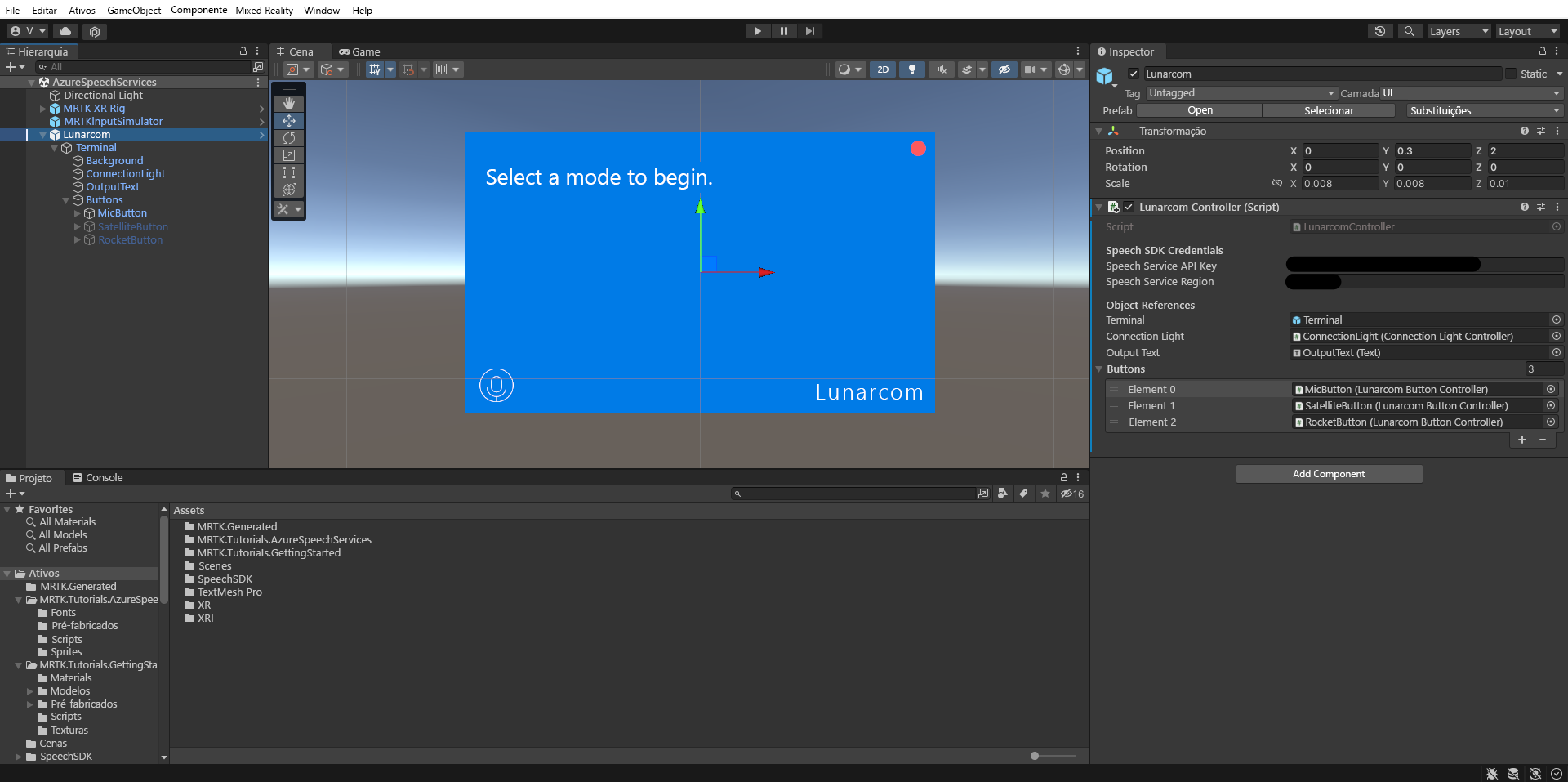

Nesta seção, você preparará a cena adicionando o pré-fabricado do tutorial e configurará o componente Controlador Lunarcom (Script) para controlar sua cena.

Na janela Projeto, navegue até a pasta Ativos>MRTK.Tutorials.AzureSpeechServices>Pré-fabricados e arraste o pré-fabricado Lunarcom para a janela Hierarquia para adicioná-lo à sua cena.

Com o objeto Lunarcom ainda selecionado na janela Hierarquia, na janela Inspetor, use o botão Adicionar componente para adicionar o componente Controlador do Lunarcom (Script) ao objeto Lunarcom.

Com o objeto Lunarcom ainda selecionado, expanda-o para revelar seus objetos filho e arraste o objeto Terminal para o campo Terminal do componente Controlador do Lunarcom (Script).

Com o objeto Lunarcom ainda selecionado, expanda o objeto Terminal para revelar seus objetos filho e arraste o objeto ConnectionLight para o campo Luz de Conexão do componente Controlador do Lunarcom (Script) e o objeto OutputText para o campo Texto de saída.

Com o objeto Lunarcom ainda selecionado, expanda o objeto Buttons para revelar seus objetos filho e, na janela Inspetor, expanda a lista Botões, defina o campo Botões como 3 e arraste os objetos MicButton, SatelliteButton e RocketButton para os campos Elemento 0, 1 e 2, respectivamente.

Conectar o projeto do Unity ao recurso do Azure

Para usar os Serviços de Fala do Azure, você precisa criar um recurso do Azure e obter uma chave de API para o Serviço de Fala. Siga as instruções de início rápido e anote sua região de serviço (também conhecida como Localização) e chave de API (também conhecida como Key1 ou Key2).

Na janela Hierarquia, selecione o objeto Lunarcom, então, na janela Inspetor, localize a seção Credenciais do SDK de Fala do componente Controlador do Lunarcom (Script) e configure-a da seguinte maneira:

- No campo Chave de API do Serviço de Fala, insira sua chave de API (Chave1 ou Chave2).

- No campo Região do Serviço de Fala, insira sua região de serviço (Localização) usando letras minúsculas e espaços removidos.

Usar o reconhecimento de fala para transcrever a fala

Na janela Hierarquia, selecione o objeto Lunarcom e, na janela Inspetor, use o botão Adicionar componente para adicionar o componente Reconhecimento de Fala do Lunarcom (Script) ao objeto Lunarcom.

Se agora você entrar no modo de jogo e selecionar o botão Reproduzir, poderá testar o reconhecimento de fala pressionando primeiro o botão de microfone:

Em seguida, supondo que o computador tenha um microfone, quando você disser algo, sua fala será transcrita no painel do terminal:

Cuidado

O aplicativo precisa se conectar ao Azure, portanto, verifique se o computador/dispositivo está conectado à Internet.