Explorar e processar dados com o Microsoft Fabric

Os dados são a base da ciência de dados, especialmente ao tentar treinar um modelo de machine learning para obter inteligência artificial. Normalmente, os modelos exibem um desempenho aprimorado à medida que o tamanho do conjunto de dados de treinamento aumenta. Além da quantidade de dados, a qualidade dos dados é igualmente crucial.

Para garantir a qualidade e a quantidade de seus dados, vale a pena usar os mecanismos robustos de ingestão e processamento de dados do Microsoft Fabric. Você tem a flexibilidade de optar por uma abordagem de baixo código ou de código como prioridade ao estabelecer os pipelines essenciais de ingestão, exploração e transformação de dados.

Ingerir seus dados no Microsoft Fabric

Para trabalhar com dados no Microsoft Fabric, primeiro você precisa ingerir dados. Você pode ingerir dados de várias fontes, tanto de fontes de dados locais quanto de nuvem. Por exemplo, você pode ingerir dados de um arquivo CSV armazenado em seu computador local ou em um Azure Data Lake Storage (Gen2).

Dica

Saiba mais sobre como ingerir e orquestrar dados de várias fontes com o Microsoft Fabric.

Depois de se conectar a uma fonte de dados, você pode salvar os dados em um Lakehouse do Microsoft Fabric. Você pode usar o lakehouse como um local central para armazenar arquivos estruturados, semiestruturados e não estruturados. Em seguida, você pode se conectar facilmente ao lakehouse sempre que quiser acessar seus dados para exploração ou transformação.

Explorar e transformar seus dados

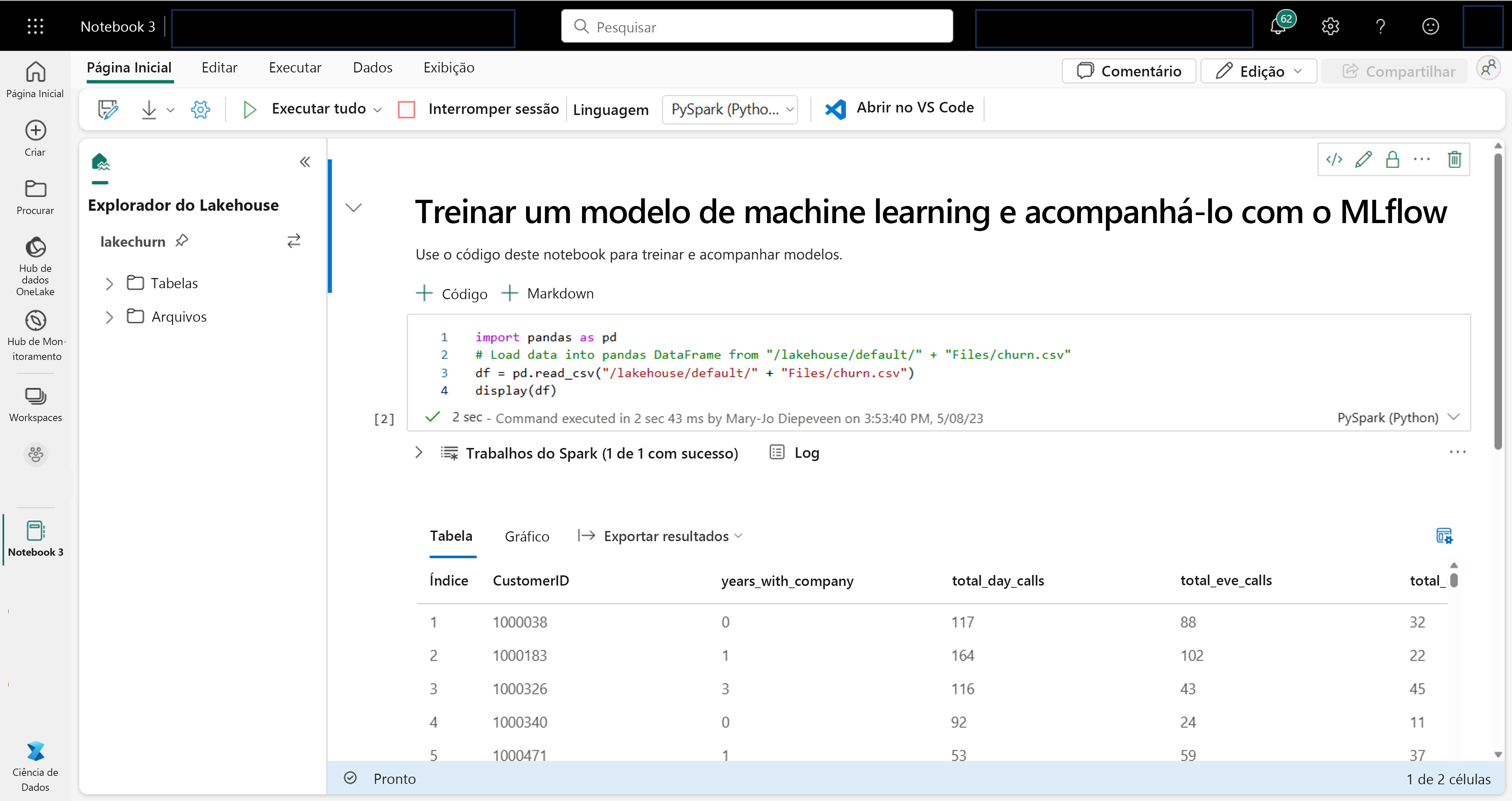

Como cientista de dados, você pode estar mais familiarizado com a escrita e a execução de código em notebooks. O Microsoft Fabric oferece uma experiência de notebook familiar, alimentada pela computação do Spark.

O Apache Spark é uma estrutura de processamento paralelo de código aberto para processamento e análise de dados em larga escala.

Eles são anexados automaticamente à computação do Spark. Ao executar uma célula em um notebook pela primeira vez, uma nova sessão do Spark é iniciada. Essa sessão persiste enquanto você executa células subsequentes. Após algum tempo de inatividade, ela será interrompida automaticamente para economizar custos. Também é possível interromper manualmente essa sessão.

Ao trabalhar em um notebook, é possível escolher a linguagem a ser usada. Para cargas de trabalho de ciência de dados, é provável que você trabalhe com PySpark (Python) ou SparkR (R).

No notebook, você pode explorar seus dados usando sua biblioteca preferida ou com qualquer uma das opções de visualização internas. Se necessário, você pode transformar seus dados e salvar os dados processados gravando-os novamente no lakehouse.

Preparar seus dados com o Data Wrangler

Para ajudá-lo a explorar e transformar seus dados mais rapidamente, o Microsoft Fabric oferece o Data Wrangler, que é fácil de usar.

Depois de iniciar o Data Wrangler, você obterá uma visão geral descritiva dos dados com os quais está trabalhando. Você pode exibir as estatísticas resumidas de seus dados para encontrar problemas como valores ausentes.

Para limpar seus dados, você pode escolher qualquer uma das operações internas de limpeza de dados. Quando você seleciona uma operação, uma visualização do resultado e o código associado são gerados automaticamente para você. Quando você tiver selecionado todas as operações necessárias, poderá exportar as transformações para codificar e executá-las em seus dados.