Modelos de teste no playground do Estúdio de IA do Azure

Os playgrounds são interfaces úteis no Estúdio de IA do Azure que você pode usar para experimentar seus modelos implantados sem a necessidade de desenvolver seu próprio aplicativo cliente. O Estúdio de IA do Azure oferece vários playgrounds com diferentes opções de ajuste de parâmetros.

Playground “Preenchimentos”

O playground “Preenchimentos” permite fazer chamadas para os modelos implantados por meio de uma interface de entrada e saída de texto e ajustar os parâmetros. Você precisa selecionar o nome da implantação do modelo em Implantações. Opcionalmente, você pode usar os exemplos fornecidos para começar e depois pode inserir seus prompts.

Parâmetros do playground “Preenchimentos”

Há diversos parâmetros que você pode ajustar para alterar o desempenho do modelo:

- Temperatura: controla a aleatoriedade. Reduzir a temperatura significa que o modelo produz respostas mais repetitivas e determinísticas. Aumentar a temperatura resulta em respostas mais inesperadas ou criativas. Tente ajustar a temperatura ou o Top P, mas não ambos.

- Comprimento máximo (tokens): Defina um limite para o número de tokens por resposta de modelo. A API dá suporte a um máximo de 4000 tokens compartilhados entre o prompt (incluindo mensagens do sistema, exemplos, histórico de mensagens e consultas do usuário) e a resposta do modelo. Um token tem aproximadamente quatro caracteres para um texto típico em inglês.

- Sequências de parada: faça as respostas pararem em um ponto desejado, como o fim de uma frase ou lista. Especifique até quatro sequências em que o modelo deixará de gerar mais tokens em uma resposta. O texto retornado não conterá a sequência de parada.

- Principais probabilidades (Princ. Prior.): semelhante à temperatura, controla a aleatoriedade, mas usa um método diferente. A redução do Top P restringe a seleção de token do modelo a tokens mais prováveis. O Aumento do Top P permite que o modelo escolha entre tokens com alta e baixa probabilidade. Tente ajustar a temperatura ou o Top P, mas não ambos.

- Penalidade de frequência: reduz a chance proporcional de repetir um token com base na frequência de seu aparecimento no texto até agora. Isso diminui a probabilidade de repetir exatamente o mesmo texto em uma resposta.

- Penalidade de presença: reduz a chance de repetir qualquer token que já tenha sido exibido no texto. Isso aumenta a probabilidade de introduzir novos tópicos em uma resposta.

- Texto de pré-resposta: insira um texto após a entrada do usuário e antes da resposta do modelo. Pode ajudar a preparar o modelo para uma resposta.

- Texto pós-resposta: insira um texto depois da resposta gerada pelo modelo para incentivar mais entradas do usuário, como ao modelar uma conversa.

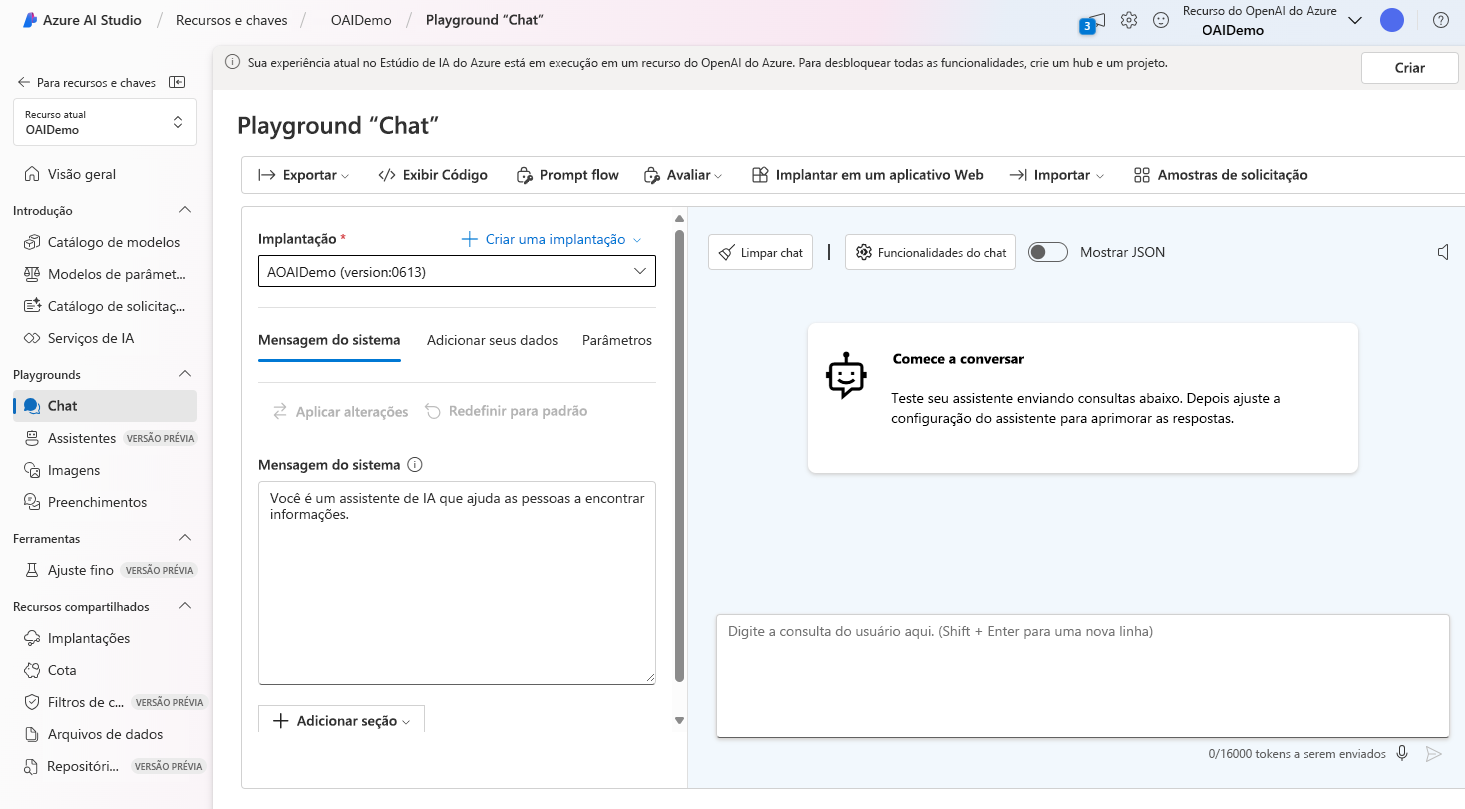

Playground “Chat”

O playground “Chat” é baseado em uma interface de entrada de conversa e saída de mensagens. Você pode inicializar a sessão com uma mensagem do sistema para configurar o contexto do chat.

No playground de chat, você pode adicionar alguns exemplos de capturas. O termo poucas capturas refere-se a fornecer alguns exemplos para ajudar o modelo a aprender o que precisa fazer. Você pode pensar nisso em contraste com a captura zero, que não fornece exemplos.

Na Configuração do Assistente, você pode fornecer alguns exemplos de como pode ser a entrada do usuário e qual deve ser a resposta do assistente. O assistente tenta imitar as respostas que você incluir aqui com o tom, as regras e o formato que você definiu na mensagem do sistema.

Parâmetros do playground do chat

O playground de Chat, assim como o playground de Conclusões, também inclui parâmetros para personalizar o comportamento do modelo. O playground Chat também dá suporte a outros parâmetros não disponíveis no playground Conclusões. Estão incluídos:

- Resposta máxima: defina um limite no número de tokens por resposta de modelo. A API dá suporte a um máximo de 4000 tokens compartilhados entre o prompt (incluindo mensagens do sistema, exemplos, histórico de mensagens e consultas do usuário) e a resposta do modelo. Um token tem aproximadamente quatro caracteres para um texto típico em inglês.

- Mensagens anteriores incluídas: selecione o número de mensagens anteriores a serem incluídas em cada nova solicitação de API. A inclusão de mensagens anteriores ajuda a fornecer o contexto do modelo para novas consultas do usuário. Definir esse número como 10 incluirá cinco consultas do usuário e cinco respostas do sistema.

A Contagem de tokens atual pode ser visualizada no playground do Chat. Como as chamadas à API são precificadas por token e é possível definir um limite máximo de tokens de resposta, você desejará ficar de olho na contagem de tokens atual para garantir que a conversa não exceda a contagem máxima de tokens de resposta.