Modelos personalizados: índices de precisão e confiança

Este conteúdo aplica-se a:![]() v4.0 (preview)

v4.0 (preview)![]() v3.1 (GA)

v3.1 (GA)![]() v3.0 (GA)

v3.0 (GA)![]() v2.1 (GA)

v2.1 (GA)

Nota

- Modelos neurais personalizados não fornecem pontuações de precisão durante o treinamento.

- As pontuações de confiança para tabelas, linhas de tabela e células de tabela estão disponíveis a partir da versão 2024-02-29-preview da API para modelos personalizados.

Os modelos de modelo personalizados geram uma pontuação de precisão estimada quando treinados. Os documentos analisados com um modelo personalizado produzem uma classificação de confiança para campos extraídos. Neste artigo, aprenda a interpretar os escores de precisão e confiança e as práticas recomendadas para usar esses escores para melhorar os resultados de precisão e confiança.

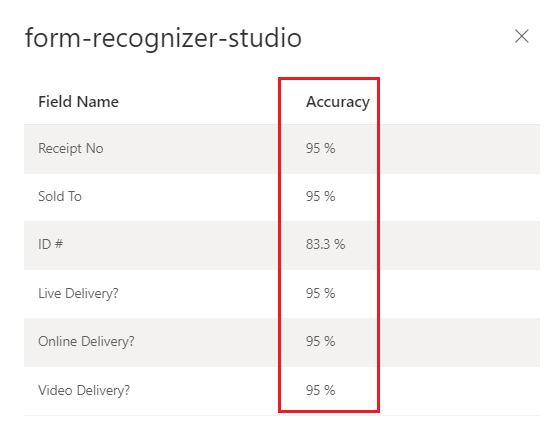

Pontuações de precisão

A saída de uma build operação de modelo personalizado (v3.0) ou train (v2.1) inclui a pontuação de precisão estimada. Essa pontuação representa a capacidade do modelo de prever com precisão o valor rotulado em um documento visualmente semelhante.

O intervalo de valores de precisão é uma porcentagem entre 0% (baixa) e 100% (alta). A precisão estimada é calculada executando algumas combinações diferentes dos dados de treinamento para prever os valores rotulados.

Modelo personalizado treinado pelo Document Intelligence Studio

(fatura)

Escores de confiança

Nota

- As pontuações de confiança de tabela, linha e célula agora estão incluídas na versão 2024-02-29-preview da API.

- As pontuações de confiança para células de tabela de modelos personalizados são adicionadas à API a partir da API 2024-02-29-preview.

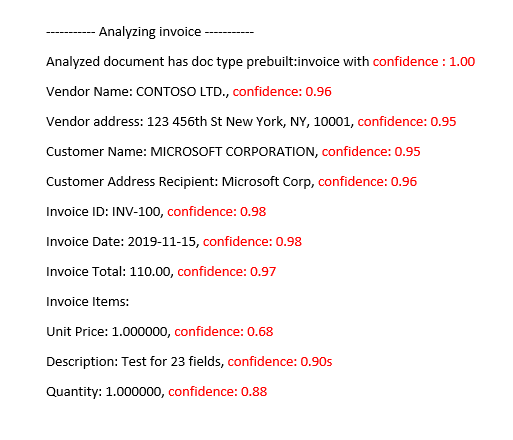

Os resultados da análise do Document Intelligence retornam uma confiança estimada para palavras previstas, pares chave-valor, marcas de seleção, regiões e assinaturas. Atualmente, nem todos os campos do documento retornam uma pontuação de confiança.

A confiança de campo indica uma probabilidade estimada entre 0 e 1 de que a previsão esteja correta. Por exemplo, um valor de confiança de 0,95 (95%) indica que a previsão provavelmente está correta 19 de 20 vezes. Para cenários em que a precisão é crítica, a confiança pode ser usada para determinar se a previsão deve ser aceita automaticamente ou se a sinaliza para revisão humana.

Document Intelligence Studio

Modelo de fatura pré-construído analisado

Interpretar pontuações de precisão e confiança para modelos personalizados

Ao interpretar a pontuação de confiança de um modelo personalizado, você deve considerar todas as pontuações de confiança retornadas do modelo. Vamos começar com uma lista de todas as pontuações de confiança.

- Pontuação de confiança de tipo de documento: A confiança de tipo de documento é um indicador de que o documento analisado se assemelha a documentos no conjunto de dados de treinamento. Quando a confiança do tipo de documento é baixa, é indicativo de variações estruturais ou de modelo no documento analisado. Para melhorar a confiança do tipo de documento, rotule um documento com essa variação específica e adicione-o ao seu conjunto de dados de treinamento. Uma vez que o modelo é retreinado, ele deve estar mais bem equipado para lidar com essa classe de variações.

- Confiança no nível de campo: Cada campo rotulado extraído tem uma pontuação de confiança associada. Esta pontuação reflete a confiança do modelo na posição do valor extraído. Ao avaliar os escores de confiança, você também deve olhar para a confiança de extração subjacente para gerar uma confiança abrangente para o resultado extraído. Avalie os resultados para

OCRextração de texto ou marcas de seleção, dependendo do tipo de campo, para gerar uma pontuação de confiança composta para o campo. - Pontuação de confiança de palavras Cada palavra extraída no documento tem uma pontuação de confiança associada. A pontuação representa a confiança da transcrição. A matriz de páginas contém uma matriz de palavras e cada palavra tem uma extensão associada e uma pontuação de confiança. Espadas do campo personalizado valores extraídos correspondem às extensões das palavras extraídas.

- Pontuação de confiança da marca de seleção: a matriz de páginas também contém uma matriz de marcas de seleção. Cada marca de seleção tem uma pontuação de confiança que representa a confiança da marca de seleção e da deteção do estado de seleção. Quando um campo rotulado tem uma marca de seleção, a seleção de campo personalizado combinada com a confiança da marca de seleção é uma representação precisa da precisão geral da confiança.

A tabela a seguir demonstra como interpretar as pontuações de precisão e confiança para medir o desempenho do seu modelo personalizado.

| Precisão | Confiança | Result |

|---|---|---|

| Alto | Alto | • O modelo está a ter um bom desempenho com as teclas etiquetadas e formatos de documentos. • Você tem um conjunto de dados de treinamento equilibrado. |

| Alto | Baixo | • O documento analisado parece diferente do conjunto de dados de treinamento. • O modelo beneficiaria de uma reconversão profissional com, pelo menos, mais cinco documentos etiquetados. • Esses resultados também podem indicar uma variação de formato entre o conjunto de dados de treinamento e o documento analisado. Considere adicionar um novo modelo. |

| Baixa | Alta | • Este resultado é muito improvável. • Para pontuações de baixa precisão, adicione mais dados rotulados ou divida documentos visualmente distintos em vários modelos. |

| Baixo | Baixo | • Adicione mais dados rotulados. • Divida documentos visualmente distintos em vários modelos. |

Confiança na tabela, linha e célula

Com a adição da confiança de tabela, linha e célula com a 2024-02-29-preview API, aqui estão algumas perguntas comuns que devem ajudar na interpretação das pontuações de tabela, linha e célula:

P: É possível ver uma pontuação de confiança alta para as células, mas uma pontuação de confiança baixa para a linha?

R: Sim. Os diferentes níveis de confiança da tabela (célula, linha e tabela) destinam-se a capturar a exatidão de uma previsão nesse nível específico. Uma célula corretamente prevista que pertence a uma linha com outras falhas possíveis teria alta confiança celular, mas a confiança da linha deve ser baixa. Da mesma forma, uma linha correta em uma tabela com desafios com outras linhas teria alta confiança de linha, enquanto a confiança geral da tabela seria baixa.

P: Qual é a pontuação de confiança esperada quando as células são mescladas? Como uma mesclagem resulta no número de colunas identificadas para serem alteradas, como as pontuações são afetadas?

R: Independentemente do tipo de tabela, a expectativa para as células mescladas é que elas tenham valores de confiança mais baixos. Além disso, a célula que está faltando (porque foi mesclada com uma célula adjacente) deve ter NULL valor com menor confiança também. O quão mais baixos esses valores podem ser depende do conjunto de dados de treinamento, a tendência geral de ambas as células mescladas e ausentes terem pontuações mais baixas deve se manter.

P: Qual é a pontuação de confiança quando um valor é opcional? Você deve esperar uma célula com um valor e uma NULL pontuação de confiança alta se o valor estiver faltando?

R: Se o conjunto de dados de treinamento for representativo da opcionalidade das células, ele ajuda o modelo a saber com que frequência um valor tende a aparecer no conjunto de treinamento e, portanto, o que esperar durante a inferência. Este recurso é usado para calcular a confiança de uma previsão ou de não fazer nenhuma previsão (NULL). Você deve esperar um campo vazio com alta confiança para valores ausentes que estão principalmente vazios no conjunto de treinamento também.

P: Como as pontuações de confiança são afetadas se um campo é opcional e não está presente ou é perdido? A expectativa é que o índice de confiança responda a essa pergunta?

R: Quando um valor está ausente de uma linha, a célula tem um valor e confiança NULL atribuídos. Uma pontuação de confiança alta aqui deve significar que a previsão do modelo (de não haver um valor) tem mais probabilidade de estar correta. Em contrapartida, uma pontuação baixa deve sinalizar mais incerteza do modelo (e, portanto, a possibilidade de um erro, como o valor ser perdido).

P: Qual deve ser a expectativa de confiança de célula e confiança de linha ao extrair uma tabela de várias páginas com uma linha dividida entre páginas?

R: Espere que a confiança da célula seja alta e que a confiança da linha seja potencialmente menor do que as linhas que não estão divididas. A proporção de linhas divididas no conjunto de dados de treinamento pode afetar a pontuação de confiança. Em geral, uma linha dividida parece diferente das outras linhas da tabela (assim, o modelo tem menos certeza de que está correto).

P: Para tabelas de páginas cruzadas com linhas que terminam e começam nos limites da página, é correto assumir que as pontuações de confiança são consistentes entre as páginas?

R: Sim. Como as linhas são semelhantes em forma e conteúdo, independentemente de onde estão no documento (ou em qual página), suas respetivas pontuações de confiança devem ser consistentes.

P: Qual é a melhor maneira de utilizar as novas pontuações de confiança?

R: Olhe para todos os níveis de confiança da tabela começando em uma abordagem de cima para baixo: comece verificando a confiança de uma tabela como um todo, depois faça uma busca detalhada até o nível da linha e olhe para linhas individuais, finalmente olhe para as confidências no nível da célula. Dependendo do tipo de tabela, há algumas coisas importantes:

Para tabelas fixas, a confiança no nível da célula já captura um pouco de informações sobre a correção das coisas. Isso significa que simplesmente passar por cima de cada célula e olhar para sua confiança pode ser suficiente para ajudar a determinar a qualidade da previsão. Para tabelas dinâmicas, os níveis devem ser construídos uns sobre os outros, por isso a abordagem de cima para baixo é mais importante.

Garantir alta precisão do modelo

As variações na estrutura visual dos documentos afetam a precisão do modelo. As classificações de precisão reportadas podem ser inconsistentes quando os documentos analisados diferem dos documentos utilizados na preparação. Tenha em conta que um conjunto de documentos pode parecer semelhante quando visto por humanos, mas parecer diferente para um modelo de IA. A seguir, está uma lista das melhores práticas para modelos de treinamento com a mais alta precisão. Seguir essas diretrizes deve produzir um modelo com maior precisão e escores de confiança durante a análise e reduzir o número de documentos sinalizados para revisão humana.

Certifique-se de que todas as variações de um documento estão incluídas no conjunto de dados de preparação. As variações incluem diferentes formatos, por exemplo, PDFs digitais e digitalizados.

Adicione pelo menos cinco amostras de cada tipo ao conjunto de dados de treinamento se você espera que o modelo analise ambos os tipos de documentos PDF.

Separe os tipos de documentos visualmente distintos para preparar diferentes modelos.

- Como regra geral, se você remover todos os valores inseridos pelo usuário e os documentos forem semelhantes, será necessário adicionar mais dados de treinamento ao modelo existente.

- Se os documentos não forem semelhantes, divida os seus dados de preparação em pastas diferentes e prepare um modelo para cada variação. Em seguida, pode compor as diversas variações num único modelo.

Certifique-se de que não tem rótulos estranhos.

Certifique-se de que a rotulagem de assinatura e região não inclua o texto ao redor.