Nota

O acesso a esta página requer autorização. Pode tentar iniciar sessão ou alterar os diretórios.

O acesso a esta página requer autorização. Pode tentar alterar os diretórios.

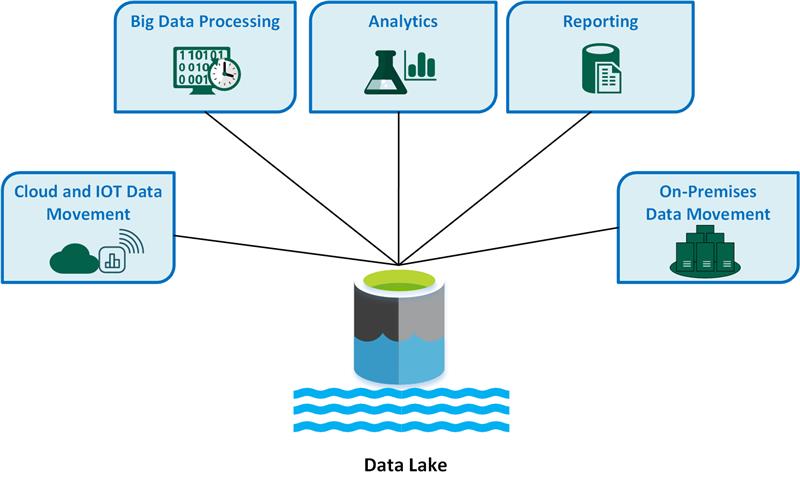

Um data lake é um repositório de armazenamento que contém uma grande quantidade de dados em seu formato nativo bruto. Os armazenamentos de data lake são otimizados para dimensionar seu tamanho para terabytes e petabytes de dados. Os dados normalmente vêm de várias fontes diversas e podem incluir dados estruturados, semiestruturados ou não estruturados. Um data lake ajuda você a armazenar tudo em seu estado original e não transformado. Este método difere de um armazém de dados tradicional, que transforma e processa dados no momento da ingestão.

Os principais casos de uso do data lake incluem:

- Movimentação de dados em nuvem e Internet das Coisas (IoT).

- Processamento de Big Data.

- Análises

- Elaboração de relatórios.

- Movimentação de dados no local.

Considere as seguintes vantagens de um data lake:

Um data lake nunca exclui dados porque armazena dados em seu formato bruto. Esse recurso é especialmente útil em um ambiente de big data porque você pode não saber com antecedência quais insights você pode obter dos dados.

Os usuários podem explorar os dados e criar suas próprias consultas.

Um data lake pode ser mais rápido do que as ferramentas tradicionais de extração, transformação, carregamento (ETL).

Um data lake é mais flexível do que um data warehouse porque pode armazenar dados não estruturados e semiestruturados.

Uma solução completa de data lake consiste em armazenamento e processamento. O armazenamento do data lake foi projetado para tolerância a falhas, escalabilidade infinita e ingestão de alta taxa de transferência de várias formas e tamanhos de dados. O processamento do data lake envolve um ou mais mecanismos de processamento que podem incorporar esses objetivos e podem operar em dados armazenados em um data lake em escala.

Quando deves usar um data lake

Recomendamos que você use um data lake para exploração de dados, análise de dados e aprendizado de máquina.

Um data lake pode atuar como a fonte de dados para um data warehouse. Quando você usa esse método, o data lake ingere dados brutos e, em seguida, os transforma em um formato consultável estruturado. Normalmente, essa transformação usa um pipeline de extração, carga, transformação (ELT) no qual os dados são ingeridos e transformados no local. Os dados de origem relacional podem ir diretamente para o data warehouse por meio de um processo ETL e ignorar o data lake.

Você pode usar armazenamentos de data lake em cenários de streaming de eventos ou IoT, pois os data lakes podem persistir grandes quantidades de dados relacionais e não relacionais sem transformação ou definição de esquema. Os data lakes podem lidar com grandes volumes de pequenas gravações com baixa latência e são otimizados para uma taxa de transferência massiva.

A tabela a seguir compara data lakes (lakes de dados) e data warehouses (armazéns de dados).

Desafios

Grandes volumes de dados: o gerenciamento de grandes quantidades de dados brutos e não estruturados pode ser complexo e consome muitos recursos, portanto, você precisa de uma infraestrutura e ferramentas robustas.

Gargalos potenciais: o processamento de dados pode introduzir atrasos e ineficiências, especialmente quando você tem grandes volumes de dados e diversos tipos de dados.

Riscos de corrupção de dados: a validação e o monitoramento inadequados de dados introduzem um risco de corrupção de dados, o que pode comprometer a integridade do data lake.

Problemas de controle de qualidade: A qualidade adequada dos dados é um desafio devido à variedade de fontes e formatos de dados. Você deve implementar práticas rigorosas de governança de dados.

Problemas de desempenho: o desempenho da consulta pode diminuir à medida que o data lake cresce, portanto, você deve otimizar as estratégias de armazenamento e processamento.

Opções de tecnologia

Ao criar uma solução abrangente de data lake no Azure, considere as seguintes tecnologias:

Azure Data Lake Storage combina o Armazenamento de Blobs do Azure com recursos de data lake, que fornecem acesso compatível com Apache Hadoop, recursos de namespace hierárquico e segurança aprimorada para uma análise de big data mais eficiente.

O Azure Databricks é uma plataforma unificada que pode utilizar para processar, armazenar, analisar e rentabilizar dados. Ele suporta processos ETL, painéis, segurança, exploração de dados, aprendizado de máquina e IA generativa.

O Azure Synapse Analytics é um serviço unificado que você pode usar para ingerir, explorar, preparar, gerenciar e fornecer dados para necessidades imediatas de business intelligence e aprendizado de máquina. Ele se integra profundamente aos data lakes do Azure para que você possa consultar e analisar grandes conjuntos de dados de forma eficiente.

O Azure Data Factory é um serviço de integração de dados baseado na nuvem que pode utilizar para criar fluxos de trabalho orientados por dados para, em seguida, orquestrar e automatizar a movimentação e transformação de dados.

O Microsoft Fabric é uma plataforma de dados abrangente que unifica engenharia de dados, ciência de dados, data warehousing, análise em tempo real e business intelligence em uma única solução.

Contribuidores

Este artigo é mantido pela Microsoft. Foi originalmente escrito pelos seguintes contribuidores.

Autor principal:

- Avijit Prasad | Consultor de Nuvem

Para ver perfis não públicos do LinkedIn, inicie sessão no LinkedIn.

Próximos passos

- O que é OneLake?

- Introdução ao armazenamento Data Lake

- Documentação do Azure Data Lake Analytics

- Treinamento: Introdução ao armazenamento Data Lake

- Integração do Hadoop e do Azure Data Lake Storage

- Conectar-se ao Armazenamento de Data Lake e ao Armazenamento de Blobs

- Carregar dados no Armazenamento Data Lake com o Azure Data Factory